如何用 Nginx 配置透明 HTTP 和 HTTPS 代理

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何用 Nginx 配置透明 HTTP 和 HTTPS 代理相关的知识,希望对你有一定的参考价值。

nginx ("engine x") 是一个高性能的 HTTP 和 反向代理 服务器,也是一个 IMAP/POP3/SMTP 代理服务器。 Nginx 是由 Igor Sysoev 为俄罗斯访问量第二的 Rambler.ru 站点开发的,,因它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名。1、首先需要配置站点的WoSign SSl证书

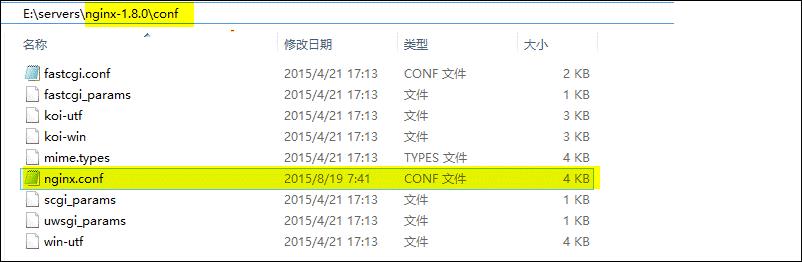

打开Nginx安装目录下conf目录中的nginx.conf文件 找到

# HTTPS server

#

#server

# listen 443;

# server_name localhost;

# ssl on;

# ssl_certificate cert.pem;

# ssl_certificate_key cert.key;

# ssl_session_timeout 5m;

# ssl_protocols SSLv2 SSLv3 TLSv1;

# ssl_ciphers ALL:!ADH:!EXPORT56:RC4+RSA:+HIGH:+MEDIUM:+LOW:+SSLv2:+EXP;

# ssl_prefer_server_ciphers on;

# location /

# root html;

# index index.html index.htm;

#

#

将其修改为 :

server

listen 443;

server_name localhost;

ssl on;

ssl_certificate sslkey/public.cer; (证书公钥)

ssl_certificate_key sslkey/private.key; (证书私钥)

ssl_session_timeout 5m;

ssl_protocols TLSv1 TLSv1.1 TLSv1.2;

ssl_ciphers ALL:!ADH:!EXPORT56:RC4+RSA:+HIGH:+MEDIUM:+LOW:+SSLv2:+EXP;

ssl_prefer_server_ciphers on;

location /

root html;

index index.html index.htm;

保存退出,并重启Nginx。

通过https方式访问您的站点,测试站点证书的安装配置。

3、配置强身份认证

1、 修改nginx.conf文件

如果要求客户采用客户证书认证方式,可以在原来的配置下增加如下参数:

server

......

......

......

ssl_verify_client on 要求SSL客户证书认证。

ssl_client_certificate trust.cer 签发客户证书的CA证书,用来验证客户证书。

ssl_verify_depth 3 SSL客户证书认证链长度。

4、重启站点使用您的客户端证书进行登陆测试 参考技术A HTTP代理存在两种。

一种是基于RFC 7230 以及其他相关RFC文档中描述的普通代理,代理服务器充当的是一个中间的组件,通过在请求URI设置的对应authority来指定目标服务器。

另一种是基于RFC 2817实现的TCP隧道代理。与上面的区别就在于“TCP隧道”,这种代理可以以HTTP协议的方式来实现理论上任意TCP之上的应用层协议代理,两端之间的通讯都是在HTTP的body部分完成的。因此就可以完成基于TLS的HTTPS通讯,被加密过的数据直接在body中传输。

Nginx不支持第二种代理,因此不能完成https代理。Nginx的作者对于这个功能有明确的回复,表示不会在近期实现,并且推荐使用Squid。 参考技术B 您说的是跳转吧?

Nginx - 负载均衡

一、前言

前文简单介绍了如何安装Nginx,方法非常简单,操作也非常方便。上文中提到了Nginx可以做http服务器、虚拟主机、负载均衡。在这篇博客中小编就向大家介绍一下如何用Nginx做负载均衡。

二、负载均衡

首先我们得知道什么是负载均衡。

负载均衡 建立在现有网络结构之上,它提供了一种廉价有效透明的方法扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。

负载均衡,英文名称为Load Balance,其意思就是分摊到多个操作单元上进行执行,例如Web服务器、FTP服务器、企业关键应用服务器和其它关键任务服务器等,从而共同完成工作任务。

负载均衡的核心是:将负载进行平衡。

负载均衡,一般包含两方面的含义。一方面是,将单一的重负载分担到多个网络节点上做并行处理,每个节点处理结束后将结果汇总返回给用户,这样可以大幅提高网络系统的处理能力;第二个方面的含义是,将大量的前端并发访问或数据流量分担到多个后端网络节点上分别处理,这样可以有效减少前端用户等待响应的时间。Web服务器、FTP服务器、企业关键应用服务器等网络应用方面谈到的负载均衡问题,基本隶属于后一方面的含义。因此,Nginx服务器的负载均衡主要是对大量前端访问和流量进行分流,以保证前端用户访问效率。可以说,在绝大多数的Nginx应用中,都会或多或少涉及它的负载均衡服务。

Nginx服务器的负载均衡策略可以划分为两大类:即内置策略和扩展策略。内置策略主要包含轮询、加权轮询和IP hash三种;扩展策略主要通过第三方模块实现,种类比较丰富,常见的有url hash、fair等。

在默认情况下,内置策略会被编译进Nginx内核,使用时只需要在Nginx服务器配置中设置相关参数即可,我们在专门的章节中会详细阐述;扩展策略不会编译进Nginx内核,需要手动将第三方模块编译到Nginx内核。第三方模块的编译技术也留在后文专门讲解。下面简单介绍一下几种负载均衡策略的实现原理。

轮询策略比较简单,就是将每个前端请求按顺序(时间顺序或者排列次序)逐一分配到不同的后端节点上,对于出现问题的后端节点自动排除。加权轮询策略,顾名思义,就是在基本的轮询策略上考虑各后端节点接受请求的权重,指定各后端节点被轮询到的几率。加权轮询策略主要用于后端节点性能不均的情况。根据后端节点性能的实际情况,我们可以在Nginx服务器的配置文件中调整权值,使得整个网络对前端请求达到最佳的响应能力。

IP hash策略,是将前端的访问IP进行hash操作,然后根据hash结果将请求分配给不同的后端节点。事实上,这种策略可以看作是一种特殊的轮询策略。通过Nginx的实现,每个前端访问IP会固定访问一个后端节点。这样做的好处是避免考虑前端用户的session在后端多个节点上共享的问题。

扩展策略中的url hash在形式上和IP hash相近,不同之处在于,IP hash策略是对前端访问IP进行了hash操作,而url hash策略是对前端请求的url进行了hash操作。url hash策略的优点在于,如果后端有缓存服务器,它能够提高缓存效率,同时也解决了session的问题;但其缺点是,如果后端节点出现异常,它不能自动排除该节点。在实际使用过程中笔者发现,后端节点出现异常会导致Nginx服务器返回503错误。

扩展的第三方模块fair则是从另一个角度来实现Nginx服务器负载均衡策略的。该模块将前端请求转发到一个最近负载最小的后台节点。那么,负载最小怎么判断呢?Nginx通过后端节点对请求的响应时间来判断负载情况。响应时间短的节点负载相对就轻。得出判断结果后,Nginx就将前端请求转发到选中的负载最轻的节点。

三、Nginx 负载均衡

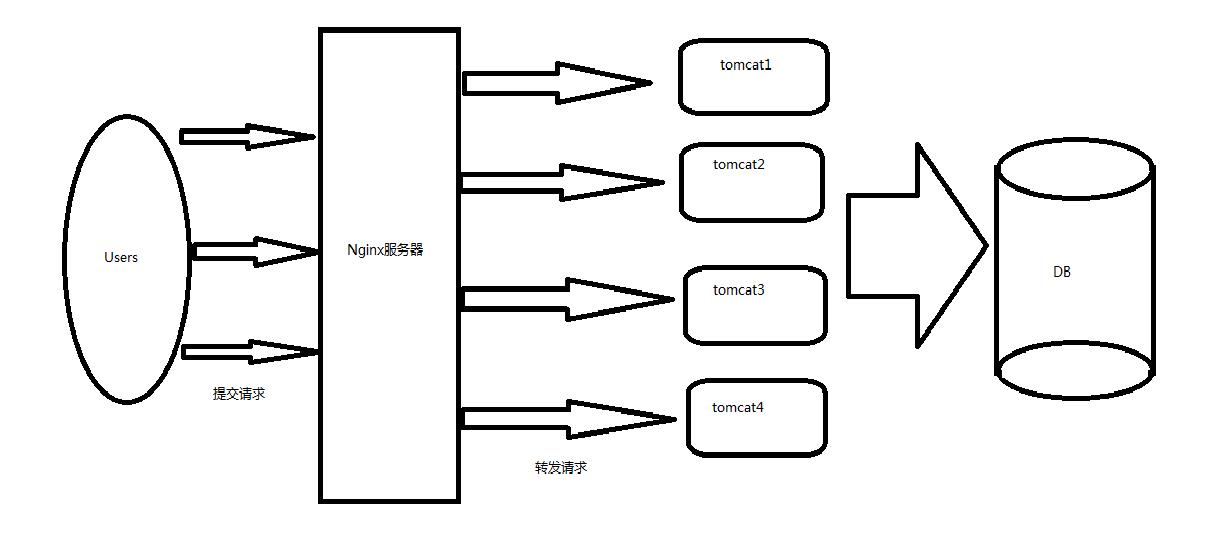

对于Nginx来说,他可以把提交的请求进行转发。架构如下:

架构图解释:在这个图中,用户提交请求先到Nginx服务器,然后由Nginx进行对这些请求的转发,转发到各个tomcat服务器上,然后tomcat进行逻辑处理。

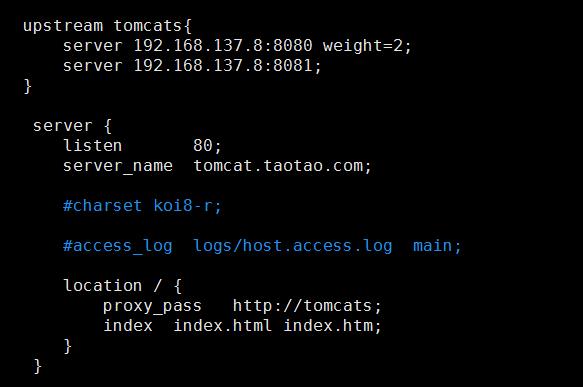

而Nginx是如何做的呢?首先Nginx中写入了各个tomcat的服务器的地址,架构师可以根据tomcat的性能,增加对其使用的程度。Nginx只需在nginx.conf中进行配置:

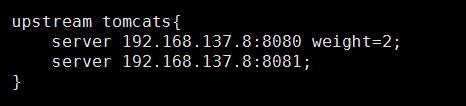

只需要在upostream的server后面添加一个weight,即可代表权重。权重越大,分配请求的数量就越多。不写的时候默认是1。

四、配置流程

1. Nginx的配置

在nginx中配置一个server:使用域名的方式来进行反向代理,这里使用的域名是tomcat.taotao.com,用户可以访问这个域名,先提交到Nginx中。

2. tomcat配置

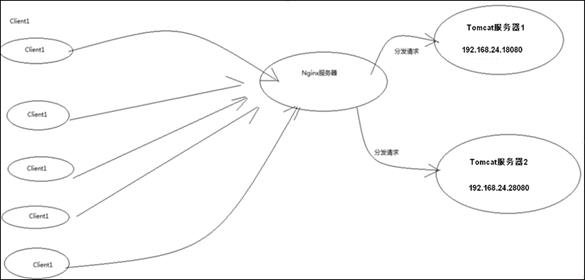

开启两台tomcat,端口如下:

Nginx根据proxy_pass来访问的路径来确定访问的server,根据权重自动分配选择的哪一个。权重大的处理的概率高。

四、详情配置

1、工具

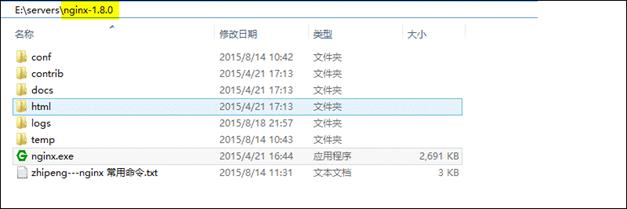

- nginx-1.8.0

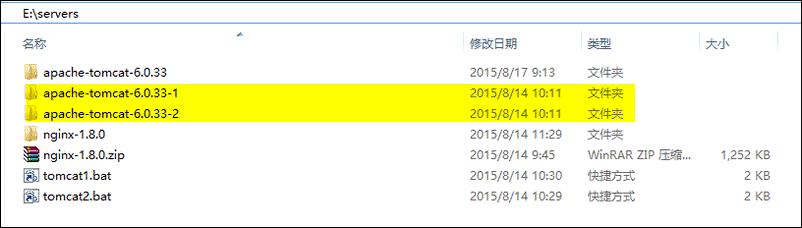

- apache-tomcat-6.0.33

2、目标

实现高性能负载均衡的Tomcat集群:

3、步骤

(1)、首先下载Nginx,要下载稳定版:

(2)然后解压两个Tomcat,分别命名为apache-tomcat-6.0.33-1和apache-tomcat-6.0.33-2:

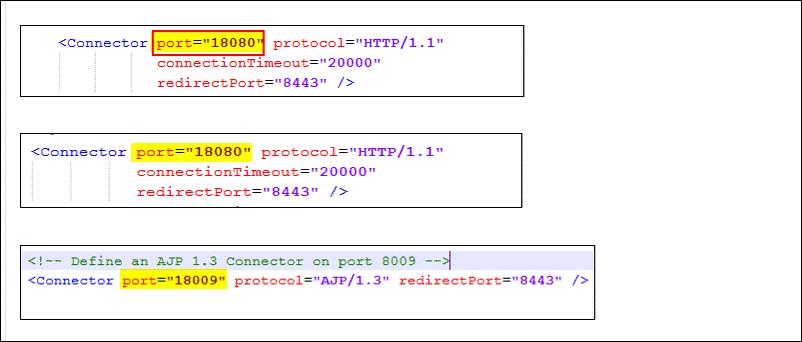

(3)然后修改这两个Tomcat的启动端口,分别为18080和28080,下面以修改第一台Tomcat为例,打开Tomcat的conf目录下的server.xml:

共需修改3处端口:

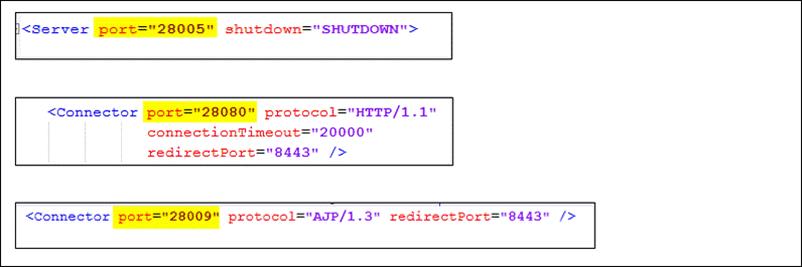

当然第二台Tomcat也一样,如下图:

4、然后启动两个Tomcat,并访问,看是否正常:

5、然后修改上面两个Tomcat的默认页面(为了区分下面到底访问的是那一台Tomcat,随便改一下即可):

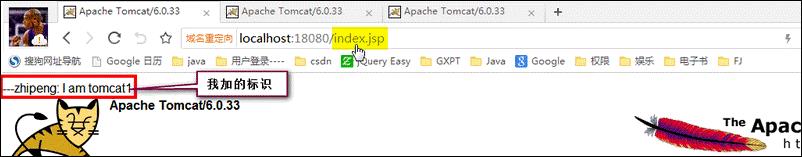

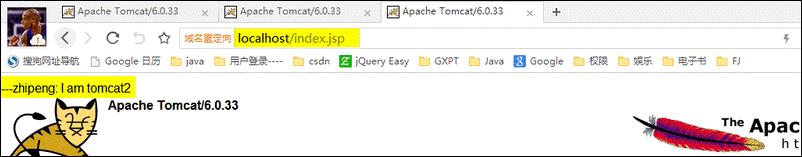

改完以后,进行访问,如下图:

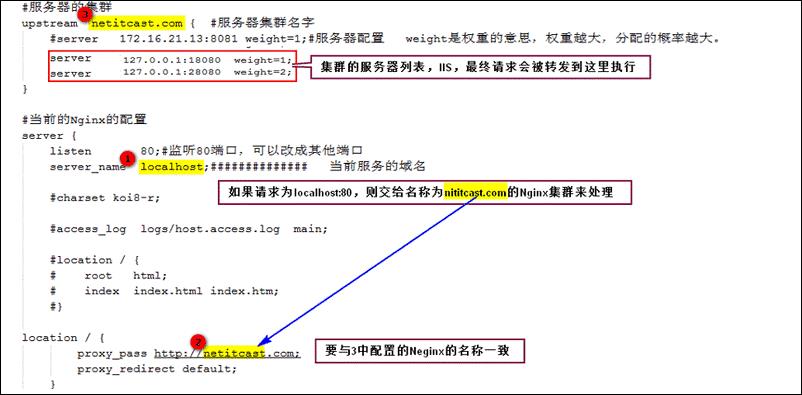

6、OK,现在我们可以开始配置Nginx来实现负载均衡了,其实非常的简单,只需要配置好Nginx的配置文件即可:

配置如下(这里只进行了简单的配置,实际生产环境可以进行更详细完善配置):

worker_processes 1;#工作进程的个数,一般与计算机的cpu核数一致

events

worker_connections 1024;#单个进程最大连接数(最大连接数=连接数*进程数)

http

include mime.types; #文件扩展名与文件类型映射表

default_type application/octet-stream;#默认文件类型

sendfile on;#开启高效文件传输模式,sendfile指令指定nginx是否调用sendfile函数来输出文件,对于普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off,以平衡磁盘与网络I/O处理速度,降低系统的负载。注意:如果图片显示不正常把这个改成off。

keepalive_timeout 65; #长连接超时时间,单位是秒

gzip on;#启用Gizp压缩

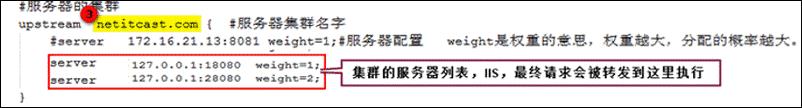

#服务器的集群

upstream netitcast.com #服务器集群名字

server 127.0.0.1:18080 weight=1;#服务器配置 weight是权重的意思,权重越大,分配的概率越大。

server 127.0.0.1:28080 weight=2;

#当前的Nginx的配置

server

listen 80;#监听80端口,可以改成其他端口

server_name localhost;############## 当前服务的域名

location /

proxy_pass http://netitcast.com;

proxy_redirect default;

error_page 500 502 503 504 /50x.html;

location = /50x.html

root html;

核心配置如下:

到此配置完成,下面开始演示负载均衡。

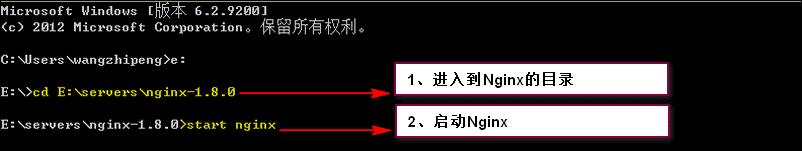

7、首先,我们启动Nginx:

8、然后我们即可输入:localhost/index.jsp查看运行状况了

第一次访问,发现访问的是Tomcat2上的程序:

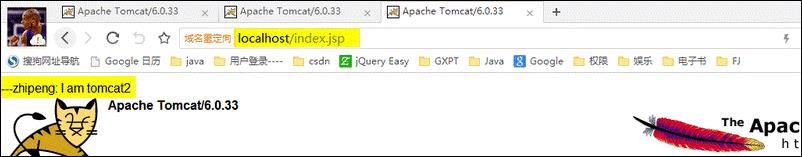

然后刷新,访问的还是Tomcat2上的程序:

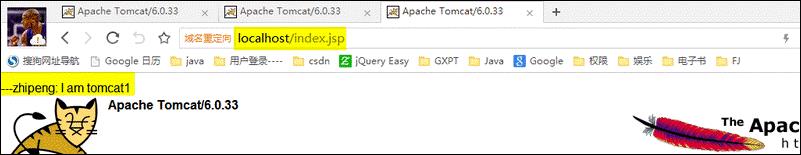

再刷新,发现变为了Tomcat1上的程序:

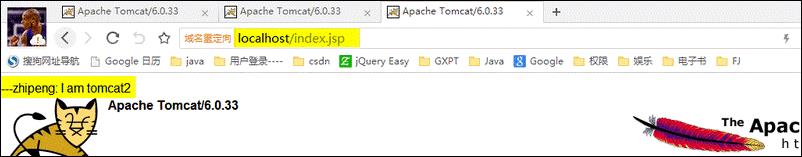

再刷新,发现又变为了Tomcat2上的程序:

到此,我们利用Nginx已经实现了负载均衡的Tomcat集群。我们不断的刷新,发现访问Tomcat2的概率大概是Tomcat1的2倍,这是因为我们在Nginx中配置的两台Tomcat的权重起的作用,如下图:

Ps:谁能想到实现一个高性能的负载均衡集群会如此简单。Nginx的功能如此强大,配置却如此简单,我们还有什么理由拒绝它呢?这比我们动不动就十多万至几十万人民币的F5 BIG-IP、NetScaler等硬件负载均衡交换机廉价了不知多少。此外,大家别忘了Nginx不仅仅是一个反向代理服务器,它本身也可以托管网站,作为Web服务器,进行Http服务处理。

五、小结

通过本次的学习Nginx的负载均衡,重点是引出了一个权重,权重越大就处理的请求越多。

以上是关于如何用 Nginx 配置透明 HTTP 和 HTTPS 代理的主要内容,如果未能解决你的问题,请参考以下文章