YOLOv5使用NCNN将模型部署到Android端教程部署自己的训练模型到Android实现静态图片检测

Posted 我真的爱发明

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了YOLOv5使用NCNN将模型部署到Android端教程部署自己的训练模型到Android实现静态图片检测相关的知识,希望对你有一定的参考价值。

文章目录

- 1. 前言

- 2. 模型转换

- 3. 问题

- 4. 报错

- 5. 资源

- 6. 参考资料

1. 前言

- 之前一直是在电脑端运行YOLOv5,但在户外调试的时候不太方便,因此考虑把YOLOv5的代码移植到手机端。

- 这个部署的流程其实很简单:原始pt权重>中间onnx权重>ncnn权重>修改android Studio源码>得到安卓APP>结束。如果你感觉博客教程太长了,那么很有可能是中间的图片太多,以及之前自己部署的时候踩坑环节太多,这些部分你都可以直接跳过去。放心好了,我把自己踩过的坑的正确方法全部修正放在正文中了,踩坑和实验环节自己全部放在[报错]章节了,尽量减少大家在部署的过程中遇到的坑的数量。

2. 模型转换

2.1. NCNN

2.1.1. 简介

NCNN是一个腾讯开源的优化到极致的高性能神经网络前向计算框架,可以把电脑端生成在深度学习模型移植到手机端,支持的模型非常多

NCNN官方的定义:NCNN是腾讯公司开源的一个专为手机端极致优化的高性能神经网络前向计算框架。NCNN从设计之初,就深刻考虑手机端的部署和使用,无需第三方依赖,跨平台,手机端CPU的速度快于目前所有已知的开源框架。基于NCNN,开发者能够将深度学习算法轻松移植到手机端高效执行,开发出人工智能APP,将AI带到你的指尖。

目前NCNN已经支持大部分的CNN网络,包括本文中用到的YOLOv5,

可以从这个网页上进行查看支持的具体平台

Releases · Tencent/ncnn · GitHub

我们接下来主要以带加速的ncnn-android-vulkan.zip展开

2.1.2. ncnn

2.1.3. ncnn-android-yolov5

GitHub nihui/ncnn-android-yolov5: The YOLOv5 object detection android example

2.2. 项目准备

2.2.1. 安装Android studio

这个百度上有很多对应的经验体,随便找一个教程,然后切换一下国内源,即可安装成功,这里不做赘述

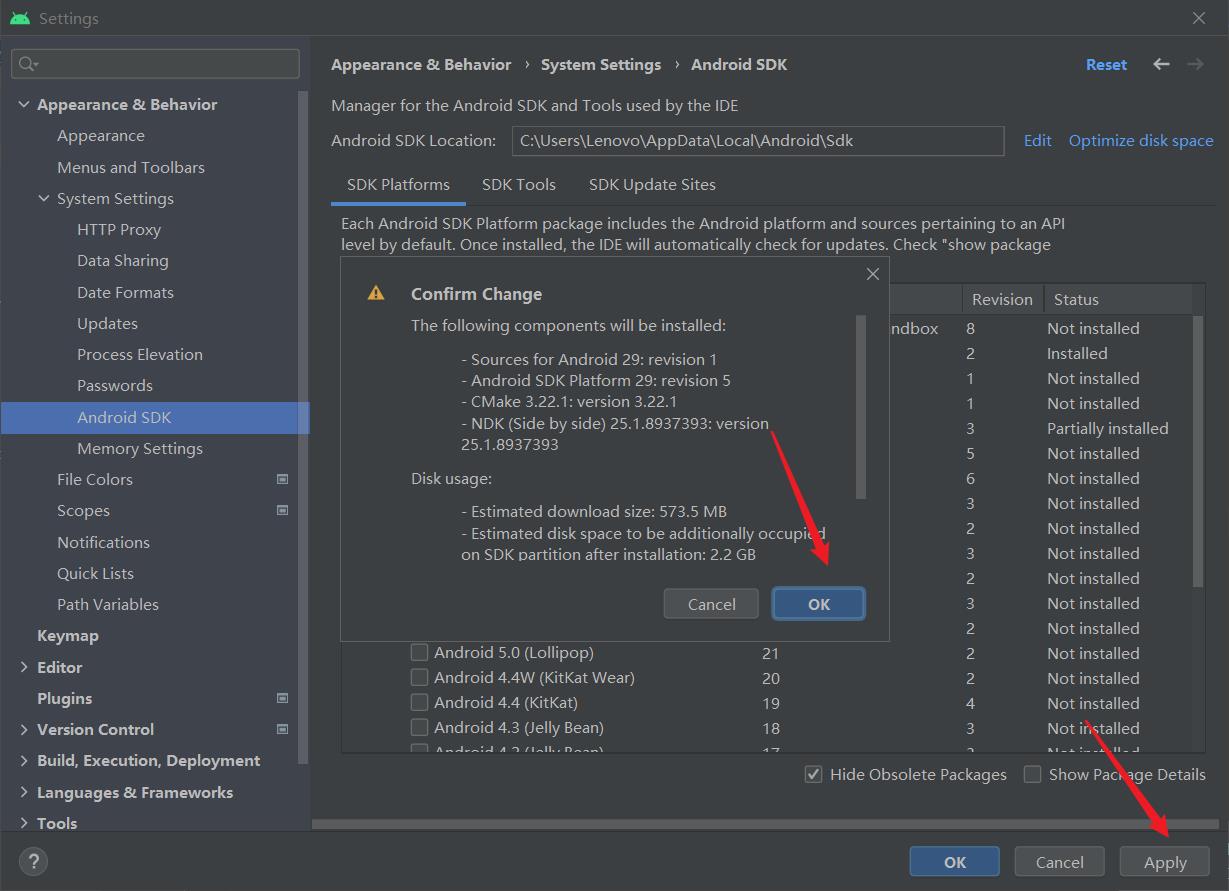

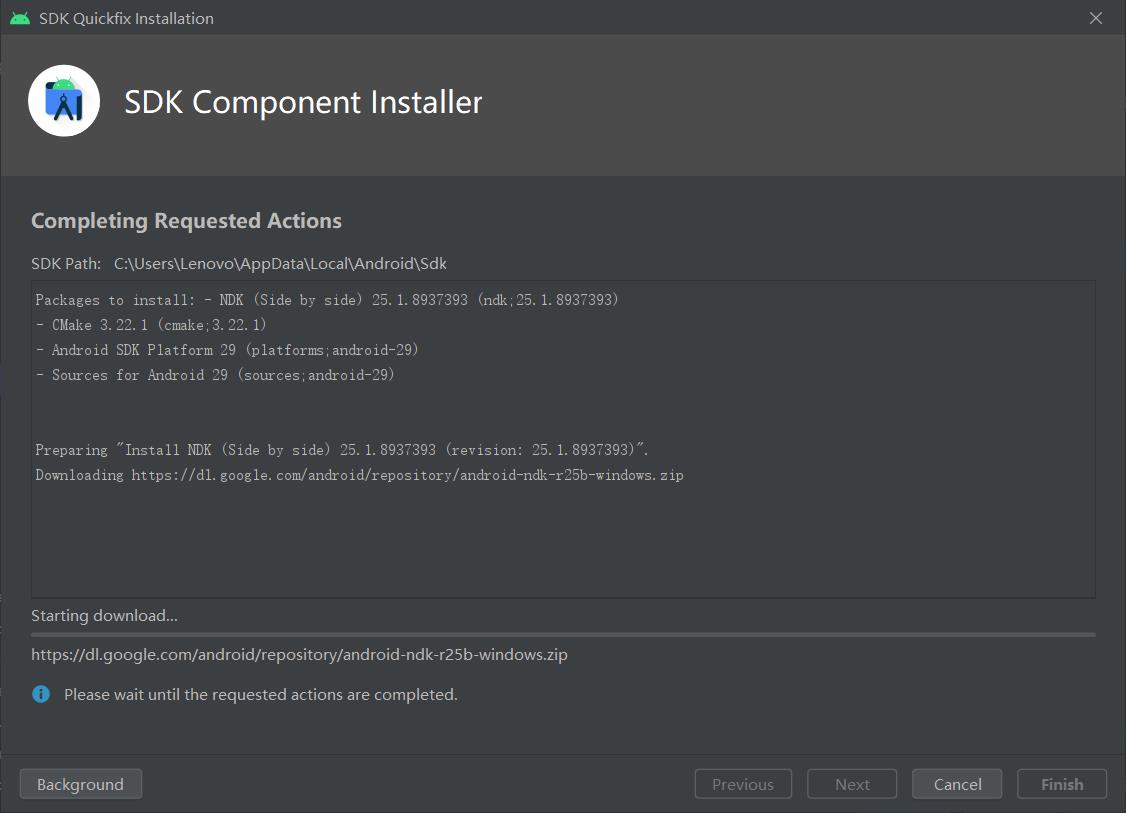

这里需要说明一点,我们应该安装NDK、Cmake

- 这里根据自己的手机版本来选择对应的开发环境

- 最后点击应用安装

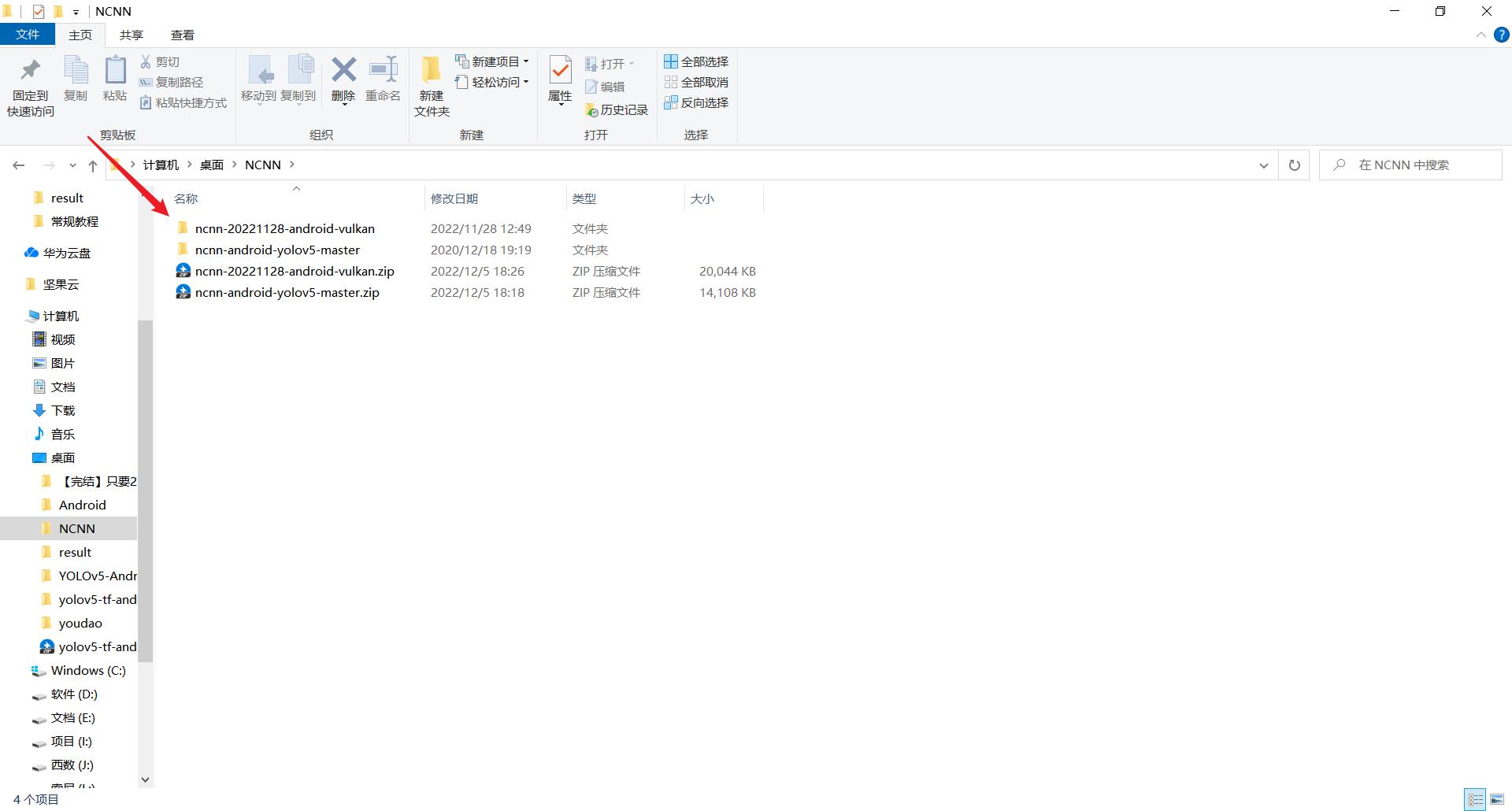

2.2.2. 下载解压源码

下载解压NCNN和ncnn-android-yolov5工程

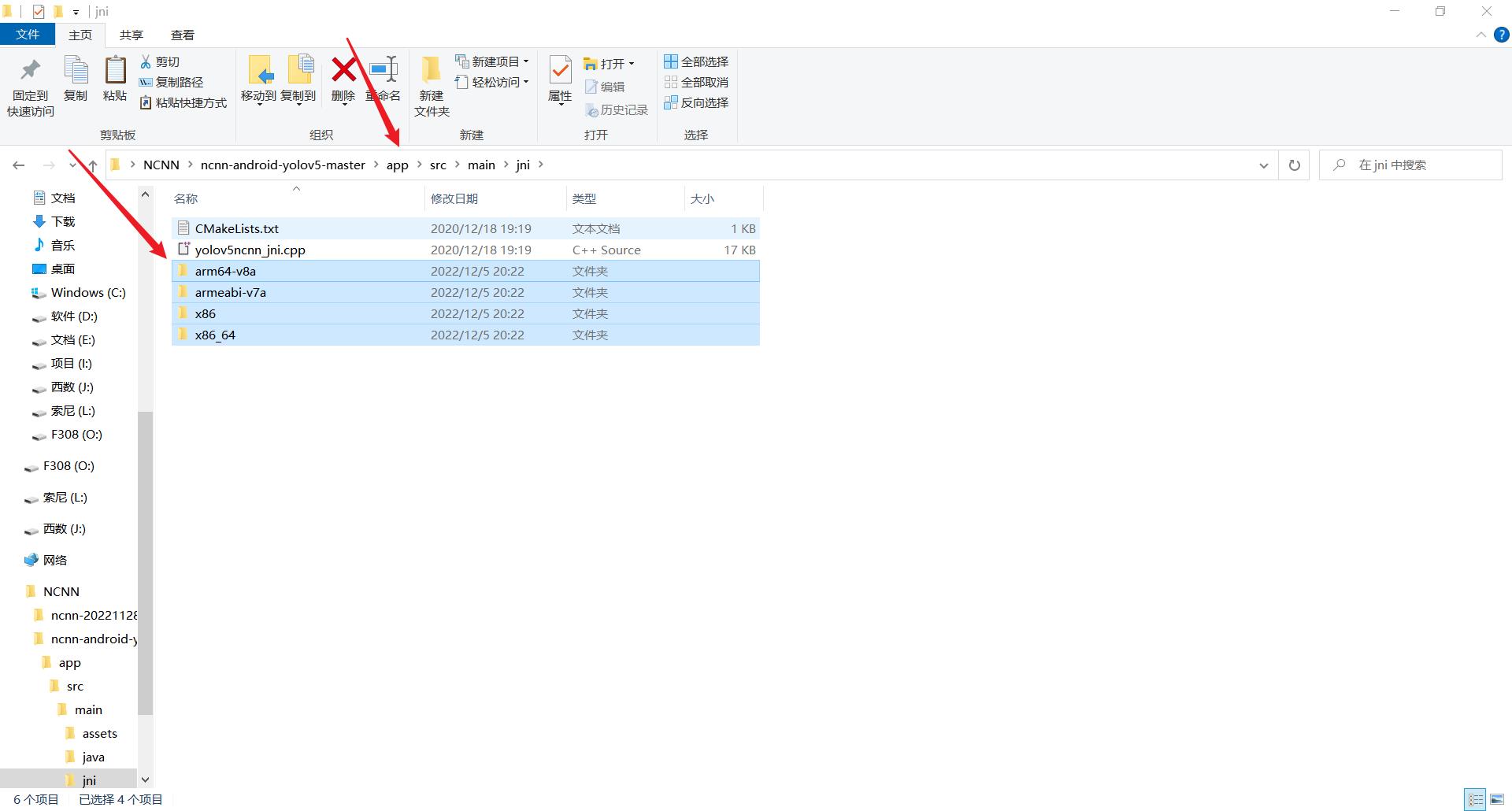

- 把ncnn-20221128-android-vulkan里面的文件复制一份到ncnn-android-yolov5-master的\\app\\src\\main\\jni目录下

2.3. 安卓源码重新编译

2.3.1. 构建工程

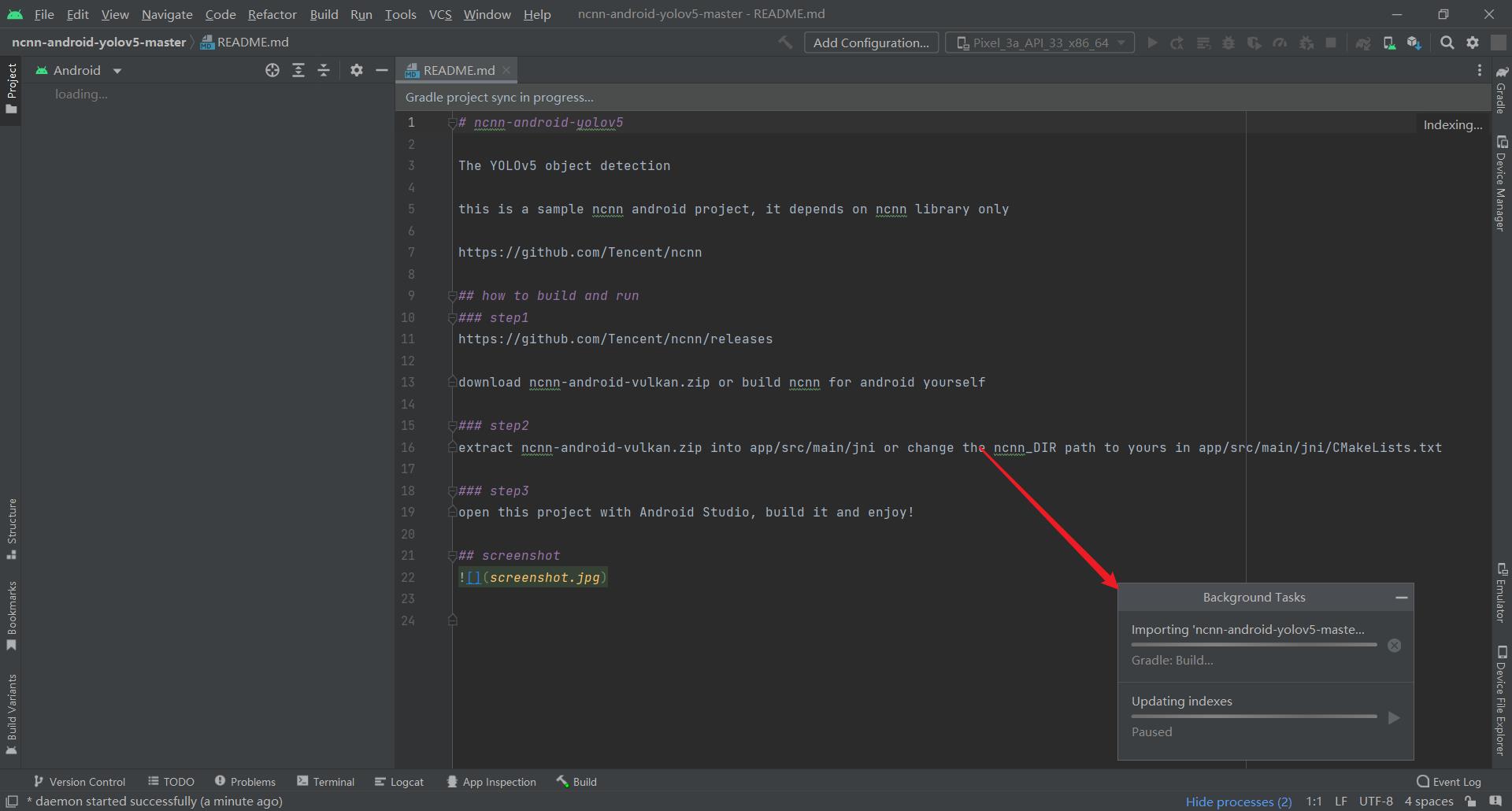

用Android studio 打开这个ncnn-android-yolov5-master项目的build.gradle文件

- 之后Android studio会帮我们构建整个工程,耐心等待他走完

2.3.2. 修改源码

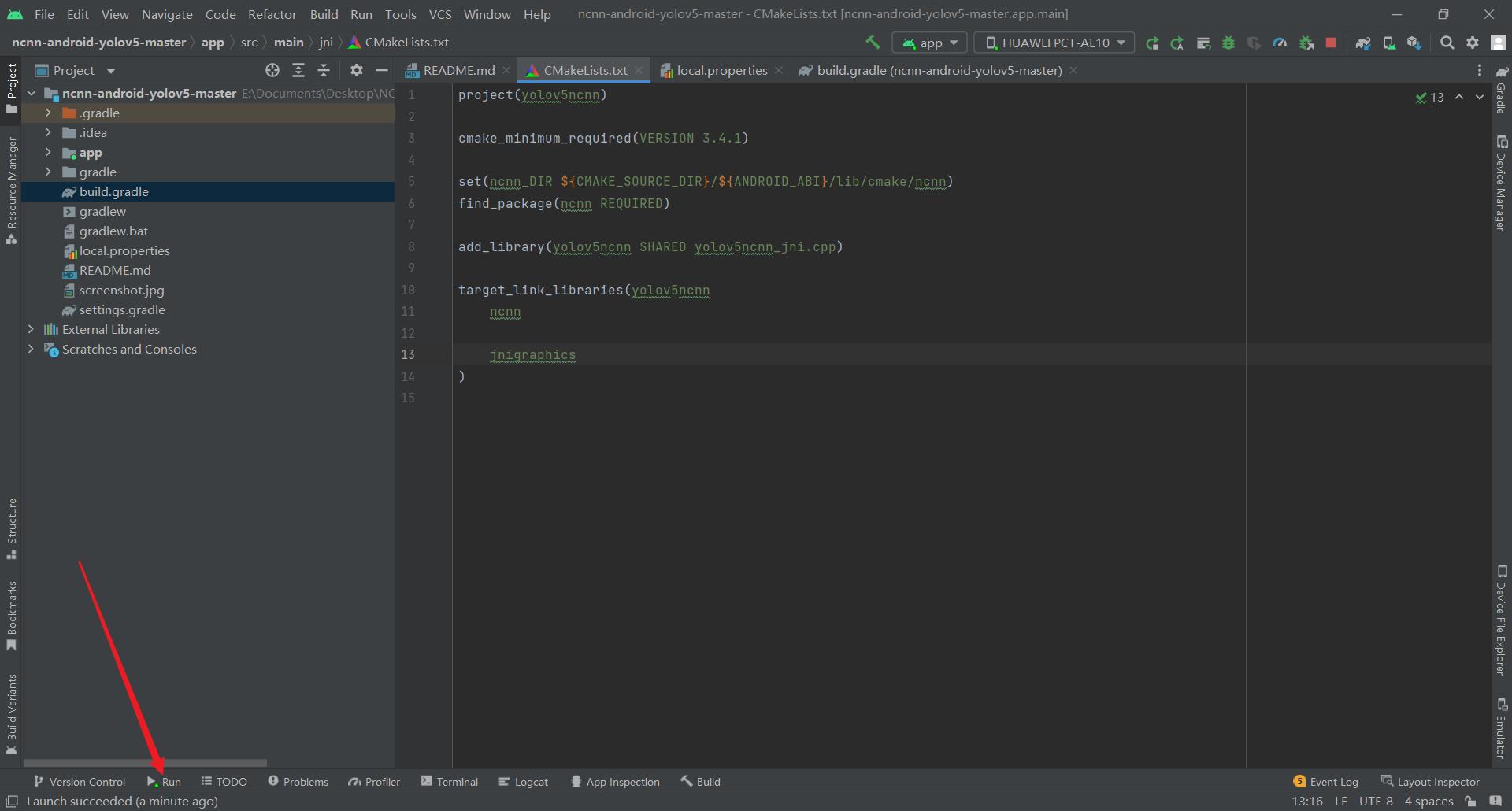

2.3.2.1. 修改CMakeLists.txt中的路径

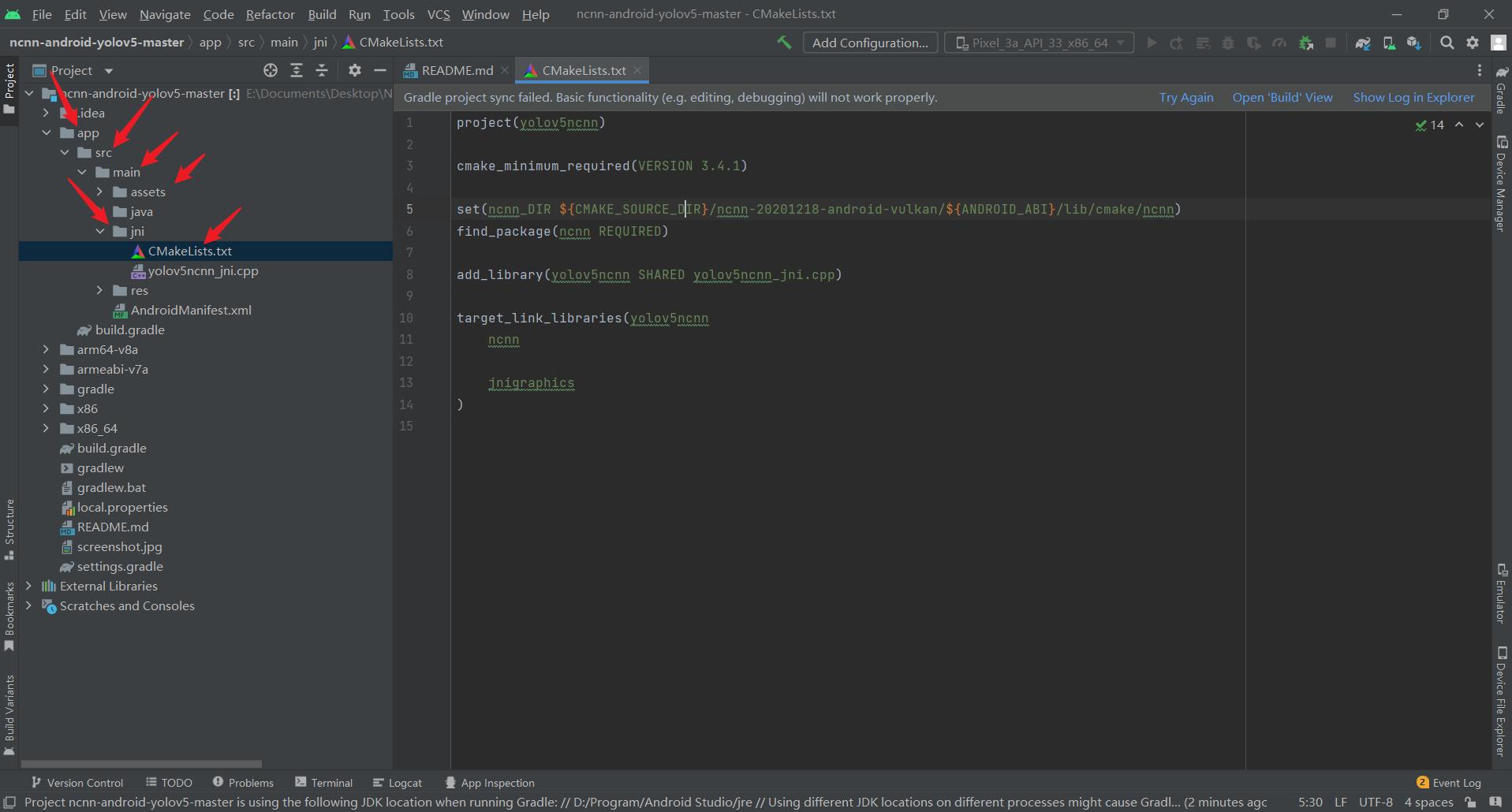

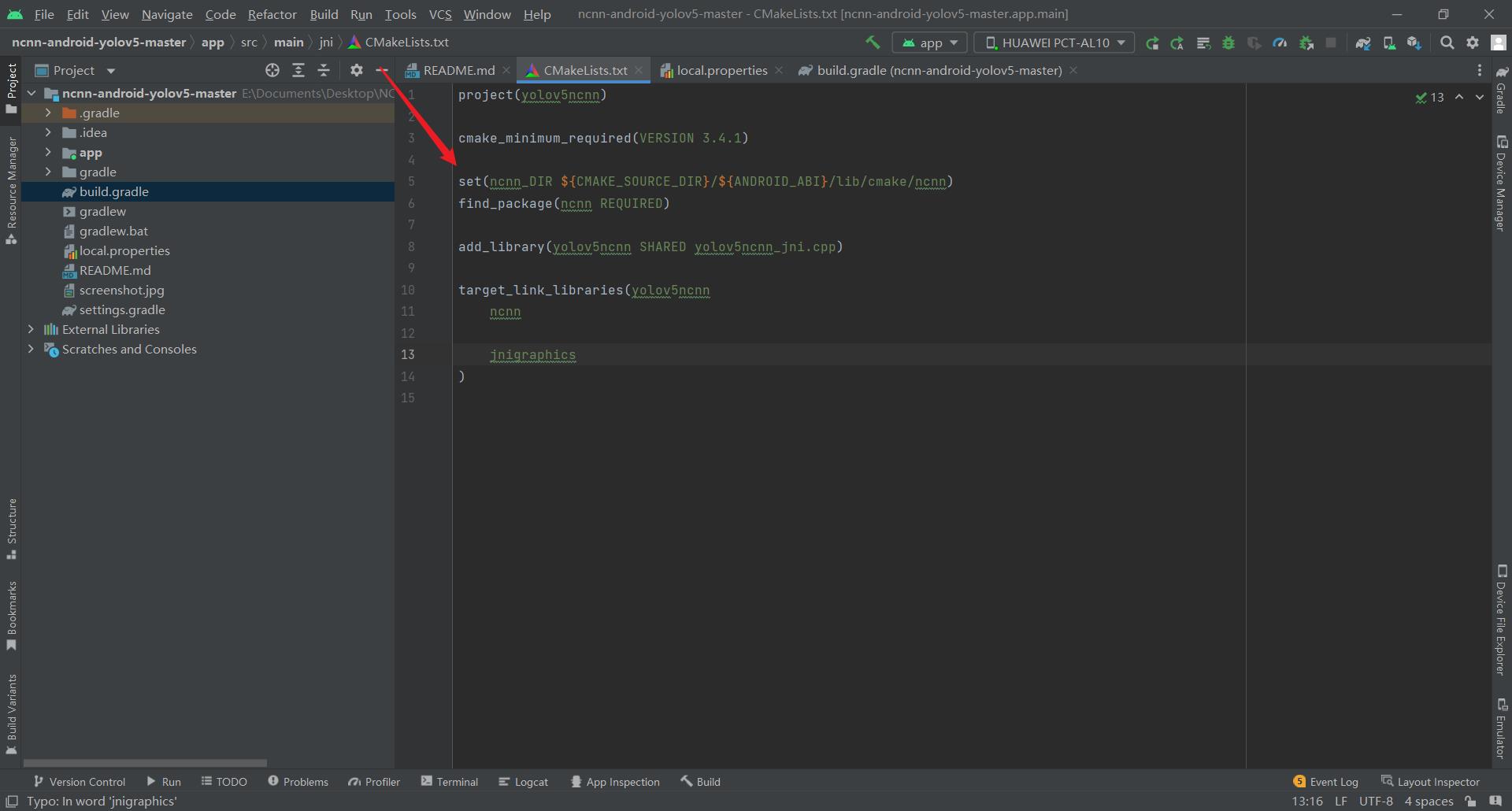

- 打开ncnn-android-yolov5-master\\app\\src\\main\\jni\\CMakeLists.txt

- 将第五行的路径改为自己的路径

- 也就是将

set(ncnn_DIR $CMAKE_SOURCE_DIR/ncnn-20201218-android-vulkan/$ANDROID_ABI/lib/cmake/ncnn)

- 改为

set(ncnn_DIR $CMAKE_SOURCE_DIR/$ANDROID_ABI/lib/cmake/ncnn)

- 也就是把作者的根目录给删除掉

- 修改之后

- 简单说明一下:ANDROID_ABI对应的是不同架构下的文件夹名称

2.3.2.2. 重新重新ysnc project

2.3.2.3. 安装APP到手机端

点击这个开始按钮即可

- 可以看到,手机端已经安装好这个APP了

- 点开看一下界面

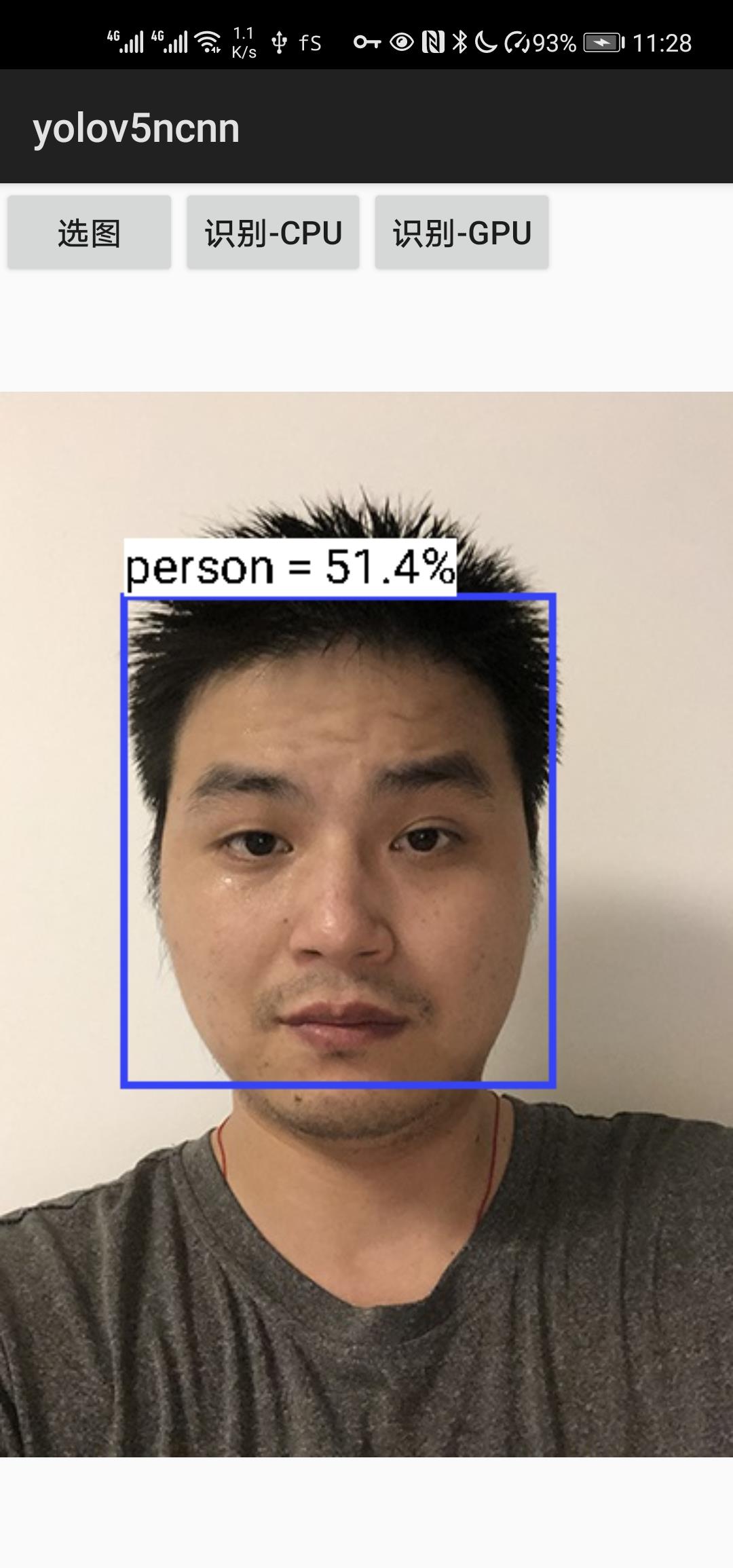

2.4. demo效果测试

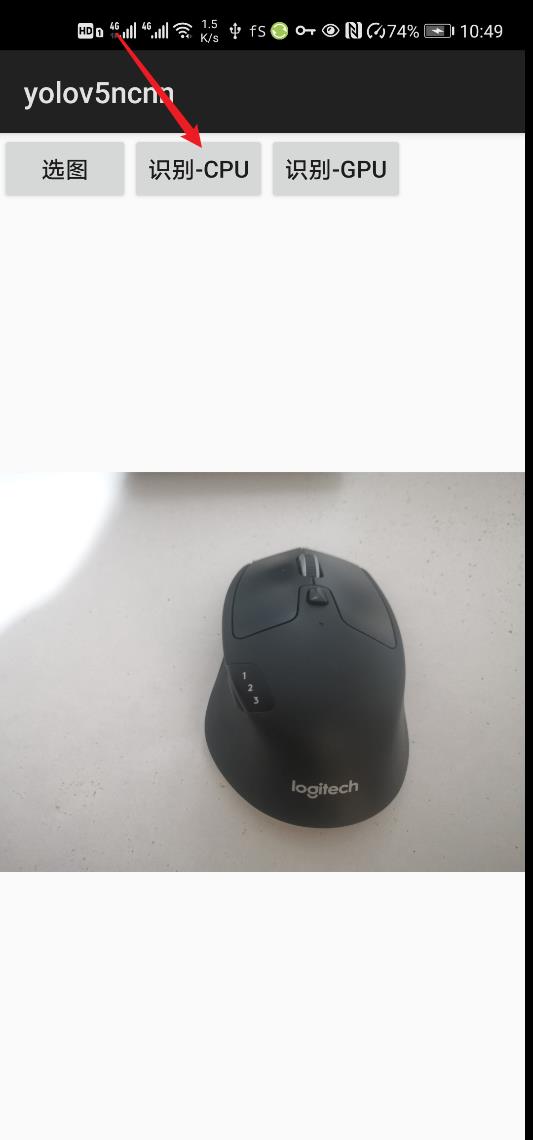

-

我们选择一张有物体的图片,点击识别

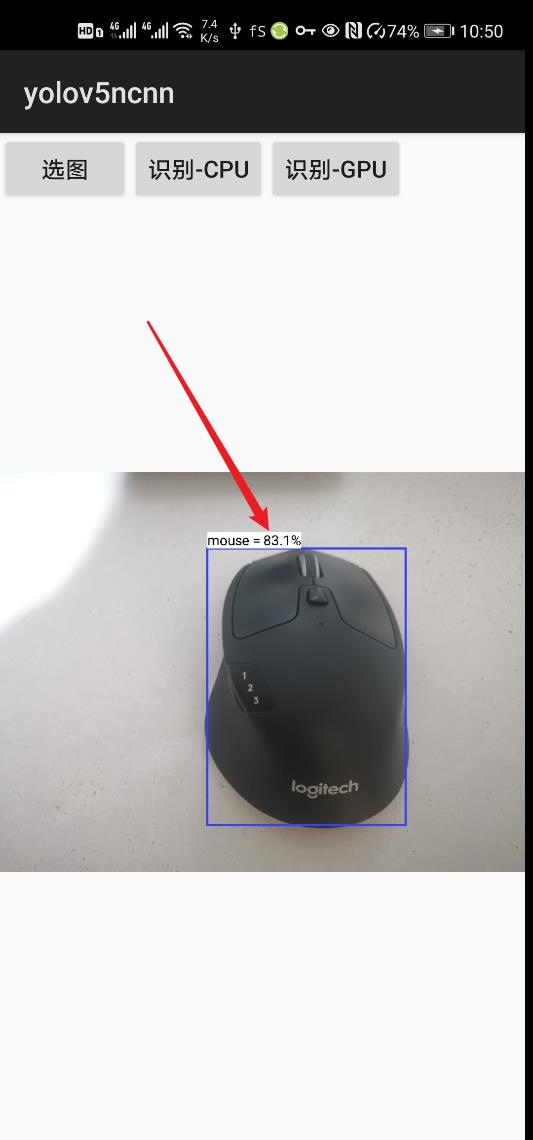

-

可以看到,已经可以用目标检测框把这个鼠标给框出来了

-

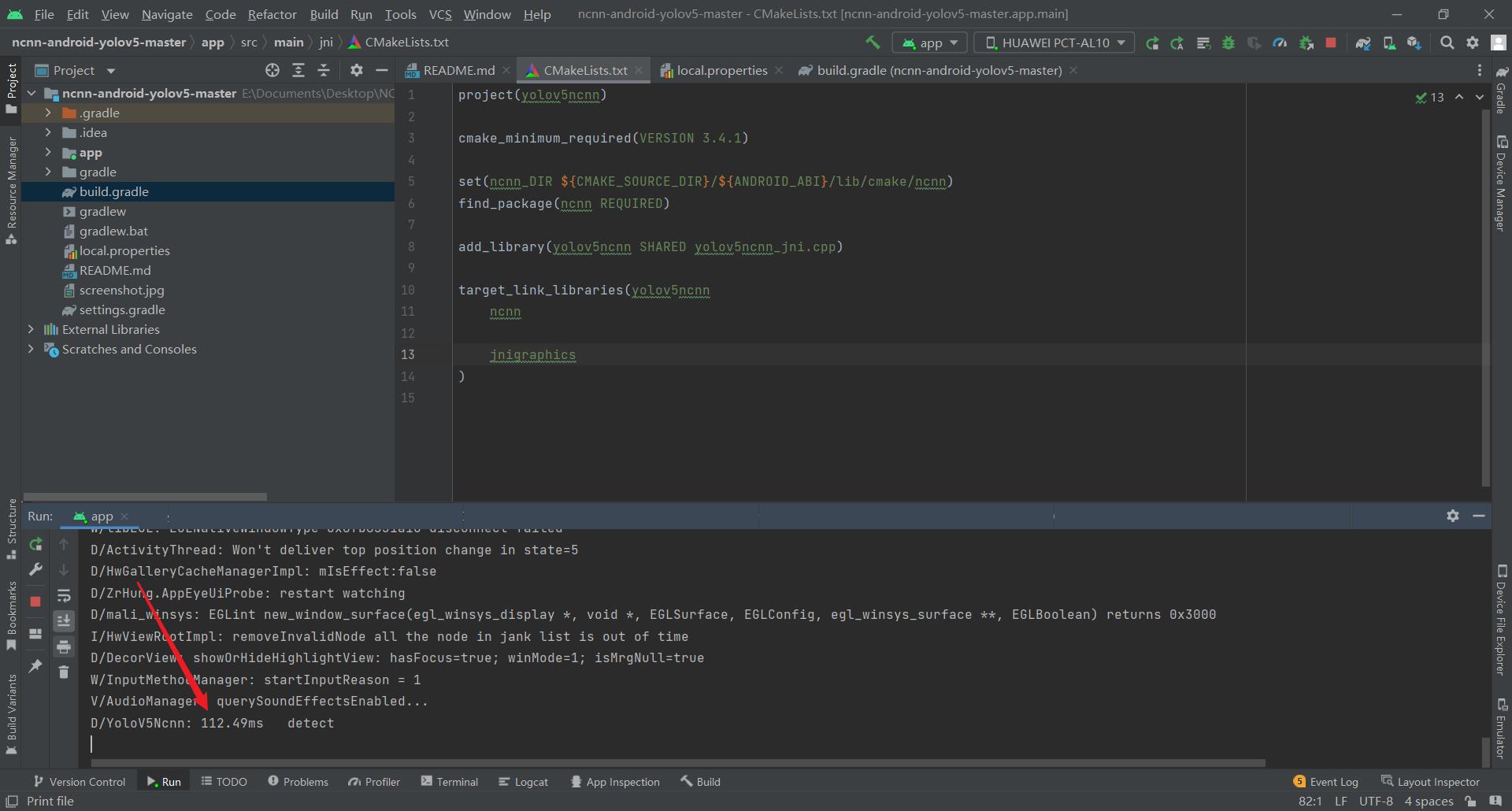

如果我们想查看手机识别的精确结果,可以点击这个run状态栏(需要注意,这个操作必须是手机通过数据线连接电脑才行)

-

这个时候再在手机端进行选图识别,电脑端就会打印出识别所用的精确时间

这里CPU识别一张图片用112毫秒,GPU识别一张图片需要201毫秒,这是什么鬼?可能是GPU模型比较大吧,导入的速度会慢一点,处理单张图片看不出来区别,处理视频的时候应该还是GPU更好。

2.5. 换成自己的训练模型

- 当我们训练好了自己的检测模型后,就需要一种中介,通过它在不同的框架之间进行转换,Open Neural Network Exchange 简称 ONNX,意思是开放神经网络交换格式,它就是我们需要的中介。

- 其实这个修改源码所需的工作量也没多少,

2.5.1. 转换自己训练的pt权重为ncnn格式

我们采用.pt ->onnx->ncnn的路线来转换自己训练的模型

2.5.1.1. 导出需要的onnx文件

2.5.1.1.1. 首先,安装onnx包

- pip install onnx coremltools onnx-simplifier

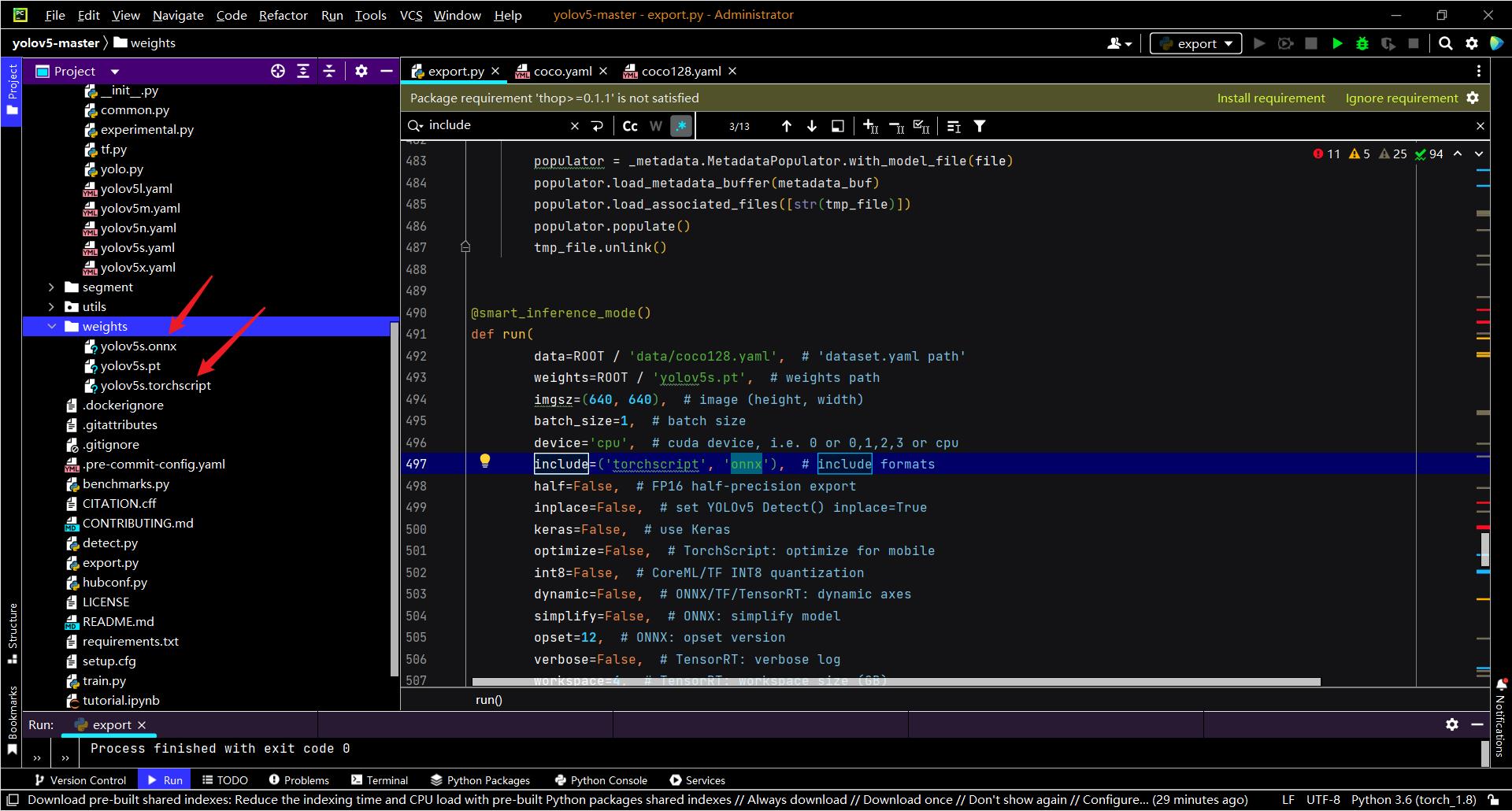

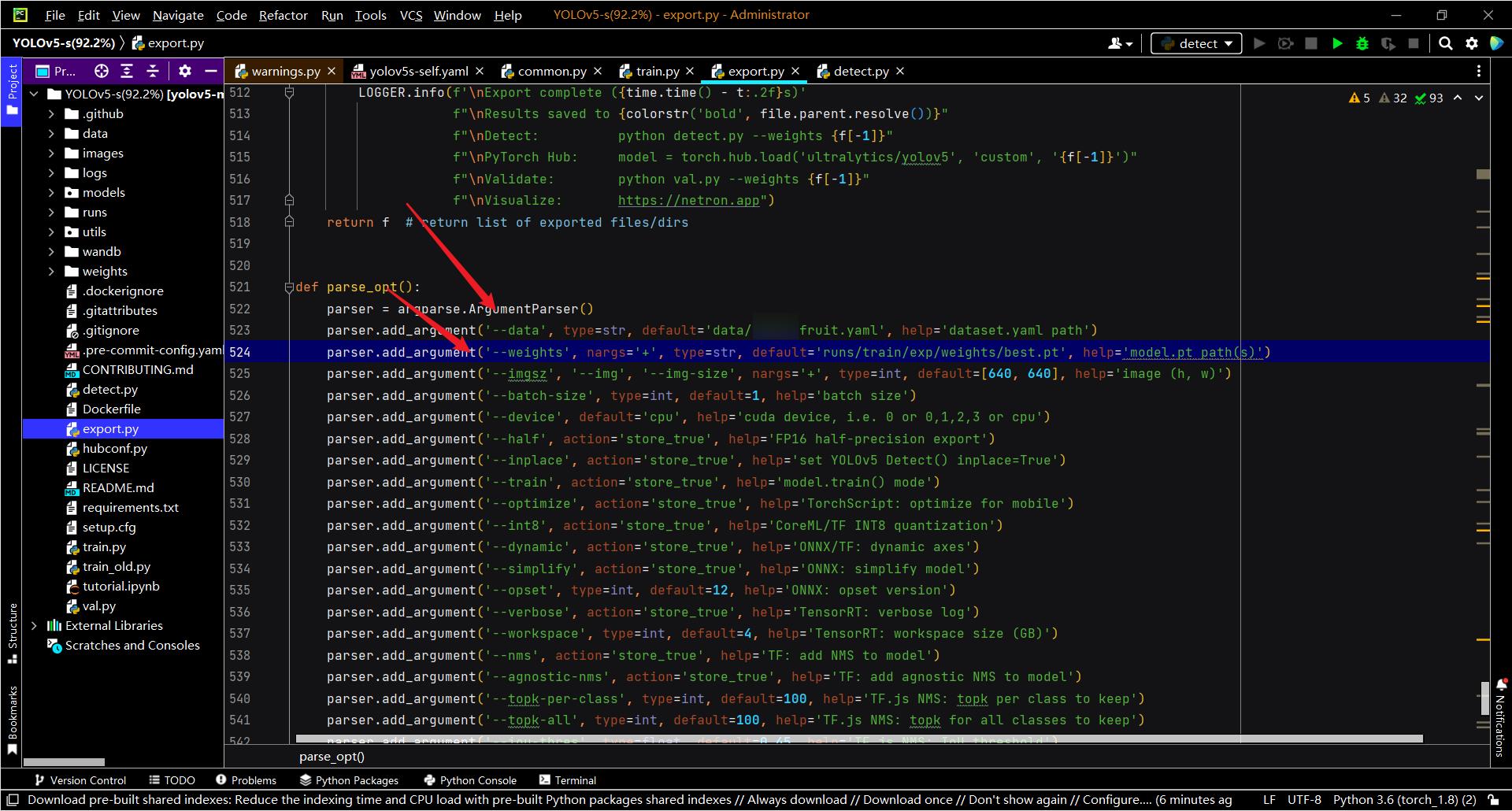

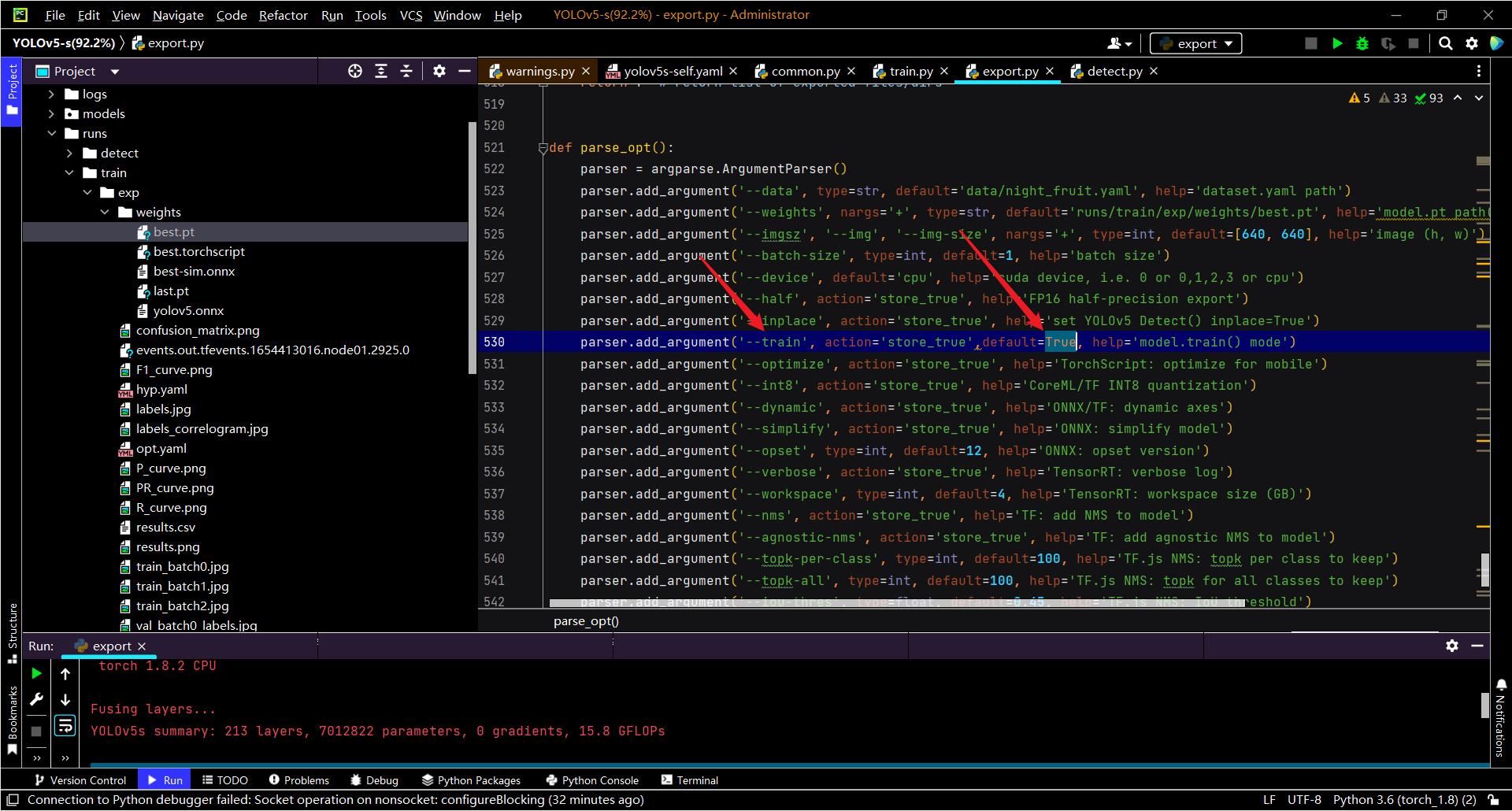

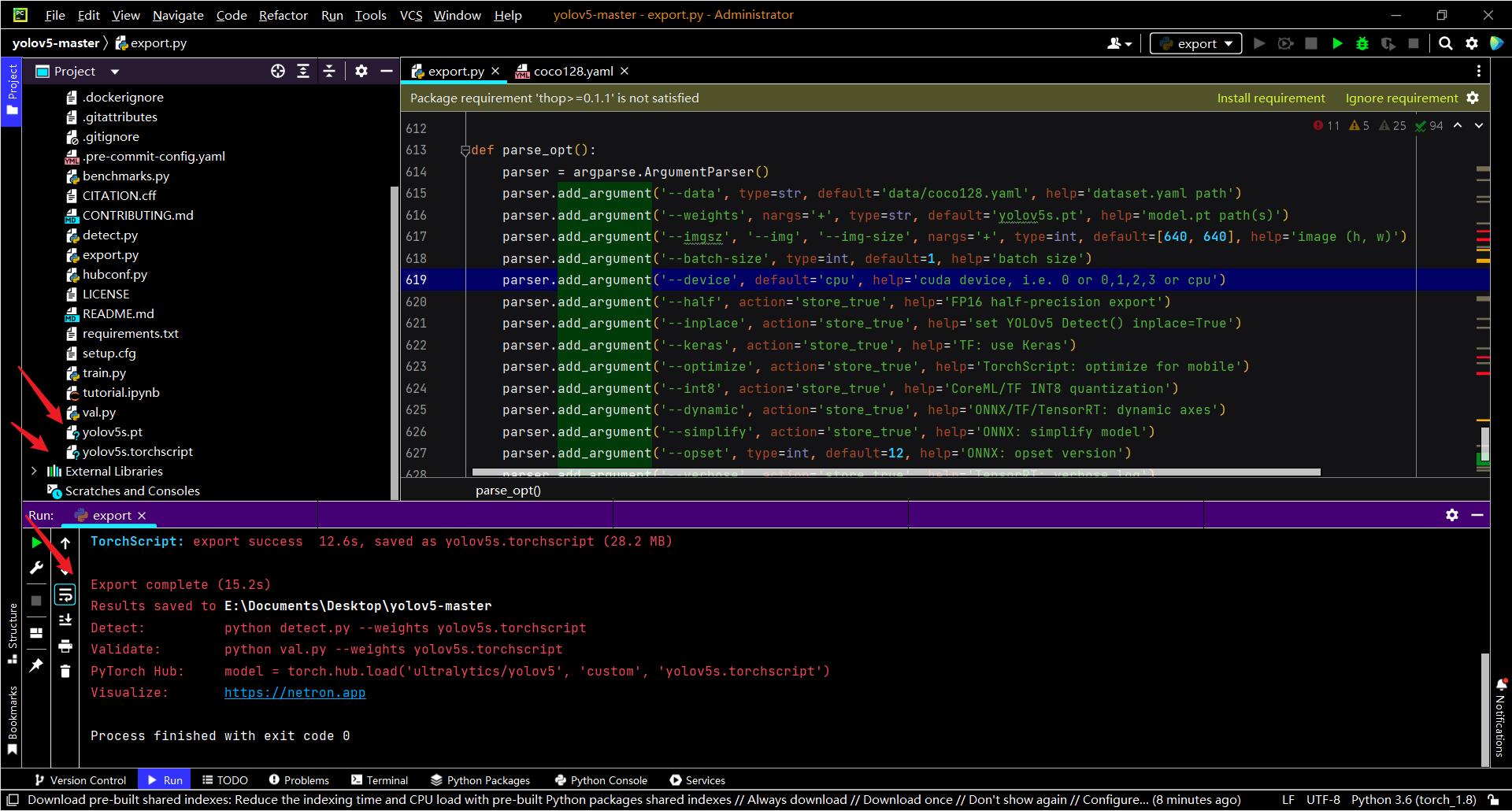

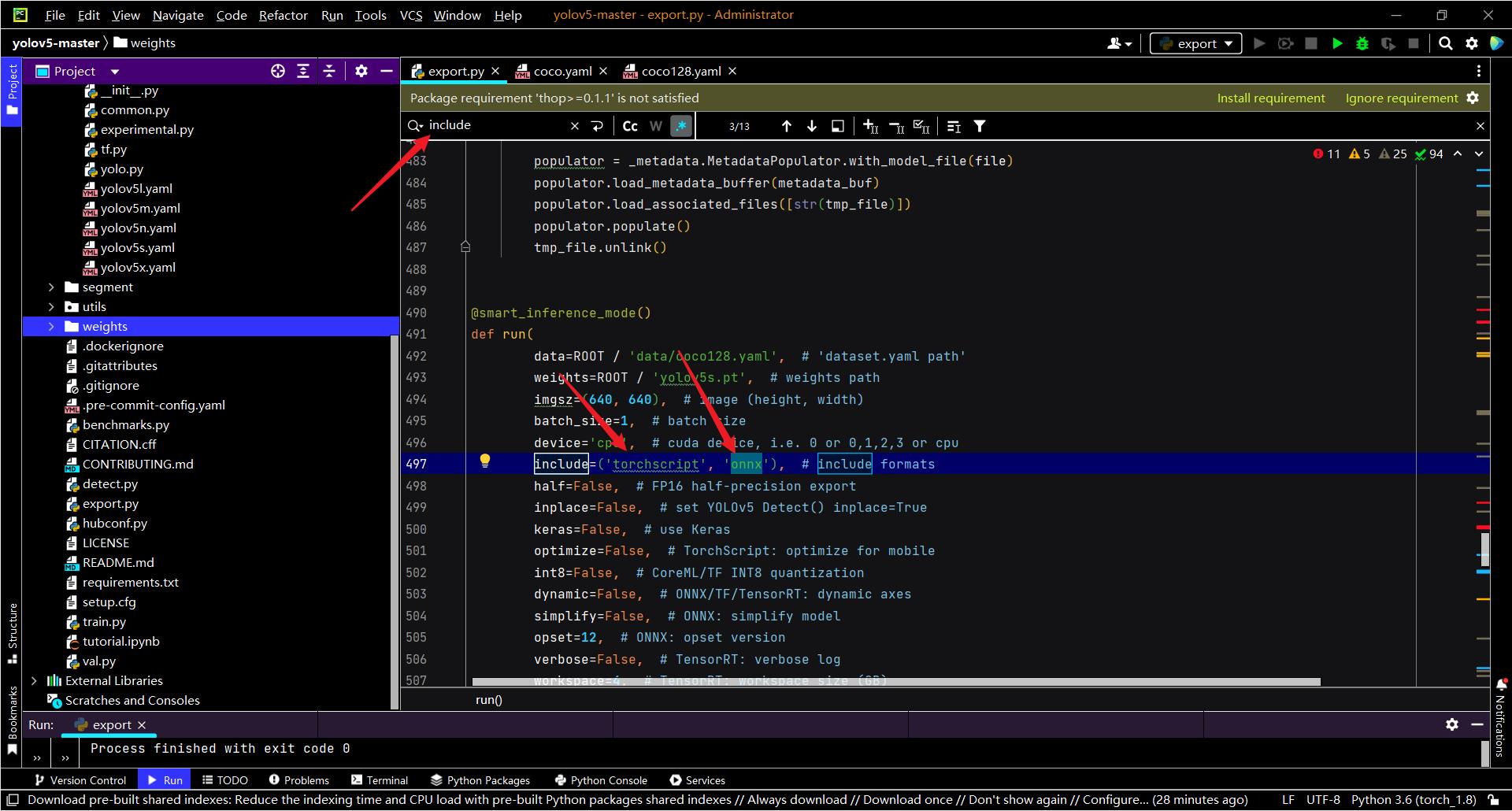

2.5.1.1.2. 使用YOLOv5自带的export.py进行转换

- 执行export.py操作前,修改weights和data的路径

- 这里有一点非常重要,一定要选择train模式去掉后处理,否则最终生成的APP会闪退(自己在这个问题上看了好长好长一段时间才摸索出来的经验)

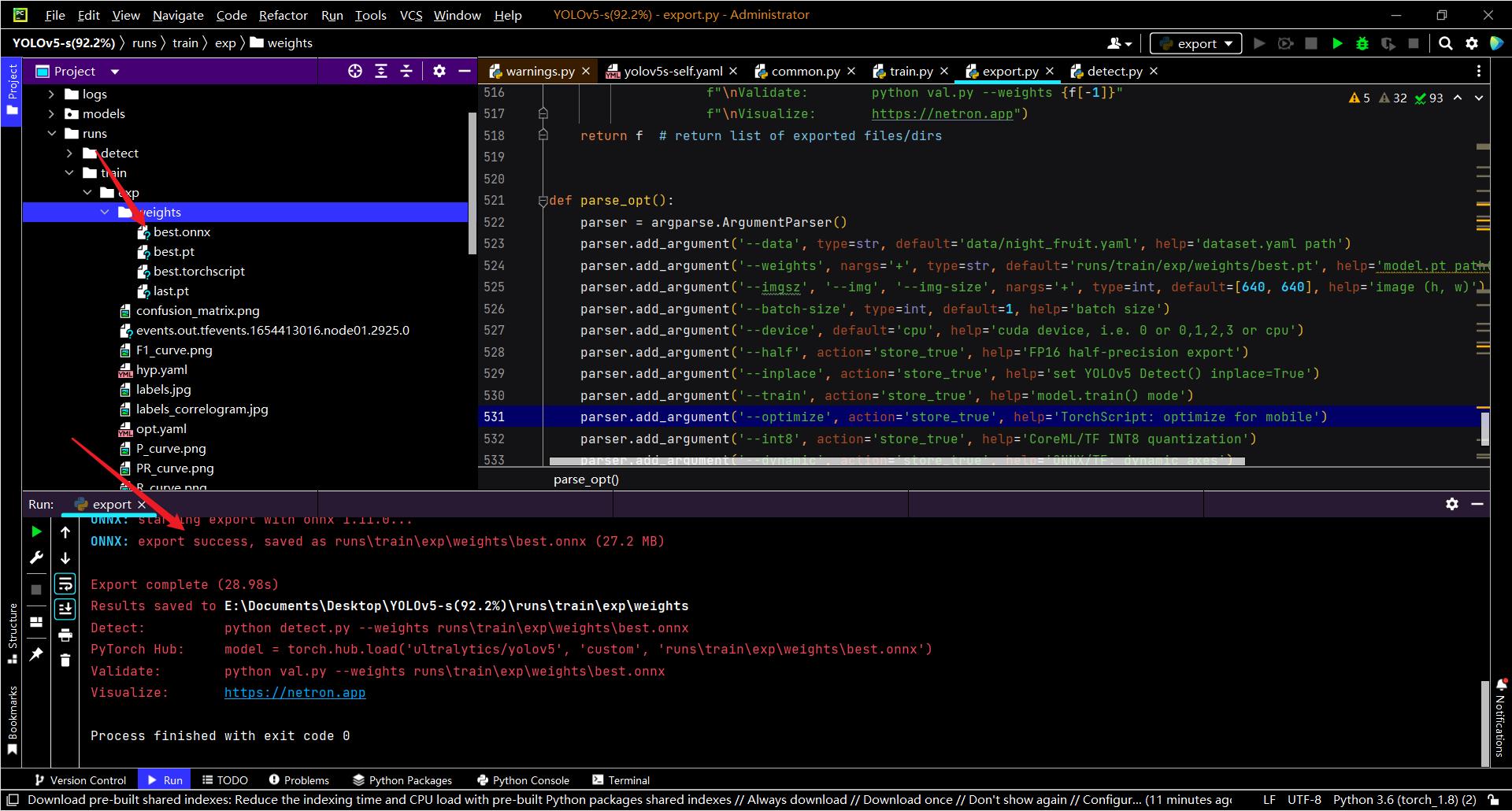

- 执行export.py操作后,会在权重文件夹下面生成一个onnx文件

- 如果PyCharm直接运行无法生成onnx的话,使用下面的脚本命令应该就可以成功了

export.py --weights weights/yolov5s.pt --include torchscript onnx

python export.py --train --weights weights/yolov5s.pt --include torchscript onnx

2.5.1.1.3. 对onnx文件进行压缩

- python -m onnxsim best.onnx best-sim.onnx

- 压缩完之后会生成一个best-sim.onnx的文件

- 这一步是必须的,如果这一步不做,后面ONNX转NCNN可能会报错

2.5.1.2. 将onnx文件转换成param文件

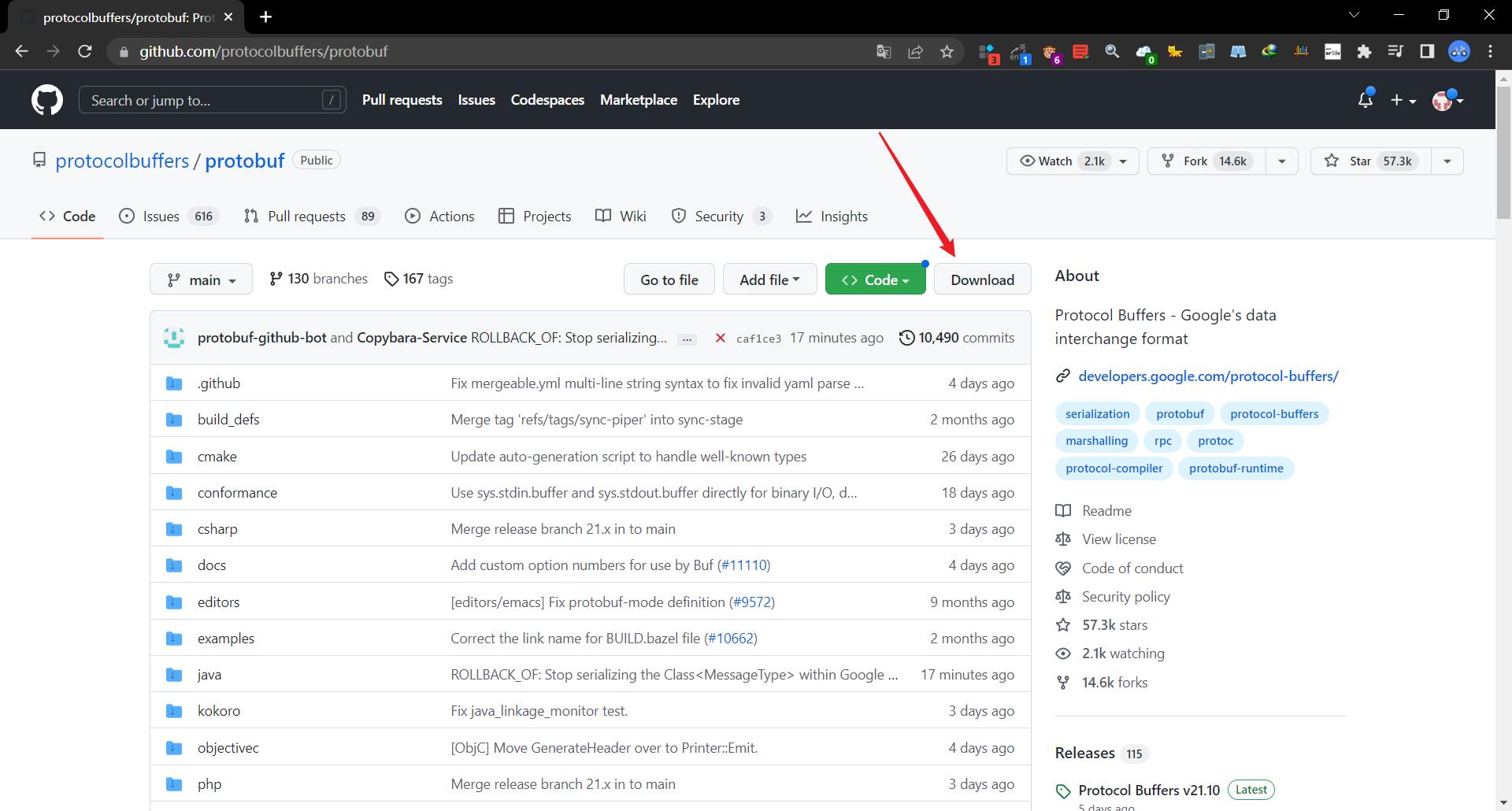

2.5.1.2.1. 使用protobuf进行转换(过程繁琐不推荐)

- 之前方法就是使用protobuf来完成这个onnx文件到ncnn权重的转换,但是现在有更好的解决方法,转换效率更高速度、更快,也更傻瓜化;以前的这种protobuf虽然也可以用,但是对于大多数来说,应该只是一种极客的情怀罢,建议选用另一种方式,如果你坚持要用这种方式的话,那么就继续往下看吧

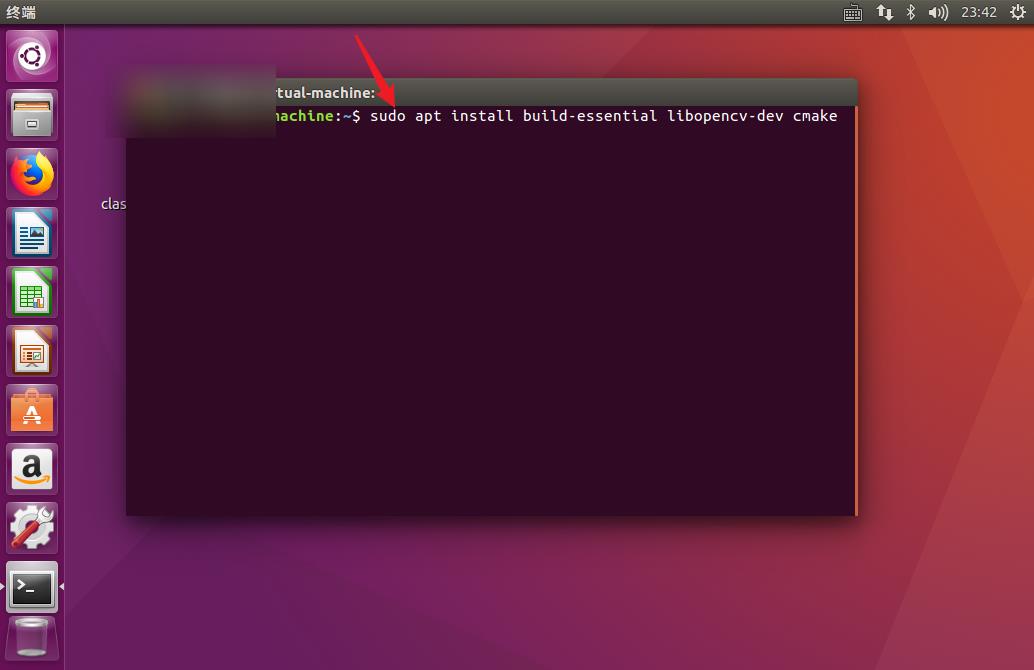

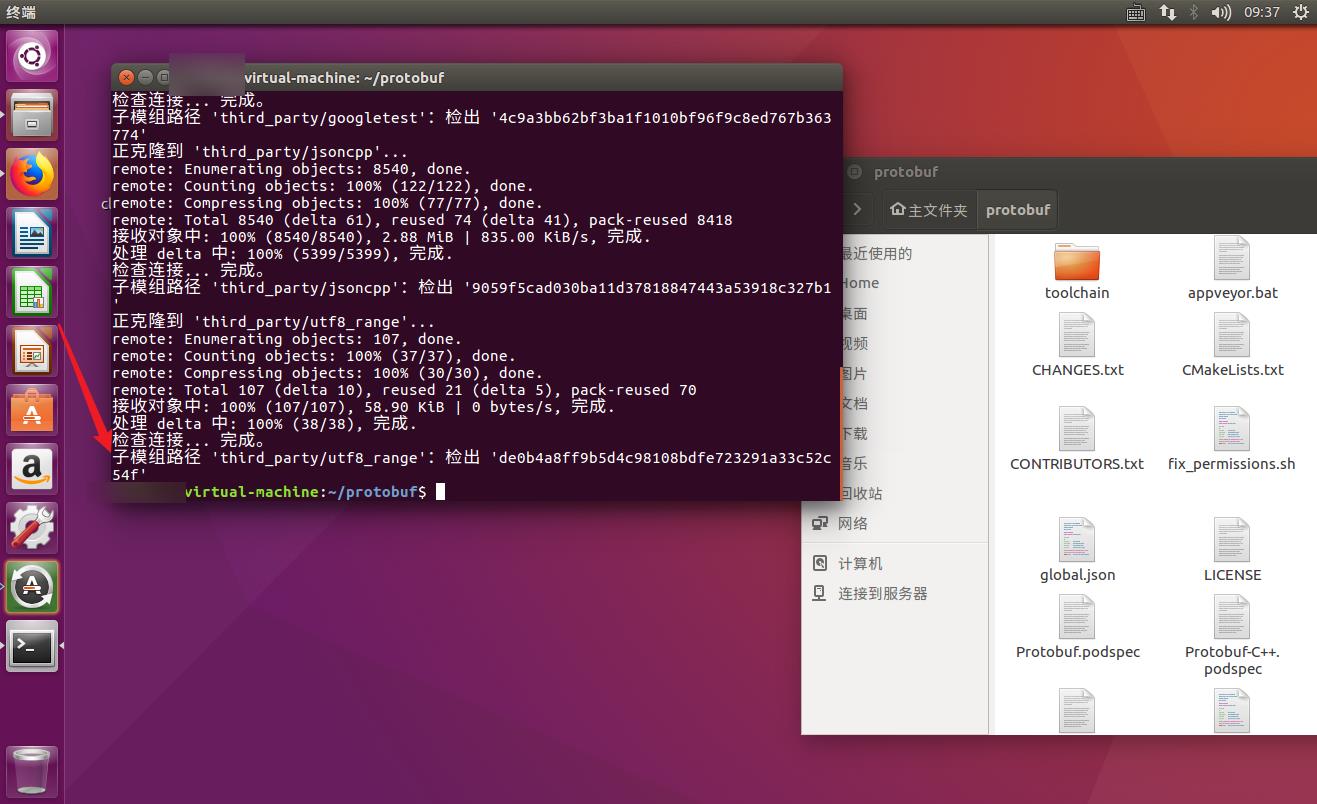

- 这个过程在Ubuntu系统上完成,可以使用真的Ubuntu系统或者使用虚拟机

- 我这里使用的是VMware虚拟机

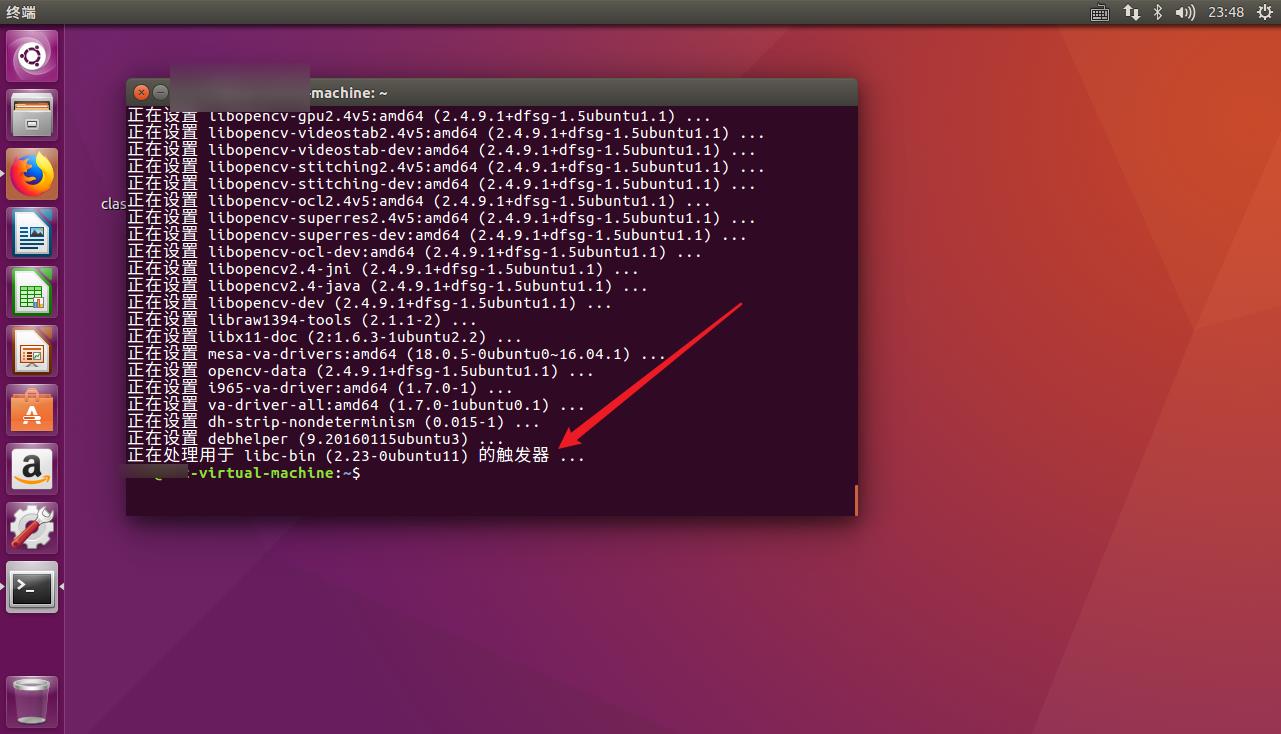

- 首先准备基础环境

sudo apt install build-essential libopencv-dev cmake git

- 安装完毕

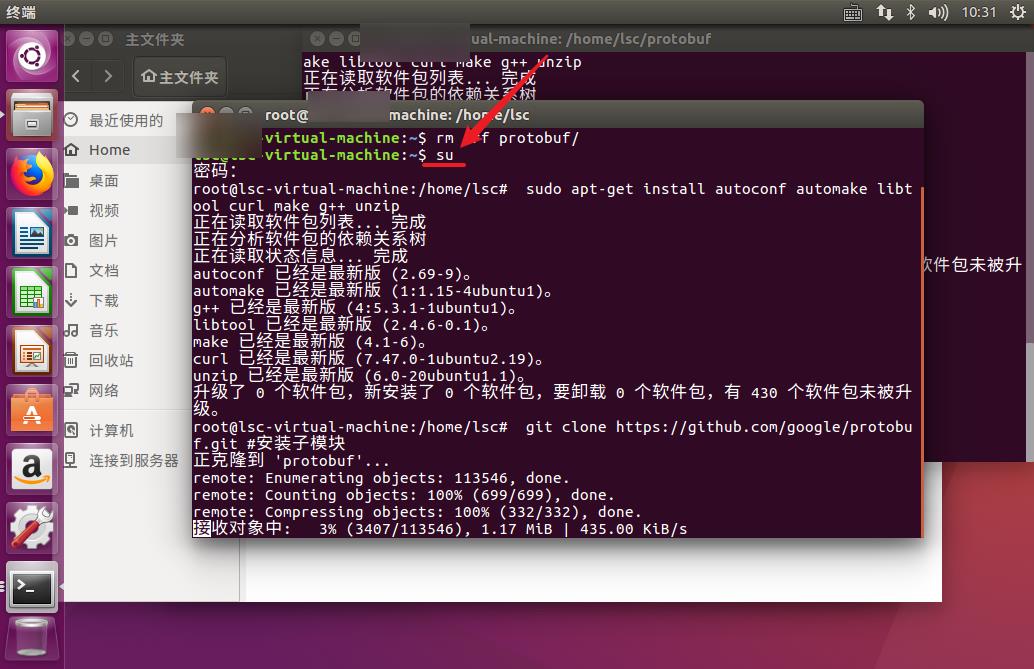

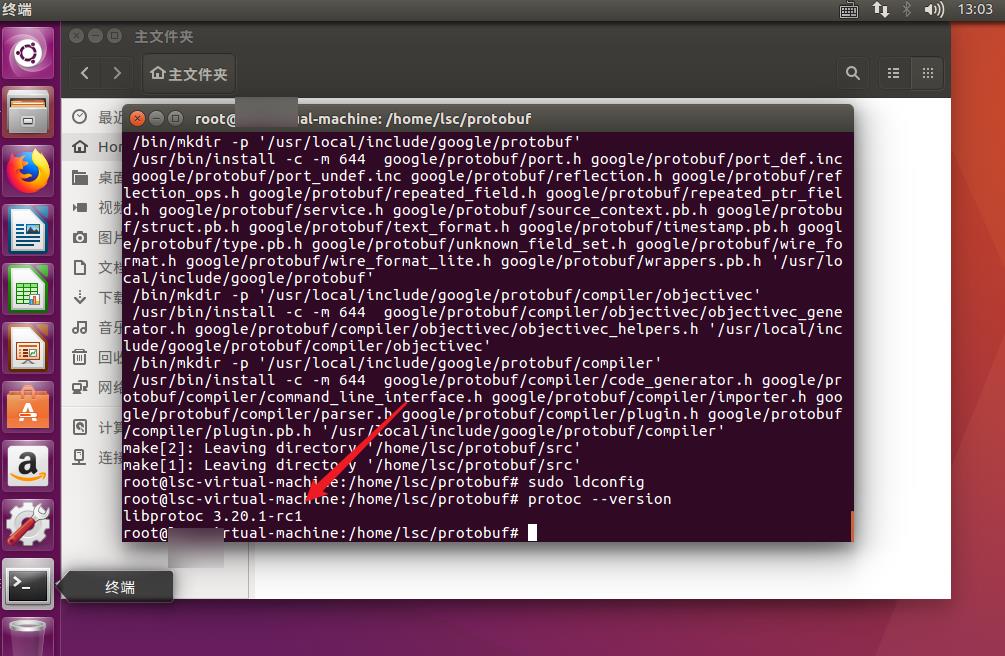

- 编译安装 protobuf 依赖库

- 需要注意的是,下面的命令都需要在管理员权限下运行,否则很有可能会运行失败(这一步有很多坑,我把自己能运行成功的代码贴上来了,但不保证大家都能运行成功。如果还是不可避免出奇奇怪怪的错误的话,那么去我下面的报错记录中查找或者自己上网上找对应的博客排查吧)

su

git clone -b v3.20.1-rc1 https://github.com/protocolbuffers/protobuf.git

cd protobuf

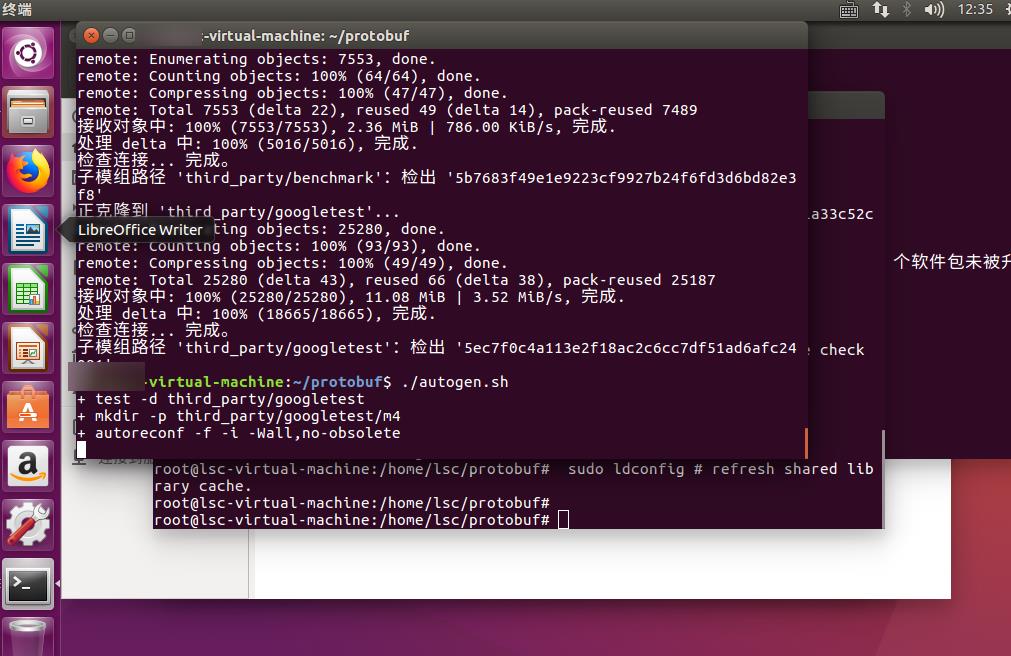

git submodule update --init --recursive

./autogen.sh

./configure

make

make install

sudo ldconfig

- 最终安装完之后会显示出protobuf版本号

protoc --version

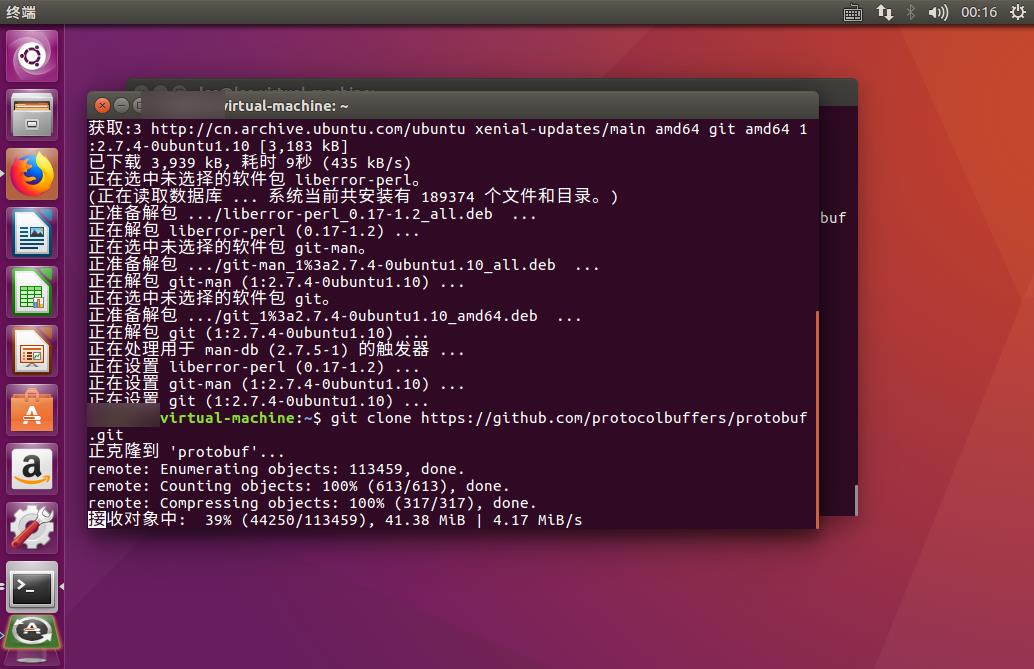

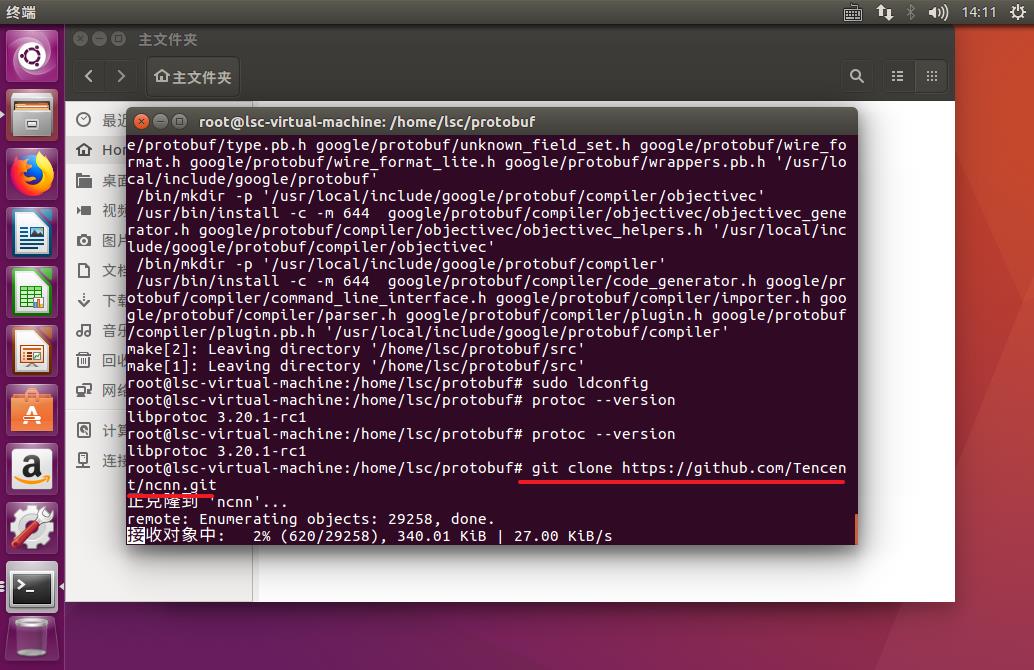

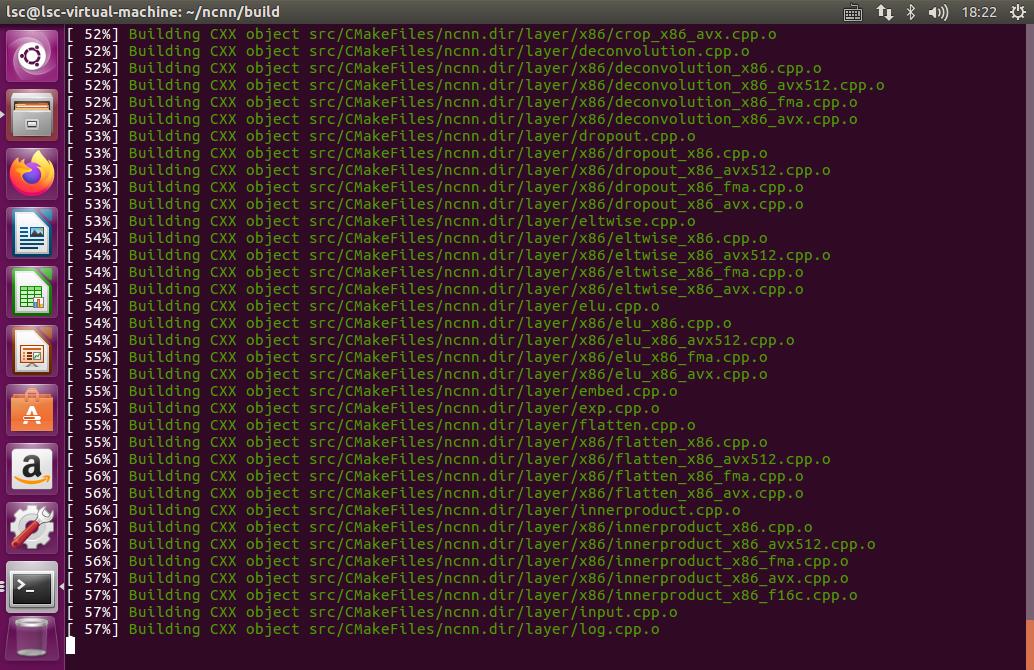

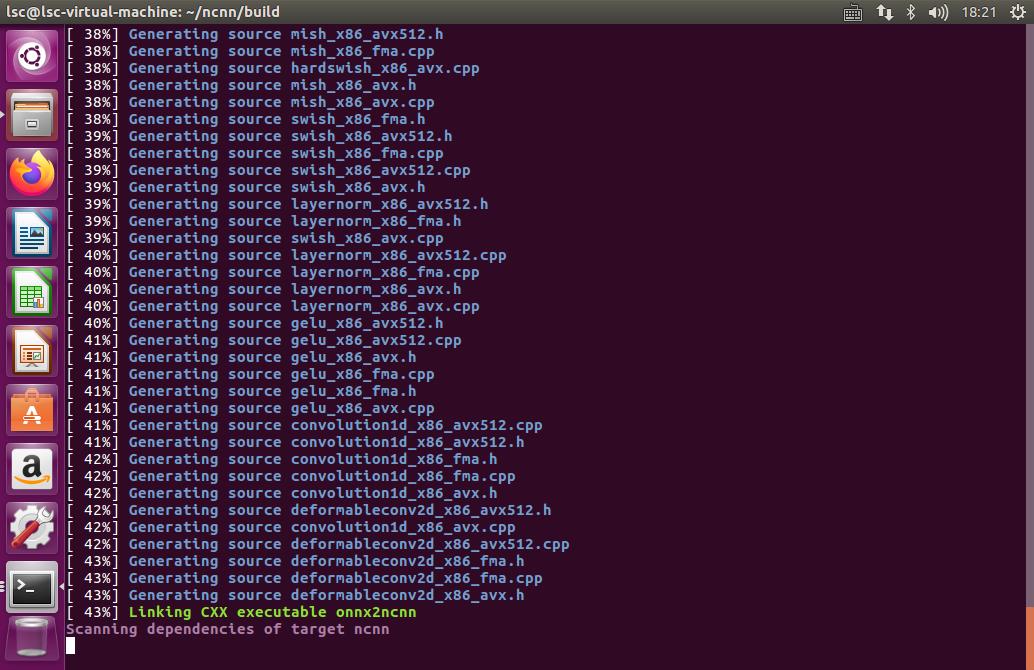

- 编译ncnn

- 目的是生成onnx 转 ncnn 的命令行工具

git clone https://github.com/Tencent/ncnn.git

cd ncnn

git submodule update --init

mkdir build

cd build

cmake ..

make -j8

make install

- 下载、编译完成

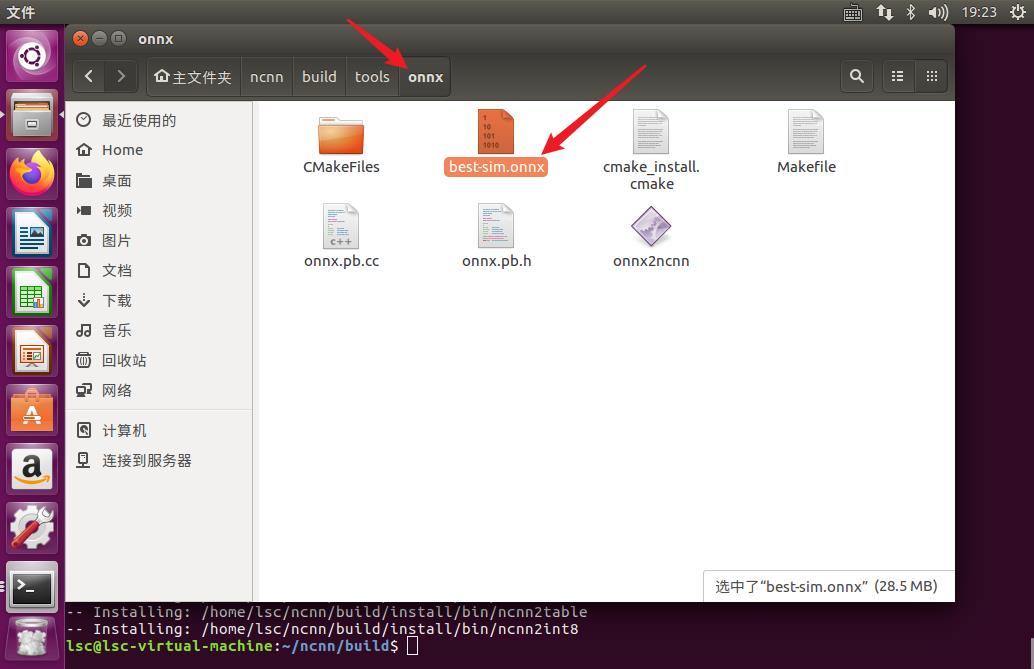

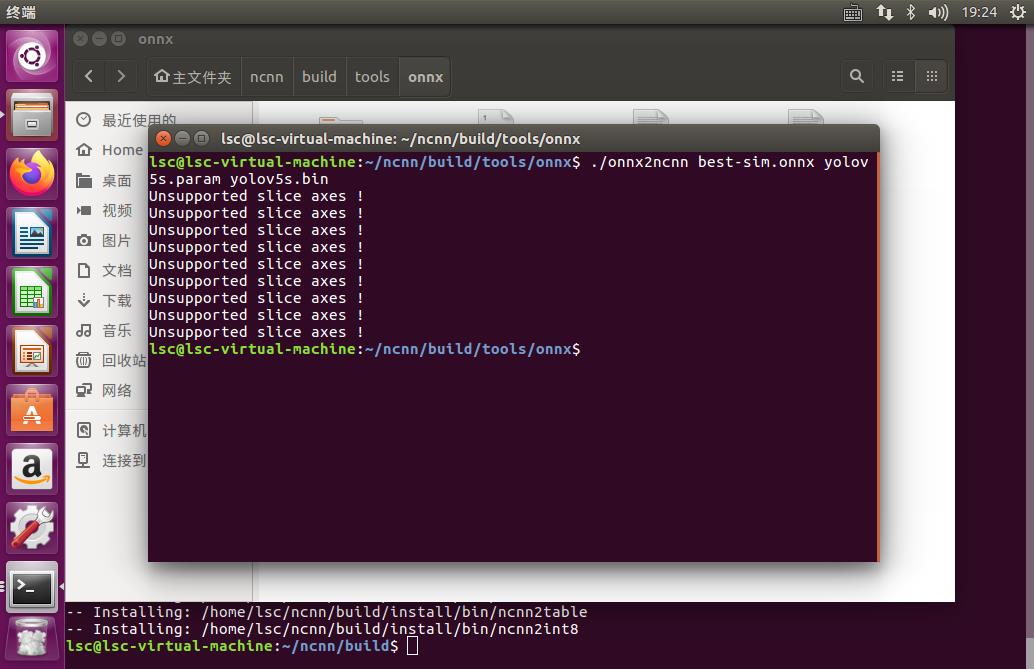

- 转换模型

- 编译安装完成后,就可以使用 onnx2ncnn 工具进行转换了

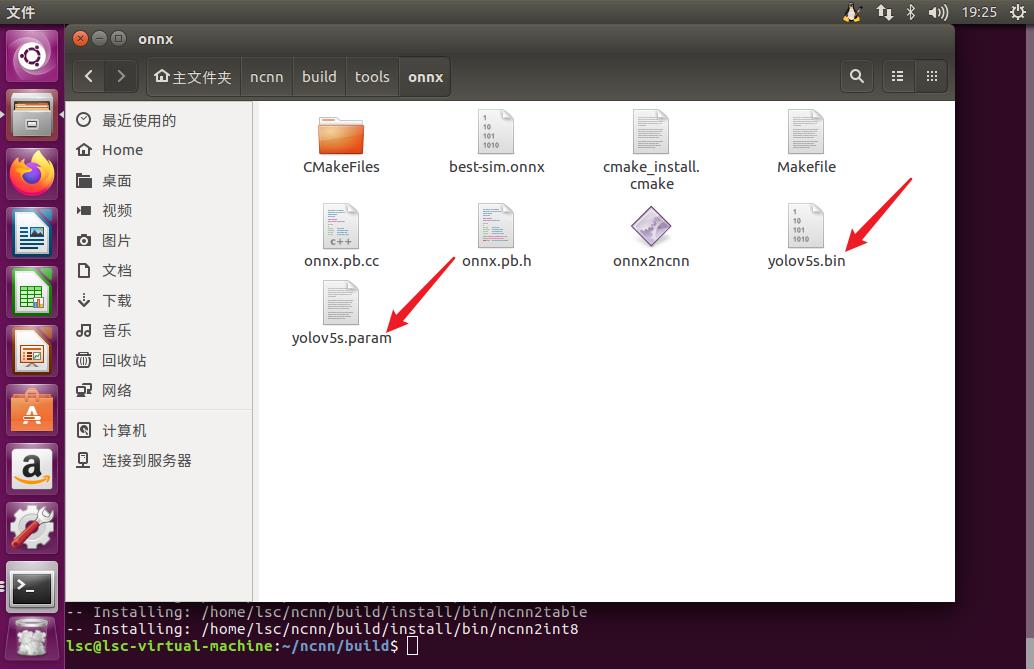

- 把自己之前压缩好的best-sim.onnx放在ncnn/build/tools/onnx文件夹下

- 之后切换到这个目录下,执行下面的操作

./onnx2ncnn best-sim.onnx yolov5s.param yolov5s.bin

- 操作成功后会生成yolov5s.bin和yolov5s.param两个文件

- 到这里,坑最多的转换部分就算完成了

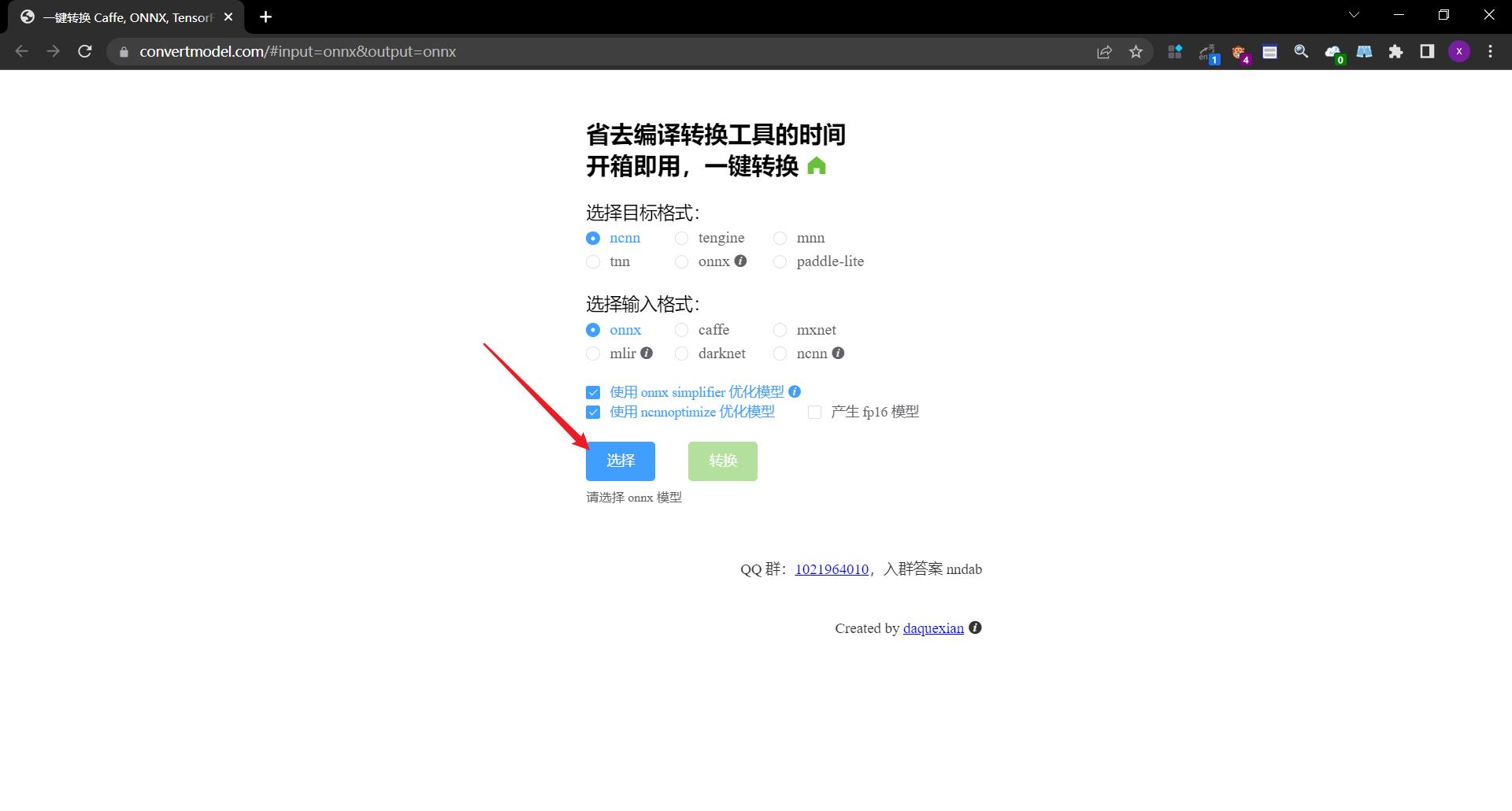

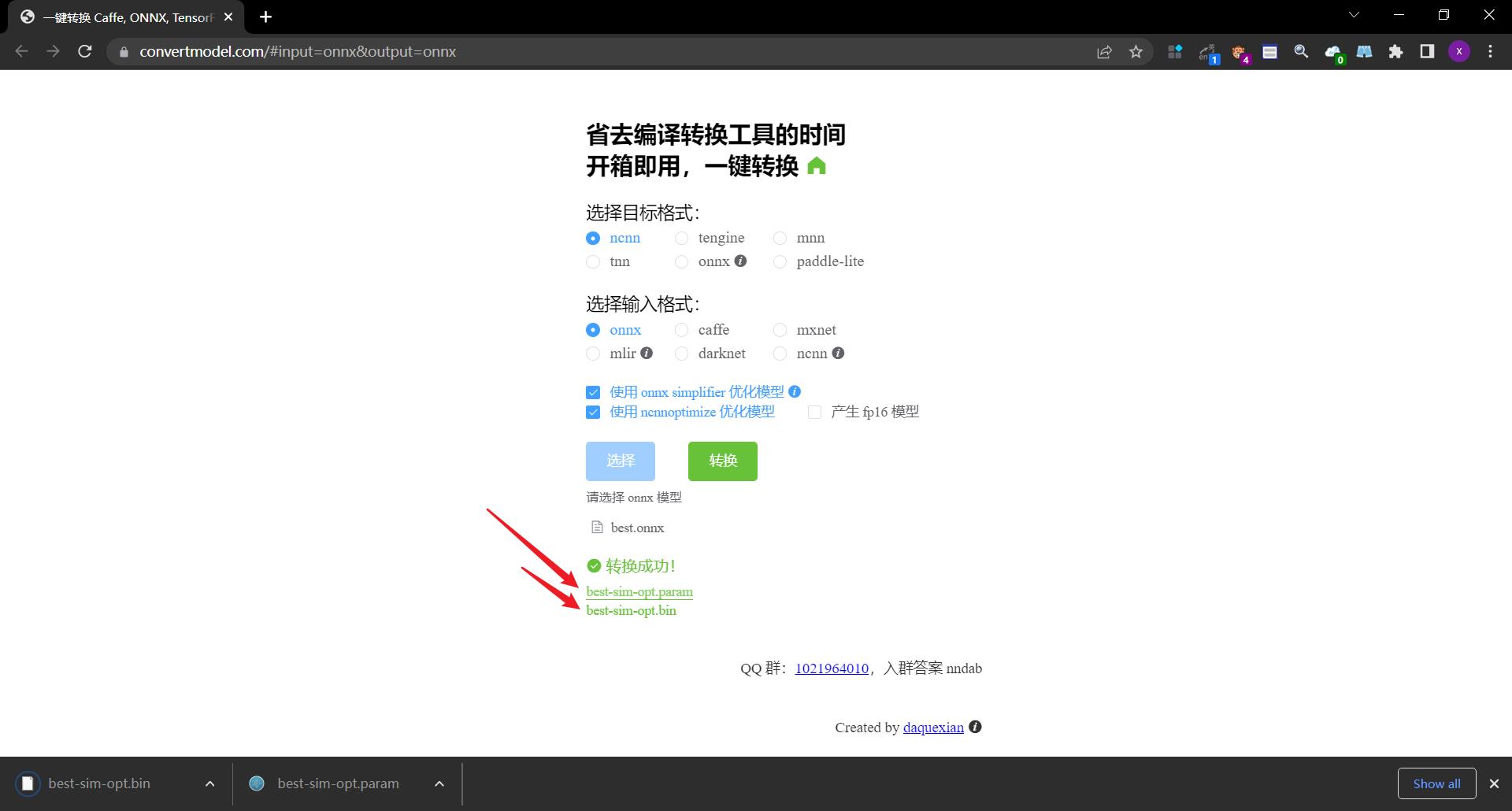

2.5.1.2.2. 使用onnxsim的在线端进行转换(过程简单,强烈推荐)

-

这种方式简直是我们做深度学习模型移植到安卓手机端的神器,整个过程里没有复杂的部署,也没有什么坑,有的只是人性化的操作界面,简单几个按钮就可以把整个流程给走完,节省好几个小时的时间,以及中间的无数大小坑,溢美之词不能再多了。

-

是在本地运行的,所以自己的模型是不会被泄露

- 使用

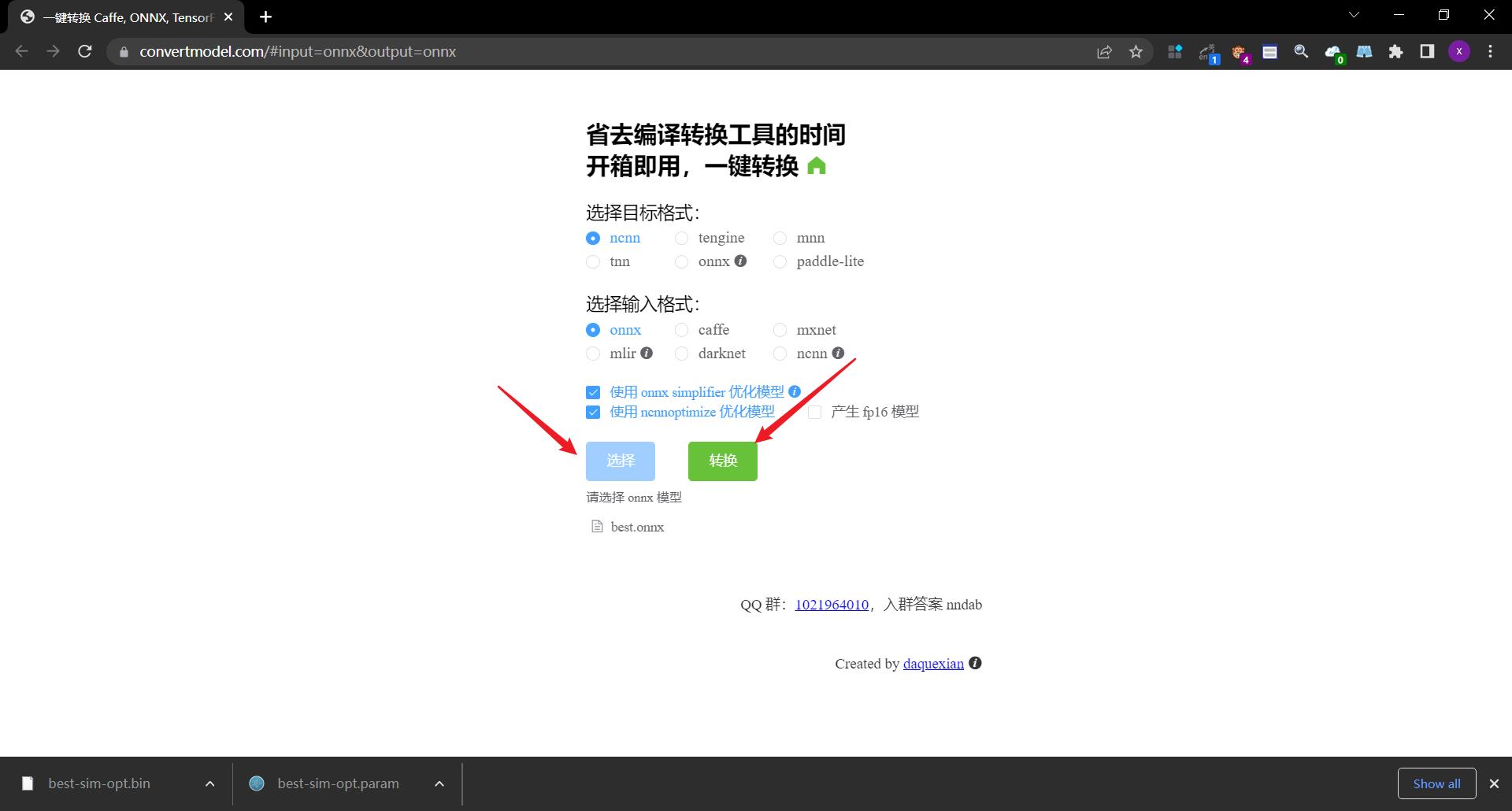

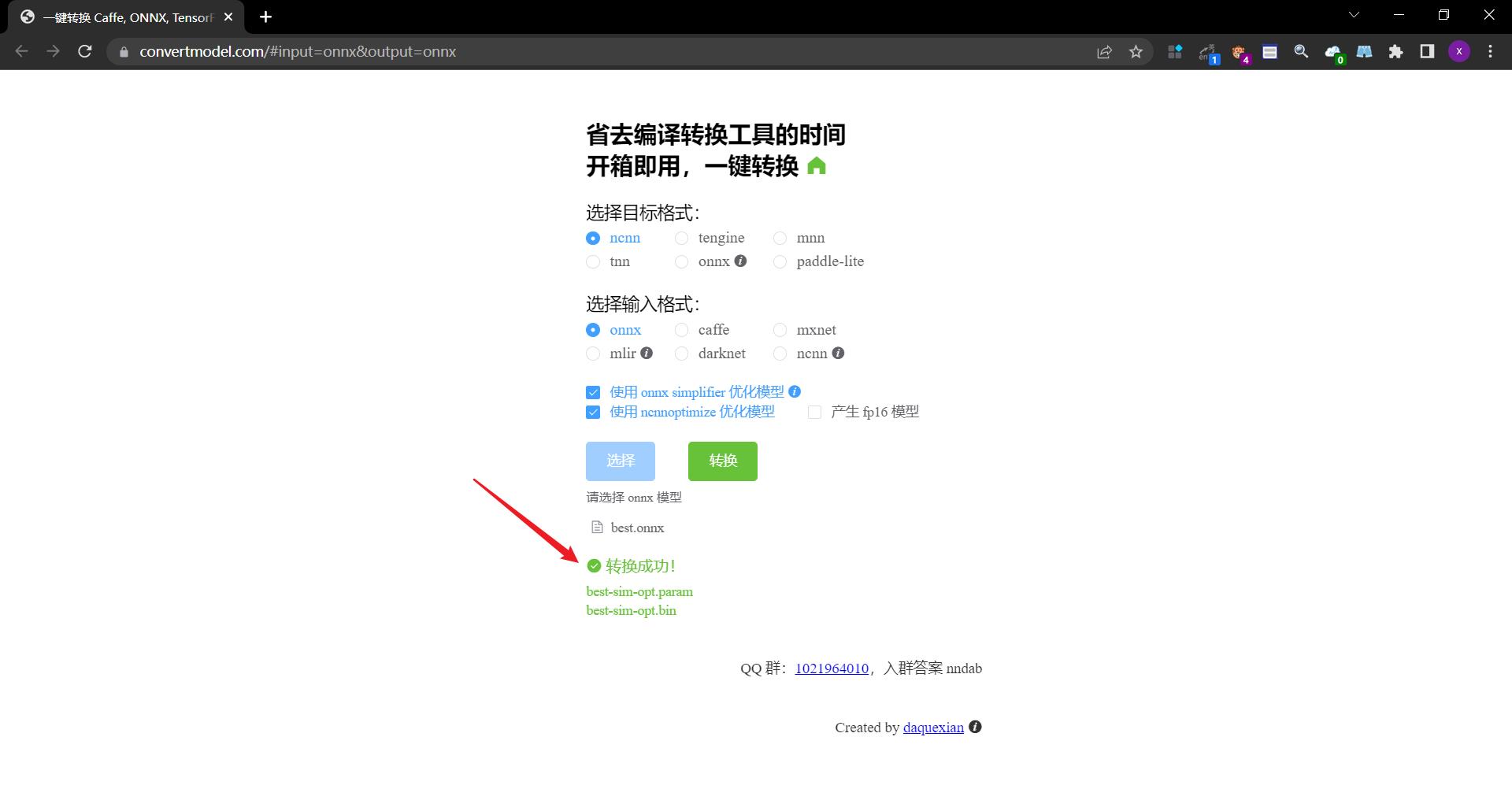

- 选择对应的参数,上传文件,点击转换

- 转换成功

- 点击下载

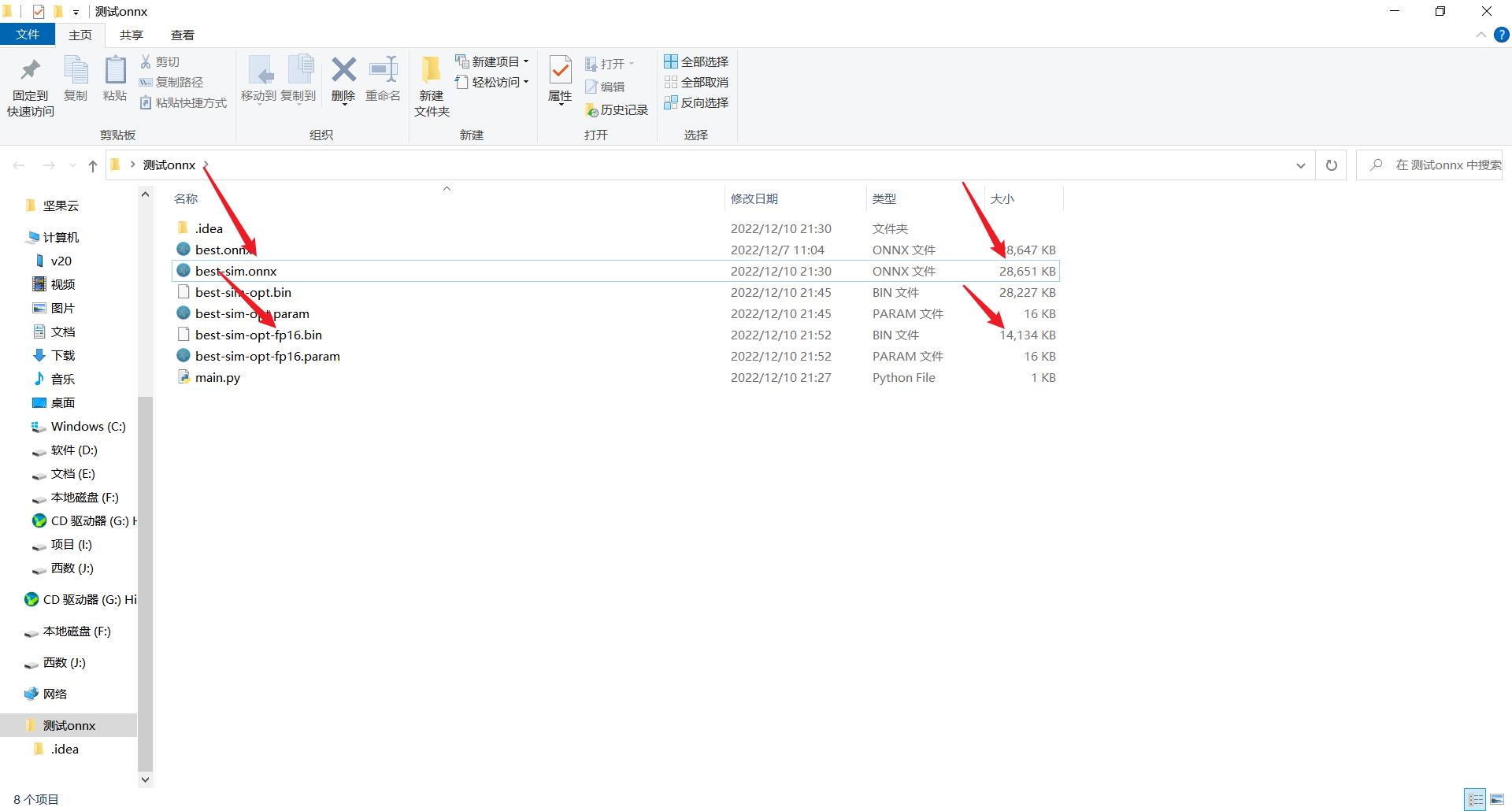

- 此外还可以选择转换为fp16模型,这样最终产生的模型大小只有原来的二分之一

- 选择对应的参数,上传文件,点击转换

- 效果对比

- 差异还挺明显的呀

- 使用

2.5.2. 修改项目源码

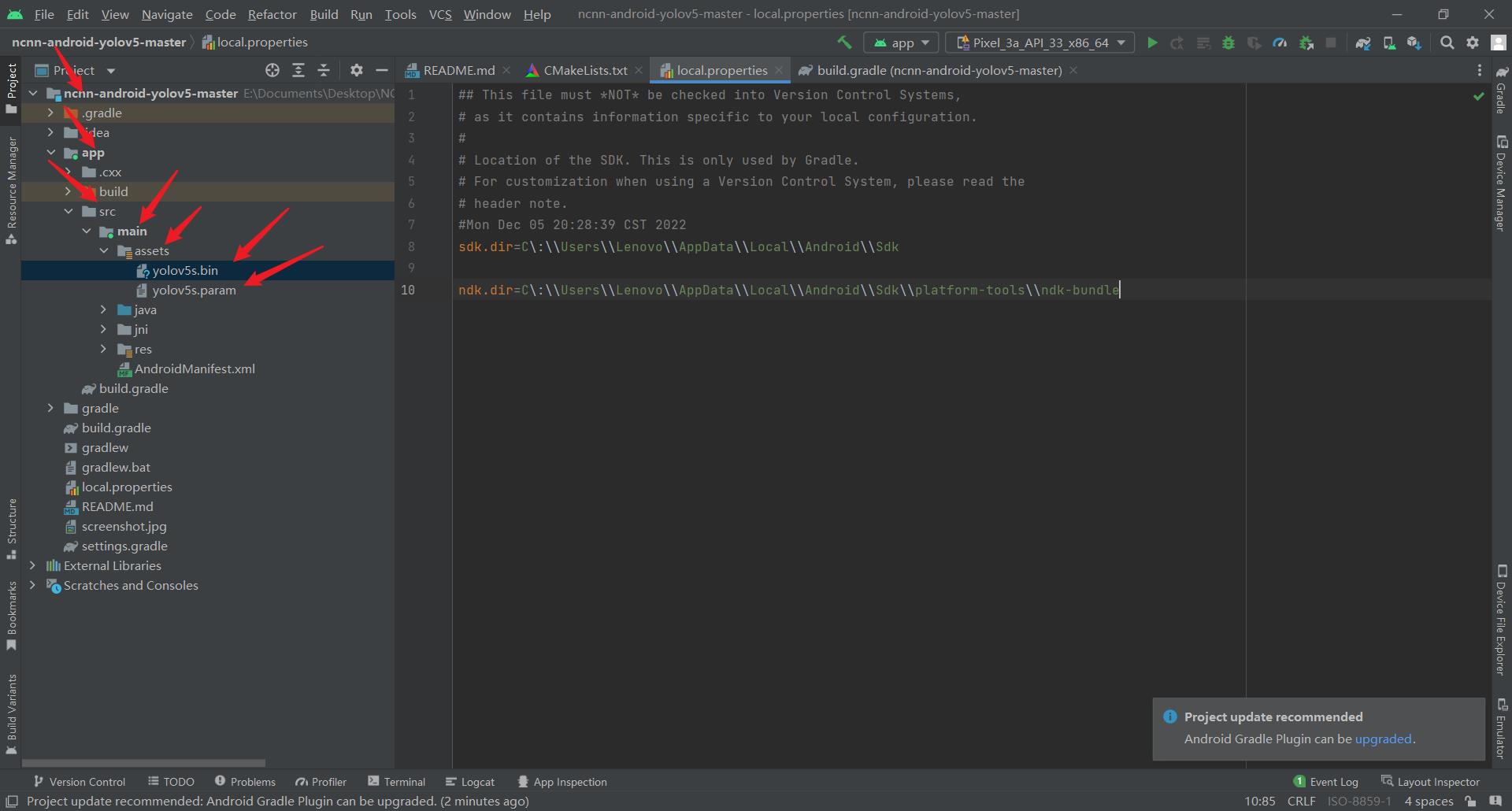

2.5.2.1. 替换原来的param文件

- 将刚才生成的yolov5s.bin、yolov5s.param文件放到ncnn-android-yolov5-master\\app\\src\\main\\assets文件夹下,并替换原来的文件

2.5.2.2. 修改param文件中的参数

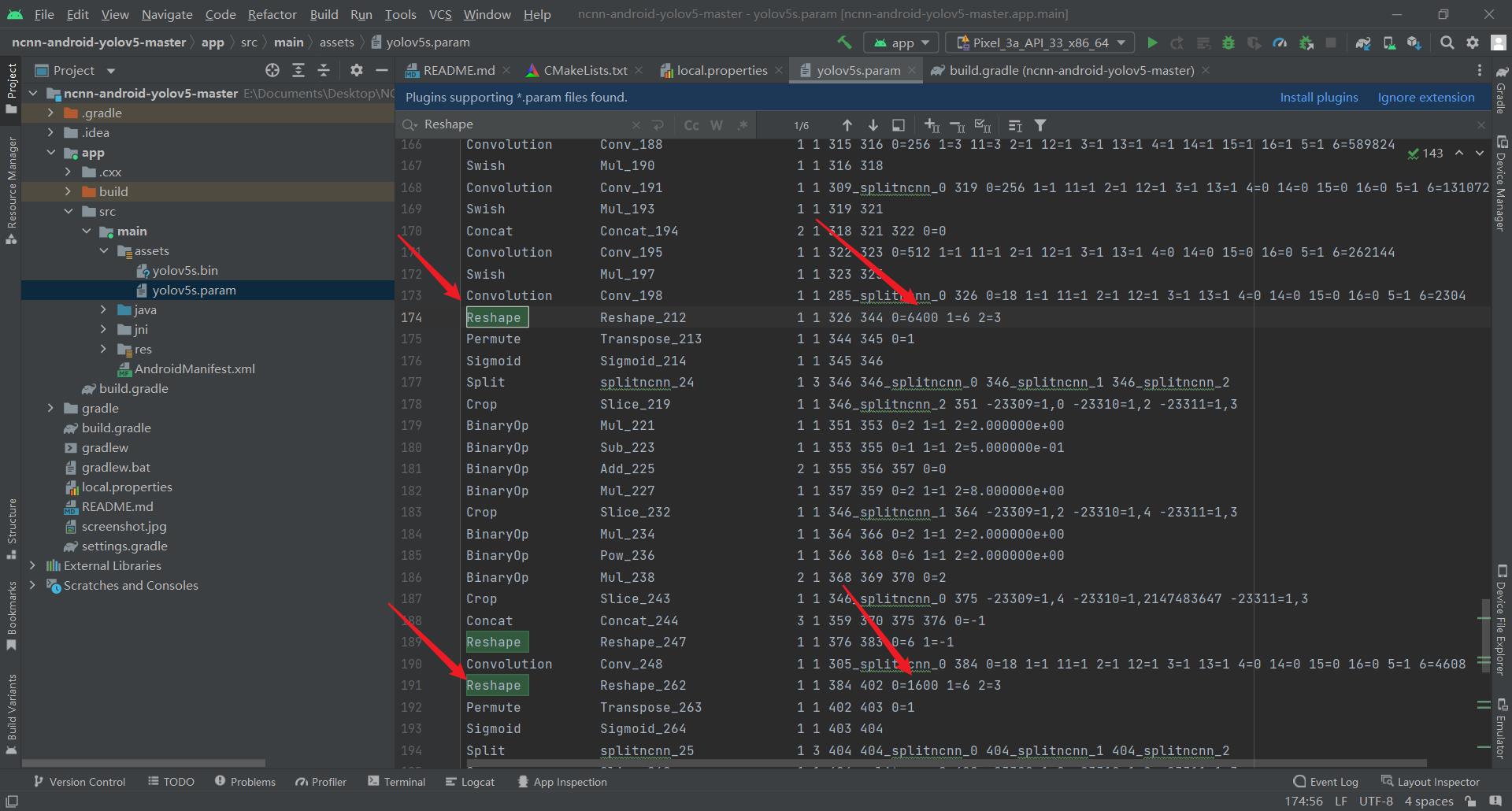

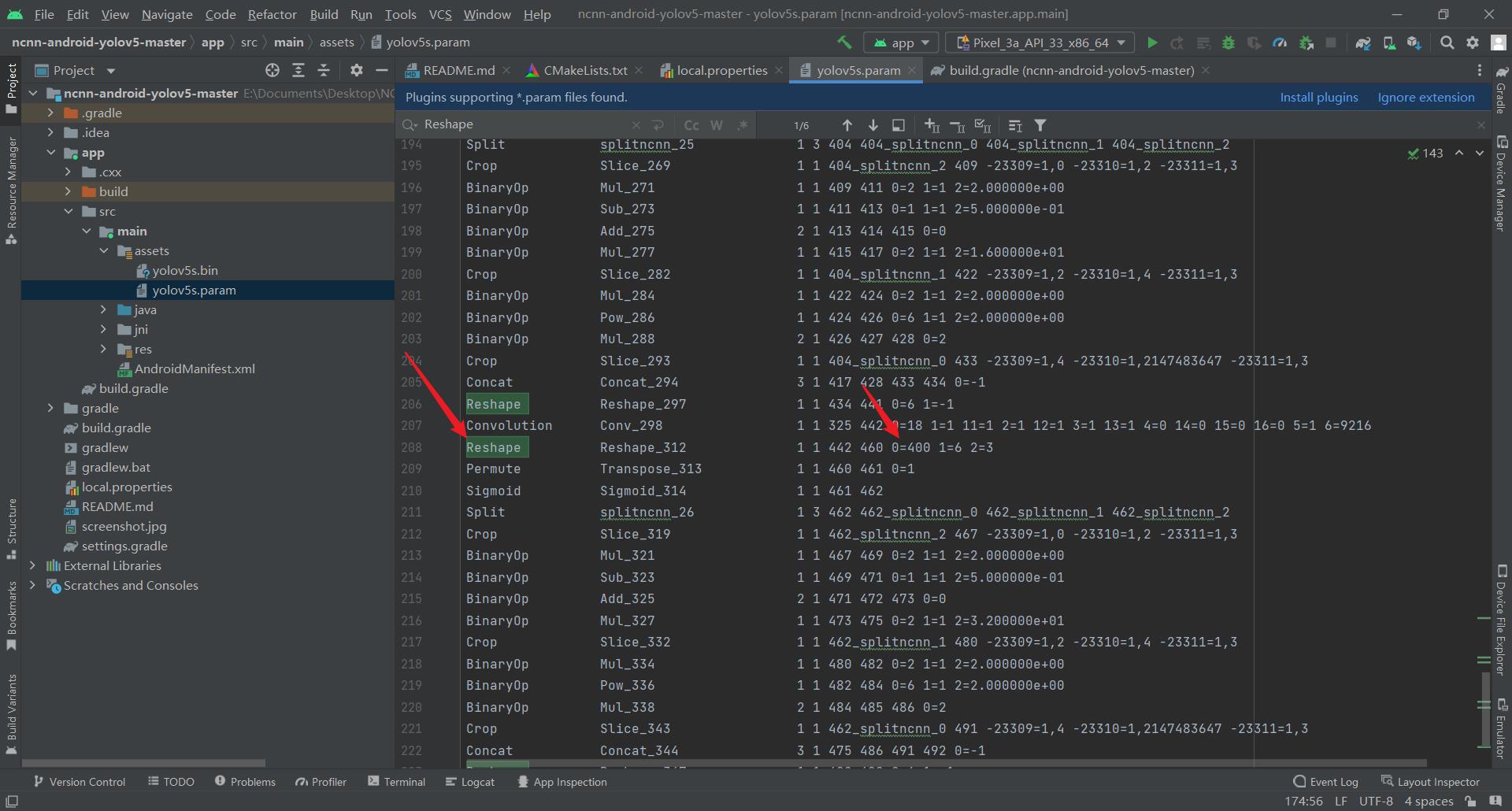

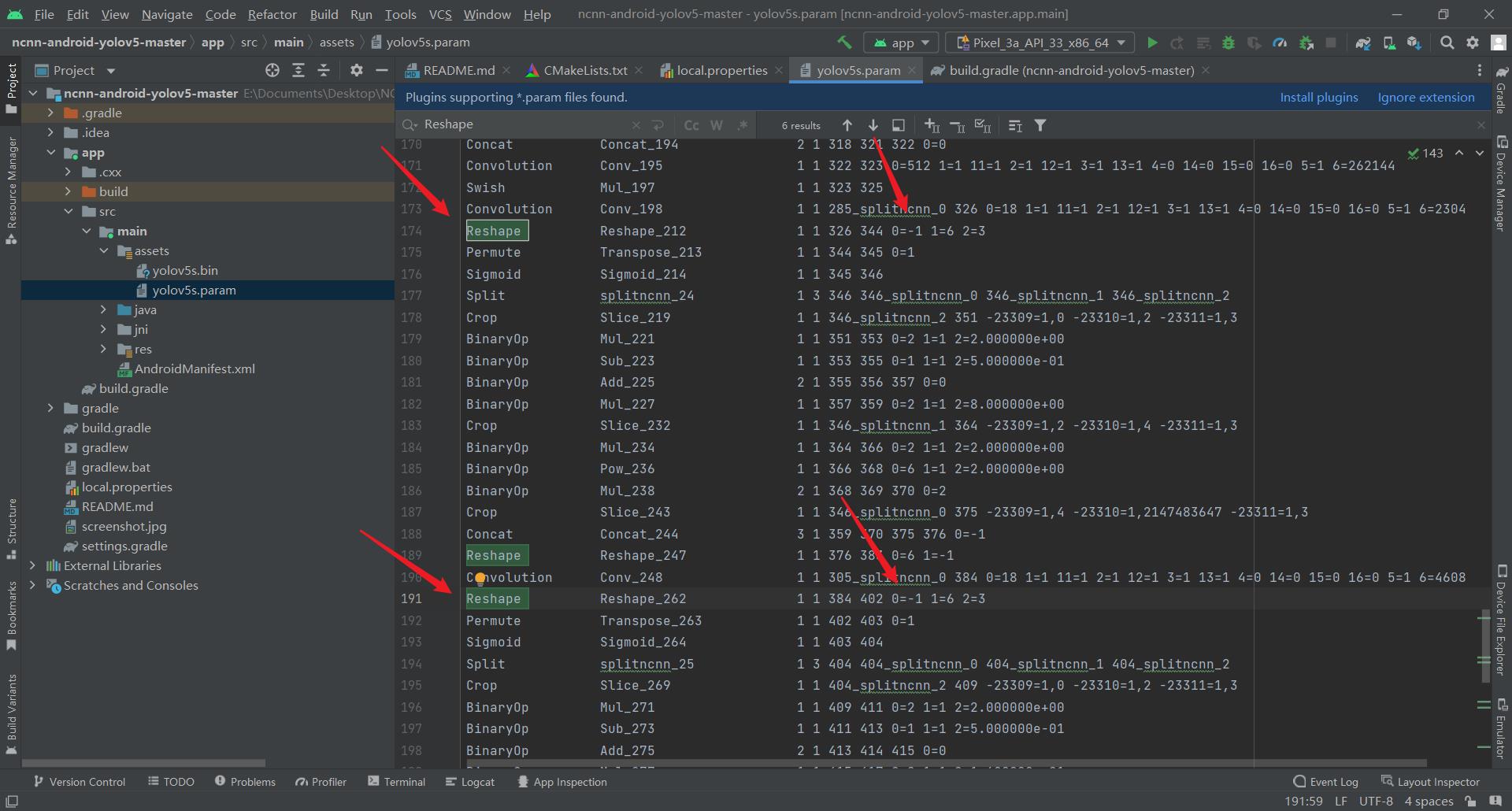

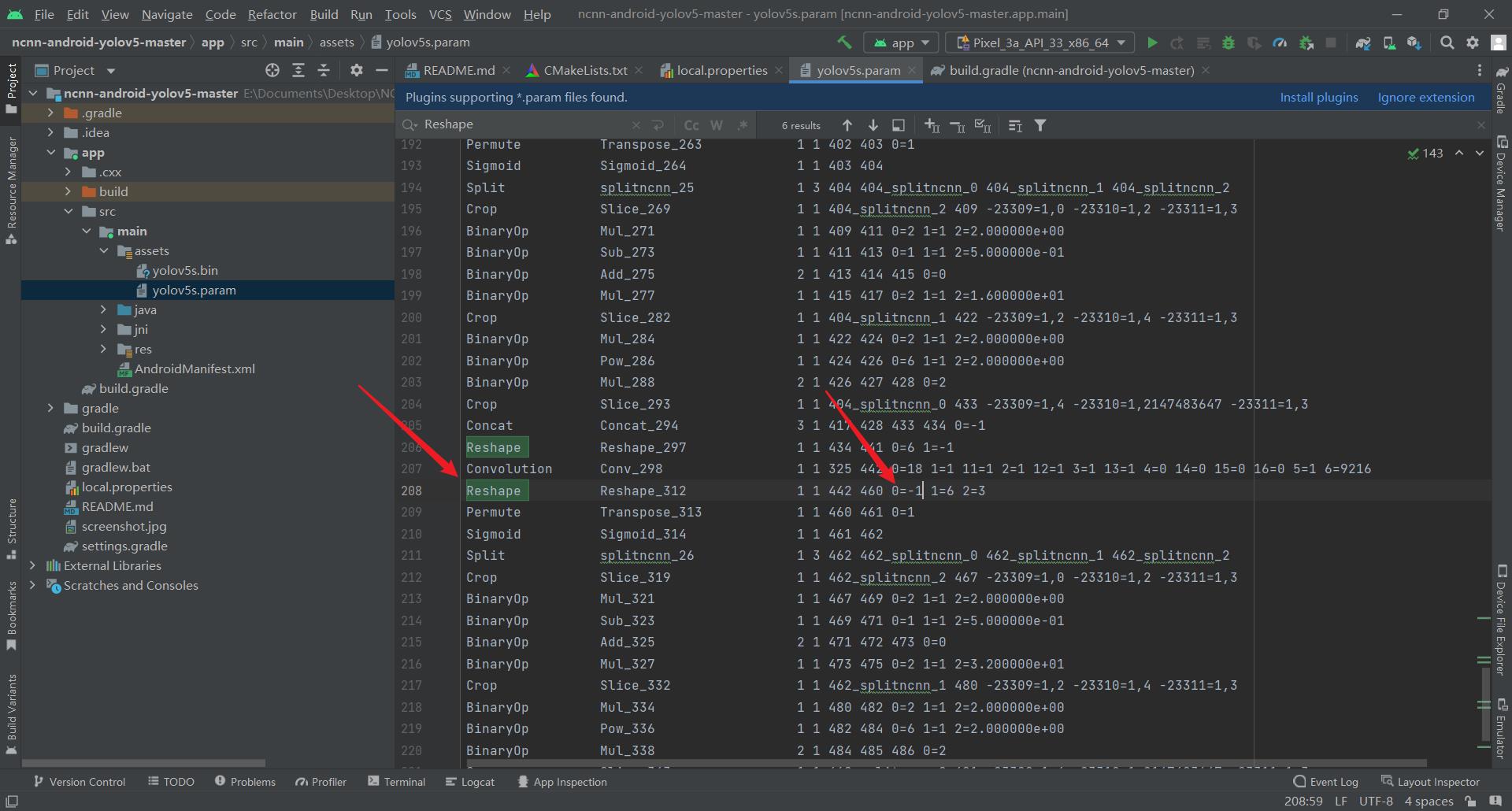

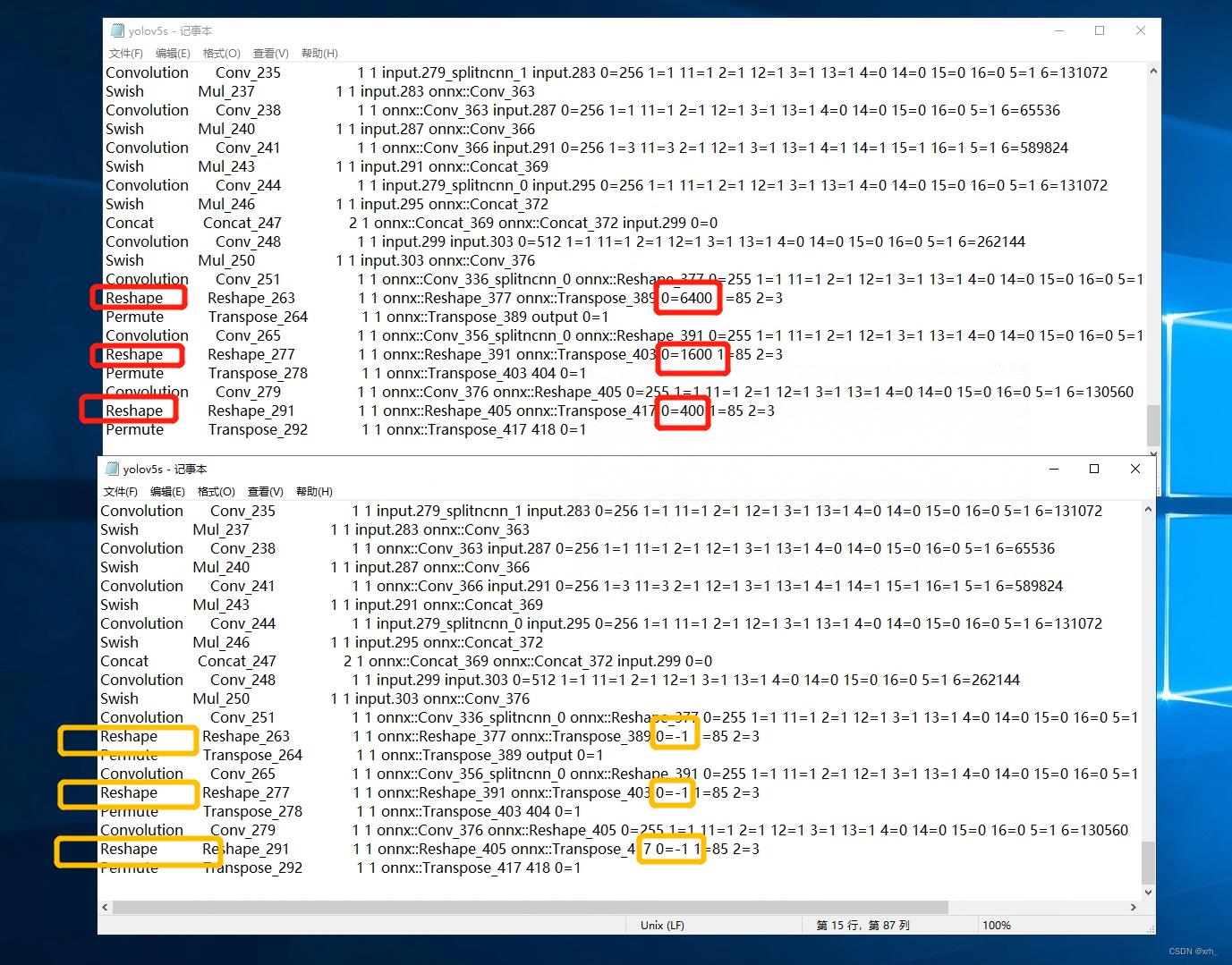

- 打开yolov5s.param,搜索Reshape层,将后面对应的 0=6400、0=1600、0=400 均修改为 0=-1 ,这是为了解决实际中出现的多检测框的问题

- 修改前

- 修改后

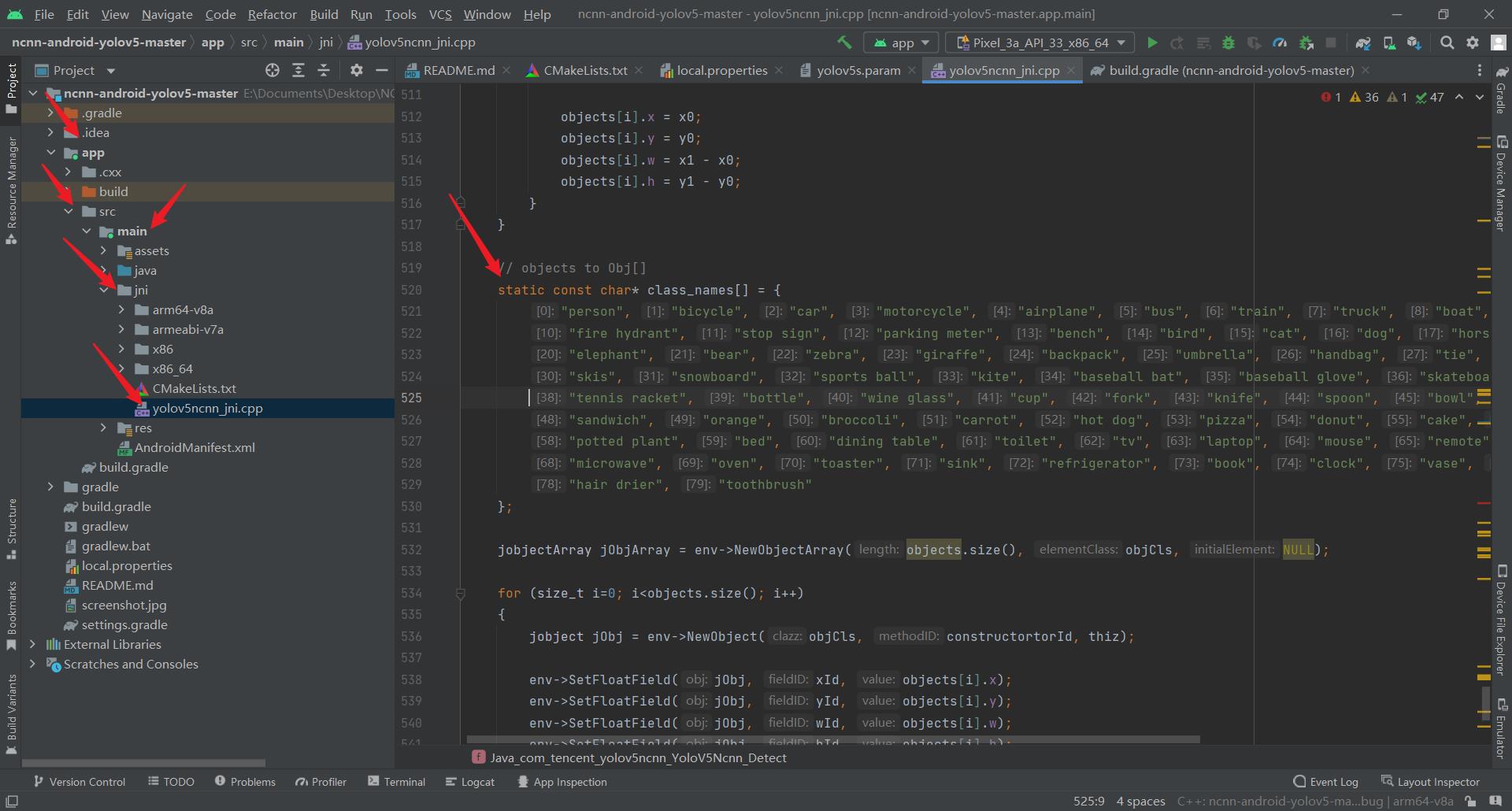

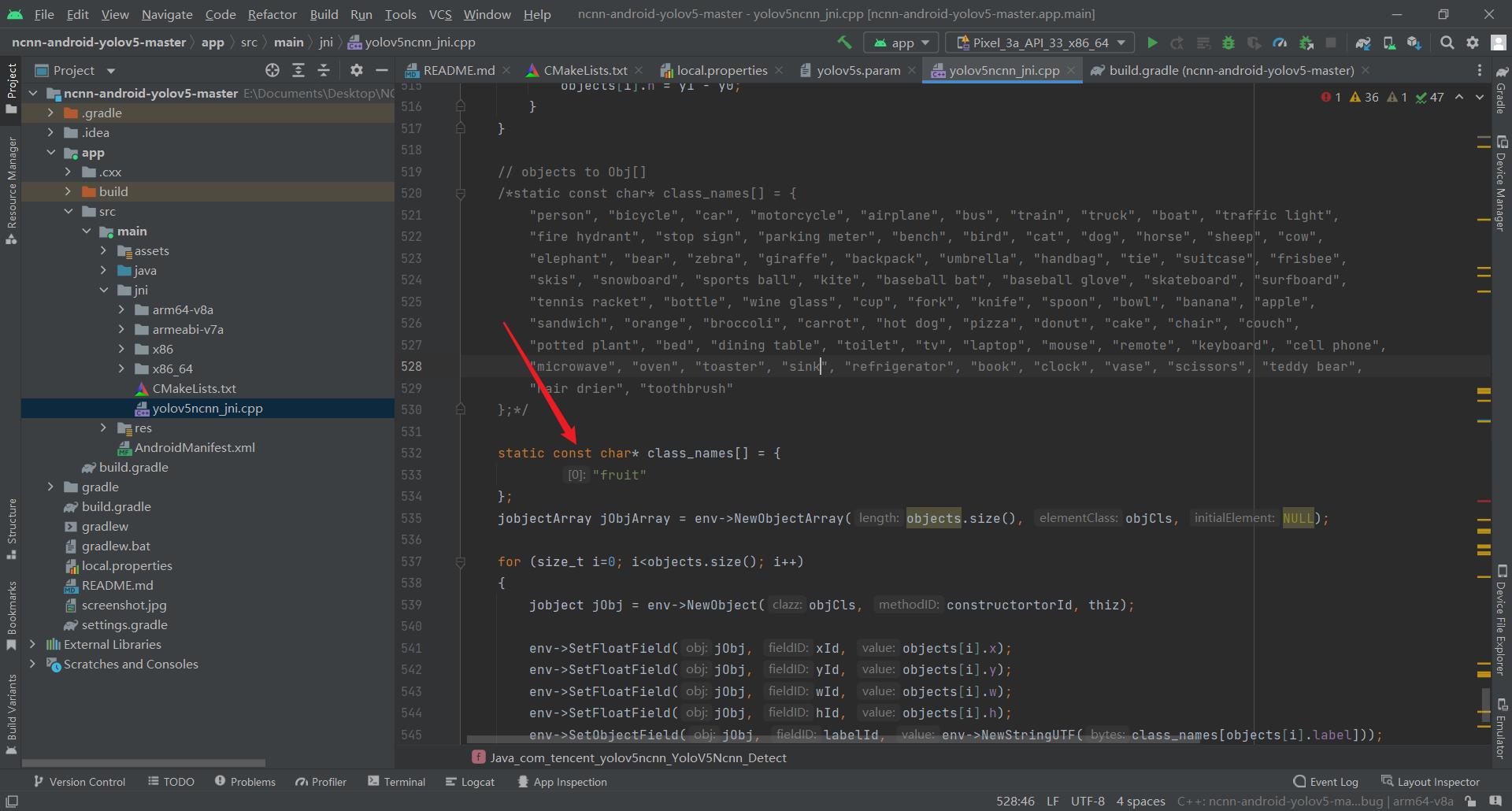

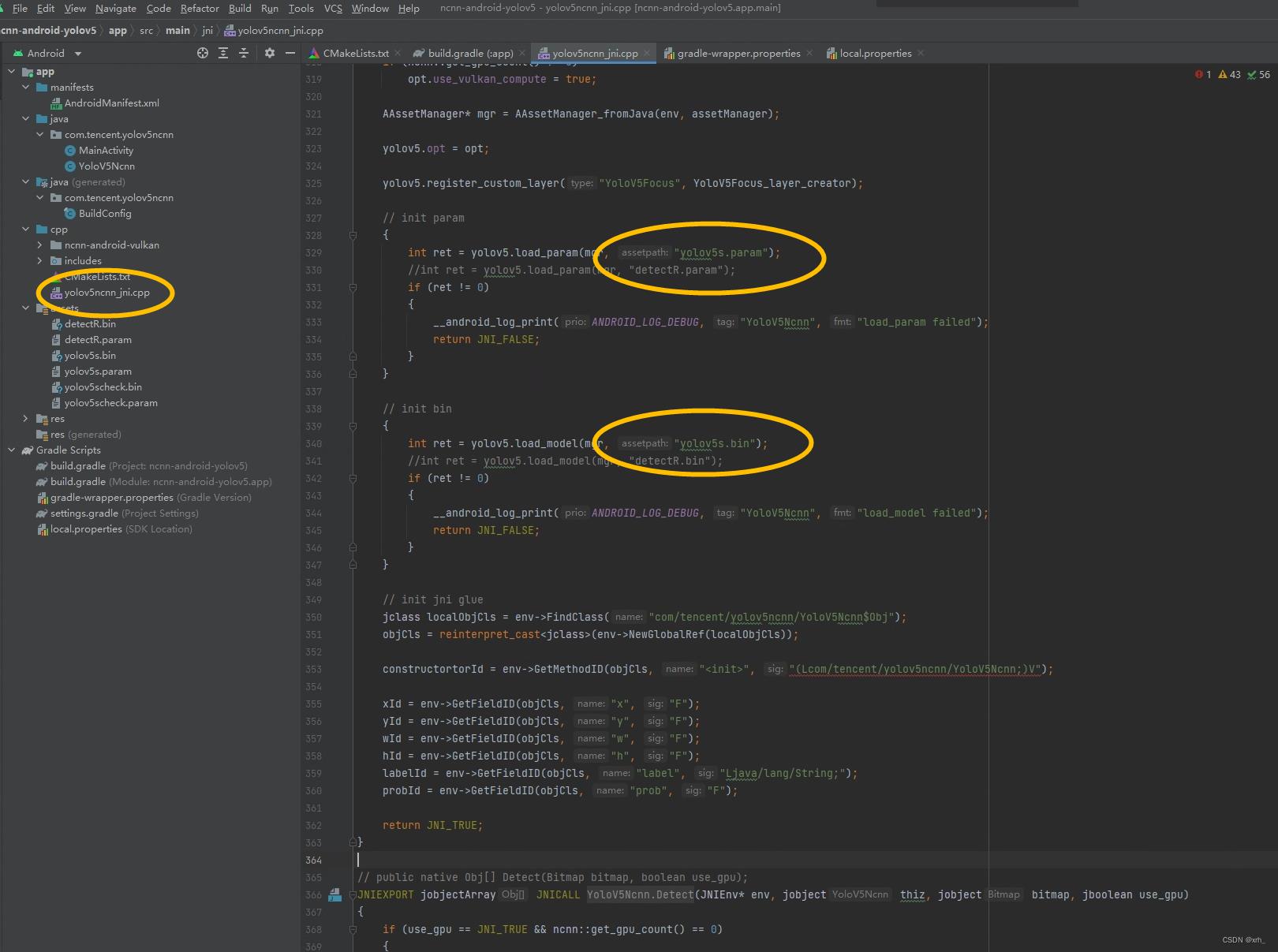

2.5.2.3. 修改yolov5ncnn_jni.cpp文件

2.5.2.3.1. 将ncnn-android-yolov5-master\\app\\src\\main\\jni文件夹下的yolov5ncnn_jni.cpp的分类类别名改成自己模型的实际类别名

- 修改前

- 修改后

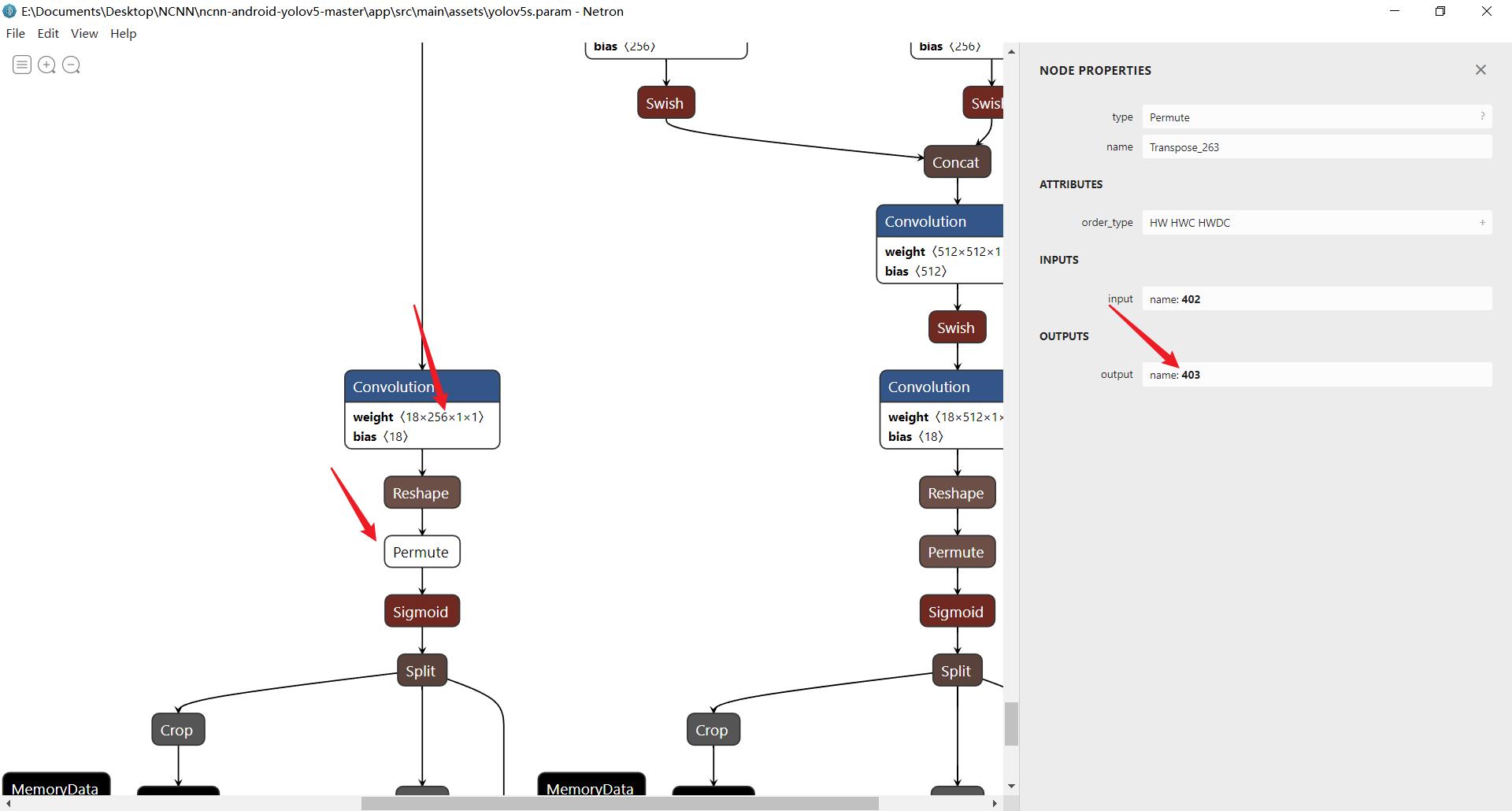

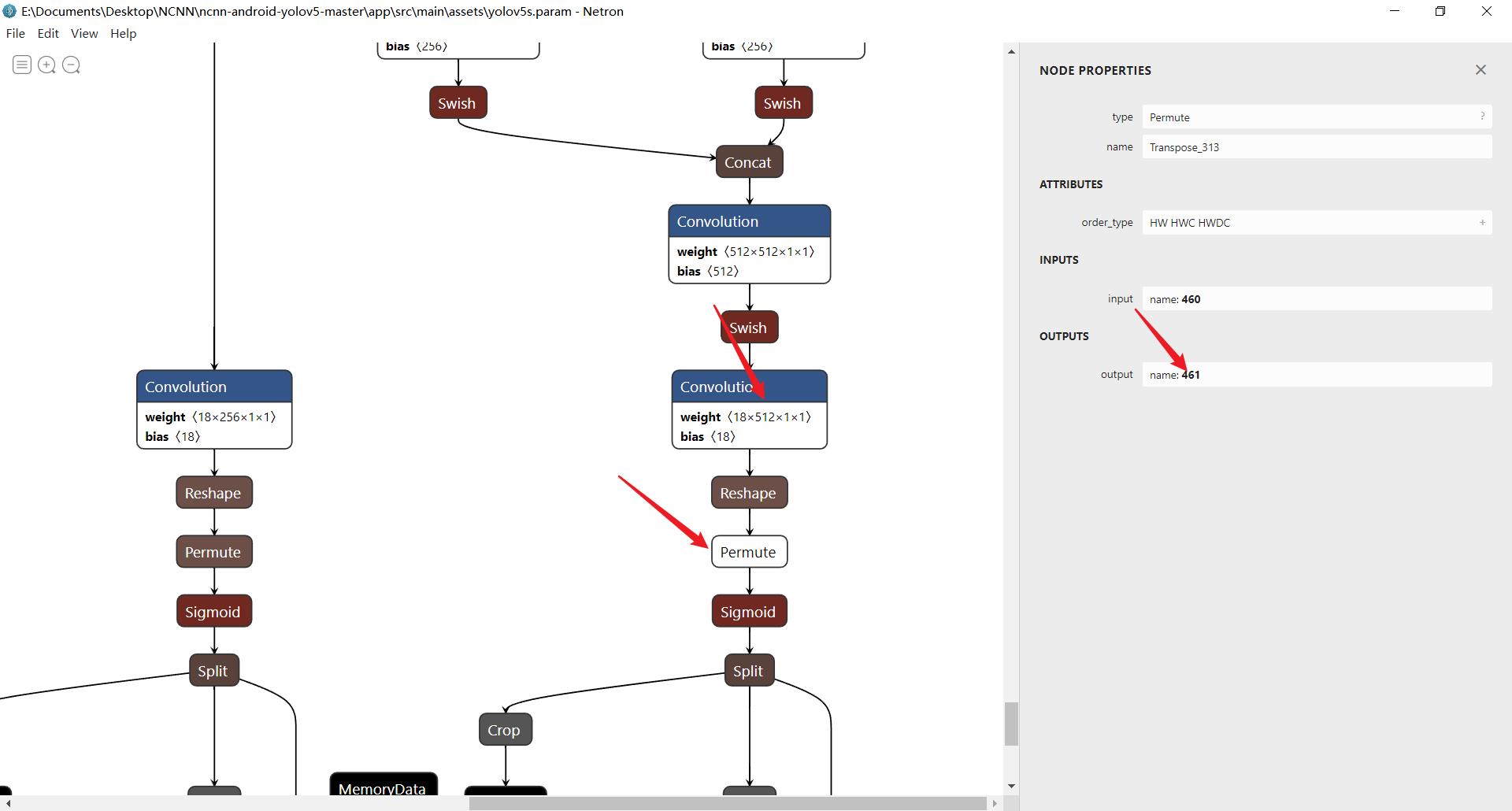

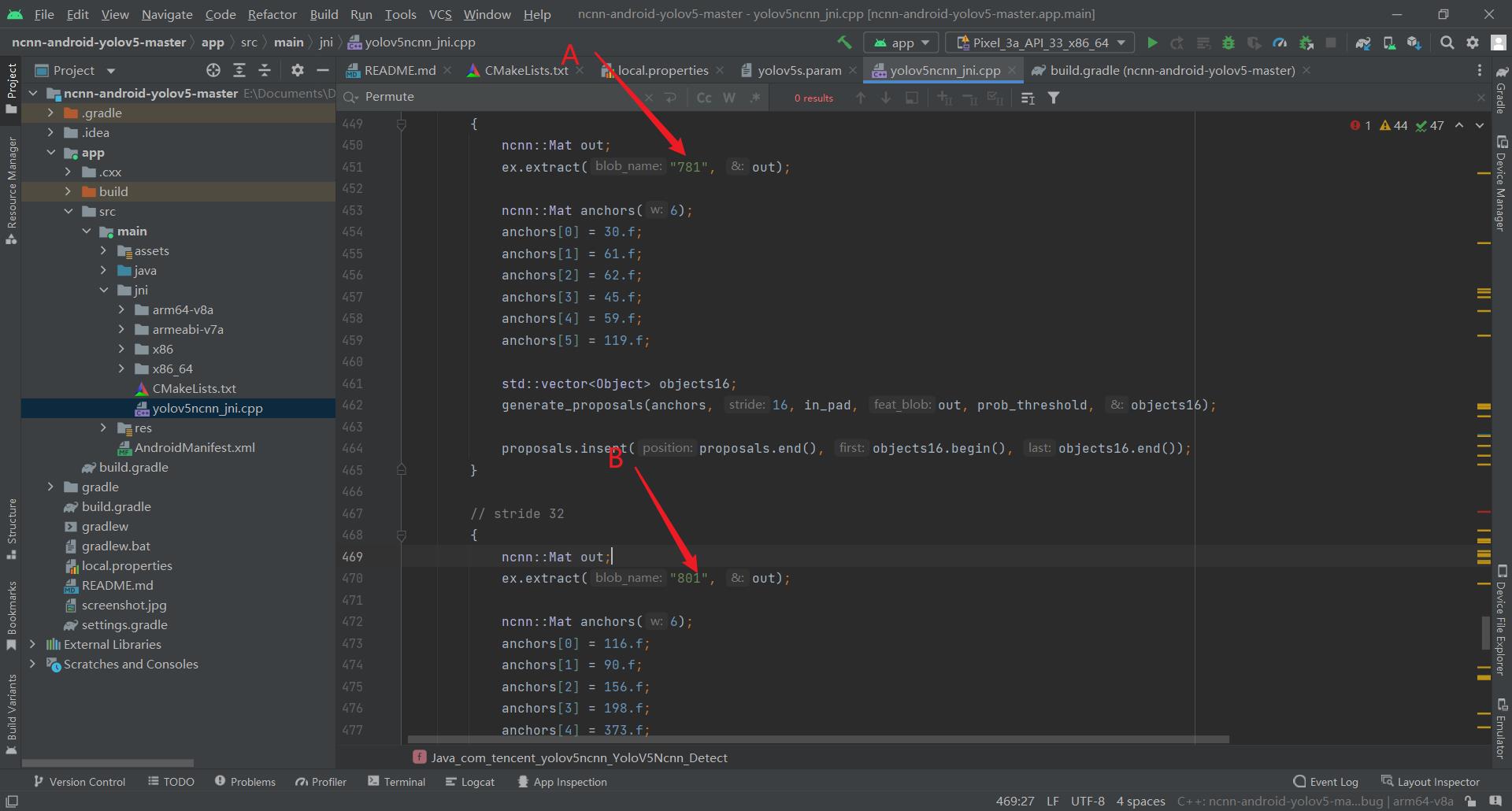

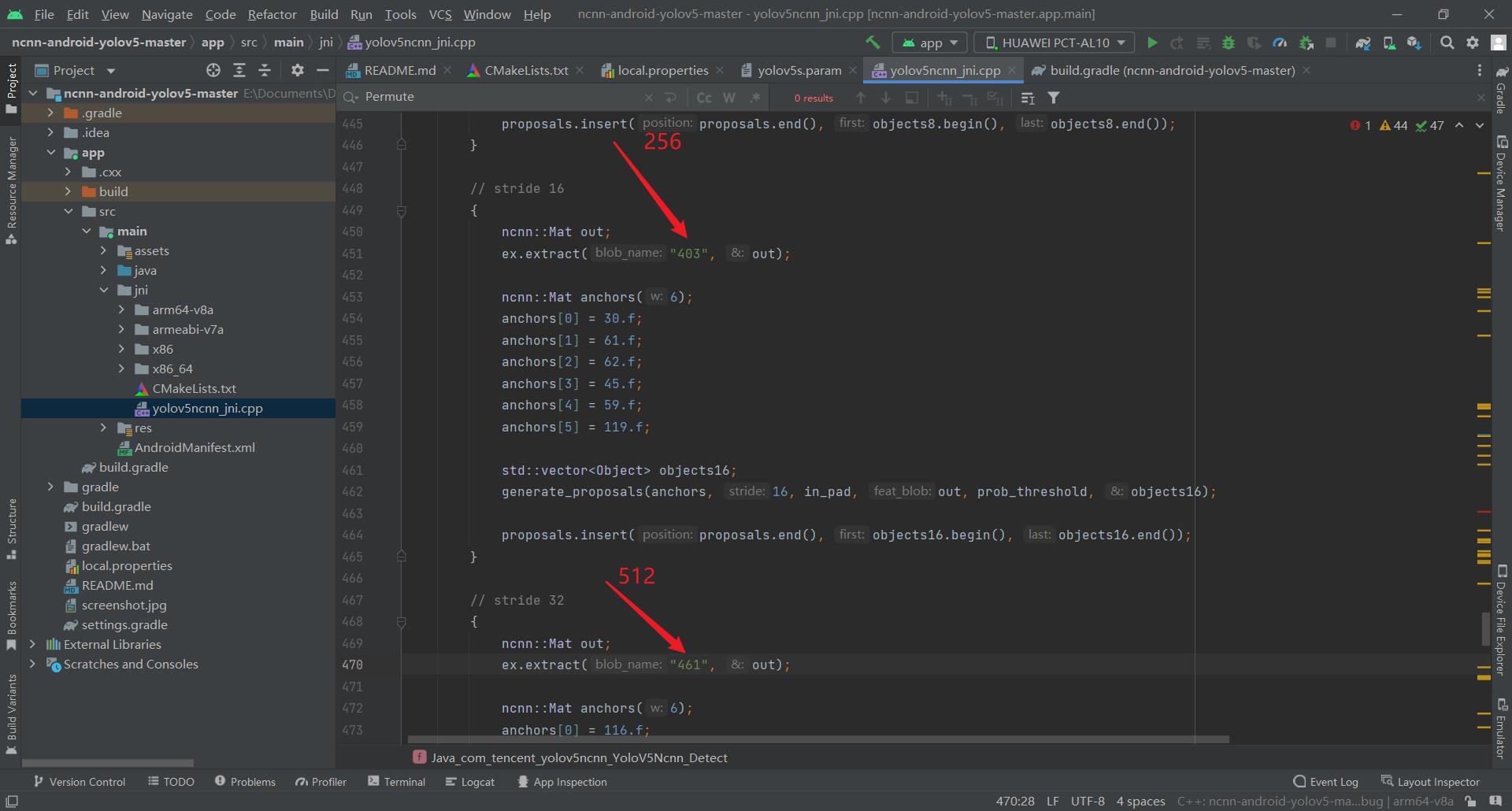

2.5.2.3.2. 修改stride 16和32部分

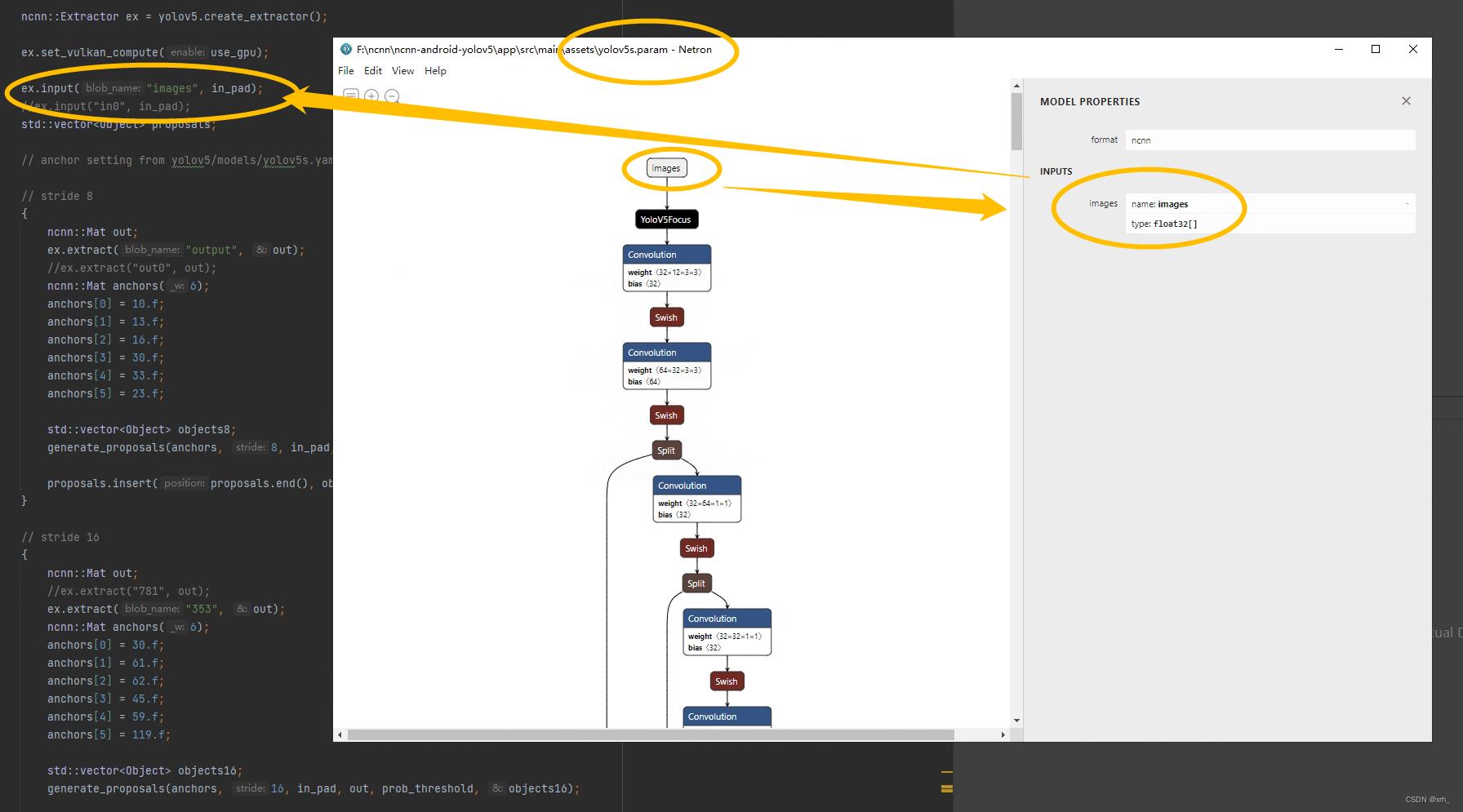

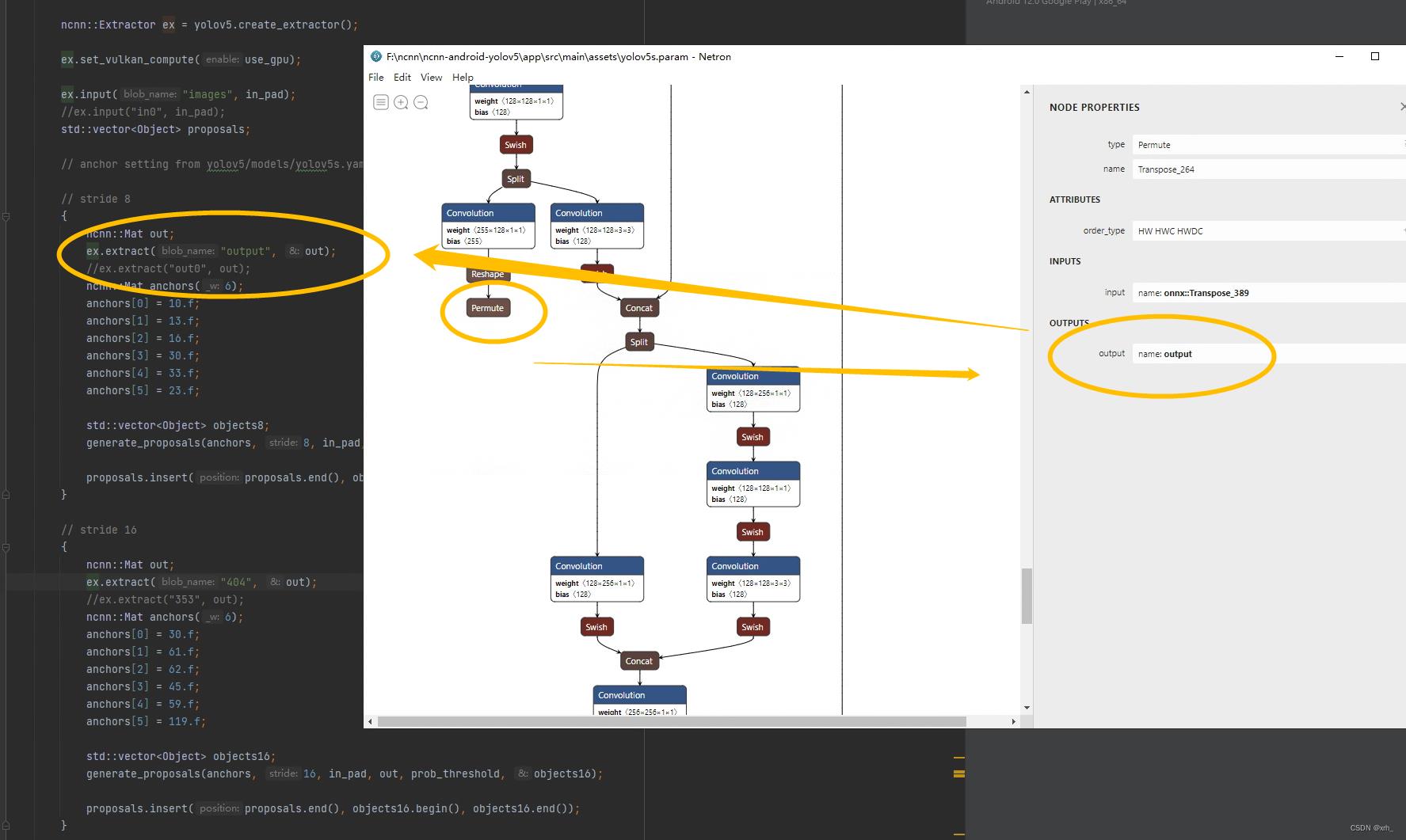

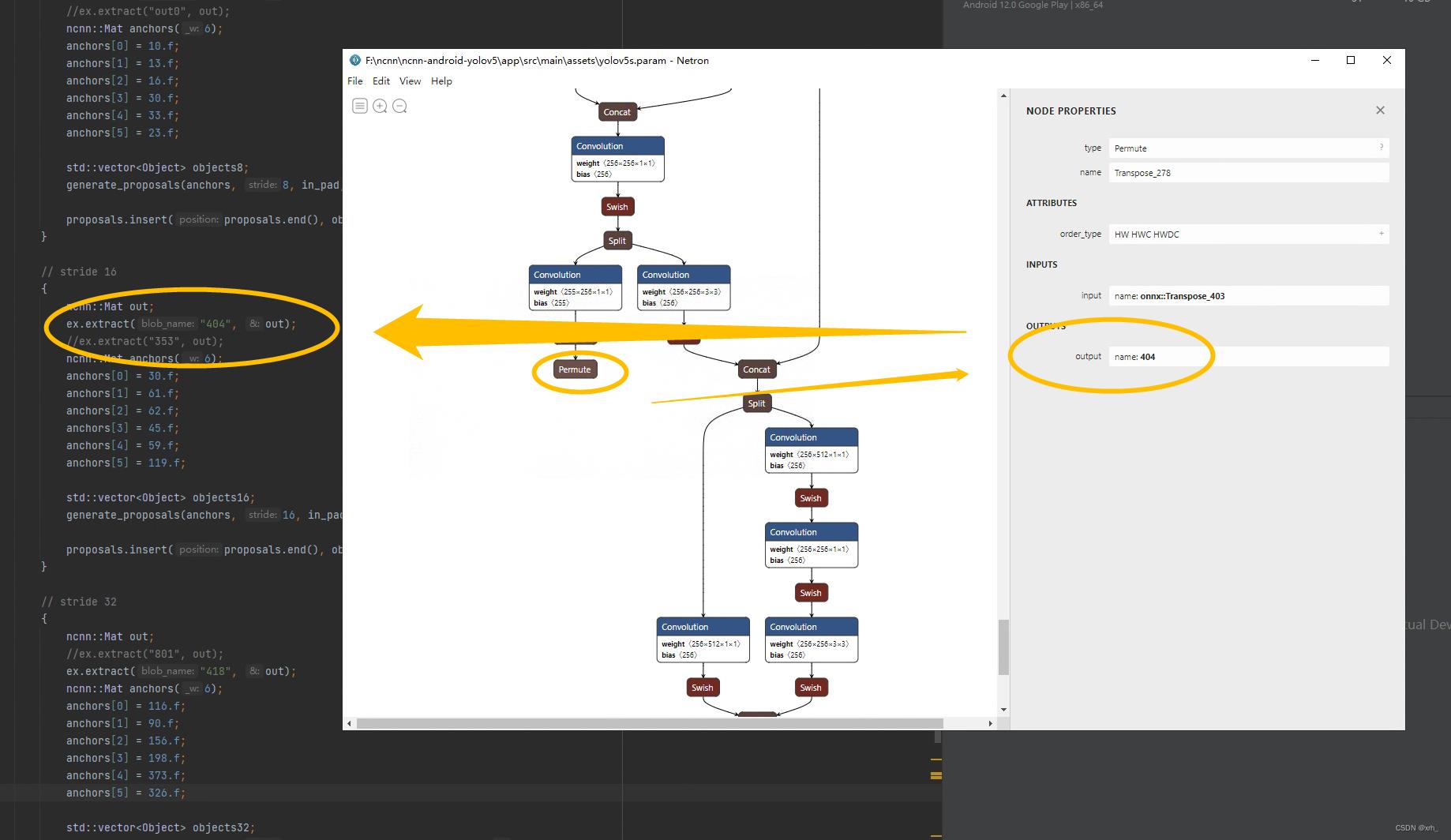

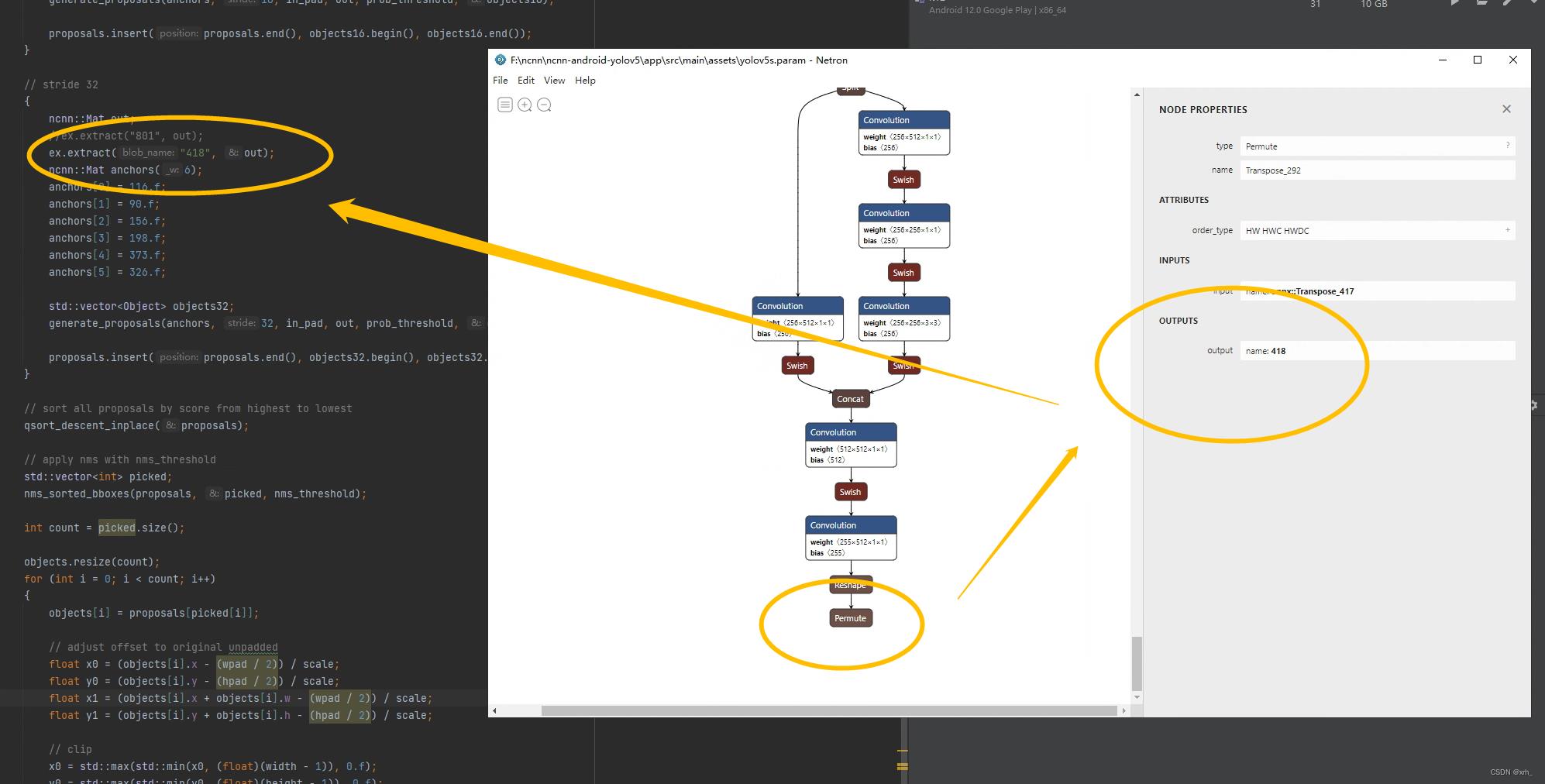

- 修改源码文件yolov5ncnn_jni.cpp中Permute 节点的 output

- 将param文件中permute部分与stride部分中blob_name后面的数字对应起来

- param文件中搜索permute会出来3个结果,我们选择

- 我们使用Notre打开这个yolov5s.param文件,找到permute节点,这个permute节点一共有3个,分别是128,256,512尺寸的,我们需要的是256和512的输出维度

- 修改前

- 修改后

-

2.6. 测试

-

连上手机,点击run按钮,编译安装调试

-

可以看到了手机端安装了对应的APP

点开

- 我们选择一张图片进行,然后点识别,可以看到已经可以正常的空穴普通的目标了,而且置信度还挺高的

- 2022.12.10-23:44:02

- 终于把自己训练好的YOLOV5模型移植到手机端了,累死我了。但愿今晚有个好梦~

3. 问题

3.1. 为什么不同人转换出来的模型大小不一样?

- 可能是在转换的过程中,有的人使用FP16吧

.pt->onnx->onnxsim->ncnn, - 在export.py的时候是否去掉了后处理

添加 --train 参数,去掉后处理

export.py --weights yolov5s.pt --include torchscript --train

3.2. NCNN可以运行的权重是fp32还是fp16的?

- fp32和fp16都可以运行

4. 报错

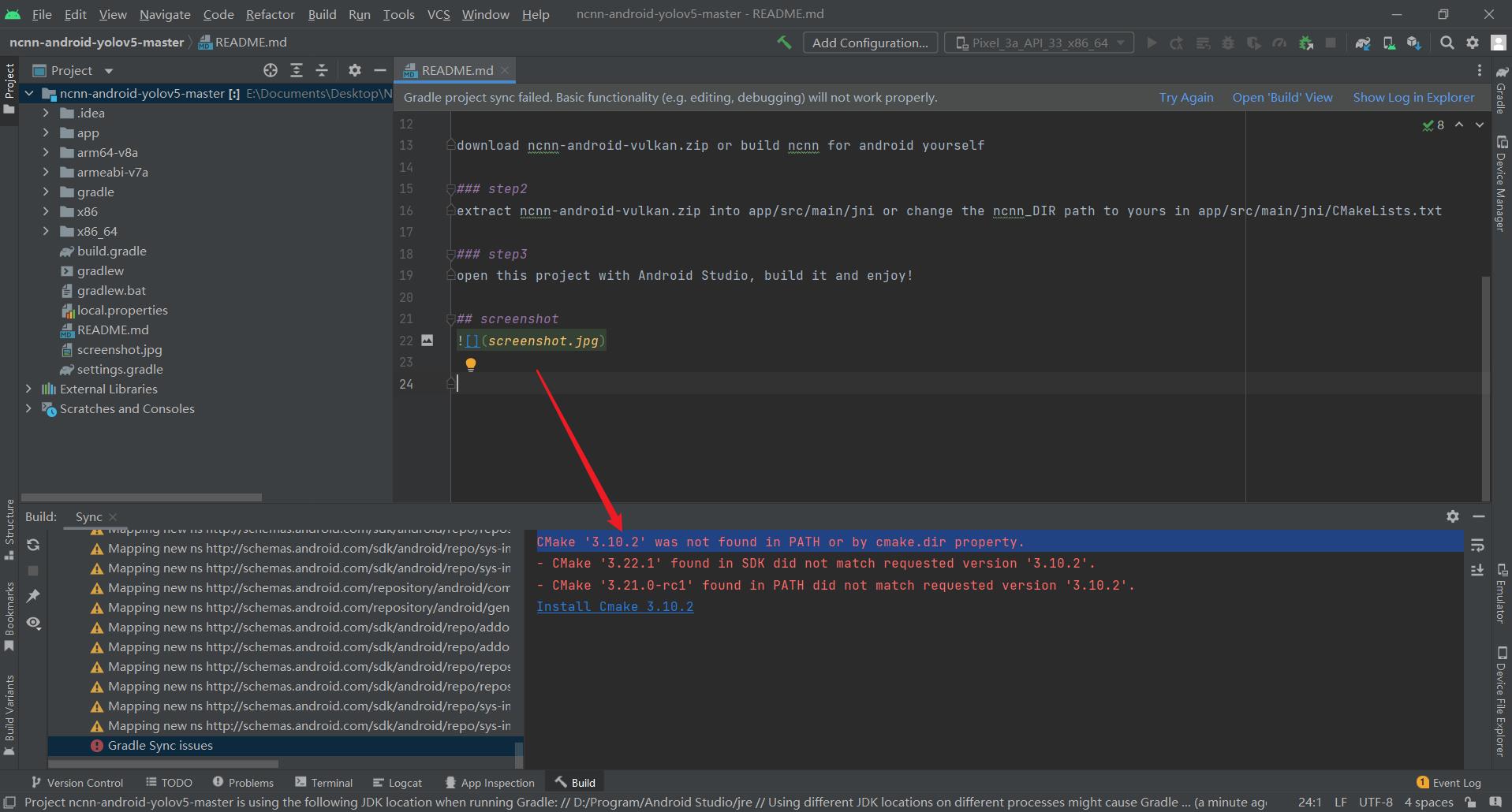

4.1. Android Studio报错

-

CMake ‘3.10.2’ was not found in PATH or by cmake.dir property.

点击下方的install即可

-

By not providing “Findncnn.cmake” in CMAKE_MODULE_PATH this project has asked CMake to find a package configuration file provided by “ncnn”, but CMake did not find one.

看一下自己ncnn-20221128-android-vulkan的代码是否放对了位置,需要放到ncnn-android-yolov5-master的\\app\\src\\main\\jni目录下 -

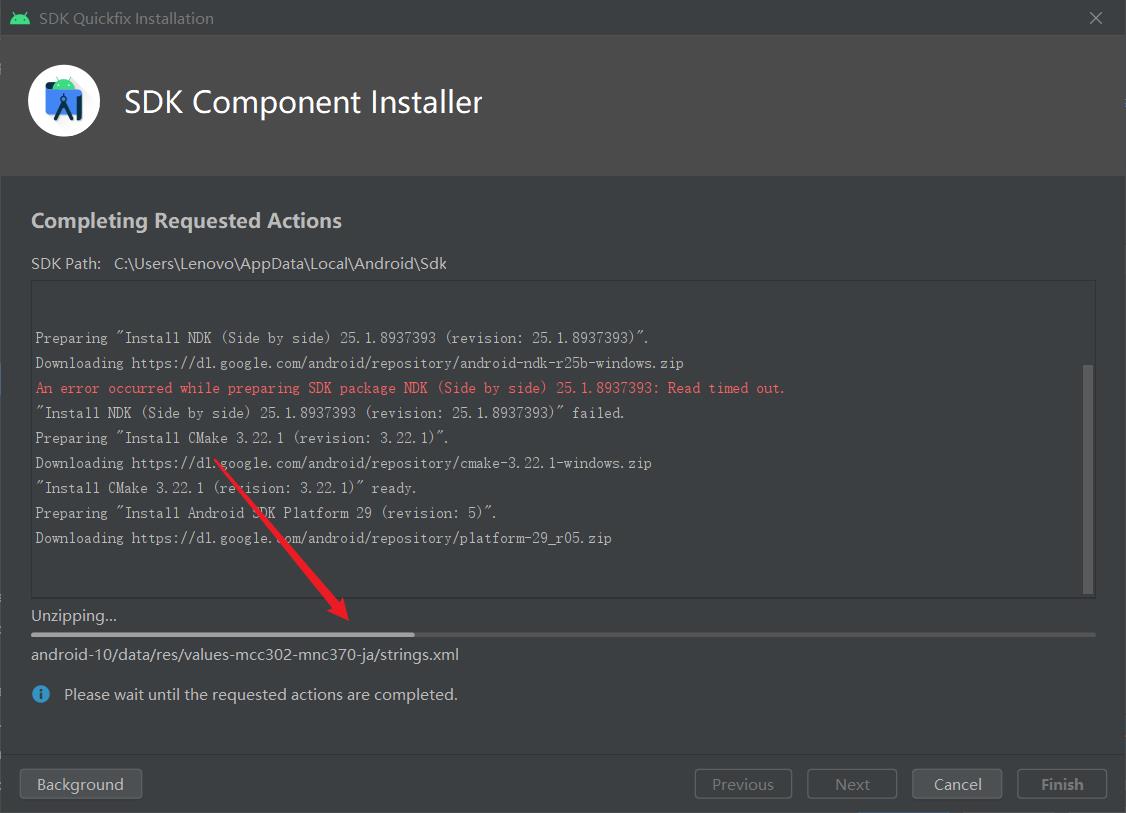

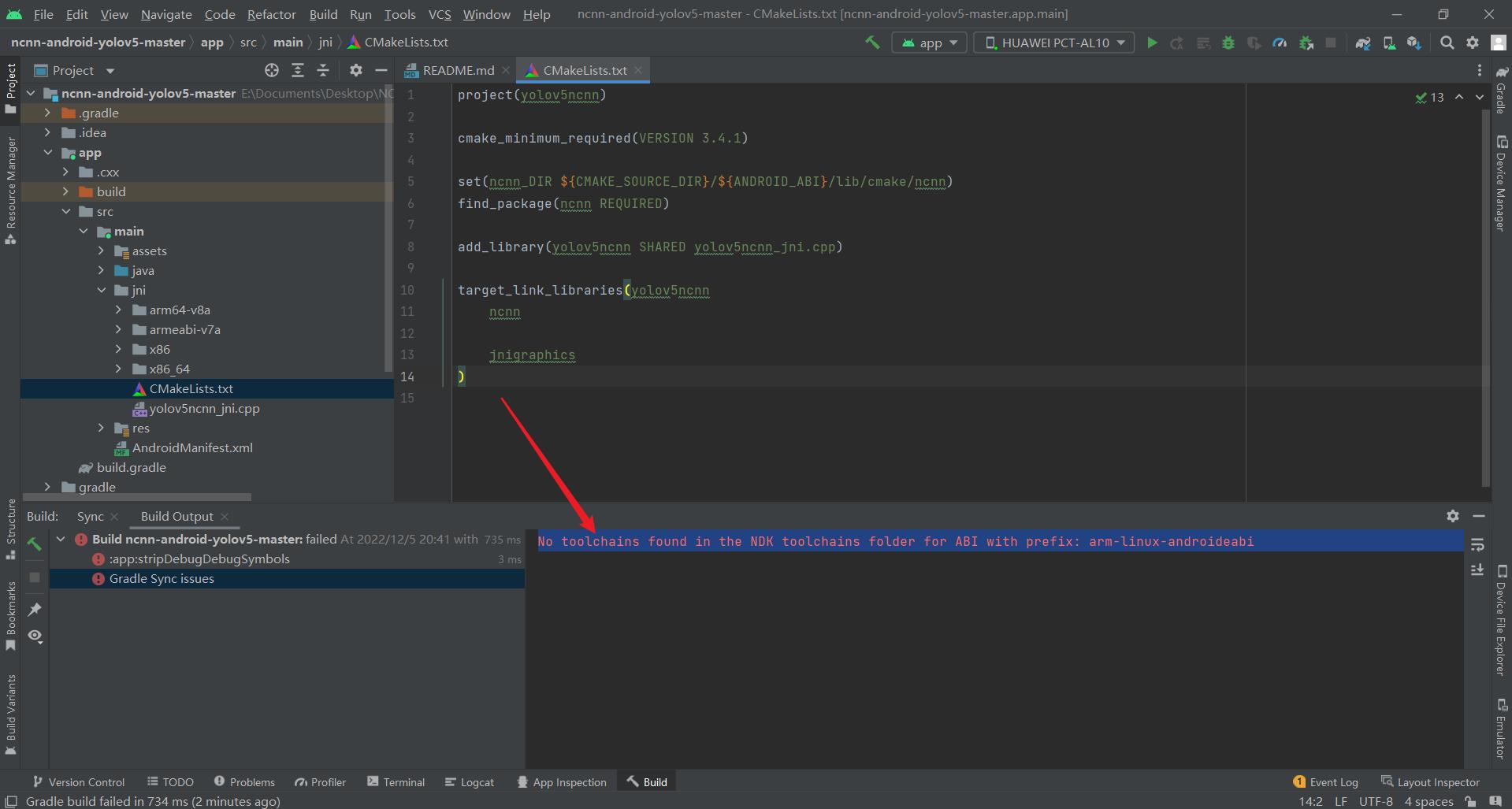

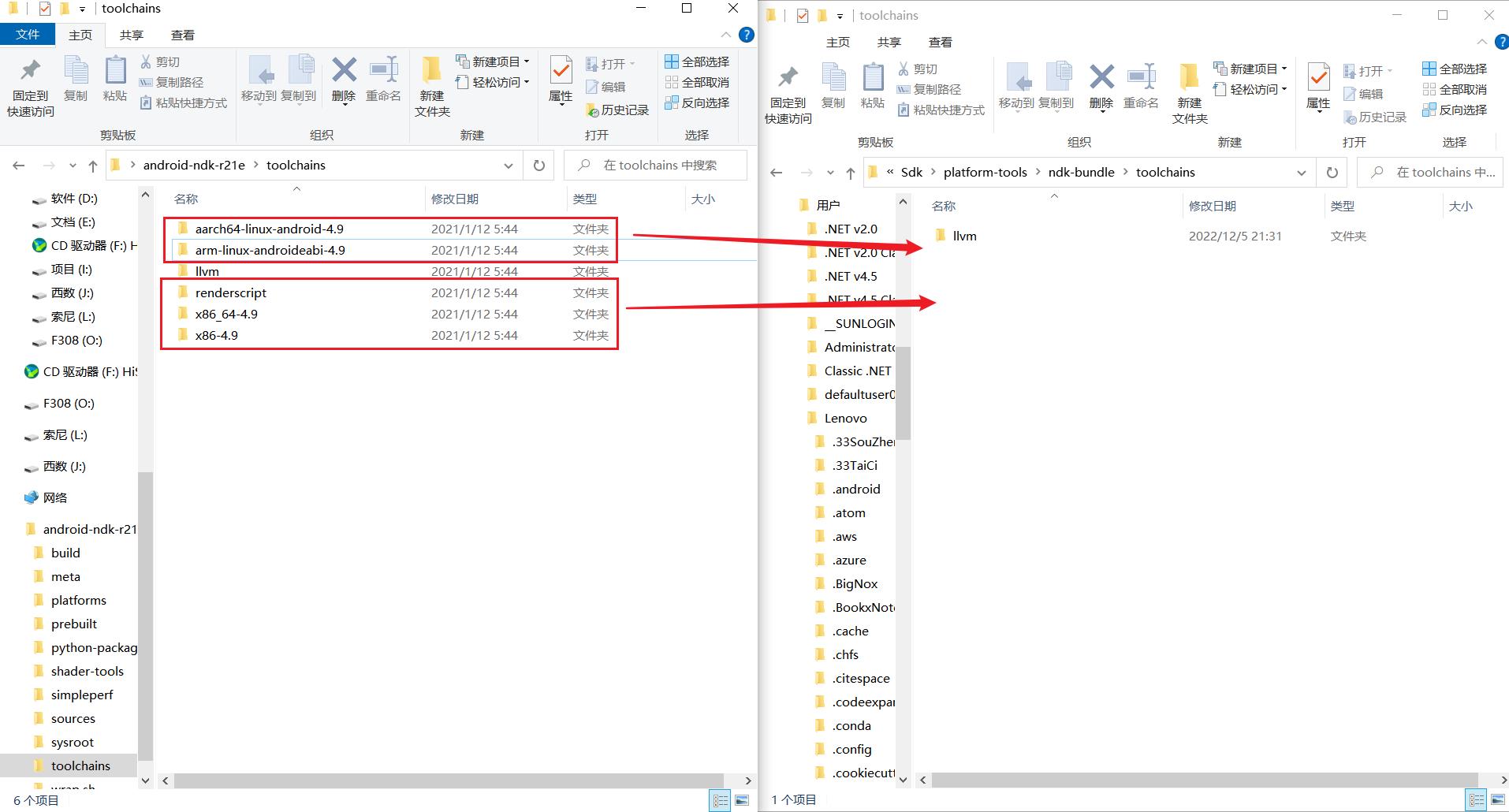

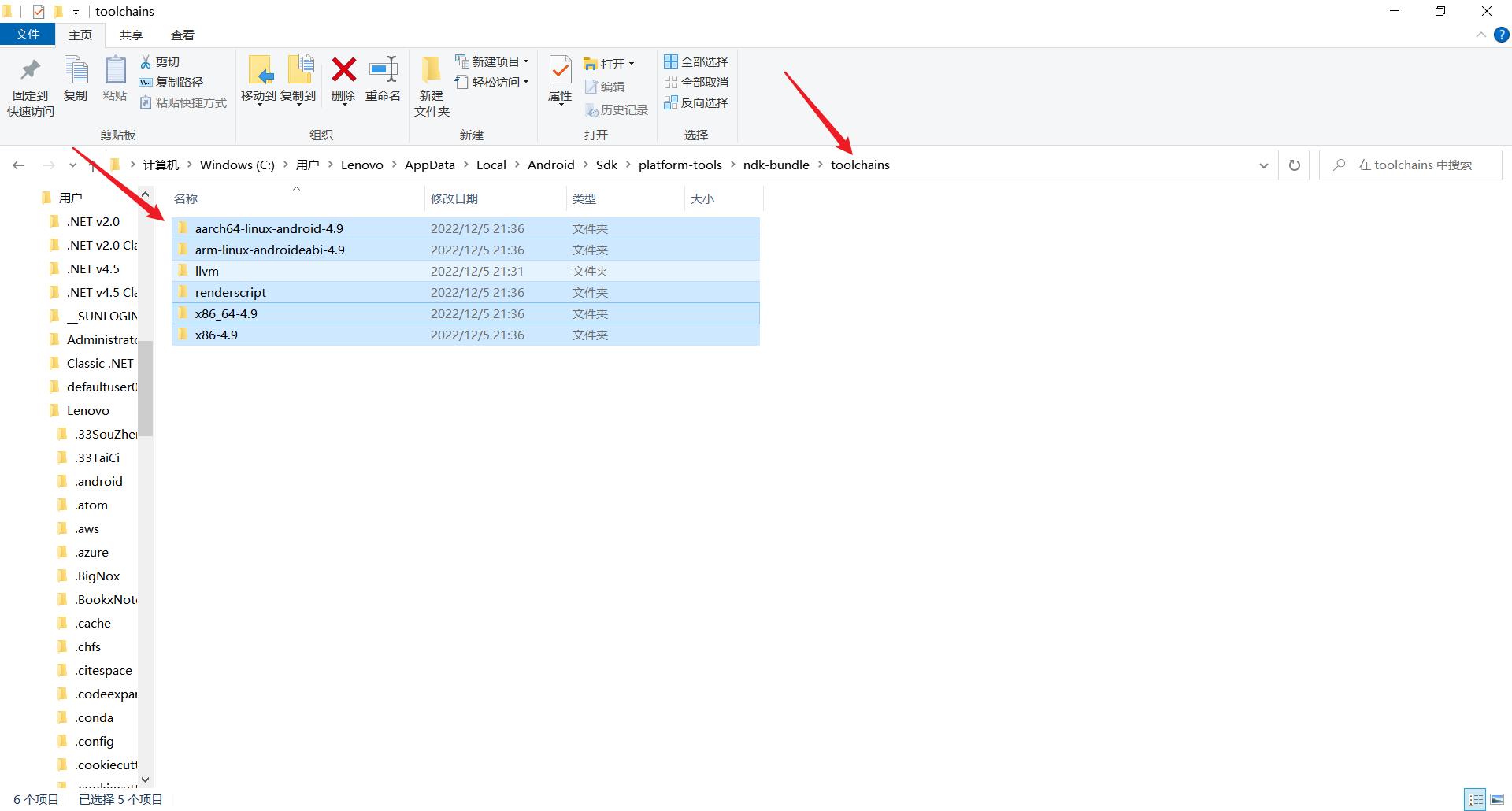

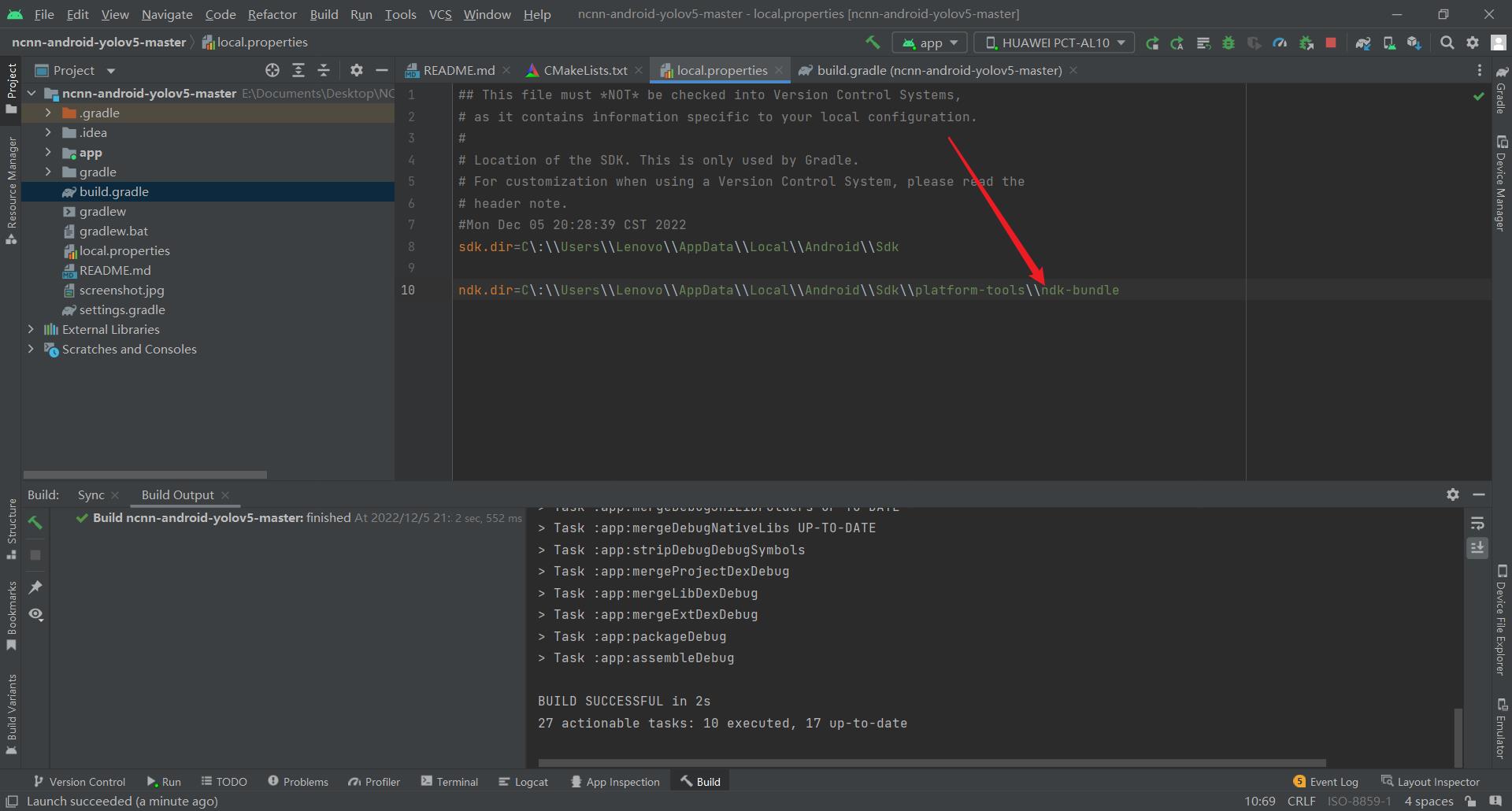

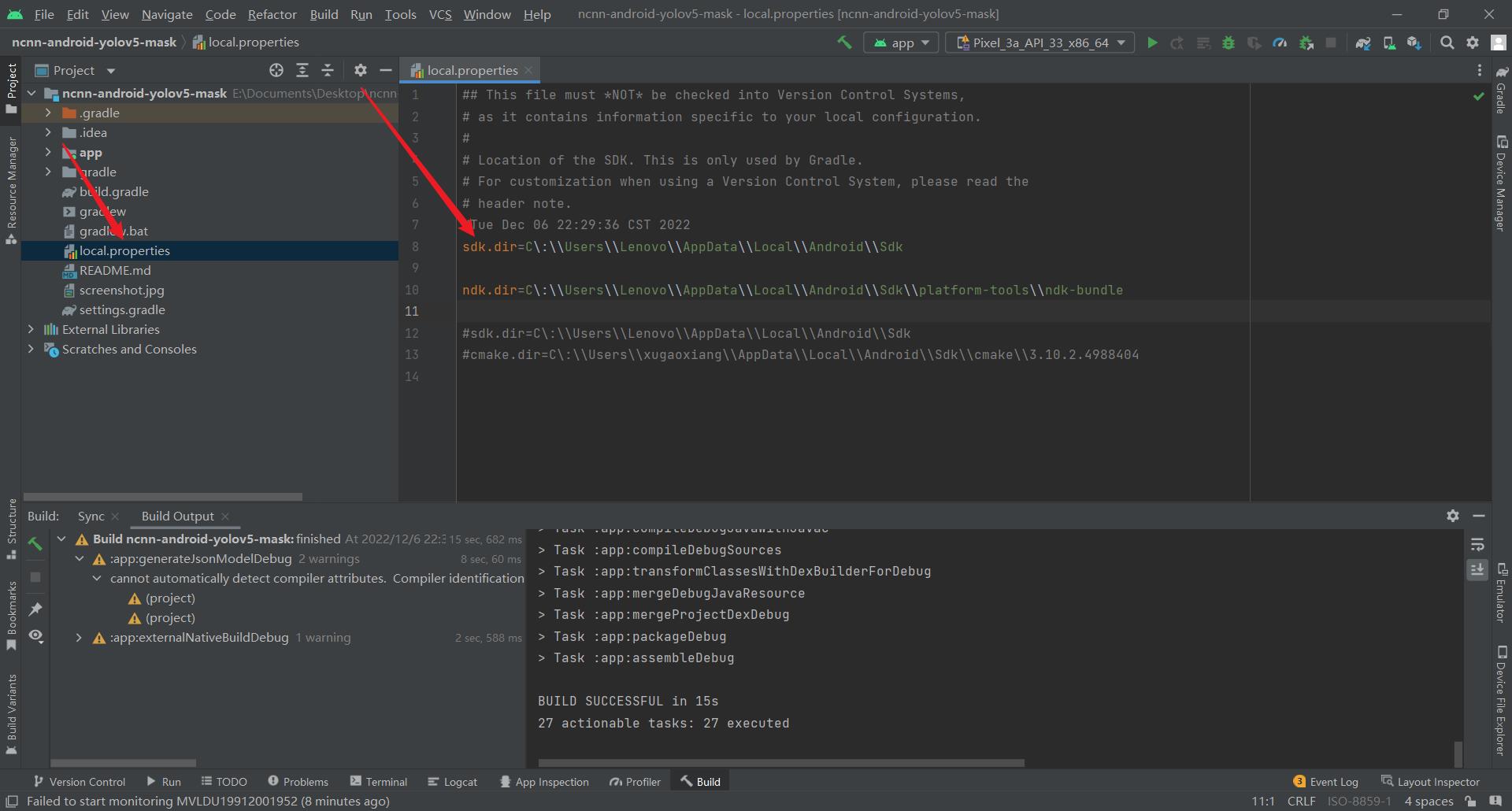

No toolchains found in the NDK toolchains folder for ABI with prefix:** arm-linux-androideabi**

在ABI的NDK工具链文件夹中没有找到带有前缀:arm-linux-androideabi的工具链

原因分析:最新版ndk(version=25.1.8937393)的toolchains文件夹中无arm-linux-androideabi文件

解决办法

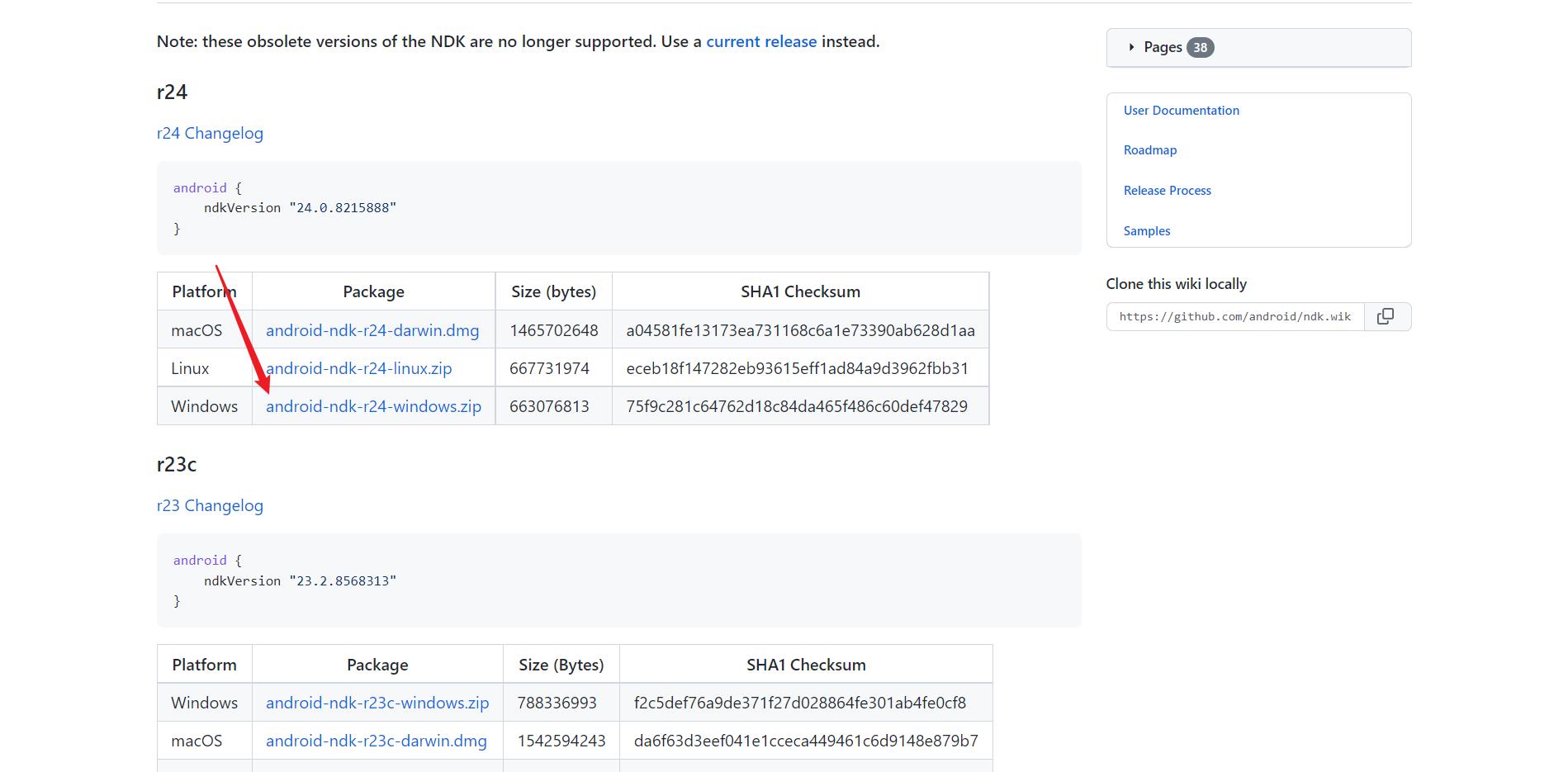

- 下载老版本NDK21,

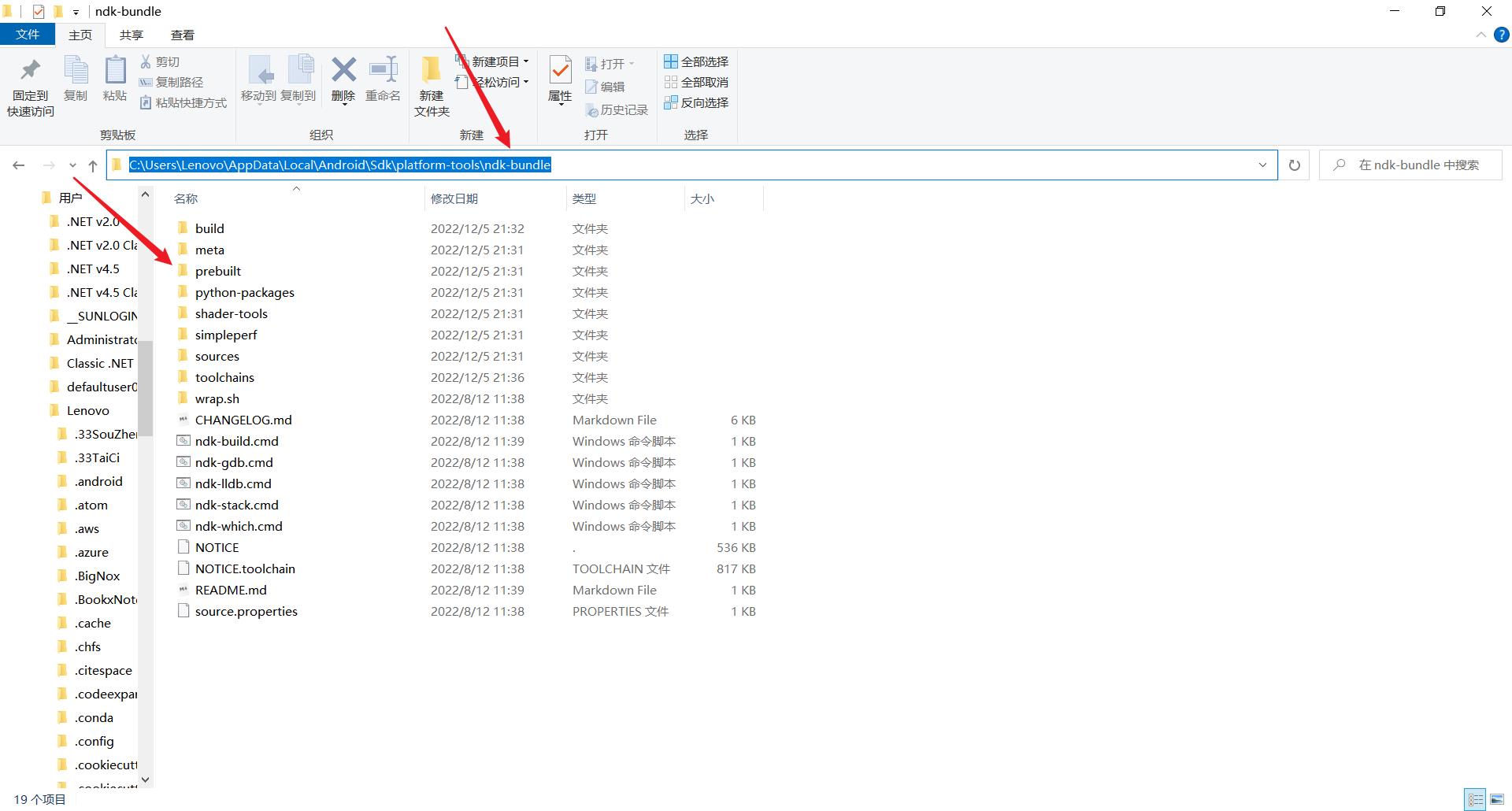

- 打开本地Android SDK所在路径,解压到指定目录就行(如果没有这个目录,就新建一个)

/ndk-bundle/toolchains

- developer.android.com/ndk/downloads/?hl=zh cn

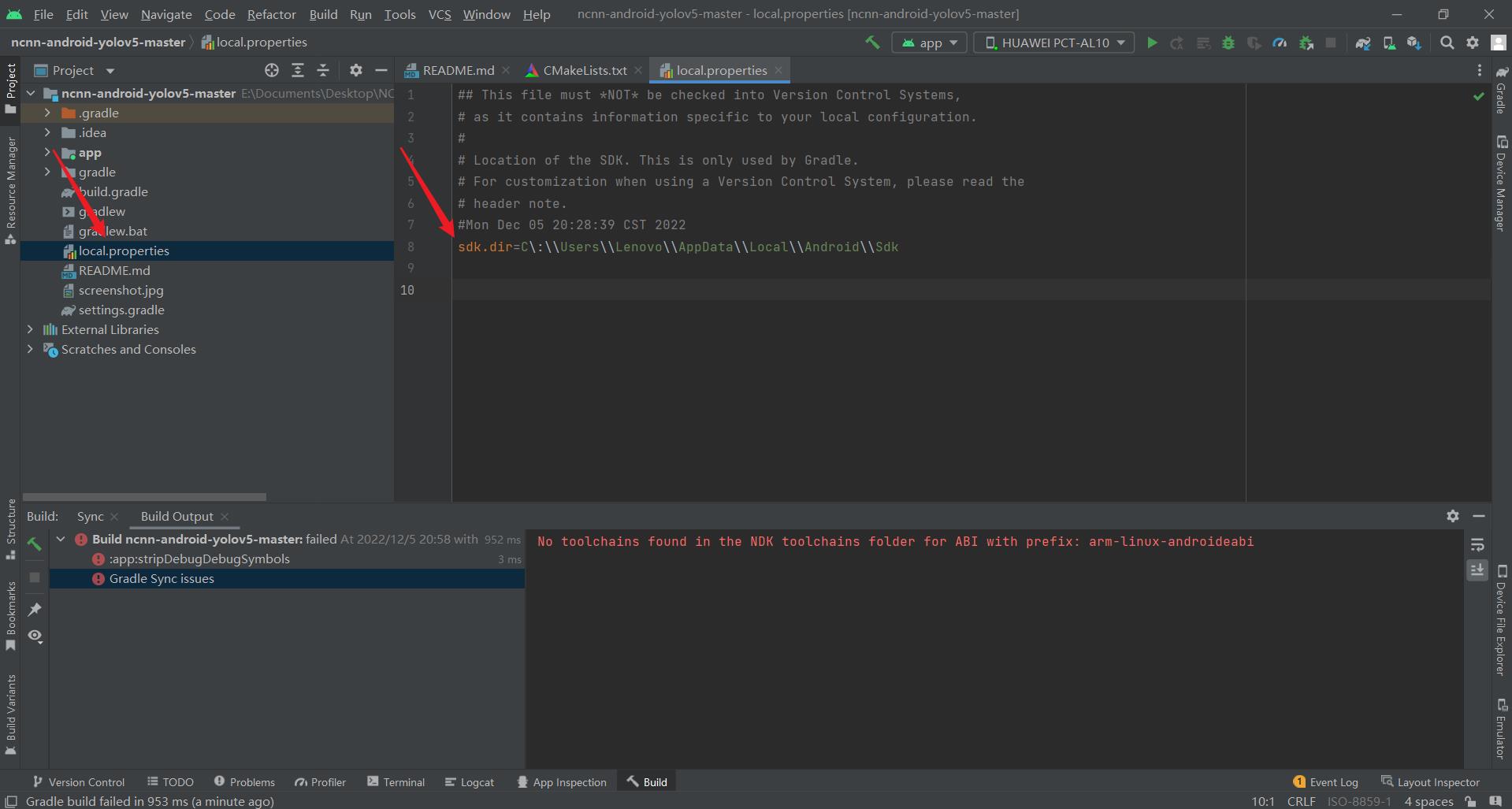

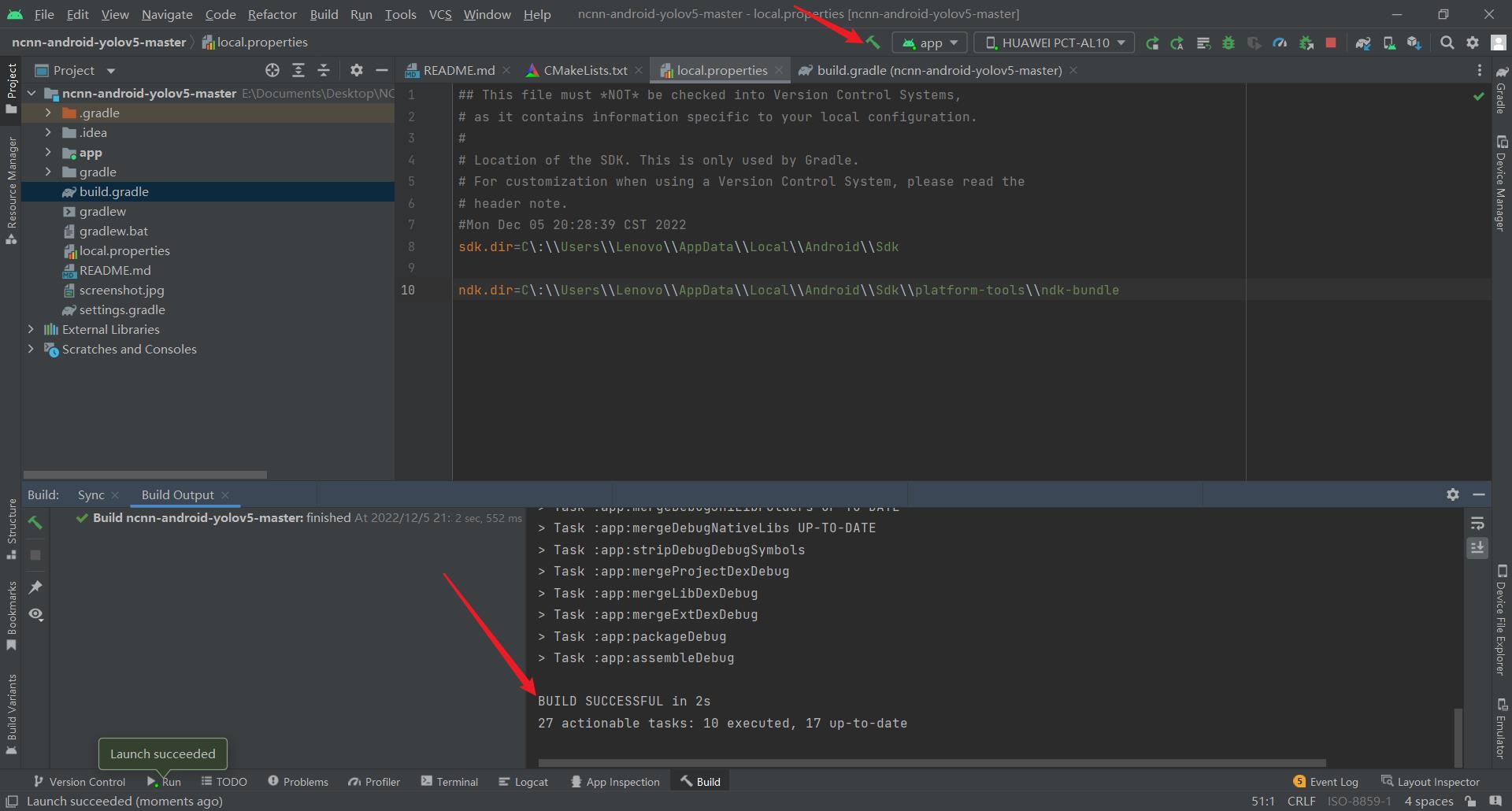

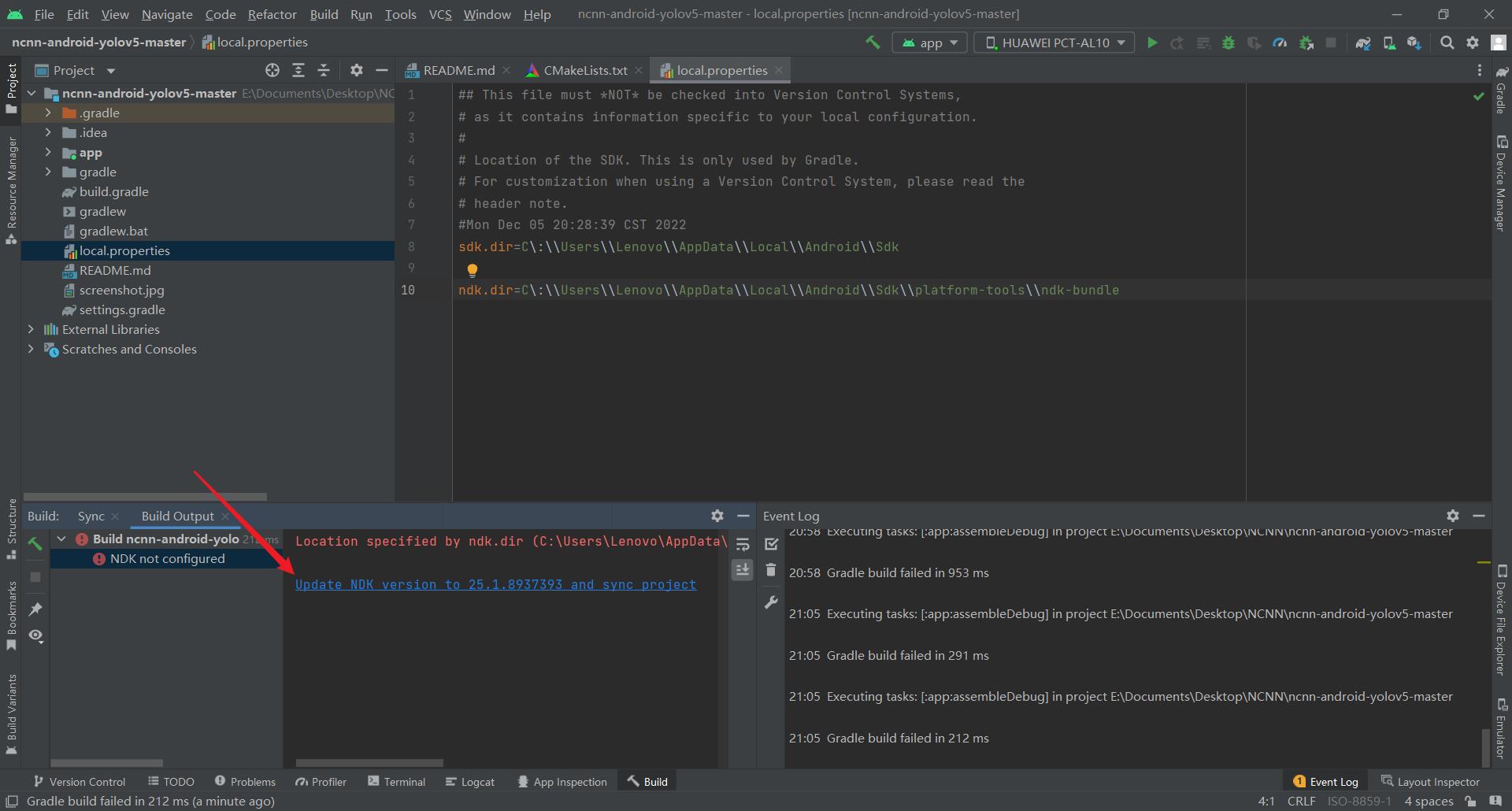

- 修改项目根目录的local.properties文件

- 可以看到这个文件中原来没有NDK的路径,我们为其手动指定一个

- 这个路径是安卓SDK下面的路径,具体根据自己的实际情况进行选择

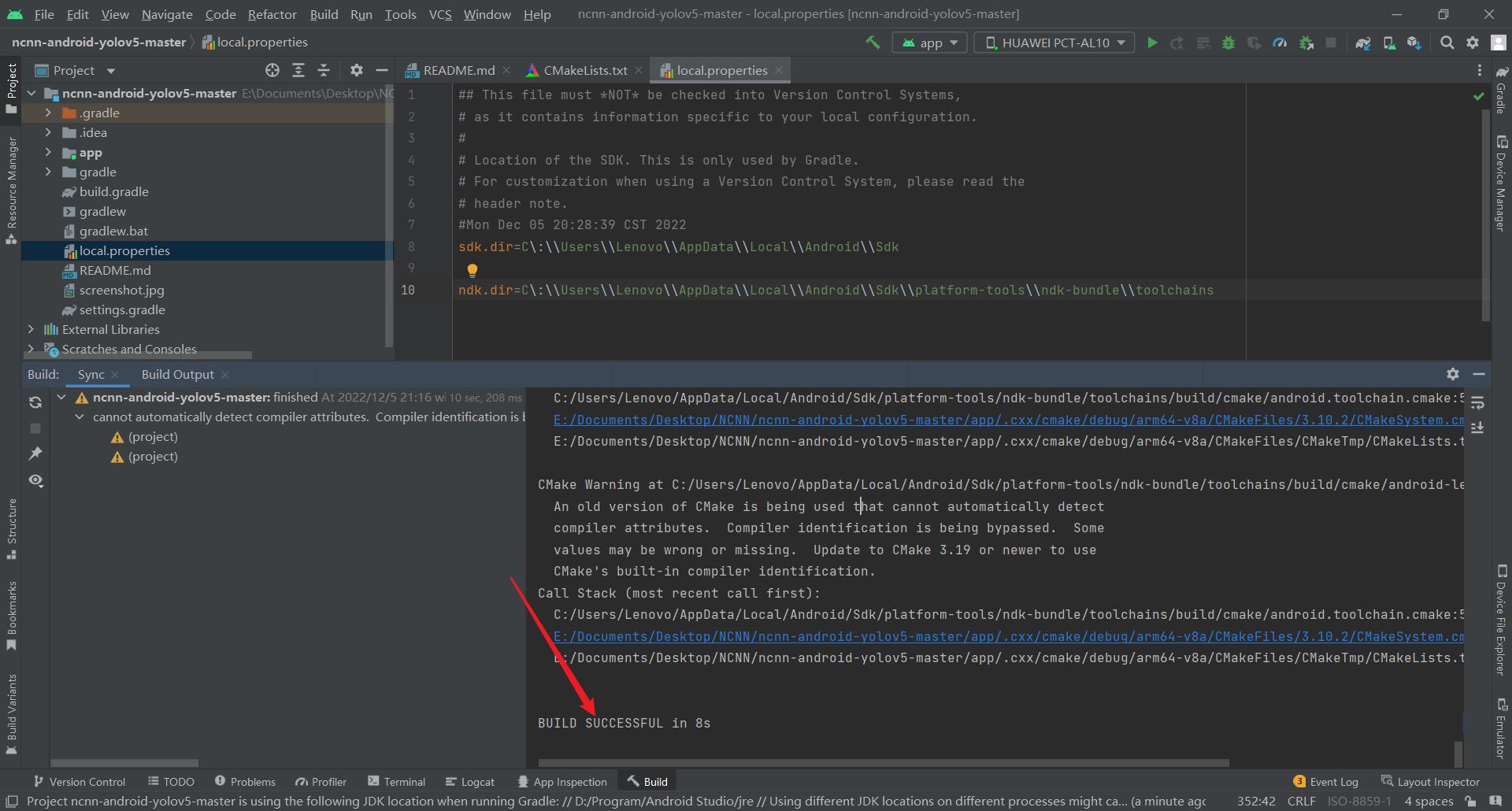

ndk.dir=C\\:\\\\Users\\\\Lenovo\\\\AppData\\\\Local\\\\Android\\\\Sdk\\\\platform-tools\\\\ndk-bundle

- 同时安装低版本的ndk(如version=21.3.6528147),将低版本ndk中toolchains 文件夹下的arm-linux-androideabi等文件复制到25.1.8937393版本ndk的toolchains 文件夹中

- 之后再构建项目就不报错了

-

Update NDK version to 25.1.8937393 and sync project

这个很好理解嘛,也就是自己的NDK的版本太低了,下载最新版的NDK即可

-

Location specified by ndk.dir (C:\\Users\\Lenovo\\AppData\\Local\\Android\\Sdk\\platform-tools\\ndk-bundle) did not contain a valid NDK and and couldn’t be used

没有包含有效的NDK

实际原因是NDK的路径不对

确保NDK的两个路径是正确的 -

-

-

这样之后再进行sync projec就可以正常了

-

-

OSError: [WinError 1455] 页面文件太小,无法完成操作。 #OSError

电脑上开的东西太多了,关掉一些就好了

或者设置虚拟内存

4.2. onnx转换报错

- export.py转换之后没有生成onnx的文件

可能是因为自己使用的PyCharm进行这个操作,里面有一些参数没有传递到,可以自己手动去看,直到找到到底哪里的参数传递出了问题(我感觉这个工作没有太大重复价值,就没做)

- 也可以直接使用脚本转换,这样一般就可以转换成功了

export.py --weights weights/yolov5s.pt --include torchscript onnx

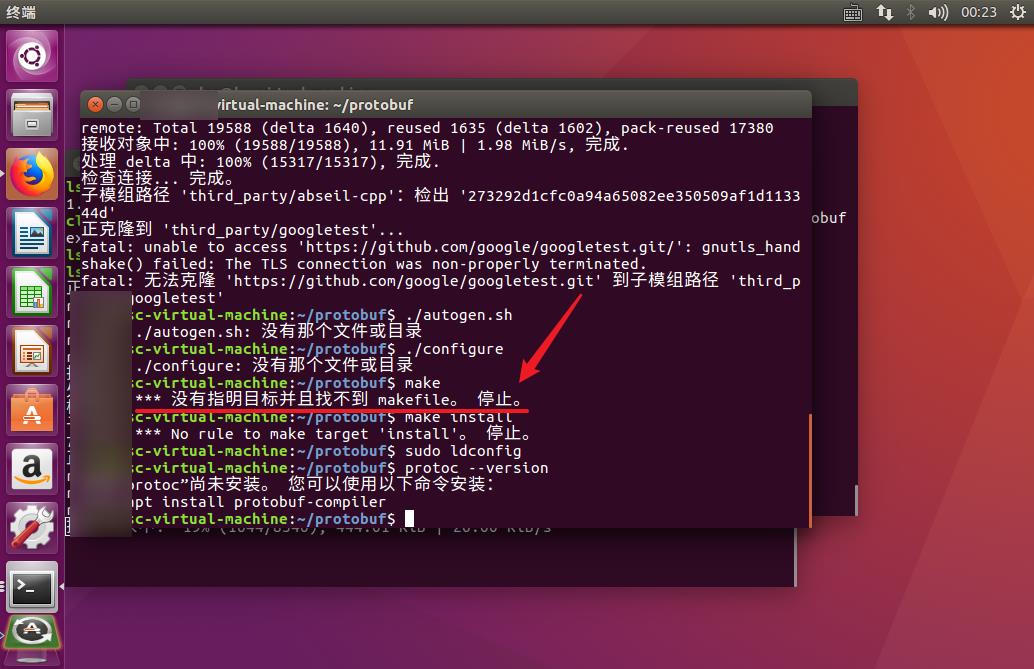

4.3. 编译protobuf报错

- make: *** No rule to make target ‘install’。 停止。

可能是中间有些文件没有下载下来,删除掉protobuf文件夹,再重新运行一遍安装命令也许就可以成功了

git clone https://github.com/protocolbuffers/protobuf.git

cd protobuf

git submodule update --init --recursive

./autogen.sh

./configure

make

make install

sudo ldconfig

或者自己先手动把这个仓库下载下来,然后再进行安装

cd protobuf

git submodule update --init --recursive

./autogen.sh

./configure

make

make install

sudo ldconfig

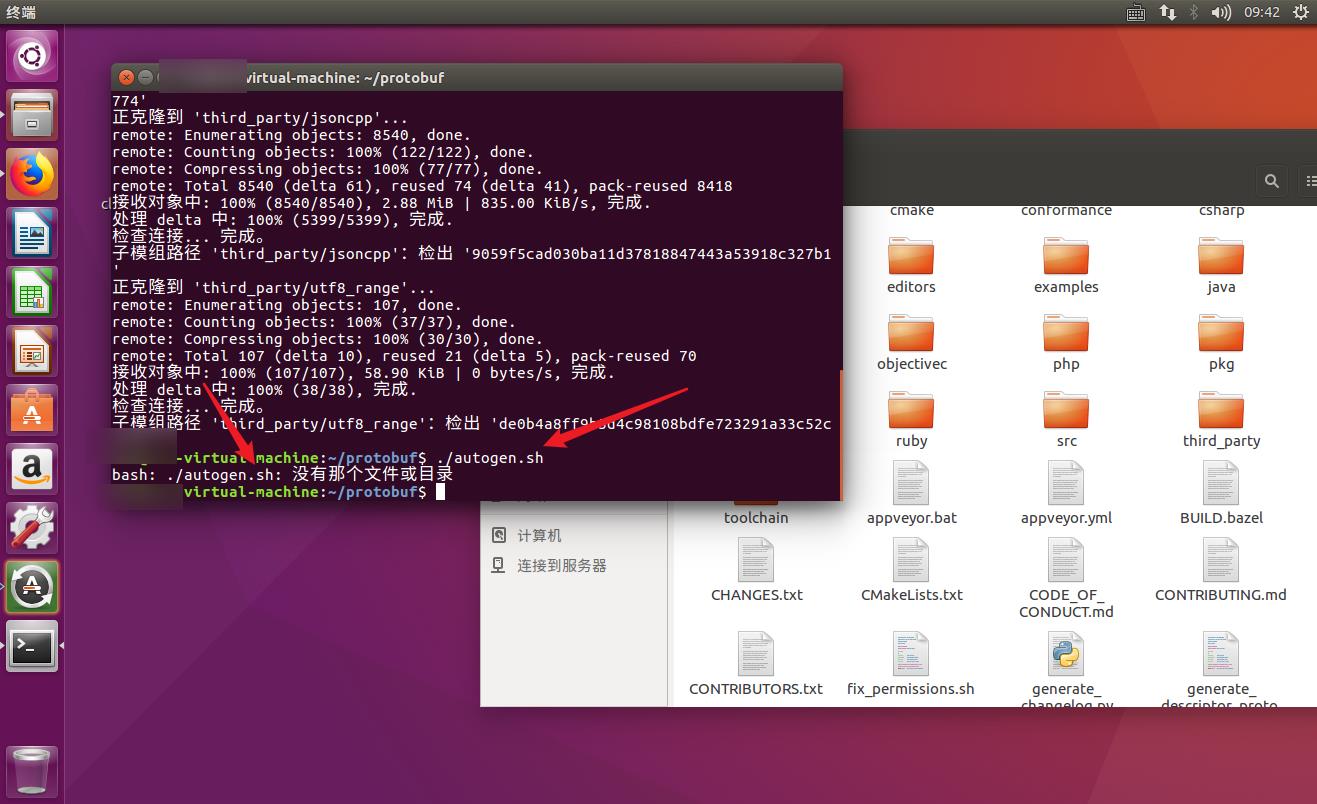

- 应该是从git submodule update --init --recursive 这一步后面就都开始错了,因为没有找到autogen.sh文件

- 2022.12.06-09:38:20

- 自己又安装了一遍,发现这边git submodule update --init --recursive 这一步其实并没有太大问题

- 2022.12.06-09:41:43

- 最终,百度找到原因了,autogen.sh是一个shell脚本,用来简化生成configure的,需要事先配置好,而不是在这个程序中才搞的。

- autogen.sh_zhangatong的博客-CSDN博客_autogen.sh

- 那么直接安装autogen.sh的相关组件即可

sudo apt-get install autoconf automake libtool

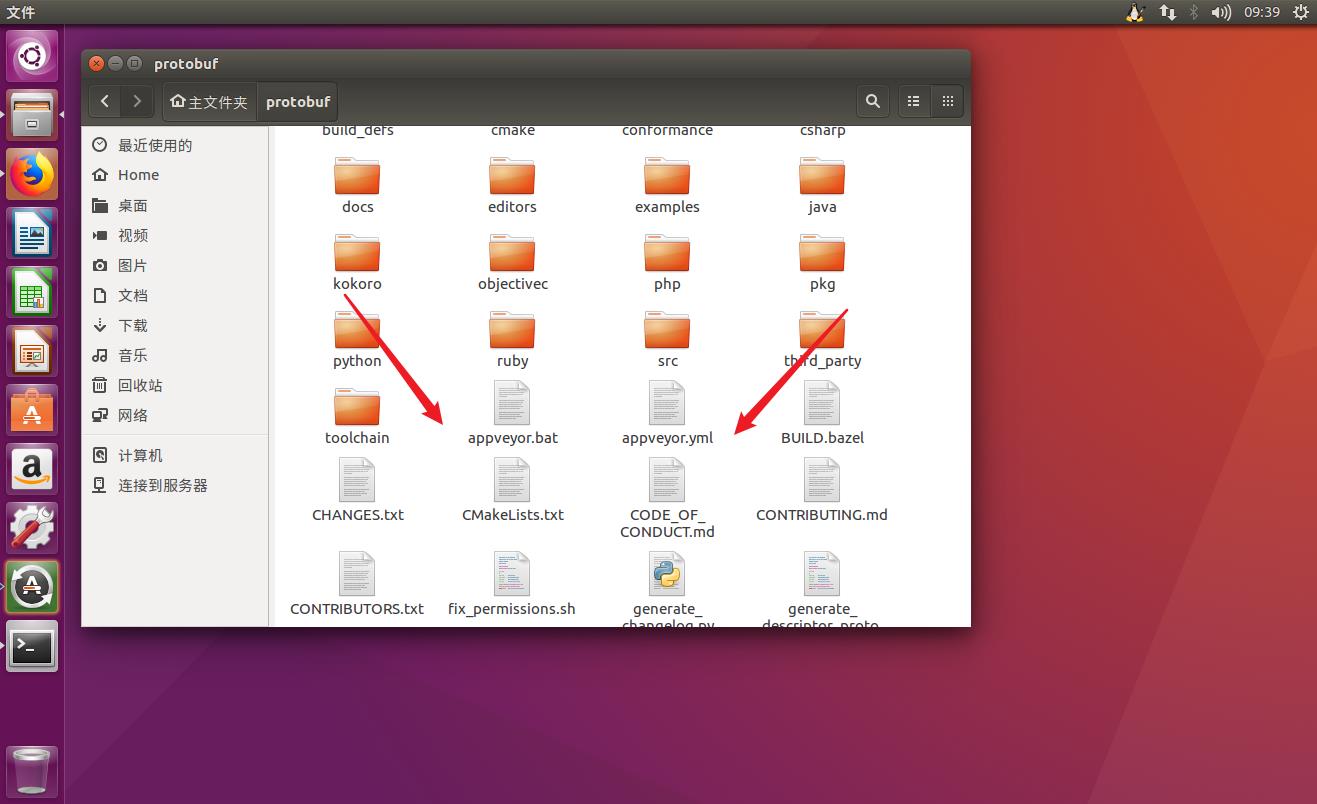

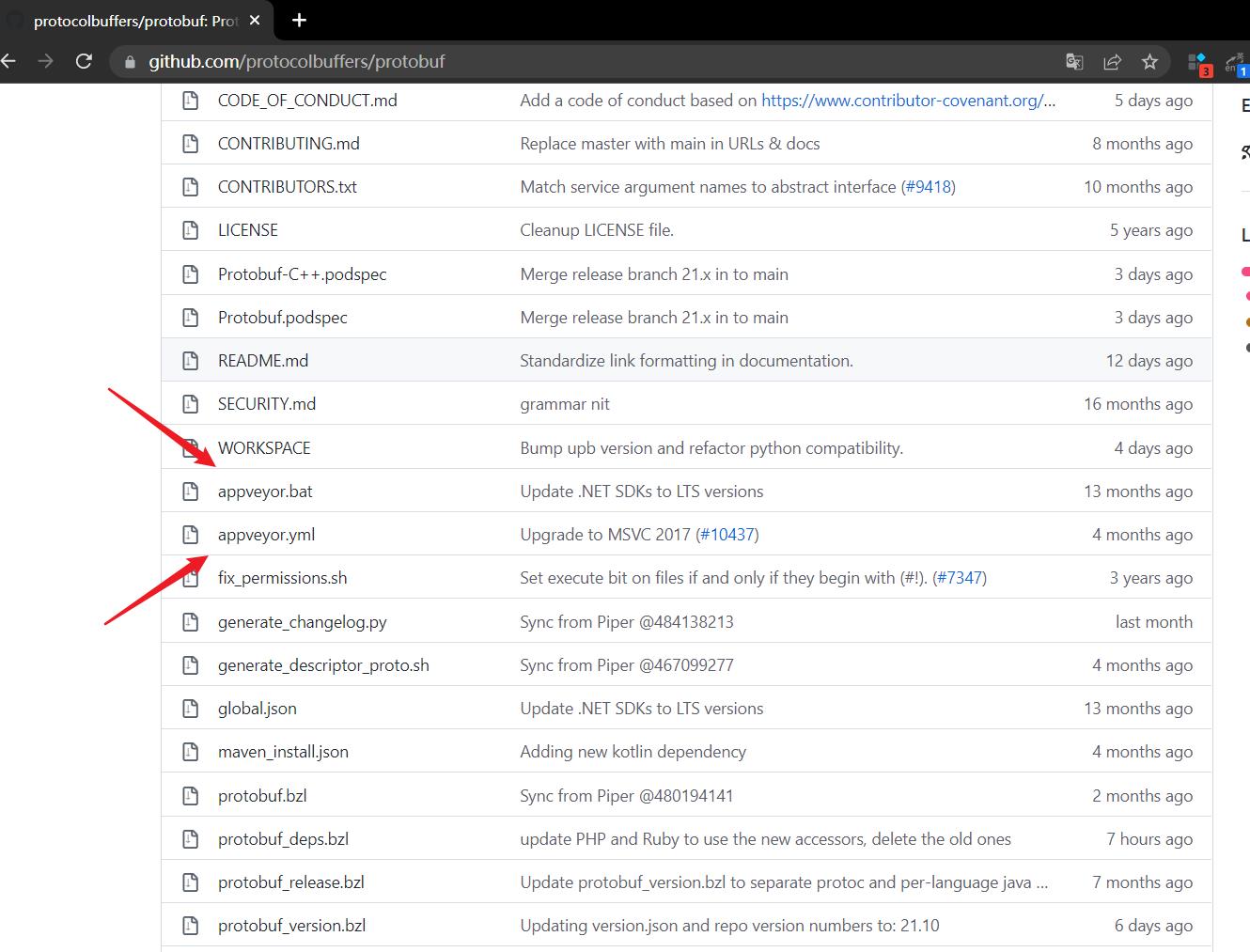

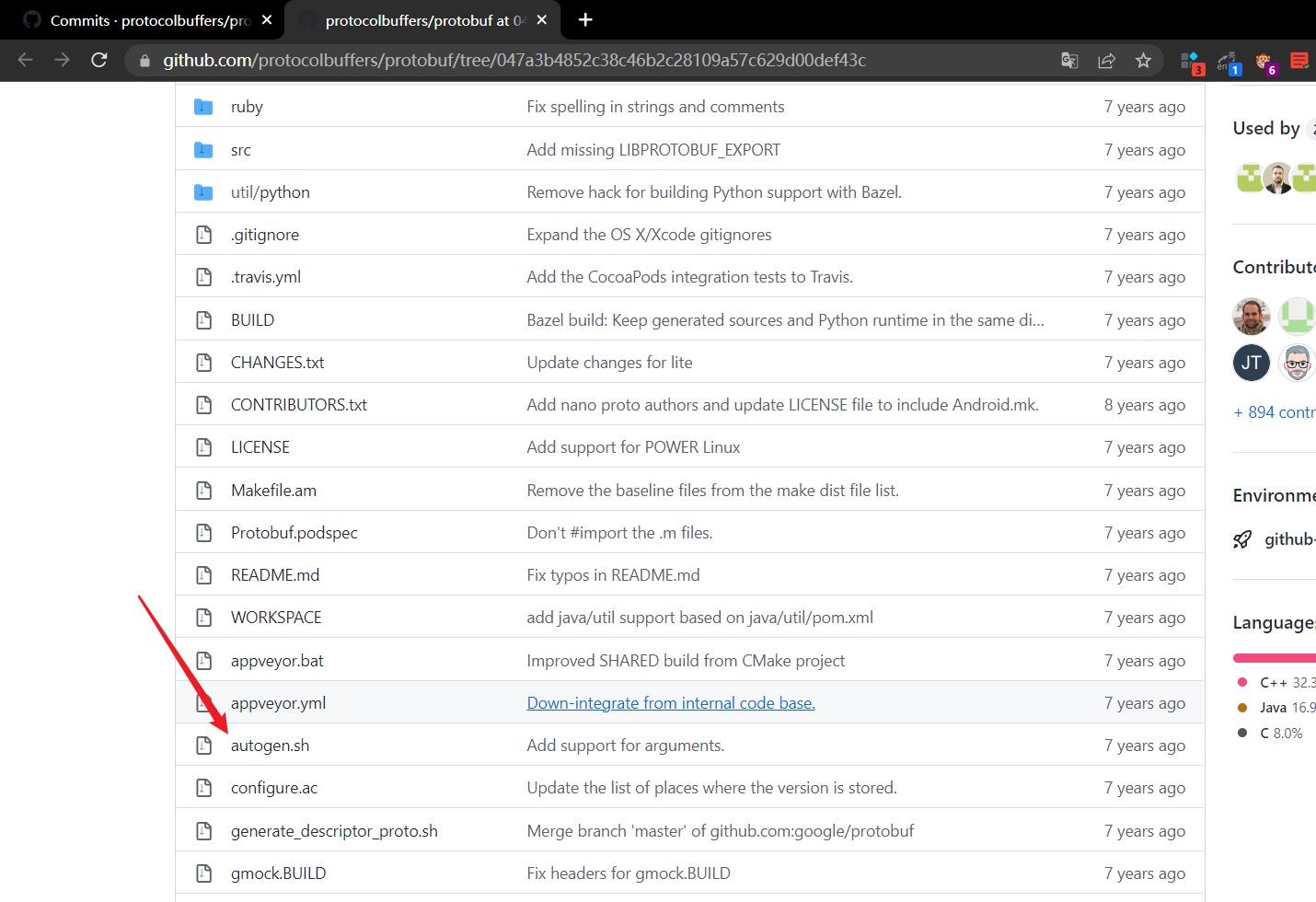

- 最终找到原因了,下载的protobuf源码中没有autogen.sh文件

- 这是因为新版本的项目中已经没有了这个autogen.sh,

- 而旧版本上面还有

- 我们下载的时候使用旧版本即可

git clone -b v3.20.1-rc1 https://github.com/protocolbuffers/protobuf.git

- 可以看到这个问题已经不报错了

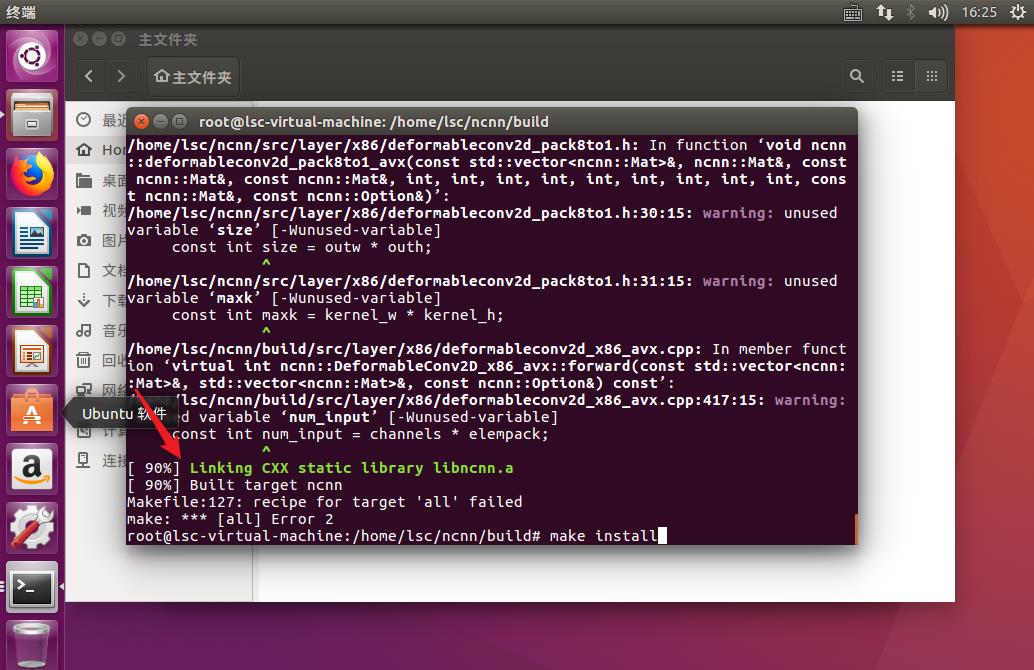

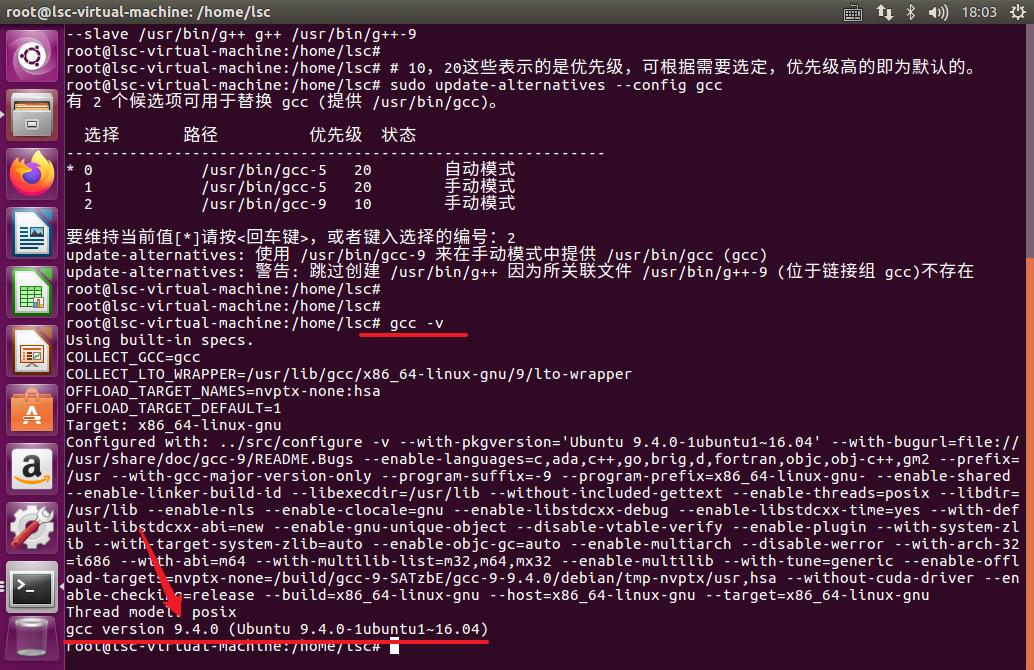

4.4. 编译NCNN报错

- Makefile:127: recipe for target ‘all’ failed make: *** [all] Error 2

Ubuntu下编译ncnn的时候说这个问题

这是因为编译的时候找不到链接目录

更新到gcc version 9.4.0 (Ubuntu 9.4.0-1ubuntu1~16.04) 解决问题了。 - NCNN编译报错 · Issue #4255 · Tencent/ncnn · GitHub

- 可以看到这个错误已经消失了(虽然后面依然有错误,但最起码是解了燃眉之急)

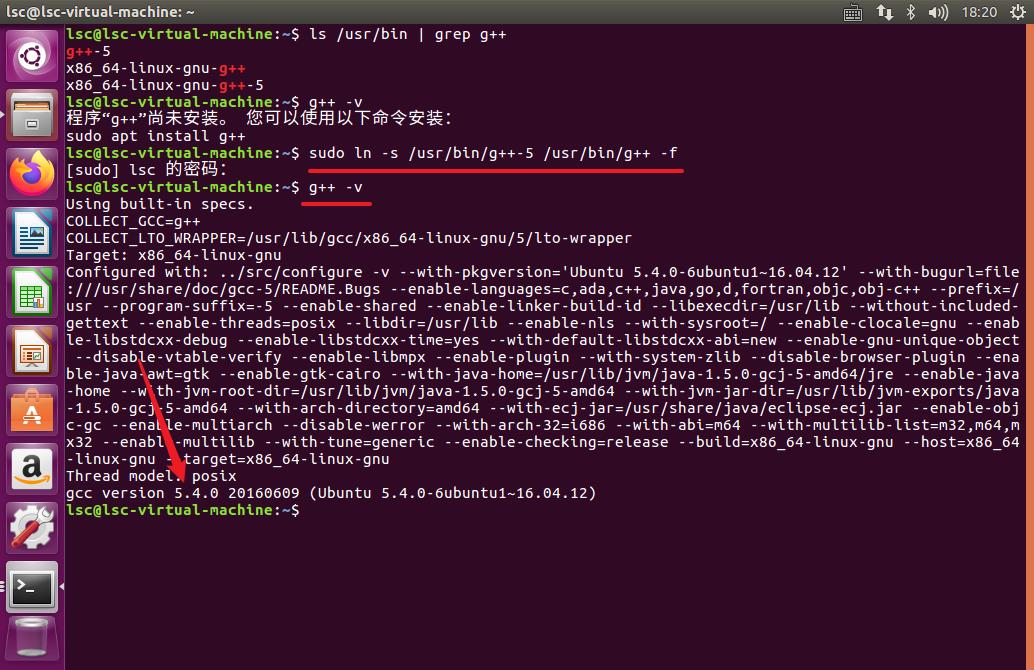

- CMake Error at CMakeLists.txt:48 (project):No CMAKE_CXX_COMPILER could be found.

应该是自己更新了gcc之后,g++找不到了

重新安装对应版本的g++即可

或者建立软连接

sudo ln -s /usr/bin/g++-5 /usr/bin/g++ -f

- 之后就不报错了

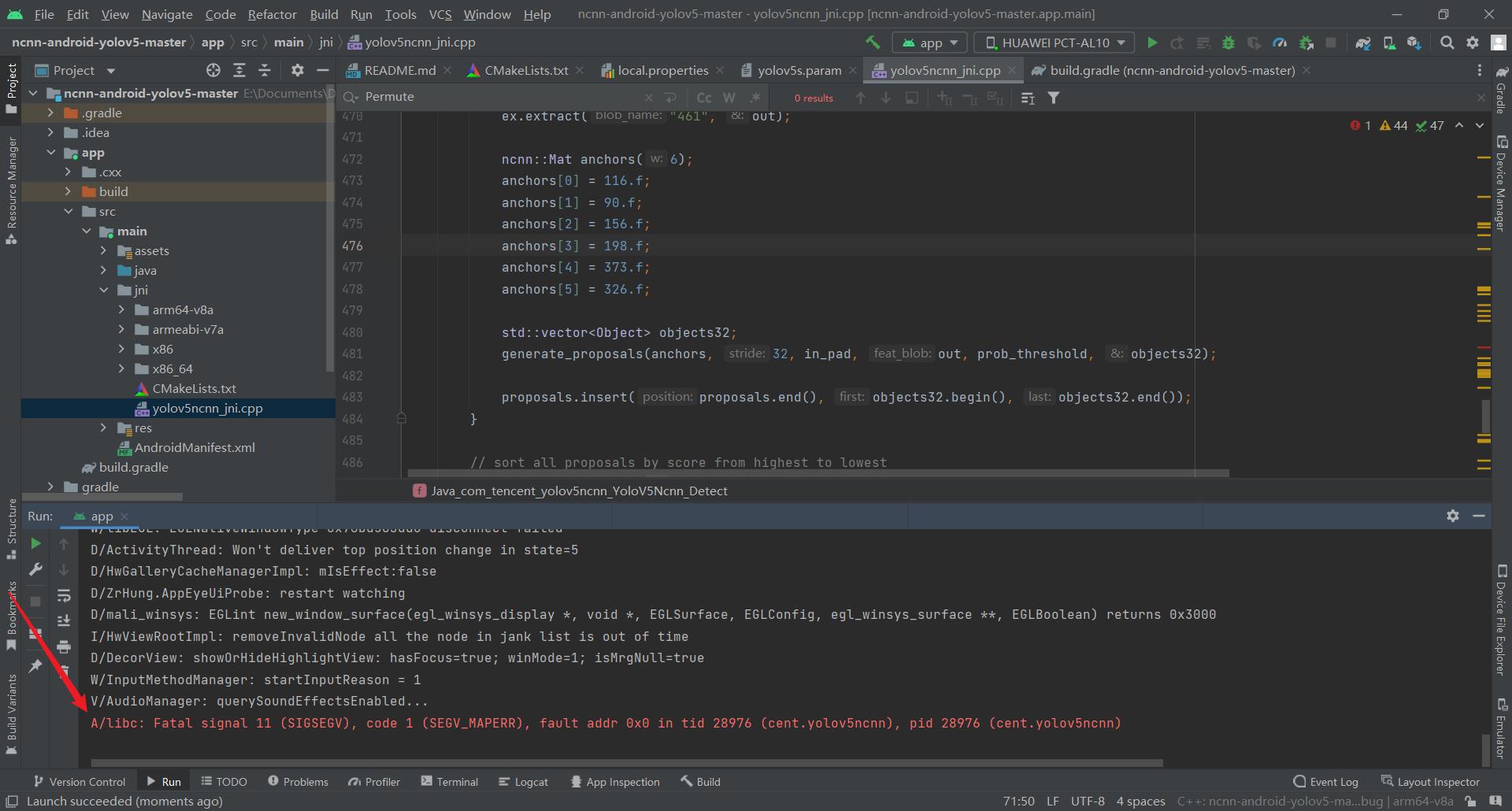

4.5. 手机APP报错

-

手机APP可以安装成功,也可以打开,但是点击识别的时候闪退

可以使用IDE调试,看一下到底报的是什么错误

A/libc: Fatal signal 11 (SIGSEGV), code 1 (SEGV_MAPERR), fault addr 0x0 in tid 28976 (cent.yolov5ncnn), pid 28976 (cent.yolov5ncnn) -

这个问题,大概率还是修改Permute参数的时候不对,要相信自己,再照着前面的教程看一下,一定可以修改成功的。

此外,不要用虚拟机运行,直接用手机运行

使用自己的模型会报错,yolov5-5.0 · Issue #32 · nihui/ncnn-android-yolov5 · GitHub

不同版本的YOLOv5 修改的方式是不一样 -

请问如何使用自己训练和转换后的param和bin文件呢? · Issue #39 · nihui/ncnn-android-yolov5 · GitHub

-

YOLOv5 5.0 的修改方法参考这篇帖子

-

YOLOv5 6.0 的修改方法参考这篇帖子

-

手机APP无法通过APP文件安装

那还是通过Android Studio进行安装吧 -

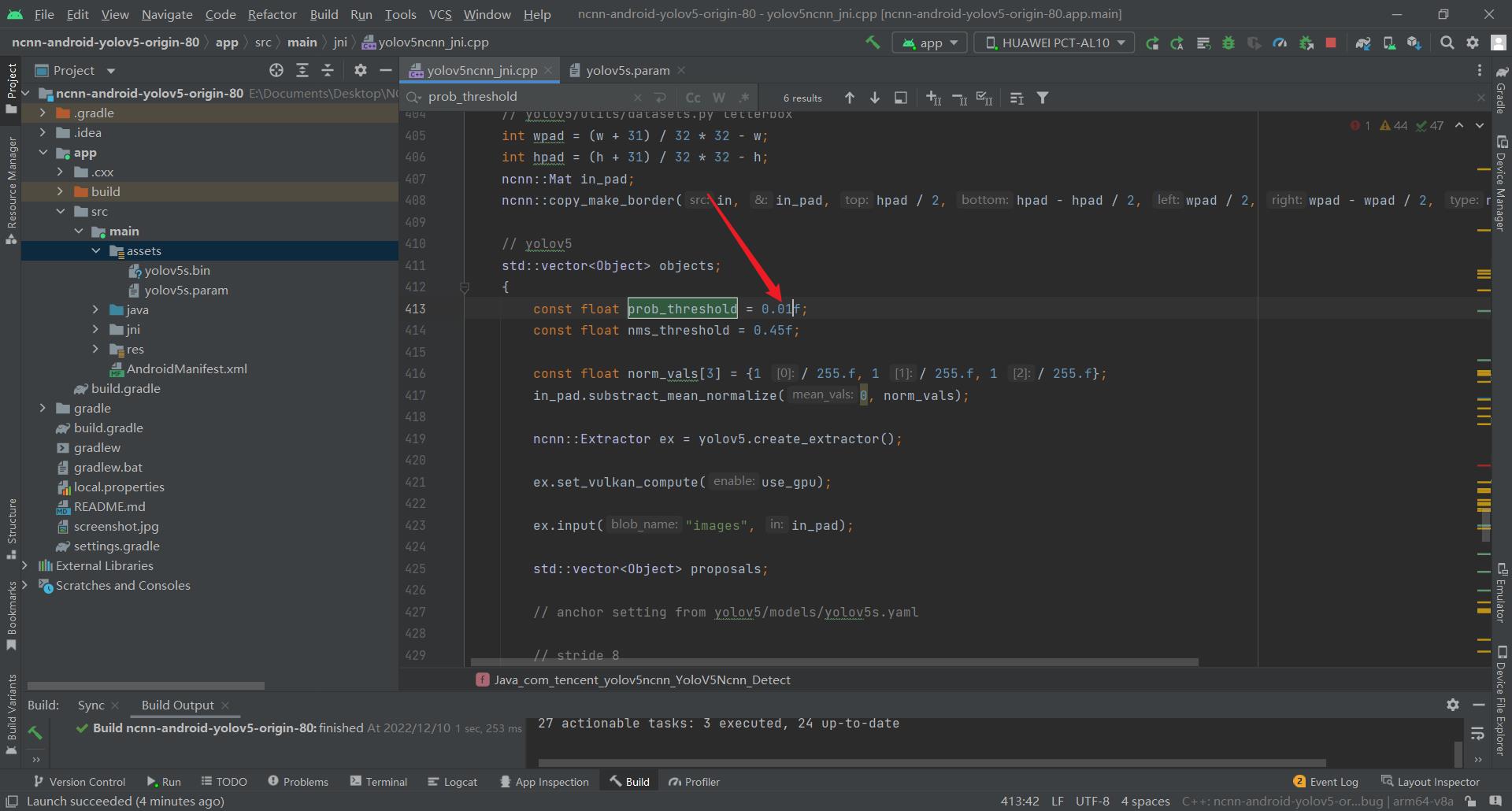

不闪退,但是也无法识别

效果 -

调试yolov5ncnn_jni.cpp文件中的prob_threshold阈值, -

将其改成0.01看能否出来框

-

-

如果可以出来框,那么表明就是阈值的问题,如果不能出来框的话,那就是其他地方的问题

换一张图试一下 -

有时候识别不出来,可能是因为图像中的物体不符合定义中的类别,再换一张图片,有可能就可以识别出来了

-

比如自己识别不出来这个口罩里,但是却可以识别出来这个男的

-

-

5. 资源

- 可以直接运行的NCNN项目

5.1. 口罩项目

https://www.lanzoui.com/iWoBt0hzt9hi 访问码:24647

下载下来之后,需要更改一下自己的Android SDK路径

6. 参考资料

- 在Android上运行YOLOv5目标检测_哔哩哔哩_bilibili

- 记录历经三天将自己的yolov5模型部署到Android安卓手机_鲁木子的博客-CSDN博客_yolov5部署到手机

- 【教程】YOLOv5模型转化-Android端部署__less is more的博客-CSDN博客_yolov5 安卓部署

- 借助NCNN,在Android上运行YOLOv5目标检测 - 迷途小书童的Note迷途小书童的Note

- 5. android里面调用tflite_哔哩哔哩_bilibili

录历经三天将自己的yolov5模型部署到Android安卓手机_鲁木子的博客-CSDN博客_yolov5部署到手机](https://blog.csdn.net/qq_44696500/article/details/124195375) - 【教程】YOLOv5模型转化-Android端部署__less is more的博客-CSDN博客_yolov5 安卓部署

- 借助NCNN,在Android上运行YOLOv5目标检测 - 迷途小书童的Note迷途小书童的Note

- 5. android里面调用tflite_哔哩哔哩_bilibili

- yolov5ncnn实时检测 · Issue #2 · nihui/ncnn-android-yolov5 · GitHub

yolov5 6.0版本->onnx->ncnn +安卓部署 附加ncnn环境配置 保姆级详细教程

目标检测:yolov5 6.0版本 ncnn环境安装 至 +安卓部署 一条龙教程

文章目录

背景

题主在模型部署时踩坑颇多,也看到yolov5 部署的参考资料不多,故本小萌新将自己踩坑的过程记录下来,也方便大家参考。yolov5->pt->onnx->ncnn float16位量化

一、准备阶段

1.参考文章

1.YoloV5官方github

YoloV5官方TFLite, ONNX, CoreML, TensorRT 的Export实现

2.nihui(ncnn作者)写的文章,感谢nihui大佬赏饭吃

ncnn github地址

ncnn-android-yolov5 github地址

详细记录u版YOLOv5目标检测ncnn实现

详细记录u版YOLOv5目标检测ncnn实现(PNNX版)

3.我踩坑时的参考文章

windows下最新yolov5转ncnn教程

YOLOv5转NCNN过程

yolov5 转onnx转ncnn

基本都是21年的文章,有些步骤现在其实不用了,大家可以参考参考

4.Linux下ncnn部署流程 –可参考

ncnn编译部署(Linux)

#2.流程

1.准备训练好的模型,建议先用官方的yolov5.pt模型自己整流程走一遍,再替换为自己的模型结构。Yolov5官方pt模型链接(链接为6.1版本)

2.pt模型->onnx

3.Windows下ncnn环境配置教程详解

4.onnx->ncnn

5.ncnn的安卓部署

二、pt模型->onnx

github上下载yolov5工程,按照 yolov5 README 指引,调用detect.py看下模型有没有问题。准备就绪后调用export.py进行模型转换

我使用的是yolov5-6.1工程,将yolov5s.pt复制到文件目录下

python export.py --weights yolov5s.pt --include onnx --img 640 --train --simplify

6.1版本已经集成好了,很方便

添加–include 是指定导出类型为 torchscript/onnx ,读者按需转换即可。

添加–train 是为了去除后处理,即不直接输出一个分类结果output,而将3个特征图的作为输出。

添加–simplify 是为了简化模型,不需要像其他帖子一样单独进行onnxsim简化,省事。

如果是修改自己的模型 记得 --data xxx.yaml

最后得到文件

yolov5s.onnx

三、Windows下ncnn环境配置教程详解

最初我是学习nihui写的pnnx版yolo部署,失败了

后面再尝试onnx的过程中,发现很多参考资料和教程都没有加入ncnn环境部署部分。大多都直接讲 ncnn-android-yolov5 的安卓部署。

实际上对萌新来说(起码我是),跟着B站教程和资料时进行不下去了,这是因为它们分享onnx模型转ncnn模型经验的时候断档了,忽略了ncnn配置环节。

1.参考

文章:ncnn环境配置

这参考文章对我帮助不小,感谢作者。在这里我搬过来,侵删

准备项:VS、 cmake、 protobuf

讲道理,这3个的版本应该没关系,我觉得可以用最新版 [狗头]

2.VS安装

我用的是19版,19和22在这项目上应该差别不大。

下载地址: https://visualstudio.microsoft.com/zh-hans/vs/

下载VS后安装下面3个工作负荷

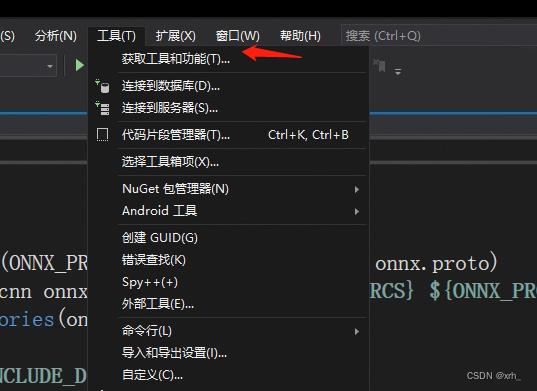

已经有VS的读者补充工具负荷即可:工具->获取工具和功能

3.cmake安装

我本身有cmake 所以当时是跳过的,此处是参考其他文章

cmake-3.16下载地址: 提取码: zme6

cmake需要变更环境变量

将解压后cmake-3.16.5-win64-x64文件夹点开进入bin将该路径添加至环境变量,

如路径为:D:\\software\\cmake-3.16.5-win64-x64\\bin

4.protobuf安装

protobuf-3.4.0下载地址: 提取码: hd3z

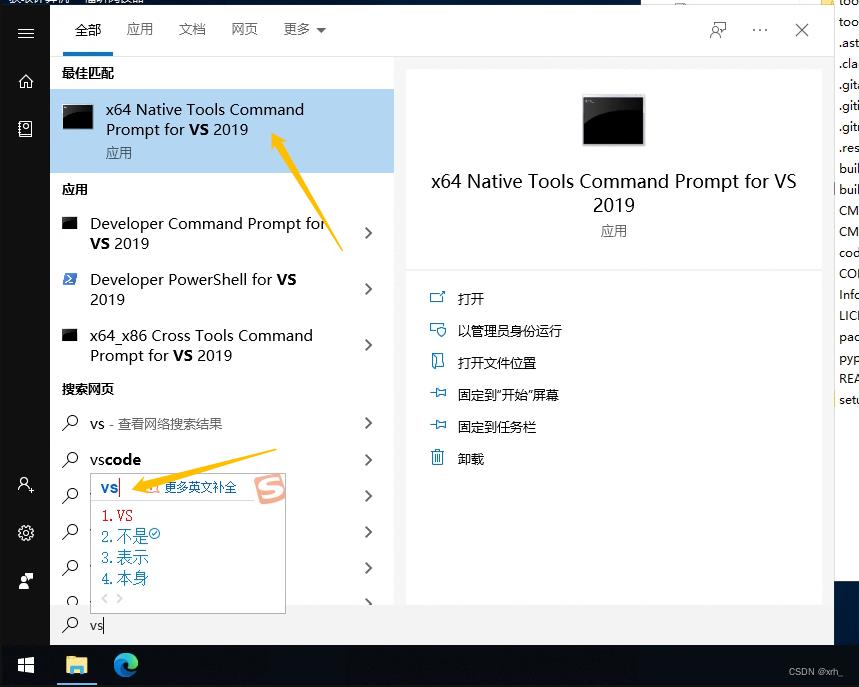

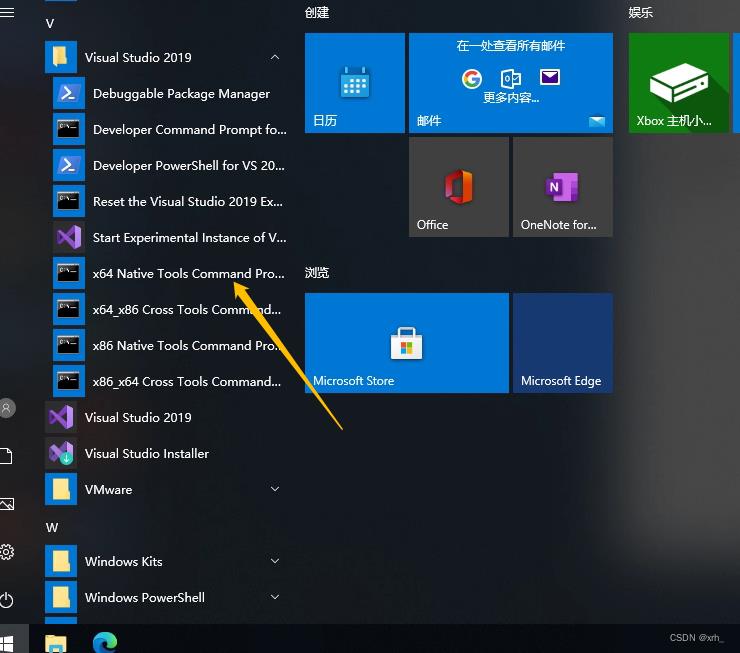

下载后解压,然后打开vs2019的x64命令提示

或

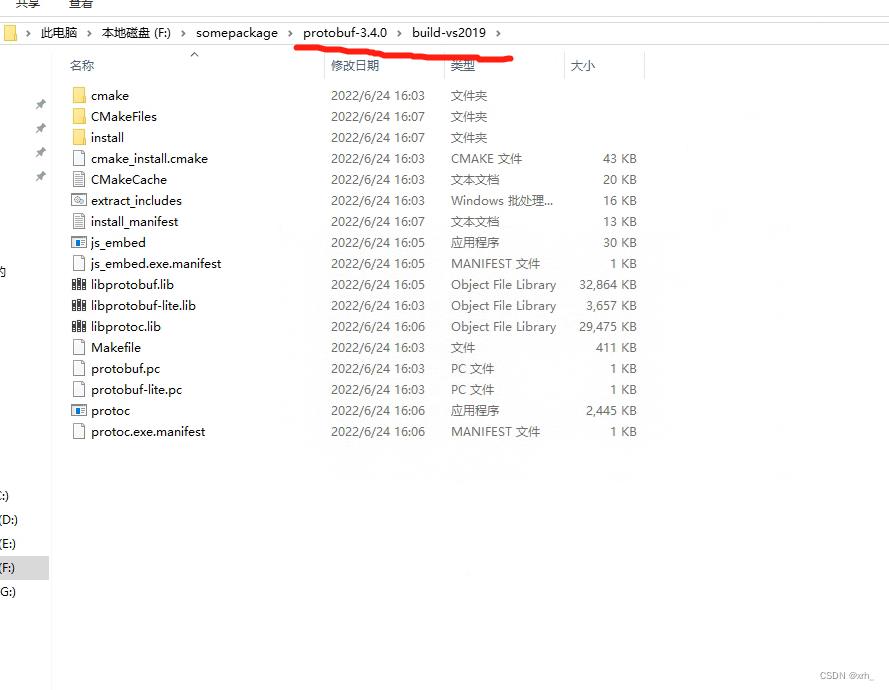

跳转到刚解压的protobuf的根目录,然后创建build-vs2019的文件并进行cmake操作

注:protobuf-root-dir为protobuf的下载位置

> cd <protobuf-root-dir>

> mkdir build-vs2019

> cd build-vs2019

> cmake -G"NMake Makefiles" -DCMAKE_BUILD_TYPE=Release -DCMAKE_INSTALL_PREFIX=%cd%/install -Dprotobuf_BUILD_TESTS=OFF -Dprotobuf_MSVC_STATIC_RUNTIME=OFF ../cmake

> nmake

> nmake install

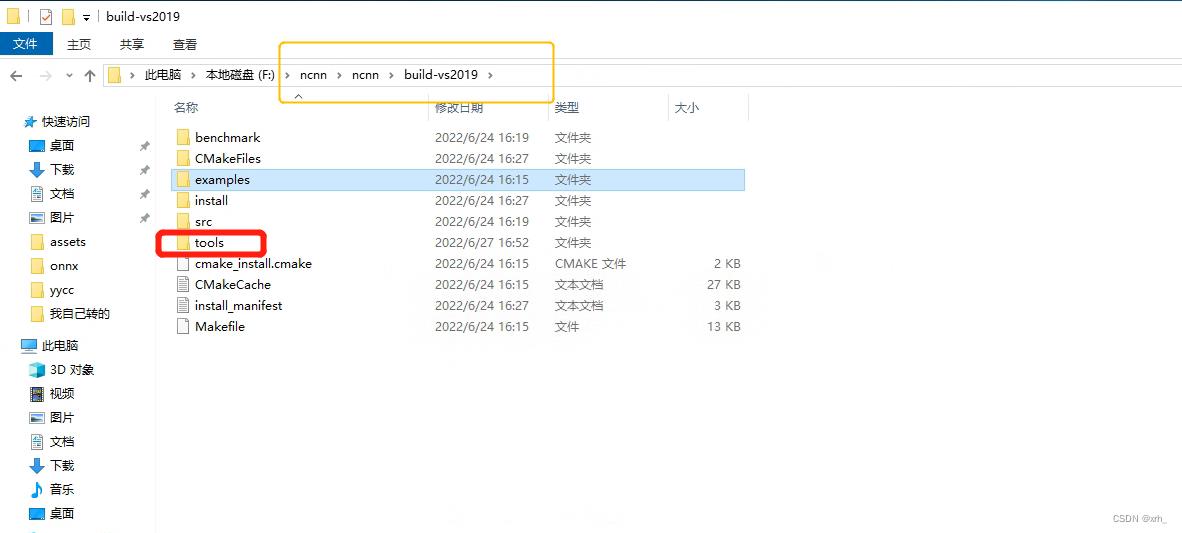

成功后会在 .\\protobuf\\build-vs2019 下生成若干文件

5.ncnn编译

github上直接下载项目,并解压

ncnn github地址

接下来我们使用vs2019的x64命令,与protobuf的安装类似,我们按下述代码操作,

> cd <ncnn-root-dir>

> mkdir -p build-vs2019

> cd build-vs2019

> cmake -G"NMake Makefiles" -DCMAKE_BUILD_TYPE=Release -DCMAKE_INSTALL_PREFIX=%cd%/install -DProtobuf_INCLUDE_DIR=<protobuf-root-dir>/build-vs2019/install/include -DProtobuf_LIBRARIES=<protobuf-root-dir>/build-vs2019/install/lib/libprotobuf.lib -DProtobuf_PROTOC_EXECUTABLE=<protobuf-root-dir>/build-vs2019/install/bin/protoc.exe -DNCNN_VULKAN=OFF ..

> nmake

> nmake install

注: ncnn-root-dir 为你的ncnn下载位置,而第四条命令cmake 里面所有(3个)的 protobuf-root-dir 都换成读者自己的protobuf路径 ,注意是绝对路径。

成功后会在 .\\nuxnn\\build-vs2019 下生成若干文件

其中tools文件夹是我们最常用到的,里面的工具基本都集成好了

install中也包含有常用的lib、bin、include等库

四、onnx->ncnn

第二章 我们得到了 yolov5s.onnx

第三章配置好了 ncnn环境

这章我们进行模型转换

1.ncnn转换

下一步是还是用到vs2019的x64命令行,cd到 .\\ncnn\\build-vs2019\\tools\\onnx

会有onnx2ncnn.exe 应用程序,我们将yolov5s.onnx复制到目录下,然后输入

.\\onnx2ncnn yolov5s.onnx yolov5s.param yolov5s.bin

此时我们 完成ncnn 转换,得到yolov5s.param和yolov5s.bin。

题主所用的模型为6.0版本前的yolov5s.pt模型,而ncnn不支持focus结构,因此需要手工修复下focus模块。

但6.0版后官方去掉了focus,建议大家检查下是否使用6.0版本的的pt模型,Yolov5官方pt模型链接(链接为6.1版本)

使用6.0版本以上的读者即可跳转至第五章,6.0版本以下的读者我们继续处理focus结构的报错问题:

同时报错很多 Unsupported slice step,这是focus模块转换的报错

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

Unsupported slice step !

如果报下面的错误的话 ,是不是你没模型导出时没–simpliffy呢?

Unsupported slice step !

Unsupported slice step !

... ....

Unsupported slice step !

Unsupported slice step !

Shape not supported yet

2.param解释

7767517 # 文件头 魔数

75 83 # 层数量 输入输出blob数量

# 下面有75行

Input data 0 1 data 0=227 1=227 2=3

Convolution conv1 1 1 data conv1 0=64 1=3 2=1 3=2 4=0 5=1 6=1728

ReLU relu_conv1 1 1 conv1 conv1_relu_conv1 0=0.000000

Pooling pool1 1 1 conv1_relu_conv1 pool1 0=0 1=3 2=2 3=0 4=0

Convolution fire2/squeeze1x1 1 1 pool1 fire2/squeeze1x1 0=16 1=1 2=1 3=1 4=0 5=1 6=1024

...

层类型 层名字 输入blob数量 输出blob数量 输入blob名字 输出blob名字 参数字典

参数字典,每一层的意义不一样:

数据输入层 Input data 0 1 data 0=227 1=227 2=3 图像宽度×图像高度×通道数量

卷积层 Convolution ... 0=64 1=3 2=1 3=2 4=0 5=1 6=1728

0输出通道数 num_output() ; 1卷积核尺寸 kernel_size(); 2空洞卷积参数 dilation(); 3卷积步长 stride();

4卷积填充pad_size(); 5卷积偏置有无bias_term(); 6卷积核参数数量 weight_blob.data_size();

C_OUT * C_in * W_h * W_w = 64*3*3*3 = 1728

池化层 Pooling 0=0 1=3 2=2 3=0 4=0

0池化方式:最大值、均值、随机 1池化核大小 kernel_size(); 2池化核步长 stride();

3池化核填充 pad(); 4是否为全局池化 global_pooling();

激活层 ReLU 0=0.000000 下限阈值 negative_slope();

ReLU6 0=0.000000 1=6.000000 上下限

综合示例:

0=1 1=2.5 -23303=2,2.0,3.0

数组关键字 : -23300

-(-23303) - 23300 = 3 表示该参数在参数数组中的index

后面的第一个参数表示数组元素数量,2表示包含两个元素

3.实现focus模块

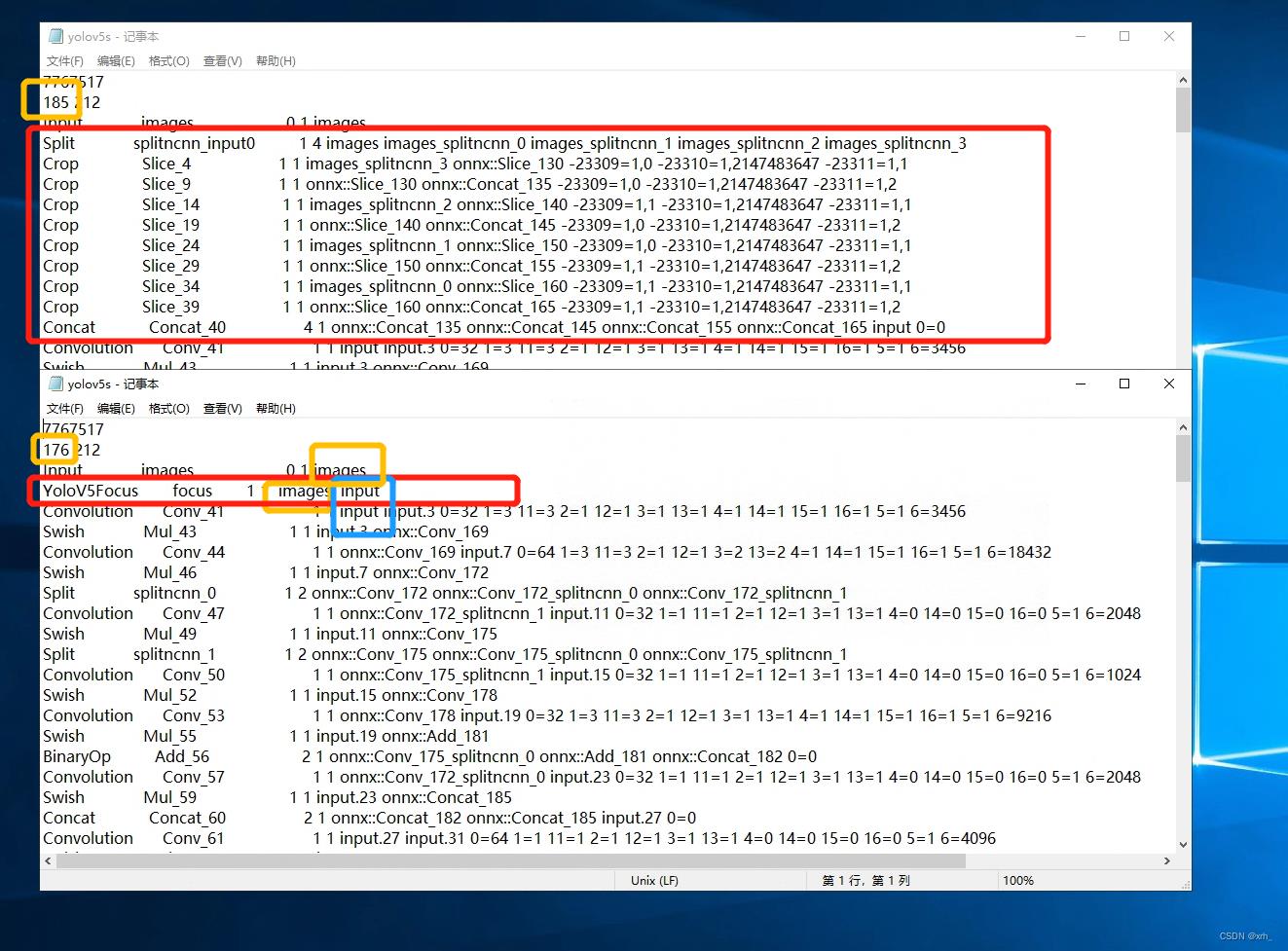

ncnn转换后我们得到yolov5s.param和yolov5s.bin

以记事本方式打开yolov5s.param

修改Split到Concat这10层,使用ncnn定义的YoloV5Focus层来替换这10层。

YoloV5Focus层的输入层顺接上一层的输出(橙色框),输出层顺接下一层的输入(蓝色框)。

param 开头第二行,layer_count 要对应修改,但 blob_count 只需确保大于等于实际数量即可。1层替换了10层,因此改为 185-10+1=176

一定要记得改这个,这里卡了我好久,当时很纳闷为什么App总是闪退。

然后,拖动到最后输出层,更改reshape的参数,将检测框修改为动态检测框。

OK,我们保存yolov5s.param后, 此时的yolov5s.param和yolov5s.bin已经可以正常使用了.

得到的bin和param根据自己需求部署到Linux/win/android/ios,如果需要部署到安卓端继续看

五、ncnn的安卓部署

nihui的教程已经写得很明白了,我们按步骤操作就好了。nihui YYDS!

ncnn-android-yolov5 github地址

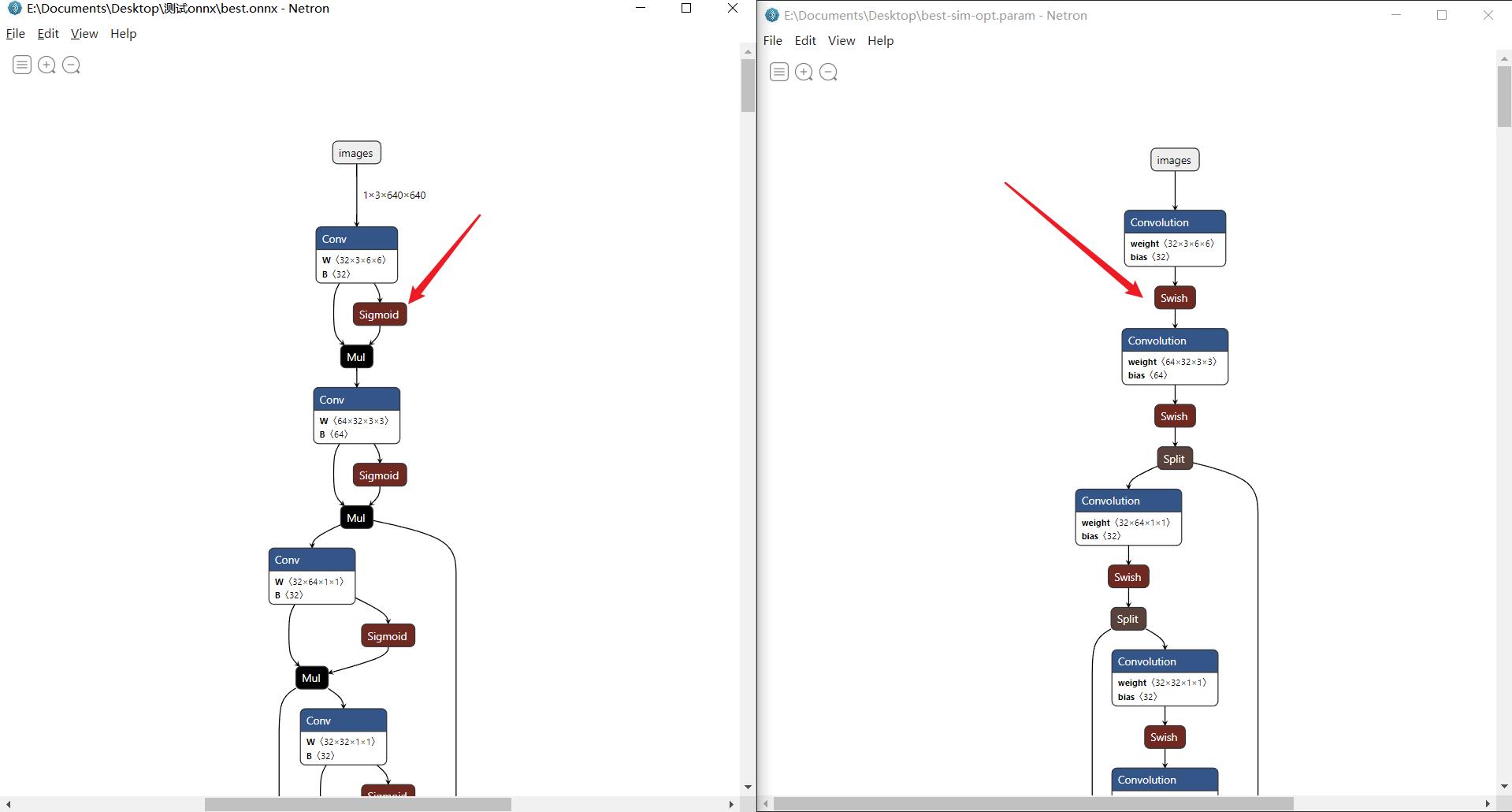

此外建议大家使用Netron查看我们的模型

OK进入正题,假设读者已经安装好Android Studio,部署好了也用了nihui大佬的工程,测试能用没问题。我们下一步是将自己的模型替换到app上。

1.模型替换

将第四章生成的bin和param放到

工程的所在目录下如 F:\\ncnn-android-yolov5\\app\\src\\main\\assets

cpp处修改param和bin的名称,与你的自己的相对应

用Netron查看模型结构,然后修改input(1处)和output(3处)

更改模型类别

最后如果你使用的是自己训练的模型,需要修改cpp下方的static const char* class_names[] ,更改为自己模型的类别。

最后可以对模型进行量化,精度不会下降多少,内存缩小了一半

cd 到ncnn的目录中 用命令器运行,与onnx转化ncnn的步骤相似

ncnnoptimize yolov5s.param yolov5s.bin yolov5s-opt.param yolov5s-opt.bin 65536

Done,Enjoy it boy!

以上是关于YOLOv5使用NCNN将模型部署到Android端教程部署自己的训练模型到Android实现静态图片检测的主要内容,如果未能解决你的问题,请参考以下文章