IDE的使用,打包spark应用提交

Posted 正义飞

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了IDE的使用,打包spark应用提交相关的知识,希望对你有一定的参考价值。

hadoop,spark,kafka交流群:224209501

标签(空格分隔): spark

1,首先启动

cd /opt/modules/idea-IC-141.178.9/

bin/idea.sh 2,导入scala插件

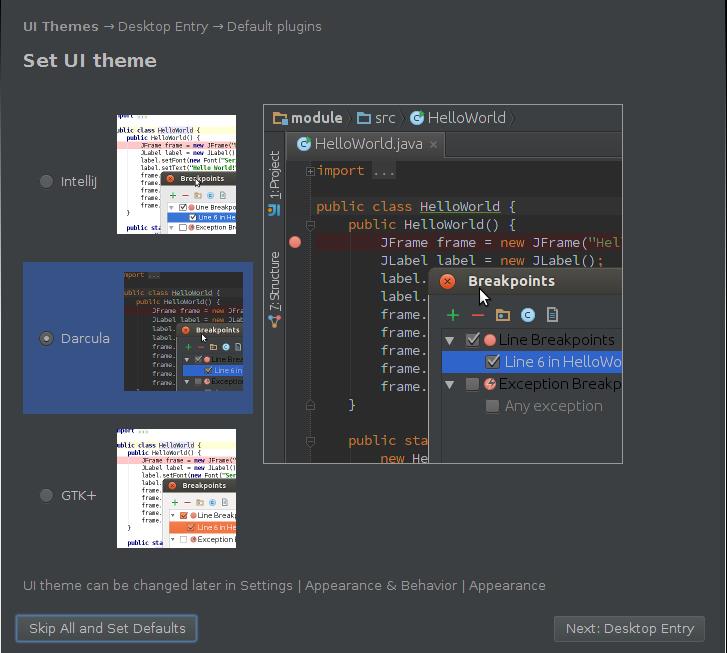

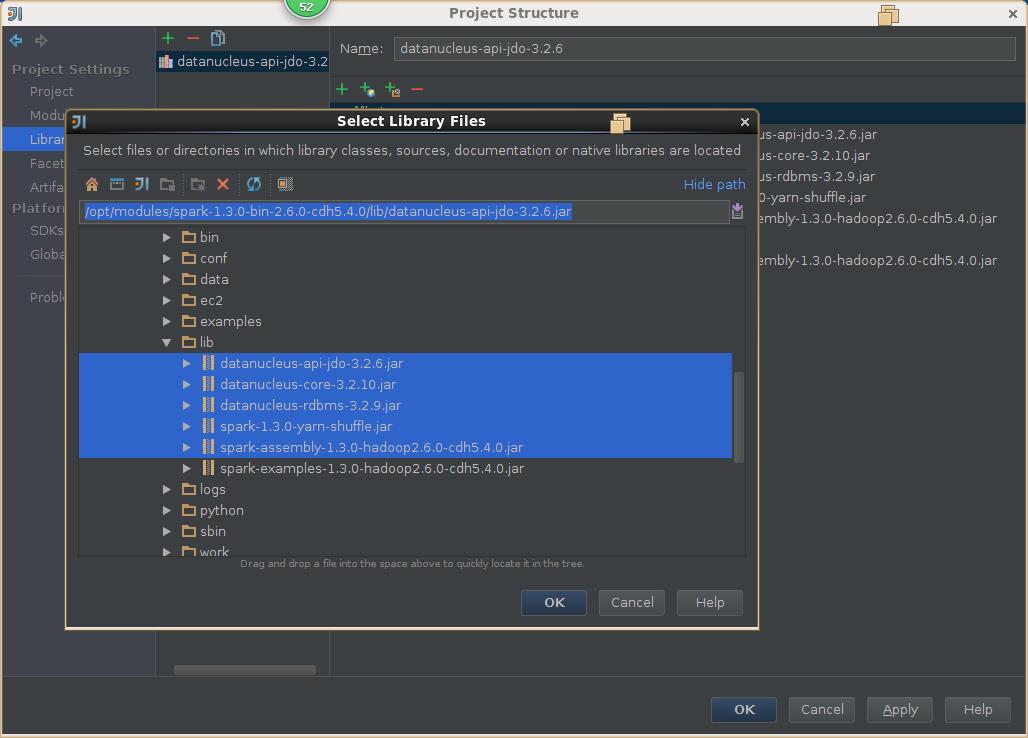

3,导入spark源码

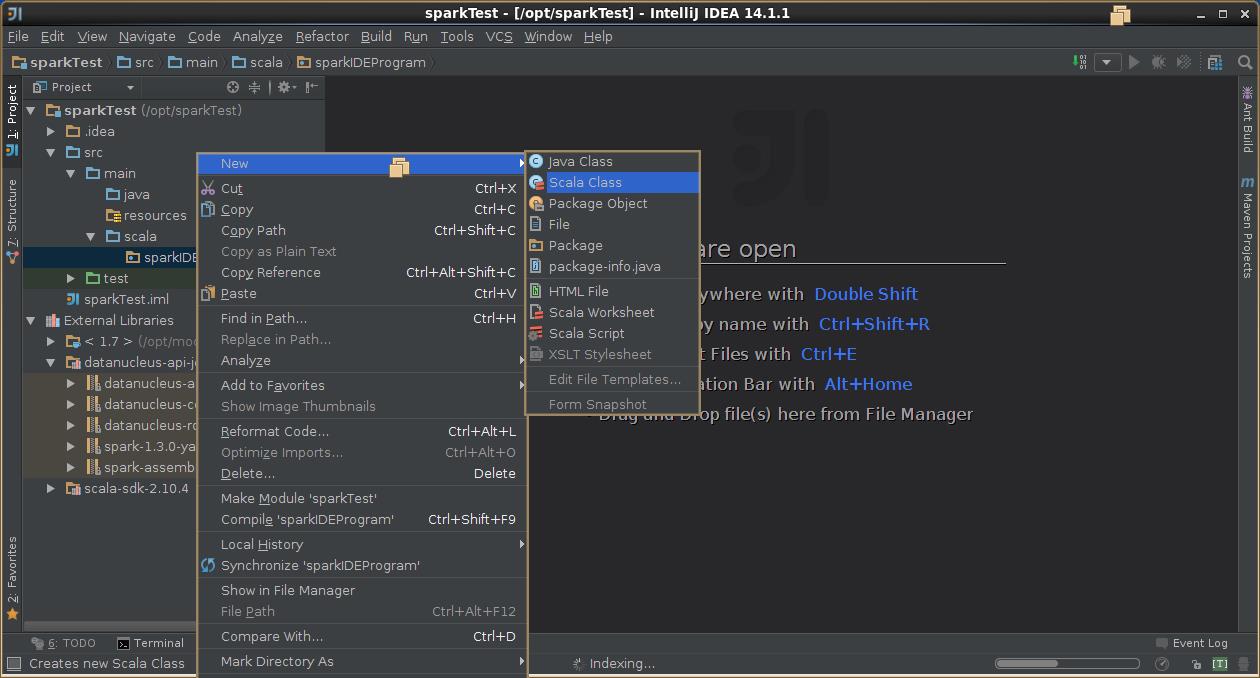

4,创建scala工程

5,导出jar包

6,示例代码

前提是

1,启动hdfs的namenode,datanode。

2,启动spark的master和slaves,本地测试无需启动。

package sparkIDEProgram

import org.apache.spark.SparkContext

import org.apache.spark.SparkConf

/**

* Created by hadoop on 1/1/16.

*/

object SimpleApp

def main(args: Array[String])

val logFile = "hdfs://spark.learn.com:8020/user/hadoop/spark/input/wc.input" // Should be some file on your system

val conf = new SparkConf()

.setAppName("Simple Application")

.setMaster("spark://spark.learn.com:7077")//本地测试需要修改为local

val sc = new SparkContext(conf)

val logData = sc.textFile(logFile, 2).cache()

val numAs = logData.filter(line => line.contains("a")).count()

val numBs = logData.filter(line => line.contains("b")).count()

println("Lines with a: %s, Lines with b: %s".format(numAs, numBs))

sc.stop()

7,提交打包好的应用

bin/spark-submit /opt/sparkTest/sparkTest.jar

以上是关于IDE的使用,打包spark应用提交的主要内容,如果未能解决你的问题,请参考以下文章