目标跟踪|单目标跟踪指标

Posted rrr2

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了目标跟踪|单目标跟踪指标相关的知识,希望对你有一定的参考价值。

VOT

VOT认为,数据集只有规模大是完全不行的,一个可靠的数据集应该测试出tracker在不同条件下的表现

VOT提出,应该对每一个序列都标注出该序列的视觉属性(visual attributes),以对应上述的不同条件,VOT2013共提出了六种视觉属性:

相机移动(camera motion,即抖动模糊)

光照变化(illumination change)

目标尺寸变化(object size change)

目标动作变化(object motion change,和相机抖动表现形式类似,都是模糊)

未退化(non-degraded)

在VOT提出之前,比较流行的评价系统是让tracker在序列的第一帧进行初始化,之后让tracker一直跑到最后一帧。然而tracker可能会因为其中一两个因素导致其在开始的某些帧就跟丢(fail),所以最终评价系统只利用了序列的很小一部分,造成浪费。而VOT提出,评价系统应该在tracker跟丢的时候检测到错误(failure),并在failure发生的5帧之后对tracker重新初始化(reinitialize),这样可以充分利用数据集。之所以是5帧而不是立即初始化,是因为failure之后立即初始化很可能再次跟踪失败,又因为视频中的遮挡一般不会超过5帧,所以会有这样的设定。

VOT的一个特色机制,即重启(reset/reinitialize)。但重启之后的一部分帧是不能用于评价的,这些帧被称作burn-in period,大量实验结果表明,burn-in period大约为初始化之后(包括第一帧的初始化和所有重启)的10帧。

Accuracy(A)

Accuracy用来评价tracker跟踪目标的准确度,数值越大,准确度越高。

某序列第t帧的accuracy定义为:每一帧的IOU值

平均精度为在所有有效帧的平均

Robustness®

Robustness用来评价tracker跟踪目标的稳定性,数值越大,稳定性越差。

F为在重复测试N_rep中失效的次数

AR rank(综合 A R)

将tracker在不同属性序列上的表现按照accuracy(A)和robustness(R)分别进行排名,再进行平均,得到该tracker的综合排名,依据这个综合排名的数字大小对tracker进行排序得出最后排名。这个排名叫做AR rank。

具体操作为:首先让tracker在同一属性的序列下测试,对得到的数据(average accuracy/average robustness)进行加权平均,每个数据的权重为对应序列的长度,由此得到单个tracker在该属性序列上的数据,然后对不同tracker在该属性序列下进行排名。得到单个tracker在所有属性序列下的排名后,求其平均数(不加权)得到AR rank。

EAO(Expected Average Overlap)

VOT2015提出,基于AR rank的评价方式没有充分利用accuracy和robustness的原始数据(raw data),所以创造了一个新的评价指标——EAO(Expected Average Overlap)。正如字面意思,这个评价指标只针对基于overlap定义的accuracy。

EAO曲线,对于不同序列长度的序列测试,横轴为序列长度,纵轴为A,

EFO(不同硬件速度对比)

EFO(Equivalent Filter Operations )是VOT2014提出来的一个衡量tracking速度的新单位,在利用vot-toolkit评价tracker之前,先会测量在一个600600的灰度图像上用3030最大值滤波器进行滤波的时间,以此得出一个基准单位,再以这个基础单位衡量tracker的速度,以此减少硬件平台和编程语言等外在因素对tracker速度的影响。

归一化的精确度(Norm. Prec)

来源——TrackingNet

考虑到Ground Truth框的尺度大小,将Precision 进行归一化,得到Norm. Prec,它的取值在[0, 0.5] 之间。即判断预测框与Ground Truth框中心点的欧氏距离与Ground Truth框斜边的比例。

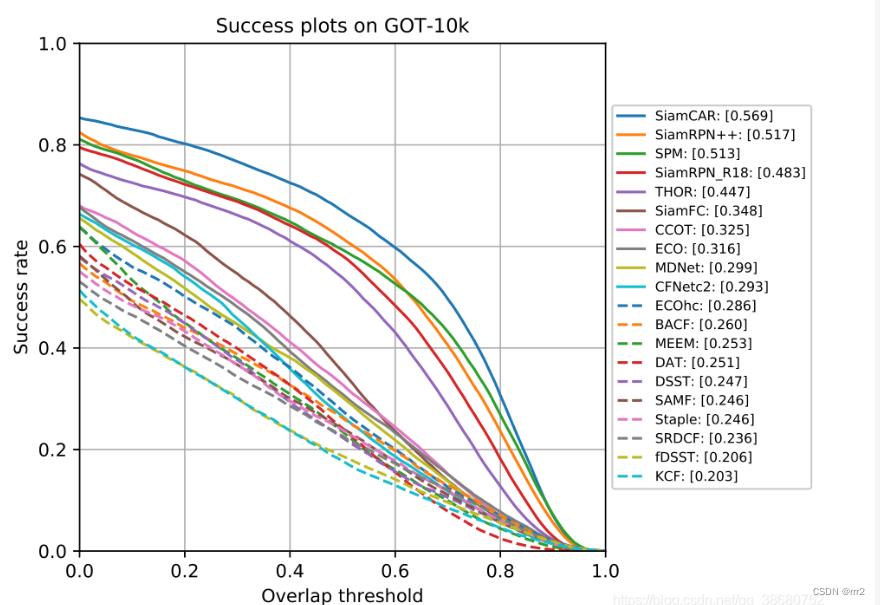

成功率 Success Rate/IOU Rate/AOS

来源——OTB2013

成功率计算是计算预测框与Ground Truth的真值框的区域内像素的交并比,即红色框与蓝色斜边区域的比值。公式如上图的S。

通常我们会看到论文中有一个AUC(Area under curve)分数,这个分数实际上算的是成功率曲线下的面积,达成的效果就相当于考虑到了不同阈值下的成功率分数。有的论文也会直接指定阈值(如0.5)。其实当成功率曲线足够光滑,取0.5对应的成功率分数和计算成功率的AUC分数是一样的【中值定理】

ref

https://blog.csdn.net/Dr_destiny/article/details/80108255

多目标跟踪 | 评测指标

前言

多目标跟踪器的性能需要某些指标来进行度量,目前使用比较广泛的评测指标主要有 Bernardin 等人定义的 CLEAR MOT 指标、Ristani 等人定义的 ID scores 指标以及最新的 Luiten 等人定义的HOTA 指标。

目录

一、基础的评测指标

1、ID Switches (ID Sw.):被跟踪目标身份发生错误地更改时被称为身份跳变。在对视频序列的跟踪过程当中,ID Sw.表示所有跟踪目标身份交换的次数。

2、Frames Per Second (FPS):多目标跟踪器的跟踪速度。

3、False Positives (FP):在视频序列中不能与 真实轨迹的边界框 相匹配的 假设边界框 被称为假阳性;即本来是假的,预测认为是真的。FP 表示整个视频序列中假阳性的数量。

4、False Negatives (FN):在视频序列中不能与 假设边界框 相匹配的 真实轨迹的边界框 被称为假阴性;即本来是真的,预测认为是假的。FN 表示整个视频序列中假阴性的数量。

5、Mostly Tracked tracklets (MT):在跟踪过程中各个目标至少有 80%的视频帧都能被正确地跟踪的跟踪轨迹数量。

6、Mostly Lost tracklets (ML):在跟踪过程中各个目标至多有 20%的视频帧能被正确地跟踪的跟踪轨迹数量。

7、Fragments (Frag):真实跟踪轨迹由于某种原因发生中断并在后来又继续被准确跟踪上被称为跟踪碎片。Frag 表示整个视频序列中碎片的总数。

以上 7 种评测指标主要度量多目标跟踪器的基础性能,其中加粗的比较常用;为了进一步评判多目标跟踪器的综合性能,出现了其他指标。

二、MOTA 和 MOTP

CLEAR MOT 指标提出了 多目标跟踪精度MOTA 和 多目标跟踪准确度MOTP 两个综合性的指标,这两个指标能够衡量多目标跟踪器在整体上的性能好坏。

2.1 MOTA:多目标跟踪精度 。

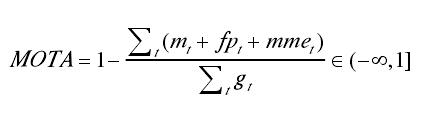

MOTA除了误报(FP)、丢失目标(FN)、ID异常切换(ID Sw.)情况以外的正确预测样本占所有样本的比率,衡量了跟踪器在检测目标和保持轨迹时的性能,与目标位置的估计精度无关。多目标跟踪准确度的分数 MOTA如下计算:

mt表示整个视频序列中假阳性的数量(FN),fpt表示整个视频序列中假阴性的数量(FP),mme t表示跟踪过程中身份交换的数量(ID Sw.),gt表示整个视频序列当中真实目标的数量。

这里 MOTA的分数可能为负数,因为假阴性、假阳性和身份跳变的数量可能会大于视频序列中真实目标的数量。

2.2 MOTP: 多目标跟踪准确度

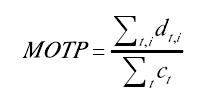

MOTP默认检测框重合度阈值下正确预测的目标与预测目标总数之比,衡量检测器的定位精度。.多目标跟踪精确度的分数 MOTP 如下计算:

ct 表示为在第 t 帧时候总共匹配的数量,d 表示假设边界框与真实边界框之间的距离值。

三、IDP、IDR、IDF

为了判断多目标跟踪器是否能够长时间地对某个目标进行准确地跟踪,ID scores 指标引入了 IDF (Identification F1) , IDP (Identification Precision) 和 IDR (Identification Recall)指标并添加到多目标跟踪中,以衡量跟踪器的身份维持能力。

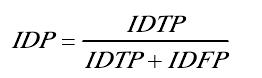

3.1 IDP:识别精确度

整体评价跟踪器的好坏,识别精确度 IDP 的分数如下进行计算:

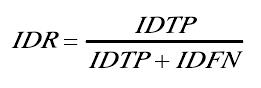

3.2 IDR:识别召回率

它是当IDF1-score最高时正确预测的目标数与真实目标数之比,识别召回率 IDR 的分数如下进行计算:

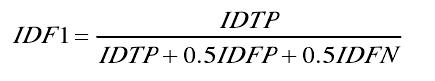

3.3 IDF1:平均数比率

IDF1是指正确的目标检测数与真实数和计算检测数和的平均数比率,这里, IDF1的分数如下进行计算:

上述公式中,IDTP 可以看作是在整个视频中检测目标被正确分配的数量,IDFN 在整个视频中检测目标被漏分配的数量,IDFP 在整个视频中检测目标被错误分配的数量。

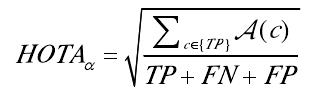

四、HOTA 更高维跟踪精度

基于多目标跟踪准确度(MOTA)的基础上,HOTA 指标引入了更高维跟踪精度指标,能够更加全面、更加均衡地衡量多目标跟踪器的性能。

HOTA:更高维跟踪精度;HOTA的分数计算过程由多个部分组成,更加重视目标检测和数据关联精度的平均性衡量。主要计算如下:

A表示数据关联分数。TP 则表示在整个视频中检测目标被正确跟踪的数量。

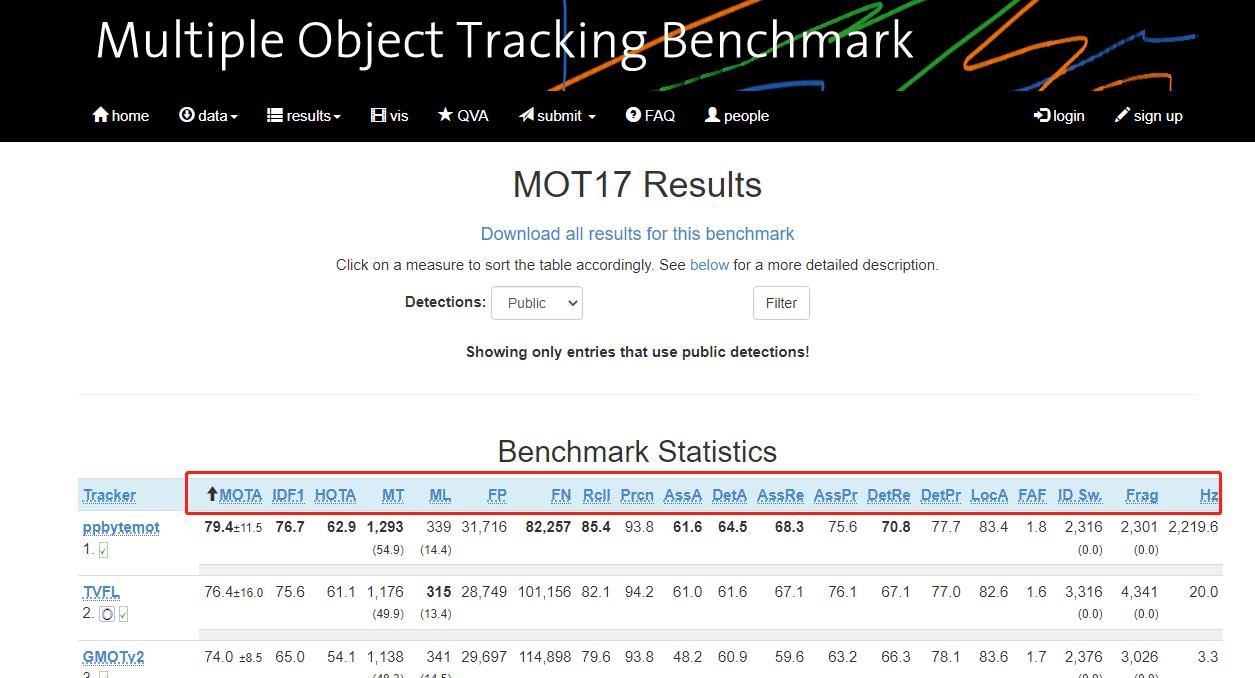

五、MOT Challenge 多目标跟踪

官网地址:

MOT ChallengeMultiple Object Tracking: Datasets, Benchmarks, Challenges and more. https://motchallenge.net/这里有多目标跟踪的竞赛,可以看看有哪些评价指标,以及评价指标是如何计算的。这里有多个数据集,比如MOT2017。

https://motchallenge.net/这里有多目标跟踪的竞赛,可以看看有哪些评价指标,以及评价指标是如何计算的。这里有多个数据集,比如MOT2017。

MOT Challenge 是应用在多目标跟踪中最常见的数据集,它专门用于行人跟踪的场景,这些数据集目前已公开提供。对于每个数据集都提供了训练数据和测试数据,其中训练数据提供了目标检测结果和真实的跟踪结果,而测试数据只提供目标检测的结果。截至目前,MOT Challenge 数据集包含了MOT15,MOT16/MOT17,MOT20等子数据集。

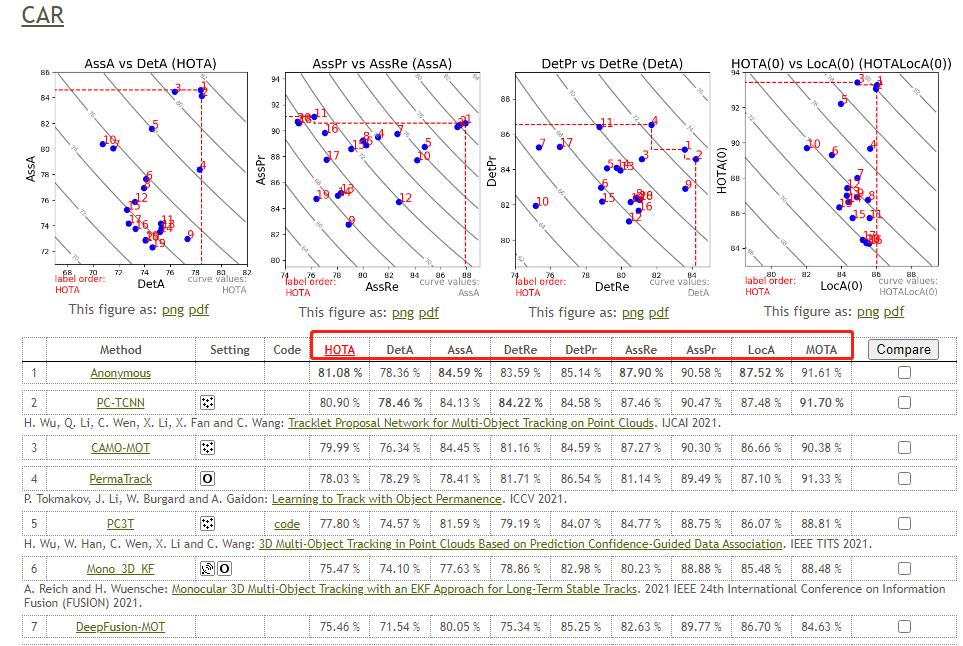

六、kitti 多目标跟踪

官网地址:

The KITTI Vision Benchmark Suite http://www.cvlibs.net/datasets/kitti/eval_tracking.php这里也有多目标跟踪的竞赛,可以看看有哪些评价指标,以及评价指标是如何计算的。

http://www.cvlibs.net/datasets/kitti/eval_tracking.php这里也有多目标跟踪的竞赛,可以看看有哪些评价指标,以及评价指标是如何计算的。

七、方案选择

7.1 DeepSort

DeepSORT(Deep Cosine Metric Learning SORT) 扩展了原有的SORT(Simple Online and Realtime Tracking)算法,增加了一个CNN模型用于在检测器限定的人体部分图像中提取特征,在深度外观描述的基础上整合外观信息,将检出的目标分配和更新到已有的对应轨迹上即进行一个ReID重识别任务。DeepSORT所需的检测框可以由任意一个检测器来生成,然后读入保存的检测结果和视频图片即可进行跟踪预测。

7.2 JDE

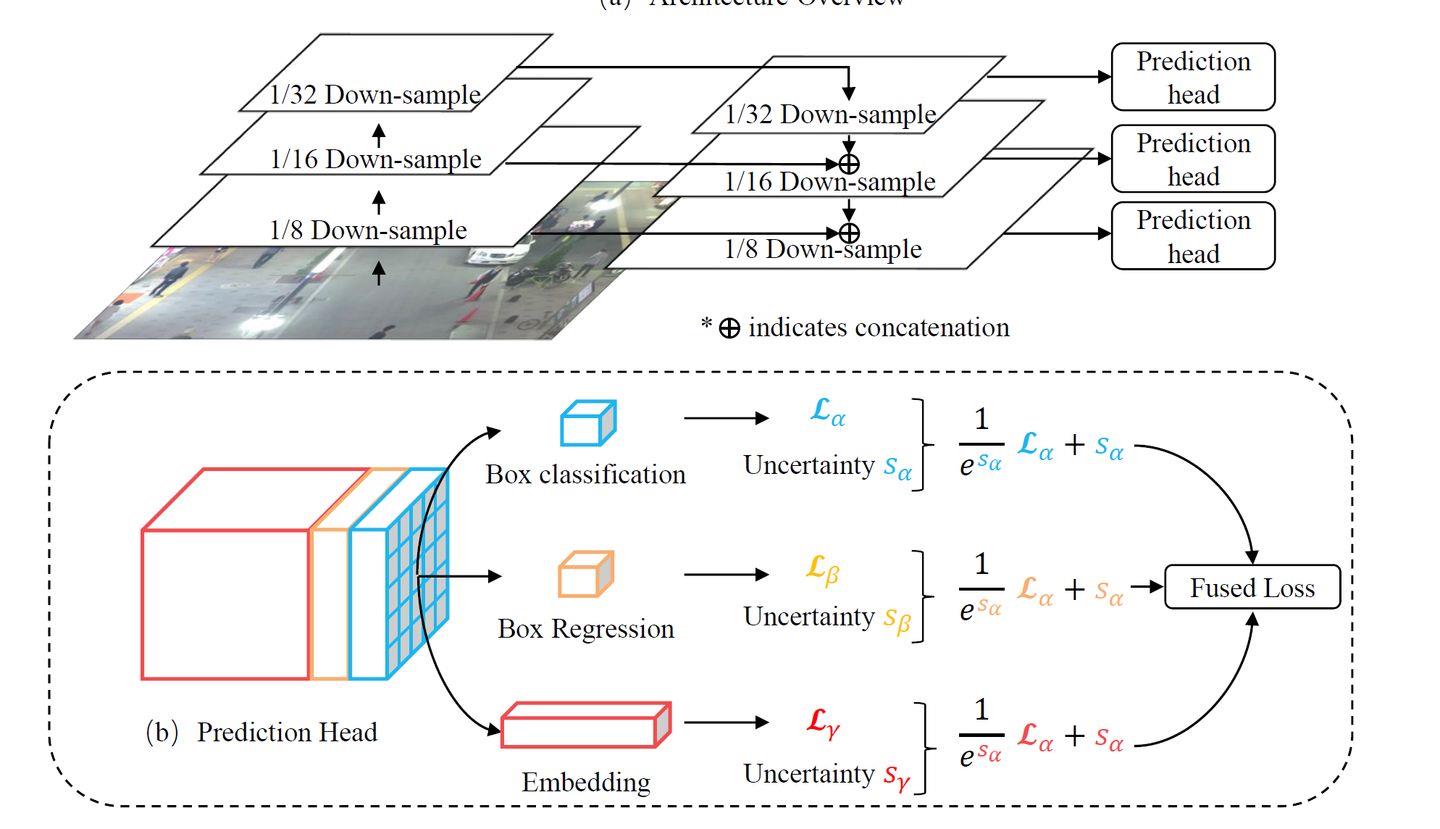

JDE(Joint Detection and Embedding)是在一个单一的共享神经网络中同时学习目标检测任务和embedding任务,并同时输出检测结果和对应的外观embedding匹配的算法。JDE原论文是基于Anchor Base的YOLOv3检测器新增加一个ReID分支学习embedding,训练过程被构建为一个多任务联合学习问题,兼顾精度和速度。

7.3 FairMOT

anchor-based的检测框架中存在anchor和特征的不对齐问题,所以这方面不如anchor-free框架。FairMOT方法检测选用了anchor-free的CenterNet算法,克服了Anchor-Based的检测框架中anchor和特征不对齐问题,深浅层特征融合使得检测和ReID任务各自获得所需要的特征,并且使用低维度ReID特征,提出了一种由两个同质分支组成的简单baseline来预测像素级目标得分和ReID特征,实现了两个任务之间的公平性,并获得了更高水平的实时多目标跟踪精度。

FairMOT属于JDE(Jointly learns the Detector and Embedding model )的一种。实验证明了现有的JDE方法存在一些不足,FairMOT根据这些不足进行了相关的改进。

综合速度和精度,本案例选用FairMot模型实现车辆跟踪计数。

参考文献:面向复杂场景的多目标跟踪算法研究.胡玉杰.电子科技大学.

参考链接:https://aistudio.baidu.com/aistudio/projectdetail/2503924?channelType=0&channel=0

希望对你有帮助。

以上是关于目标跟踪|单目标跟踪指标的主要内容,如果未能解决你的问题,请参考以下文章