机器学习:基于逻辑回归对超市销售活动预测分析

Posted i阿极

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习:基于逻辑回归对超市销售活动预测分析相关的知识,希望对你有一定的参考价值。

系列文章目录

作者:i阿极

作者简介:Python领域新星作者:博主个人首页

😊😊😊如果觉得文章不错或能帮助到你学习,可以点赞👍收藏📁评论📒+关注哦!👍👍👍

📜📜📜如果有小伙伴需要数据集和学习交流,文章下方有交流学习区!一起学习进步!💪

文章目录

1、实验背景

一家超级市场正在计划年终促销。他们想推出一个新的优惠——黄金会员资格,所有购买的产品都有20%的折扣,只需499美元,其他日子里是999美元。该优惠政策将只对现有客户有效,目前他们正计划通过电话进行宣传。

管理层认为,降低活动成本的最好方法是建立一个预测模型,首先将可能购买该优惠的客户进行分类。

2、实验数据说明

数据信息是在去年的活动中收集的,以下为数据描述:

| 字段 | 说明 |

|---|---|

| Id | 每个客户的独特ID |

| Year_Birth | 客户的年龄 |

| Education | 顾客的教育水平 |

| Marital_Status | 客户的婚姻状况 |

| Income | 客户的家庭年收入 |

| Kidhome | 客户家庭中小孩的数量 |

| Teenhome | 客户家庭中的青少年人数 |

| Dt_Customer | 客户在公司注册的日期 |

| Recency | 自上次购买以来的天数 |

| MntWines | 在过去的两年中,购买葡萄酒产品的金额 |

| MntFruits | 在过去的2年里,购买水果产品的消费金额 |

| MntMeatProducts | 在过去的两年中,花在肉类产品上的金额 |

| MntFishProducts | 在过去的两年中,花在鱼类产品上的金额 |

| MntSweetProducts | 在过去两年中,花在甜食产品上的金额 |

| MntGoldProds | 在过去的两年中,购买黄金产品的消费金额 |

| NumDealsPurchases | 使用折扣购买的数量 |

| NumWebPurchases | 通过公司网站购买的数量 |

| NumCatalogPurchases | 使用目录购买的数量(购买货物通过邮件发送)。 |

| NumStorePurchases | 直接在商店购买的数量 |

| NumWebVisitsMonth | 上个月访问公司网站的次数 |

| Response | 目标变量 - 如果客户在上一次活动中接受了报价,则为1,否则为0 |

| Complain | 如果客户在过去两年中投诉,则为1 |

3、实验环境

Python 3.9

Anaconda

Jupyter Notebook

4、实验内容

使用逻辑回归对超市销售活动预测分析

5、实验步骤

5.1导入数据

import pandas as pd

import numpy as np

data = pd.read_csv("/home/mw/superstore_data.csv")

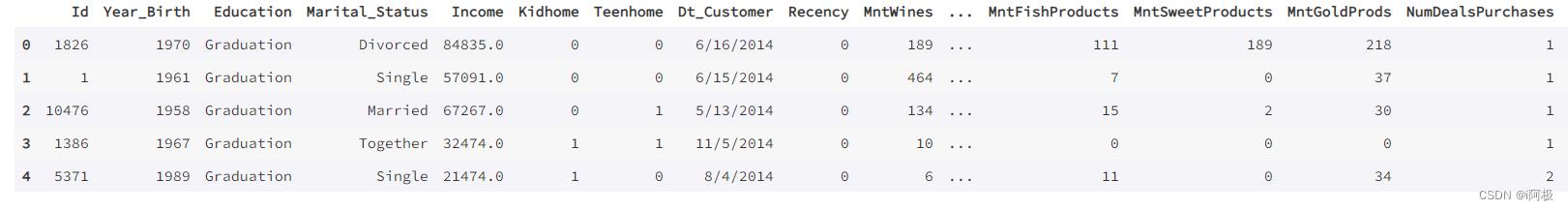

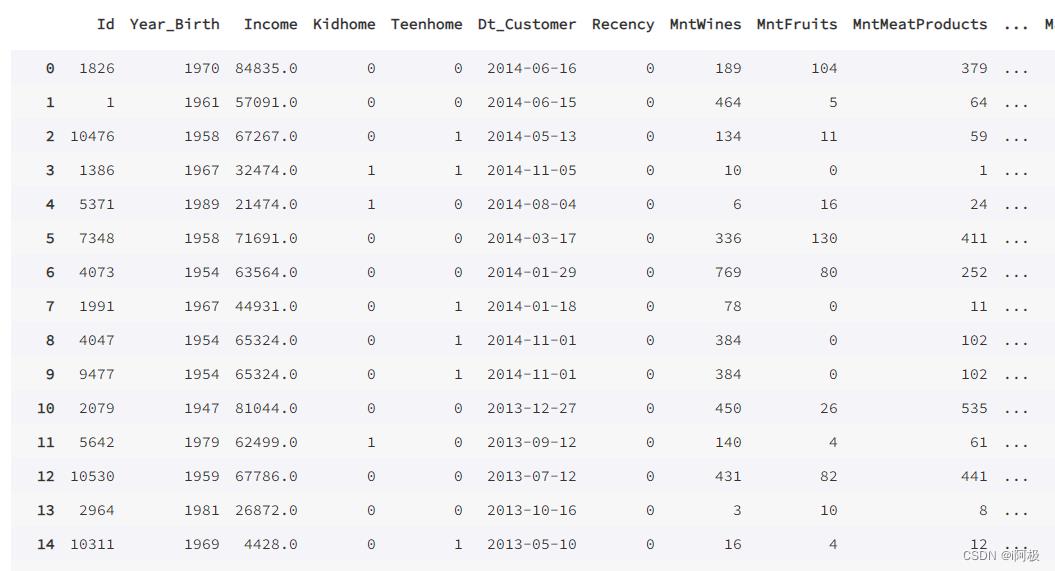

data.head()

5.2数据探索

查看数据数量

data.shape

有2240行,22个特征值

查看基本信息

data.info()

发现Income列有缺失值,接下来需要对缺失值进行处理

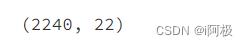

观察Income列缺失的行

income_missing = data[data.Income.isnull()]

income_missing

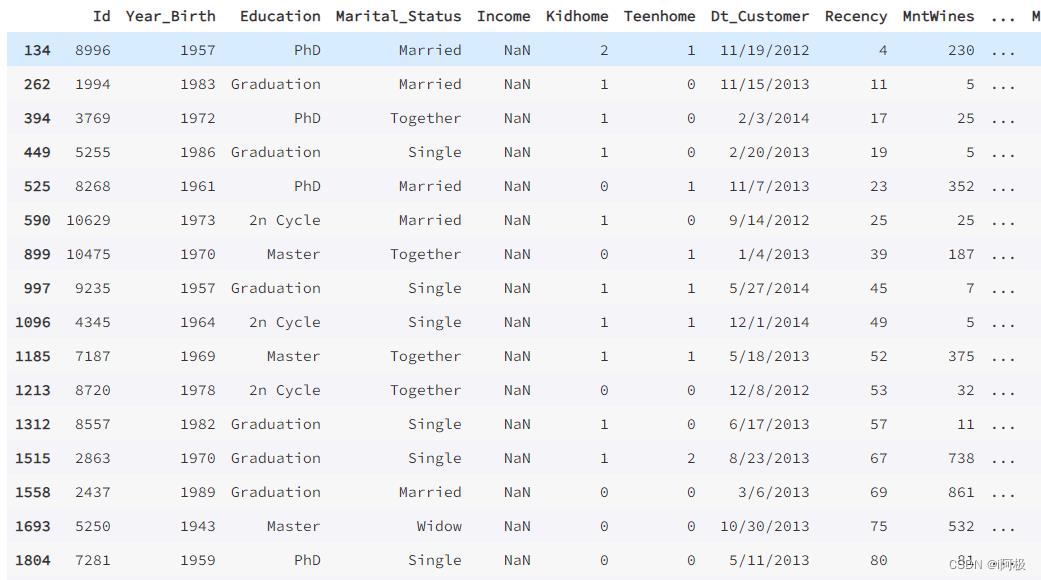

从他们的Year_Birth中发现,很多都是1960年之前的人,很有可能退休了(2023-65=1958)

before = income_missing[income_missing.Year_Birth < 1961]

after = income_missing[income_missing.Year_Birth > 1961]

import matplotlib.pyplot as plt

plt.bar(['before 1961','after 1961'],[len(before),len(after)])

plt.show()

对于可能退休的人(小于1961)我们用0填充,其他的用平均值

data.loc[(data['Year_Birth'] < 1961) & (data['Income'].isnull())] =data.loc[(data['Year_Birth'] < 1961) & (data['Income'].isnull())].fillna(0)

data.Income = data.Income.fillna(data.Income.mean())

data.isnull().sum()

对于可能退休的人(小于1961)我们用0填充,其他的用平均值,已经没有缺失值。

5.3处理非数值型变量

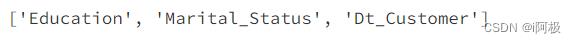

查看类型为object的列

non_num_cols = [cols for cols in data.columns if data[cols].dtype == 'object']

non_num_cols

首先我们将Dt_Customer转化为日期格式

data['Dt_Customer'] = pd.to_datetime(data['Dt_Customer'])

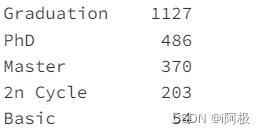

处理类别变量,先来看看有几种类别

data.Education.value_counts()

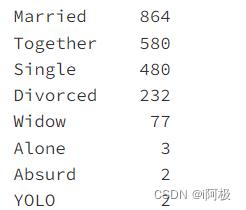

data.Marital_Status.value_counts()

因为alone、YOLO、Abusurd样本数很少,所以本次分析将 alone、YOLO、Abusurd 统一归为 Single。

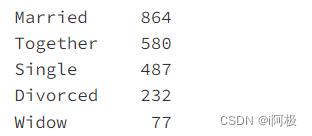

data.Marital_Status = data.Marital_Status.replace(['Alone','YOLO','Absurd'],'Single')

data.Marital_Status.value_counts()

Marital_Status = pd.get_dummies(data.Marital_Status,prefix='Marital_Status')

data = data.drop('Marital_Status',axis=1).join(Marital_Status)

同理应用于教育状况

Education = pd.get_dummies(data.Education,prefix='Education')

data = data.drop('Education',axis=1).join(Education)

data

再来看看处理之后的特征值

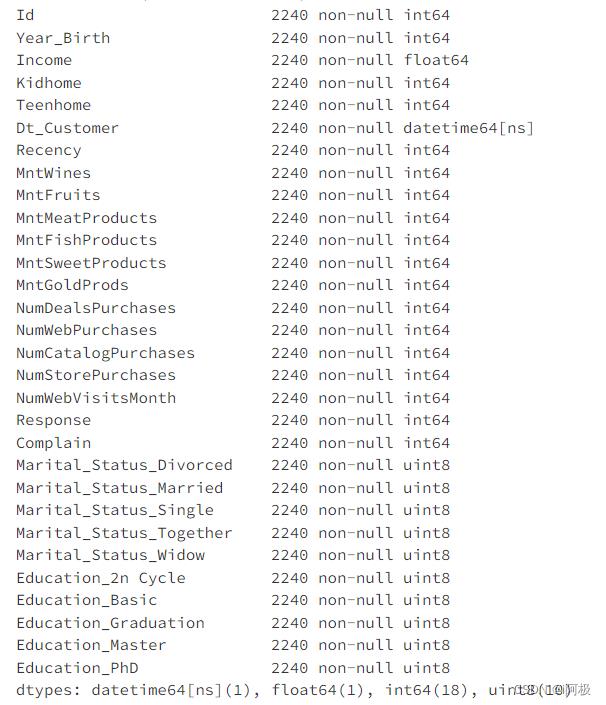

data.info()

5.4构造模型

划分训练集和测试集

from sklearn.model_selection import train_test_split

y = data.Response #目标变量

X = data.drop('Response',axis=1)

train_x,val_x,train_y,val_y = train_test_split(X,y,train_size=0.8,test_size=0.2,random_state=0)

用统计的方法看看相关性

cor = data.corr()

features = cor[(cor['Response'] < -0.1) | (cor['Response'] > 0.1)] .index.drop('Response')

模型搭建

from sklearn.linear_model import LogisticRegression

lr = LogisticRegression()

lr.fit(train_x[features],train_y)

验证

prey = lr.predict(val_x[features])

from sklearn.metrics import accuracy_score

accuracy_score(val_y,prey)

开始预测

predictions = lr.predict(data[features])

results = pd.DataFrame(data='Id':data.Id,'Response':predictions)

results[:15]

📢文章下方有交流学习区!一起学习进步!💪💪💪

📢创作不易,如果觉得文章不错,可以点赞👍收藏📁评论📒

📢你的支持和鼓励是我创作的动力❗❗❗

机器学习:基于逻辑回归对某银行客户违约预测分析

机器学习:基于逻辑回归对某银行客户违约预测分析

文章目录

一、实验目的

1.理解逻辑回归原理

2.掌握scikit-learn操作逻辑回归方法

二、实验原理

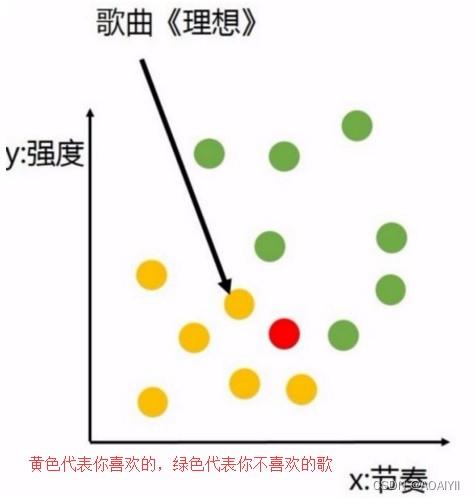

机器学习是博大精深的,除了我们上一次说的线性回归,还有一类重要的回归就是逻辑回归。逻辑回归其实用于二分分类问题,用于判断一个离散性的特征得到的标签类型的概率。举个例子,你是否喜欢一首歌是通过很多这个歌的特征(如节奏、强度等)来判断的,那么我们的数据集就是各种歌的特征,而返回的结果则是一个非1即0,不是喜欢就是不喜欢的结果:

而机器学习可以做到什么呢?它会通过模型形成一个决策面,在你喜欢和不喜欢的歌之间划出一条分界线,就像这样:

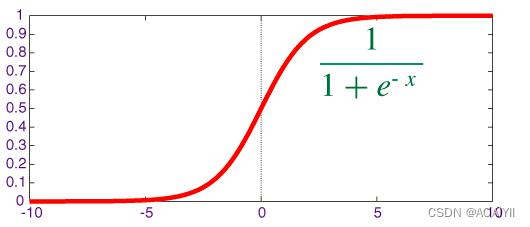

用线性回归的拟合线已经无法很好的表示结果了,这时候就是使用逻辑回归来分类的时候了,而对于Logistic Regression来说,其思想也是基于线性回归(Logistic Regression属于广义线性回归模型)。其公式如下:

其中,

被称作sigmoid函数,我们可以看到,Logistic Regression算法是将线性函数的结果映射到了sigmoid函数中。sigmoid的函数图形如下:

我们可以看到,sigmoid的函数输出是介于(0,1)之间的,中间值是0.5,于是之前的公式 hθ(x) 的含义就很好理解了,因为 hθ(x) 输出是介于(0,1)之间,也就表明了数据属于某一类别的概率,例如 :

hθ(x)hθ(x)<0.5 则说明当前数据属于A类;

hθ(x)hθ(x)>0.5 则说明当前数据属于B类。

所以我们可以将sigmoid函数看成样本数据的概率密度函数

三、实验环境

Python 3.6.1以上

Jupyter

四、实验内容

根据逻辑回归,分析银行违约客户的各项特征,推测某一客户违约的情况

五、实验步骤

1.逻辑回归

逻辑回归用于二分分类问题,回归是一种极易理解的模型,就相当于y=f(x),表明自变量x与因变量y的关系。最常见问题有如医生治病时的望、闻、问、切,之后判定病人是否生病或生了什么病,其中的望闻问切就是获取自变量x,即特征数据,判断是否生病就相当于获取因变量y,即预测分类。

2.业务理解

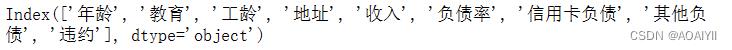

某银行违约客户信息表如下:(这里只展示了部分数据)我们通过银行客户资料违约情况表来做逻辑回归分析,其中的年龄、教育、工龄、地址、收入、 负债率、信用卡负债、其他负债就是获取自变量x,即特征数据,判断是否违约就相当于获取因变量y,即预测分类。

3.读取数据

1.编写代码,读取数据

import numpy as np

import pandas as pd

data = pd.read_excel(r'D:\\CSDN\\数据分析\\逻辑回归\\loandata.xls')

data.head()

4.数据理解

1.查看数据结构

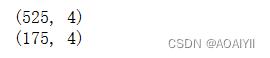

data.shape

说明:loandata.xls数据位700行9列

2.查看数据列名称

data.columns

说明:loandata.xls中列名称为:‘年龄’‘教育’‘工龄’‘地址’‘收入’‘负债率’‘信用卡负债’‘其他负债’’违约‘

5.数据准备

数据准备就是获得特征数据和预测分类

1.删除’违约‘这一列数据得到特征数据

X_Data = data.drop(['违约'],axis = 1)

X_Data.head()

2.获取’违约‘这列数据得到预测分类

y_data = np.ravel(data[['违约']])

y_data[0:5]

6.逻辑回归模型训练

1.创建新的特征矩阵

X2_data = data.drop(['年龄','教育','收入','其他负债','违约'],axis=1)

X2_data.head()

2.建立训练数据和测试数据

-

train_test_split是交叉验证中常用的函数,功能是从样本中随机的按比例选取训练数据(train)和测试数据(test)

-

第1个参数:所要划分的样本特征

-

第2个参数:所要划分的样本标签

-

random_state:它的用途是在随机划分训练集和测试集时候,划分的结果并不是那么随机,也即,确定下来random_state是某个值后,重复调用这个函数,划分结果是确定的

from sklearn.model_selection import train_test_split

X_train,X_test,y_train,y_test = train_test_split(X2_data,y_data,random_state=1)

print(X_train.shape)

print(X_test.shape)

3.进行逻辑训练

#导入逻辑回归包

from sklearn.linear_model import LogisticRegression

# 创建模型:逻辑回归

lr = LogisticRegression()

#训练模型

lr.fit(X_train,y_train)

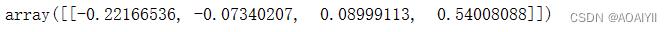

4.查看训练模型参数

lr.coef_

5.查看截距

#训练模型截距

lr.intercept_

6.预测数据

使用模型的predict方法对划分的X测试数据可以进行预测得值“违约”情况

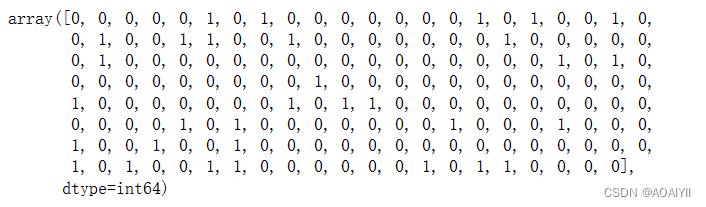

lr.predict(X_test)

7.模型评价

1.我们使用“准确率"来评估模型:

#模型评价的平均正确率

lr.score(X_test,y_test)

得到的结果准确率为0.834

总结

逻辑回归用于二分分类问题,回归是一种极易理解的模型,就相当于y=f(x),表明自变量x与因变量y的关系。最常见问题有如医生治病时的望、闻、问、切,之后判定病人是否生病或生了什么病,其中的望闻问切就是获取自变量x,即特征数据,判断是否生病就相当于获取因变量y,即预测分类。

以上是关于机器学习:基于逻辑回归对超市销售活动预测分析的主要内容,如果未能解决你的问题,请参考以下文章