Testin云测试的券商测试服务怎么样?谁了解来说说

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Testin云测试的券商测试服务怎么样?谁了解来说说相关的知识,希望对你有一定的参考价值。

体验过,非常不错,有专门的证券行业解决方案,这是其他家都不具备的。近年来,随着券商的各类业务系统功能日趋增加,系统模块越来越多,功能趋于完善,势必导致传统以手工测试为主的测试体系越来越难以满足日益增长的业务模块的测试需求。采用Testin测试管理自动化平台+专业软件测试专家的模式,在确保总体系统能力稳定性的前提下,构建高效高覆盖的自动化回归测试和验收测试能力,实现回归测试工作与验收测试工作的一体化和自动化,从而大幅提升保障测试准确性,降低测试成本。

有不清楚的,欢迎随时追问 参考技术A 以我在职的国内某Top10券商的为例,我们在IT建设投入名列行业前茅,有多个App端产品以及PC端系统,IT建设在国内券商一直被视为标杆之一,且建立了较为完善的测试体系。但在实际测试工作的进行中,存在测试工作以手工为主,测试人效偏低的情况。同时由于产品用户数量大,在产品迭代上线后,会经常收到关于产品闪退、界面展示不全等兼容性问题。为了全面提升测试工作效率并尽早发现产品兼容问题,券商引入Testin云测证券行业智能解决方案,结合自身的实际情况,针对其自身问题点从自动化测试平台建设、测试人员加入、兼容测试方案等多个方面进行升级。

从应用证券行业智能解决方案的实际效果来看,彻底解决了自动化工具和懂券商业务的专业测试人员的问题,实现了功能回归自动化测试的有序进行。覆盖测试用例近7000个,总脚本数超过2000个,脚本支持跨双平台(android+ios)执行,自动化目标覆盖率60%以上。彻底解决了兼容性的问题,实现了600款安卓机型、70款苹果全系列机型以及Web端多维度组合的兼容测试问题,测试任务下发24小时之内即可收到反馈测试报告,整体流程上使得券商发版提前了5天以上的时间,百度也查得到的。 参考技术B 在上家公司用过,产品、工具和方案都不错,他家比较懂证券的业务,这点比较关键,整体来说专业性和综合性很强,做测试就需要准确和专业,要不测试做了和没做一样,百度能查到相关资料的。

应用运维的红蓝演练:全链路压测在券商系统的落地实践

作者简介

林英,国信证券-资深测试经理

腾讯6年,负责服务端测试、精准测试、平台建设

国信证券,负责全链路压测及测试右移

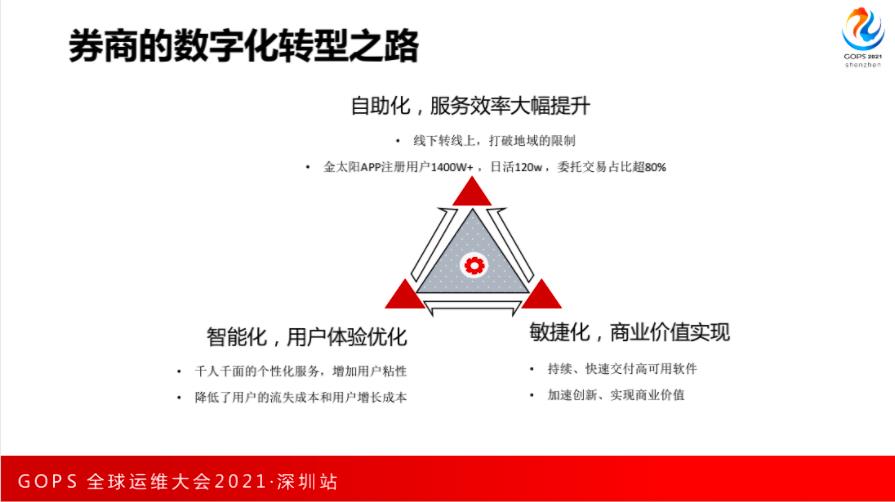

一、券商的数字化转型之路

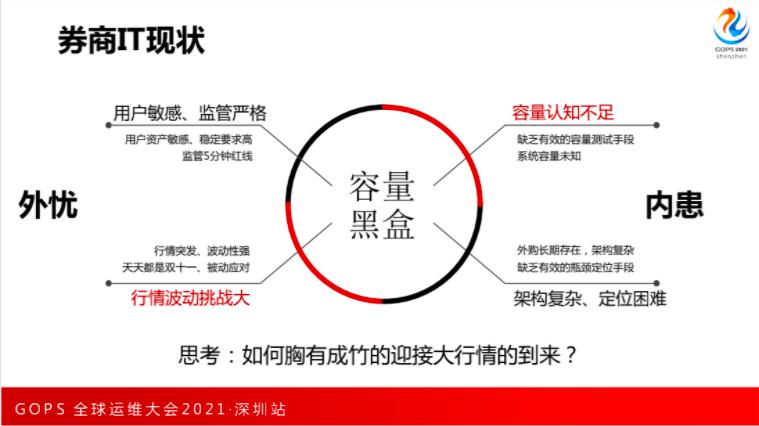

二、券商的 IT 现状

三、应用运维的红蓝演练

红方的设计思路

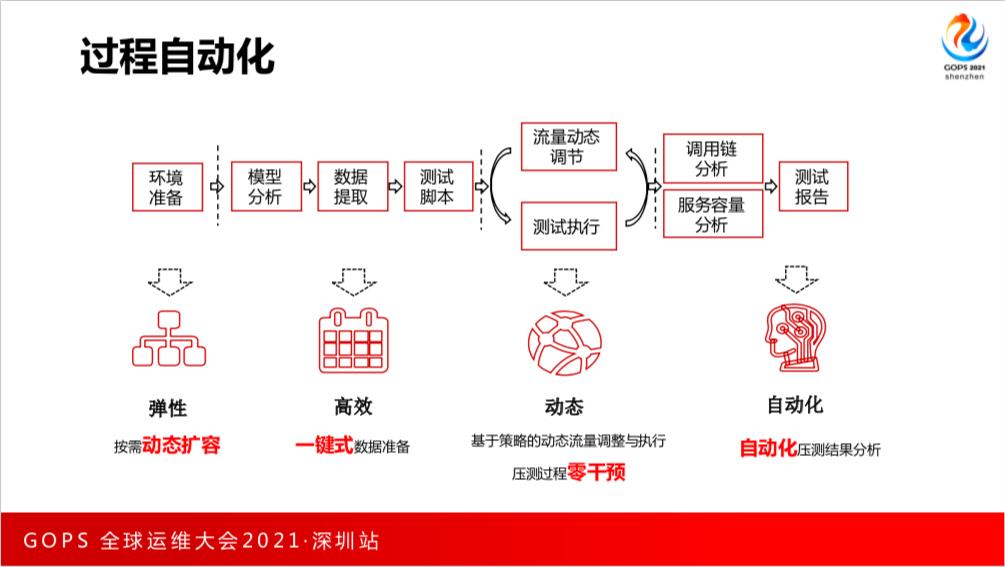

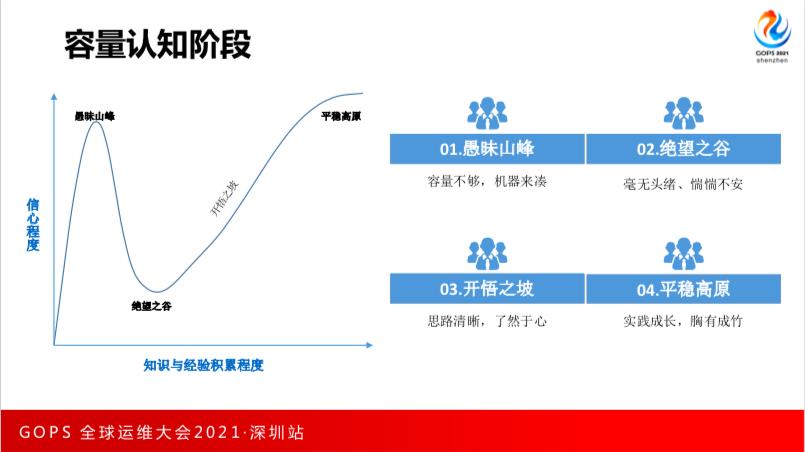

红方的设计思路主要是制定完善的压测方案,最终实现流程自动化、工具平台化、制度常态化。

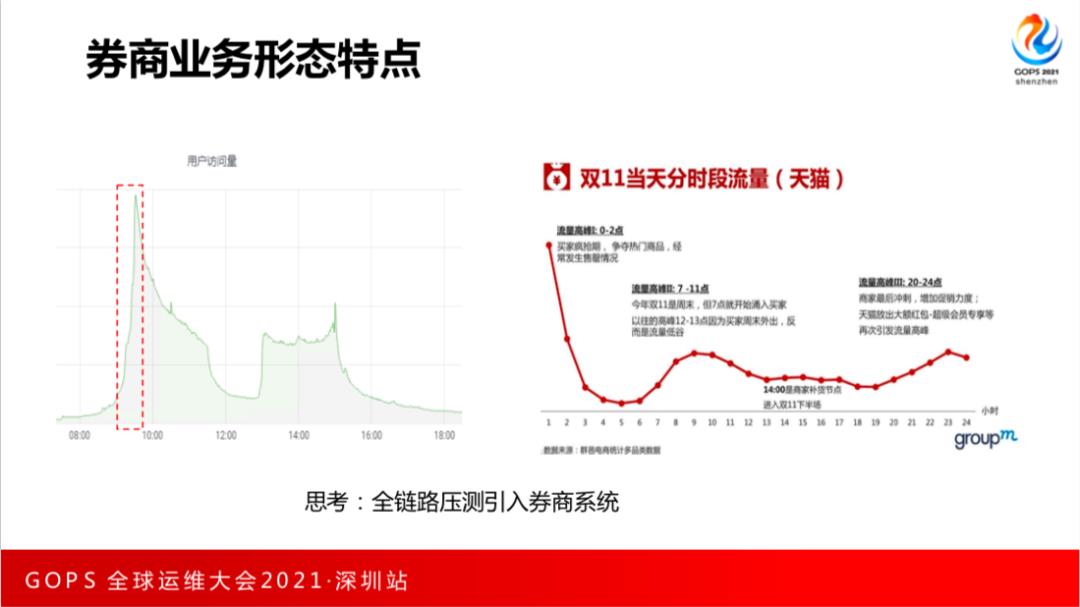

我们先看一下传统的压测方案是怎么做的,是以交易中间件为界限,分别对渠道接入系统和交易系统做性能测试,达到的结果作为我们应用部署上线的参考。

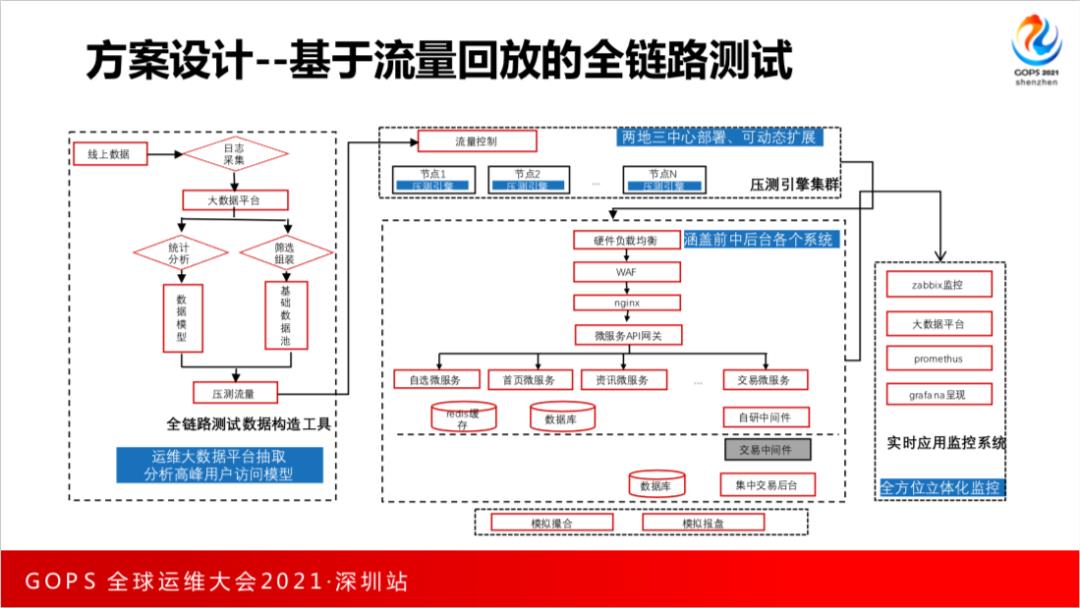

参考阿里应对天猫双十一的最佳实践,我们设计了基于流量回放的全链路压测方案,整个系统分为4大部分:

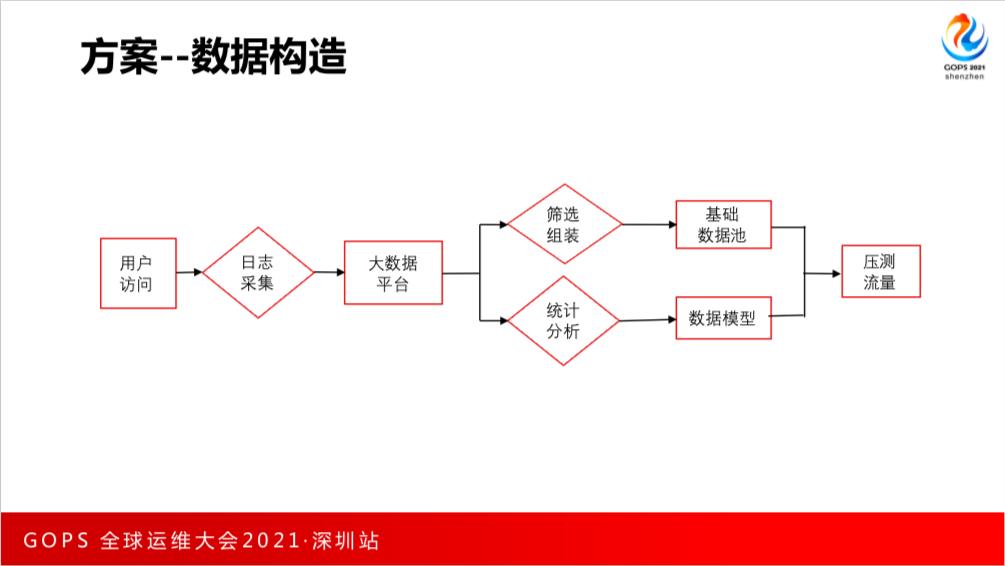

第一部分是全链路压测数据构造部分,基于大数据平台分析用户的分布情况,共同构成压测流量。

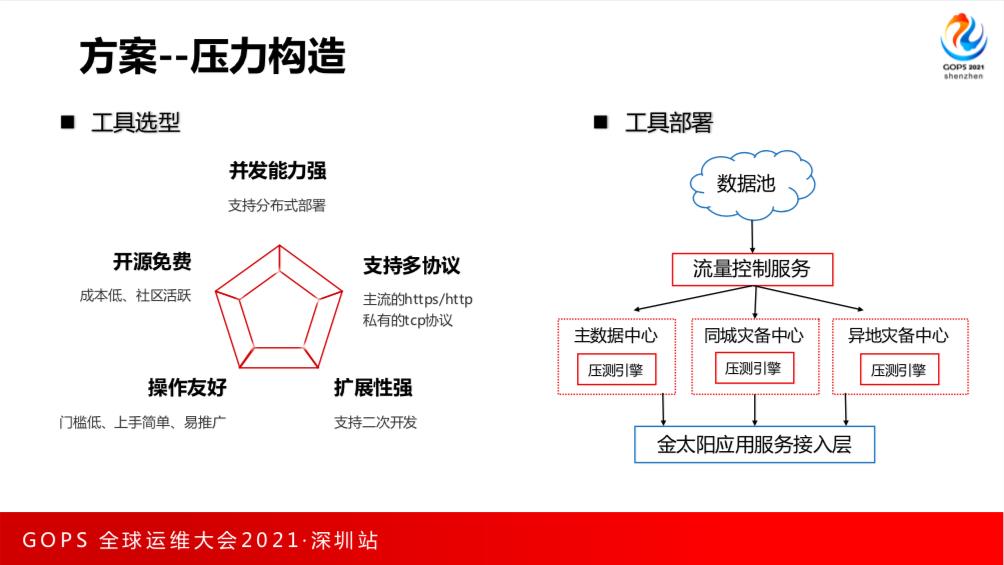

第二部分是压测集群,采用是两地三中心的部署架构,可以支持动态的横向扩展。

第三部分是应用系统,流量会从最外层的接入层进来,经过渠道接入部分、应用部分、交易中间件,最终到达集中交易后台,覆盖了前中后台的各个系统。

第四部分是监控系统,是基于现有的 Prometheus 和大数据平台,实现全方位立体化的监控。

我们的数据应该怎么构造,怎么才能更好的模拟生产环境的用户分布模型,怎么模拟高峰期用户的访问操作呢?有多少用户是在每天高峰期下单,进行交易登陆,有多少用户在查询行情呢?我们的方案是直接选用生产的数据来进行测试。

我们利用现有的运维大数据平台抽取数据,分析用户访问高峰的模型,利用生产运行真实用户数据分析,然后进行脱敏、订正之后导入构造压测数据池。

工具、数据、方案都准备就绪后,可以撸起袖子开工了。问题又来了,全链路压测的最佳实践对象是生产运行环境。如何保证压测期间的中间数据不会被用户看到?压测产生的脏数据如何与生产的数据隔离?互联网的方案是对压测流量做标识、改造中间件识别压测流量,利用影子库隔离脏数据。

券商系统涉及自研、外购,前后链路非常长,改造的难度非常大,而且必然会引入风险。稳字当头,注定了这个方案不可行。幸好,证券行业与互联网不同,它并不是7*24小时提供服务的。休市之后应用系统的流量就会大幅下降。我们在非交易时间利用网络隔离和数据库备份恢复策略来保障实施的安全性。

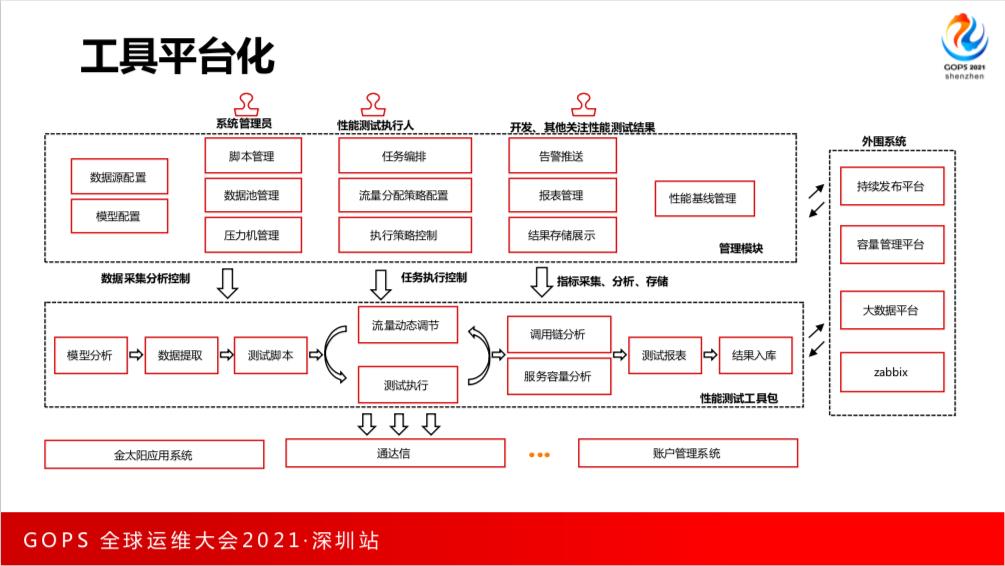

自动化下一层是工具平台化,为了让我们的工具能够推广到更多的团队,实行了平台化处理。平台分为四大部分,最下面是应用系统,最上层是权限管控、数据报表展示,同时我们还与外部系统实现了对接和联动。

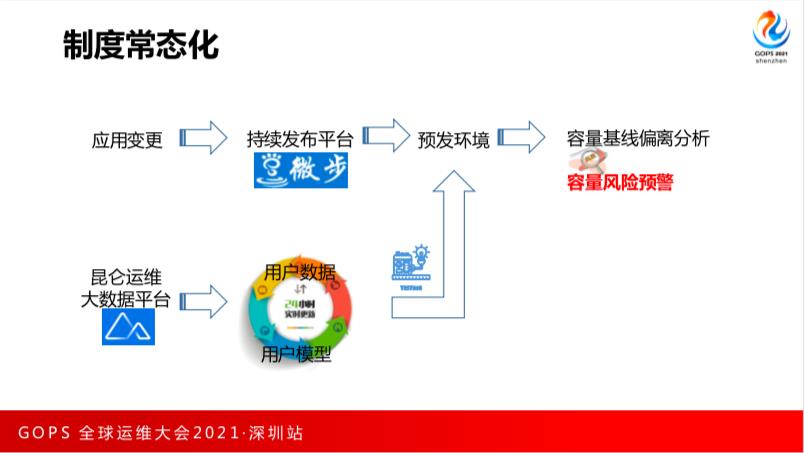

生产环境并不能每天都测试,所以我们按照生产环境等比例建设了预发环境,在预发环境里,我们会每天自动分析当天访问模型、抽取最新的用户数据,对待发布的金太阳应用版本,进行全自动的容量压测,从而建立容量的变化基线,并进行容量预警。

蓝方的设计思路

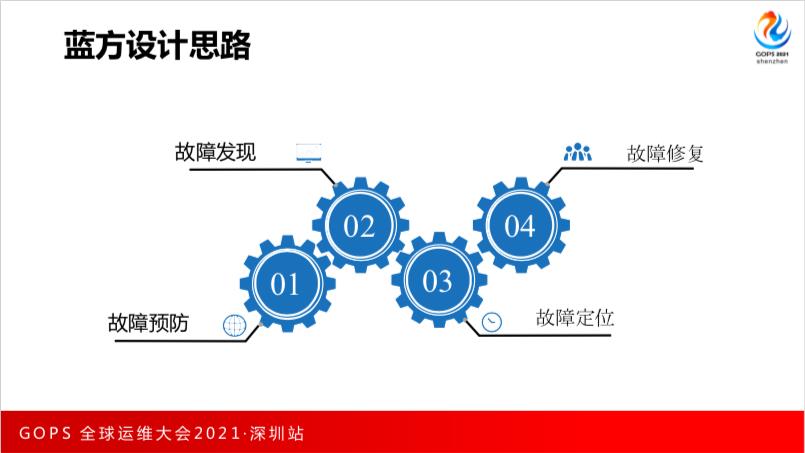

蓝军的防守策略主要从我们熟悉的故障预防、发现、定位、修复这4步开展。

在故障发现方面,我们建设了全面覆盖的监控体系,可以简单抽象成四层。在采集层我们采集了基础的资源监控指标,调用监控信息和日志信息统一发送到处理层,进行数据的落地。通过运维大数据平台和安全大数据平台进行聚合分析,发送告警到事件平台,使对应的人进行处理。最后对事件进行复盘回顾。

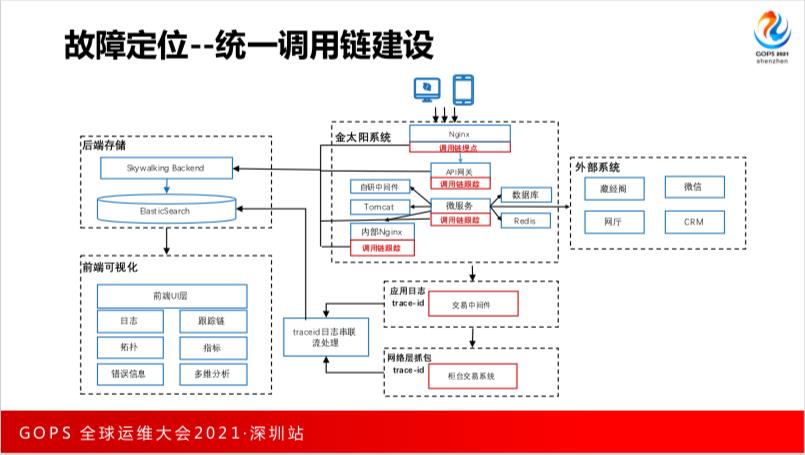

故障定位方面,我们实现从系统、组件、再到用户级别的,从立体到平面再到单点的层层递进式定位。首先对系统健康检查识别到请求量、错误率、时延的异常,接着下钻组件层,看到系统下各个组件各台机器的请求量、时延的异常,进而追溯到每个用户每笔交易的明细。

尽管我们做了充分的准备,但是依然可能会面临各种突发情况。假如用户的流量远高于我们的预估,出现了部分服务故障或者机器故障,我们应该怎么处理?扩容、降本是我们的手段。在业务限流方面,我们通过自研框架管理中心方面进行解决。在业务降级方面我们通过自研平台实现快速业务降级。

四、国信的建设成果

下面我们看一下效果。全链路压测在每半年的生产演练和每月的灾备演练中使用。覆盖了10多个应用体系,上百个应用组件和上千个应用主机。通过系统调优,主数据中心每秒处理能力提升3倍。福田、金桥两大新数据中心性能分别提升了4.1倍和5倍,平稳度过了2020年的行情高峰。

DevOps 风向标!DevOps 国际峰会 2021 · 北京站震撼来袭~想知道本届 DOIS 大会有哪些精彩?扫码提前了解~

以上是关于Testin云测试的券商测试服务怎么样?谁了解来说说的主要内容,如果未能解决你的问题,请参考以下文章