hadoop第四章:完全分布式(开发重点)

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了hadoop第四章:完全分布式(开发重点)相关的知识,希望对你有一定的参考价值。

参考技术AHadoop集群设置

将/opt/module文件夹,及配置文件/etc/profile分发到hadoop102|103|104上

分发配置文件时要使用root账户

刷新配置文件,使java环境变量生效

[atguigu@hadoop102 ~]$ source /etc/profile

[atguigu@hadoop103 ~]$ source /etc/profile

[atguigu@hadoop104 ~]$ source /etc/profile

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/core-site.xml

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/hdfs-env.sh

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/hdfs-site.xml

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/yarn-env.sh

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/yarn-site.xml

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/mapred-env.sh

[atguigu@hadoop102 hadoop-2.7.2]$ cp etc/hadoop/mapred-site.xml.template etc/hadoop/mapred-site.xml

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/mapred-site.xml

[atguigu@hadoop102 hadoop-2.7.2]$ hdfs namenode -format

[atguigu@hadoop102 hadoop-2.7.2]$ hadoop-daemon.sh start namenode

3台机器分别执行ssh

3台机器分别验证,都不需要密码则成功

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/slaves

分发到其他两台虚拟机

在hadoop102(namenode节点)上启动hdfs

[atguigu@hadoop102 hadoop-2.7.2]$ start-dfs.sh

在hadoop103(sourceManager节点)上启动yarn

[atguigu@hadoop103 hadoop-2.7.2]$ start-yarn.sh

hadoop102:50070

hadoop102:50070

日志聚集功能能够解决:当集群庞大,yarn的任务有错时无法定位到是某台节点的异常,日志聚集可以将所有节点日志都收集到历史服务器上,并通过yarn管理界面查看

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/mapred-site.xml

在mapred-site.xml中添加如下内容

[atguigu@hadoop102 hadoop-2.7.2]$ vi etc/hadoop/yarn-site.xml

在yarn-site.xml中添加如下内容

在hadoop102(namenode节点)上启动hdfs

[atguigu@hadoop102 hadoop-2.7.2]$ start-dfs.sh

在hadoop103(sourceManager节点)上启动yarn

[atguigu@hadoop103 hadoop-2.7.2]$ start-yarn.sh

在hadoop104上启动history

[atguigu@hadoop104 hadoop-2.7.2]$ mr-jobhistory-daemon.sh start historyserver

此时hadoop04出现JobHistoryServer服务

发现还是访问不了日志页面,原来是没配pc端hosts文件。哈哈,不能偷懒呀

Hadoop 开发重点:完全分布式运行模式编写集群分发脚本 scp/rsync/xsync

完全分布式运行模式:编写集群分发脚本

1. scp 安全拷贝

scp :(secure copy)

(1)scp 定义

scp 可以实现服务器与服务器之间的数据拷贝。(from server1 to server2)

(2)基本语法

scp -r $pdir/$fname $user@$host:$pdir/$fname

命令 递归 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称

(3)案例实操

前提:在 hadoop102、hadoop103、hadoop104 都已经创建好的/opt/module、/opt/software 两个目录,并且已经把这两个目录修改为 zs:zs(zs:username)。

sudo chown zs:zs -R /opt/module

(a)在 hadoop102 上,将 hadoop102中/opt/module/jdk1.8.0_212 目录拷贝到hadoop103 上。

scp -r /opt/module/jdk1.8.0_212 zs@hadoop103:/opt/module

(b)在 hadoop103 上,将 hadoop102中/opt/module/hadoop-3.1.3 目录拷贝到hadoop103 上。

scp -r zs@hadoop102:/opt/module/hadoop-3.1.3 /opt/module/

(c)在 hadoop103 上操作,将 hadoop102 中/opt/module 目录下所有目录拷贝到hadoop104 上。

scp -r zs@hadoop102:/opt/module/* zs@hadoop104:/opt/module

2. rsync 远程同步工具

rsync 主要用于备份和镜像。具有速度快、避免复制相同内容和支持符号链接的优点。

rsync 和 scp 区别:用 rsync 做文件的复制要比 scp 的速度快,rsync 只对差异文件做更新。scp 是把所有文件都复制过去。

一次copy用scp,二次更新用rsync

(1)基本语法

rsync -av $pdir/$fname $user@$host:$pdir/$fname

命令 选项参数 要拷贝的文件路径/名称 目的地用户@主机:目的地路径/名称

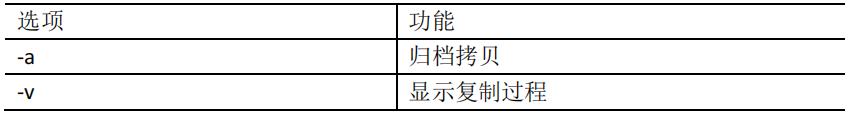

选项参数说明:

(2)案例实操

(a)删除 hadoop103 中/opt/module/hadoop-3.1.3/wcinput:

rm -rf wcinput/

(b)同步 hadoop102 中的/opt/module/hadoop-3.1.3 到 hadoop103

rsync -av hadoop-3.1.3/ zs@hadoop103:/opt/module/hadoop-3.1.3/

查看已删除的wcinput是否更新出来,而且速度更快,只更新差异文件,已有的自动跳过

3. xsync 集群分发脚本

(1)需求:循环复制文件到所有节点的相同目录下

(2)需求分析:

(a)rsync 命令原始拷贝:

rsync -av /opt/module zs@hadoop103:/opt/

(b)期望脚本:

xsync 要同步的文件名称

(c)期望脚本在任何路径都能使用(脚本放在声明了全局环境变量的路径)

# 查看PATH环境变量

echo $PATH

/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/home/zs/.local/bin:/home/zs/bin:/opt/module/jdk1.8.0_212/bin

(3)脚本实现

(a)在/home/atguigu/bin 目录下创建 xsync 文件

[zs@hadoop102 opt]$ cd /home/atguigu

[zs@hadoop102 ~]$ mkdir bin

[zs@hadoop102 ~]$ cd bin

[zs@hadoop102 bin]$ vim xsync

在该文件中编写如下代码:

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

(b)修改脚本 xsync 具有执行权限

[zs@hadoop102 bin]$ chmod +x xsync

(c)测试脚本

[zs@hadoop102 ~]$ xsync /home/atguigu/bin

(d)将脚本复制到/bin 中,以便全局调用

[zs@hadoop102 bin]$ sudo cp xsync /bin/

(e)同步环境变量配置(root 所有者)

[zs@hadoop102 ~]$ sudo ./bin/xsync /etc/profile.d/my_env.sh

注意:如果用了 sudo,那么 xsync 一定要给它的路径补全。

让每一台服务器的环境变量生效:

[zs@hadoop103 bin]$ source /etc/profile

[zs@hadoop104 opt]$ source /etc/profile

xsync 集群分发脚本使用还是特别方便的,能快速的将数据同步到其他服务器。

加油!

感谢!

努力!

以上是关于hadoop第四章:完全分布式(开发重点)的主要内容,如果未能解决你的问题,请参考以下文章