yarn和mapreduce资源调优

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了yarn和mapreduce资源调优相关的知识,希望对你有一定的参考价值。

参考技术A YARN允许用户配置每个节点上可用的物理内存资源,注意,这里是“可用的”,因为一个节点上的内存会被若干个服务共享,比如一部分给YARN,一部分给HDFS,一部分给HBase等,YARN配置的只是自己可以使用的,配置参数如下:

(1)yarn.nodemanager.resource.memory-mb

表示该节点上YARN可使用的物理内存总量,默认是8192(MB),注意,如果你的节点内存资源不够8GB,则需要调减小这个值,而YARN不会智能的探测节点的物理内存总量。

(2)yarn.scheduler.minimum-allocation-mb

单个容器可申请的最少物理内存量,默认是1024(MB),如果一个容器申请的物理内存量少于该值,则该对应的值改为这个数。

(3) yarn.scheduler.maximum-allocation-mb

单个容器可申请的最多物理内存量,默认是8192(MB)

目前的CPU被划分成虚拟CPU(CPU virtual Core),这里的虚拟CPU是YARN自己引入的概念,初衷是,考虑到不同节点的CPU性能可能不同,每个CPU具有的计算能力也是不一样的,比如某个物理CPU的计算能力可能是另外一个物理CPU的2倍,这时候,你可以通过为第一个物理CPU多配置几个虚拟CPU弥补这种差异。用户提交作业时,可以指定每个任务需要的虚拟CPU个数。在YARN中,CPU相关配置参数如下:

(1)yarn.nodemanager.resource.cpu-vcores

表示该节点上YARN可使用的虚拟CPU个数,默认是8,注意,目前推荐将该值设值为与物理CPU核数数目相同。如果你的节点CPU核数不够8个,则需要调减小这个值,而YARN不会智能的探测节点的物

理CPU总数。

(2)yarn.scheduler.minimum-allocation-vcores

单个容器可申请的最小虚拟CPU个数,默认是1,如果一个容器申请的CPU个数少于该数,则该对应的值改为这个数

(3)yarn.scheduler.maximum-allocation-vcores

单个容器可申请的最多虚拟CPU个数,默认是4

3.mapreduce---Memory调优

(1)yarn.app.mapreduce.am.resource.mb

MR AppMaster需要的内存,默认是1536M

(2)yarn.app.mapreduce.am.command-opts

MR AppMaster的Java opts ,默认是 -Xmx1024m

(3)mapreduce.map.memory.mb

每个map task所需要的内存,默认是1024M。应该是大于或者等于Container的最小内存

(4)mapreduce.reduce.memory.mb

每个reduce task所需要的内存,默认是1024M

(5)mapreduce.map.java.opts

map task进程的java.opts,默认是 -Xmx200m

(6)mapreduce.reduce.java.opts

reduce task进程的java.opts,默认是 -Xmx200m

特别注意:

mapreduce.map.memory.mb >mapreduce.map.java.opts

mapreduce.reduce.memory.mb >mapreduce.reduce.java.opts

mapreduce.map.java.opts / mapreduce.map.memory.mb

=0.70~0.80

mapreduce.reduce.java.opts / mapreduce.reduce.memory.mb

=0.70~0.80

在yarn container这种模式下,JVM进程跑在container中,mapreduce.map|reduce.java.opts 能够通过Xmx设置JVM最大的heap的使用,

一般设置为0.75倍的memory.mb,

则预留些空间会存储java,scala code等

4.mapreduce---CPU调优

(1)mapreduce.map.cpu.vcores

map task的虚拟核数,默认为1

(2)mapreduce.reduce.cpu.vcores

reduce task的虚拟核数,默认为1

(3)yarn.app.mapreduce.am.resource.cpu-vcores

am的虚拟核数,默认为1

假设机器的物理配置 64G 16cores

装完系统还剩 62G

预留15~20% 14G:DN 4G + NM 1G=5G 9G

DN进程: 生产4G

1000m

hadoop-env.sh

HADOOP_NAMENODE_OPTS=-Xmx1024m

HADOOP_DATANODE_OPTS=-Xmx4096m

NM进程: 生产1G

yarn-env.sh

export YARN_RESOURCEMANAGER_HEAPSIZE=1024

export YARN_NODEMANAGER_HEAPSIZE=1024

部署同一台: 数据本地化

NN RM 经常性部署同一台 说白了 集群节点少

yarn.nodemanager.resource.memory-mb : 48G 计算总内存 固定经验计算值

yarn.nodemanager.resource.cpu-vcores : 24

yarn.scheduler.minimum-allocation-mb : 4G

yarn.scheduler.minimum-allocation-vcores: 2

yarn.scheduler.maximum-allocation-mb : 8G

yarn.scheduler.maximum-allocation-vcores : 4 固定经验值(不要超过5个)

http://blog.itpub.net/30089851/viewspace-2127851/

http://blog.itpub.net/30089851/viewspace-2127850/

hadoop之MapReduce---Yarn资源调度器

Yarn是一个资源调度平台,负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台,而MapReduce等运算程序则相当于运行于操作系统之上的应用程序

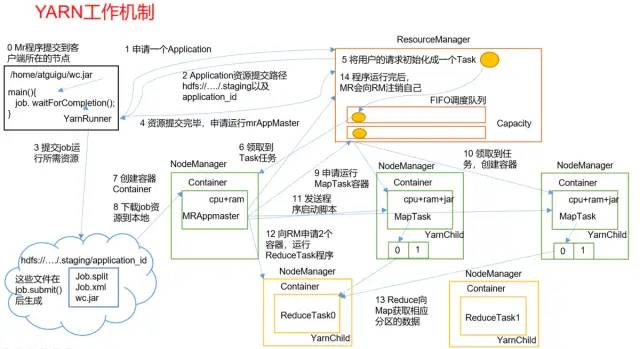

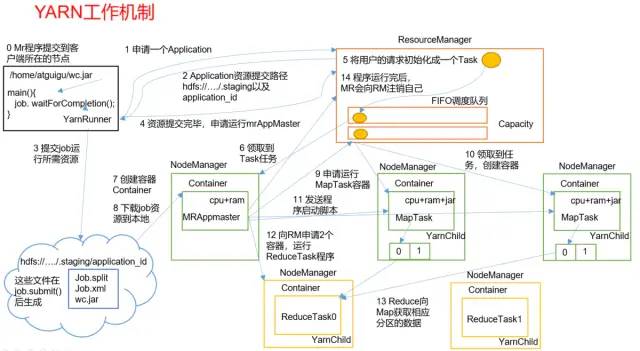

Yarn基本架构

YARN主要由ResourceManager、NodeManager、ApplicationMaster和Container等组件构成

Yarn工作机制

工作机制详解

1)MR程序提交到客户端所在的节点。

2)YarnRunner向ResourceManager申请一个Application。

3)RM将该应用程序的资源路径返回给YarnRunner。

4)该程序将运行所需资源提交到HDFS上。

5)程序资源提交完毕后,申请运行mrAppMaster。

6)RM将用户的请求初始化成一个Task。

7)其中一个NodeManager领取到Task任务。

8)该NodeManager创建容器Container,并产生MRAppmaster。

9)Container从HDFS上拷贝资源到本地。

10)MRAppmaster向RM 申请运行MapTask资源。

11)RM将运行MapTask任务分配给另外两个NodeManager,另两个NodeManager分别领取任务并创建容器。

12)MR向两个接收到任务的NodeManager发送程序启动脚本,这两个NodeManager分别启动MapTask,MapTask对数据分区排序。

13)MrAppMaster等待所有MapTask运行完毕后,向RM申请容器,运行ReduceTask。

14)ReduceTask向MapTask获取相应分区的数据。

15)程序运行完毕后,MR会向RM申请注销自己

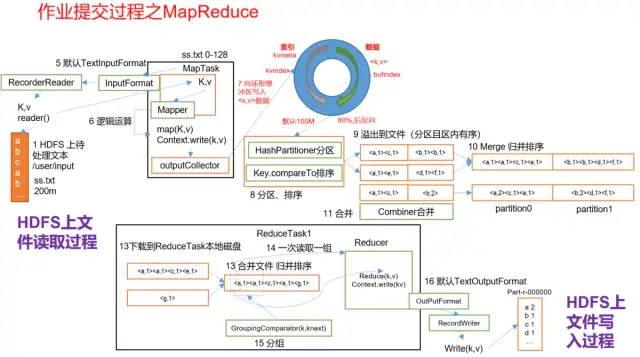

作业提交全过程

作业提交全过程详解

1)作业提交

第1步:Client调用job.waitForCompletion方法,向整个集群提交MapReduce作业。

第2步:Client向RM申请一个作业id。

第3步:RM给Client返回该job资源的提交路径和作业id。

第4步:Client提交jar包、切片信息和配置文件到指定的资源提交路径。

第5步:Client提交完资源后,向RM申请运行MrAppMaster。

2)作业初始化

第6步:当RM收到Client的请求后,将该job添加到容量调度器中。

第7步:某一个空闲的NM领取到该Job。

第8步:该NM创建Container,并产生MRAppmaster。

第9步:下载Client提交的资源到本地。

3)任务分配

第10步:MrAppMaster向RM申请运行多个MapTask任务资源。

第11步:RM将运行MapTask任务分配给另外两个NodeManager,另两个NodeManager分别领取任务并创建容器。

4)任务运行

第12步:MR向两个接收到任务的NodeManager发送程序启动脚本,这两个NodeManager分别启动MapTask,MapTask对数据分区排序。

第13步:MrAppMaster等待所有MapTask运行完毕后,向RM申请容器,运行ReduceTask。

第14步:ReduceTask向MapTask获取相应分区的数据。

第15步:程序运行完毕后,MR会向RM申请注销自己。

5)进度和状态更新

YARN中的任务将其进度和状态(包括counter)返回给应用管理器, 客户端每秒(通过mapreduce.client.progressmonitor.pollinterval设置)向应用管理器请求进度更新, 展示给用户。

6)作业完成

除了向应用管理器请求作业进度外, 客户端每5秒都会通过调用waitForCompletion()来检查作业是否完成。时间间隔可以通过mapreduce.client.completion.pollinterval来设置。作业完成之后, 应用管理器和Container会清理工作状态。作业的信息会被作业历史服务器存储以备之后用户核查。

作业提交过程之MapReduce

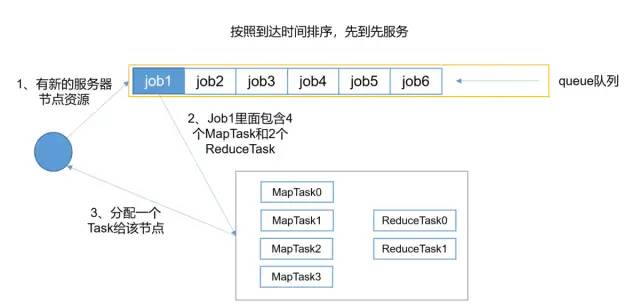

资源调度器

目前,Hadoop作业调度器主要有三种:FIFO、Capacity Scheduler和Fair Scheduler。Hadoop2.7.2默认的资源调度器是Capacity Scheduler。

具体设置详见:yarn-default.xml文件

<property>

<description>The class to use as the resource scheduler.</description>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.capacity.CapacityScheduler</value>

</property>

先进先出调度器(FIFO)

容量调度器(Capacity Scheduler)

公平调度器(Fair Scheduler)

任务的推测执行

作业完成时间取决于最慢的任务完成时间

一个作业由若干个Map任务和Reduce任务构成。因硬件老化、软件Bug等,某些任务可能运行非常慢。

思考:系统中有99%的Map任务都完成了,只有少数几个Map老是进度很慢,完不成,怎么办?推测执行机制

发现拖后腿的任务,比如某个任务运行速度远慢于任务平均速度。为拖后腿任务启动一个备份任务,同时运行。谁先运行完,则采用谁的结果。执行推测任务的前提条件

1)每个Task只能有一个备份任务

2)当前Job已完成的Task必须不小于0.05(5%)

3)开启推测执行参数设置。mapred-site.xml文件中默认是打开的。

<property>

<name>mapreduce.map.speculative</name>

<value>true</value>

<description>If true, then multiple instances of some map tasks may be executed in parallel.</description>

</property>

<property>

<name>mapreduce.reduce.speculative</name>

<value>true</value>

<description>If true, then multiple instances of some reduce tasks may be executed in parallel.</description>

</property>

不能启用推测执行机制情况

1)任务间存在严重的负载倾斜;

2)特殊任务,比如任务向数据库中写数据算法原理

假设某一时刻,任务T的执行进度为progress,则可通过一定的算法推测出该任务的最终完成时刻estimateEndTime。另一方面,如果此刻为该任务启动一个备份任务,则可推断出它可能的完成时刻estimateEndTime`,于是可得出以下几个公式:

estimatedRunTime = (currentTimestamp - taskStartTime) / progress

推测运行时间(60s)=(当前时刻(6) - 任务启动时刻(0)) / 任务运行比例(10%)

estimateEndTime = estimatedRunTime + taskStartTime

推测执行完时刻 60 = 推测运行时间(60s) + 任务启动时刻(0)

estimateEndTime = currentTimestamp + averageRunTime

备份任务推测完成时刻(16) = 当前时刻(6) + 运行完成任务的平均时间(10s)

1)MR总是选择(estimateEndTime- estimateEndTime ` )差值最大的任务,并为之启动备份任务。

2)为了防止大量任务同时启动备份任务造成的资源浪费,MR为每个作业设置了同时启动的备份任务数目上限。

3 )推测执行机制实际上采用了经典的优化算法:以空间换时间,它同时启动多个相同任务处理相同的数据,并让这些任务竞争以缩短数据处理时间。显然,这种方法需要占用更多的计算资源。在集群资源紧缺的情况下,应合理使用该机制,争取在多用少量资源的情况下,减少作业的计算时间。

简书:https://www.jianshu.com/u/0278602aea1d

CSDN:https://blog.csdn.net/u012387141

特别感谢:尚硅谷教育

以上是关于yarn和mapreduce资源调优的主要内容,如果未能解决你的问题,请参考以下文章