文献阅读:Scaling Instruction-Finetuned Language Models

Posted Espresso Macchiato

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了文献阅读:Scaling Instruction-Finetuned Language Models相关的知识,希望对你有一定的参考价值。

1. 文章简介

这篇文章同样是Google在上年发表的一篇同样关于大模型的工作。

在这篇文章当中,作者对Flan进行了更加细致的考察。

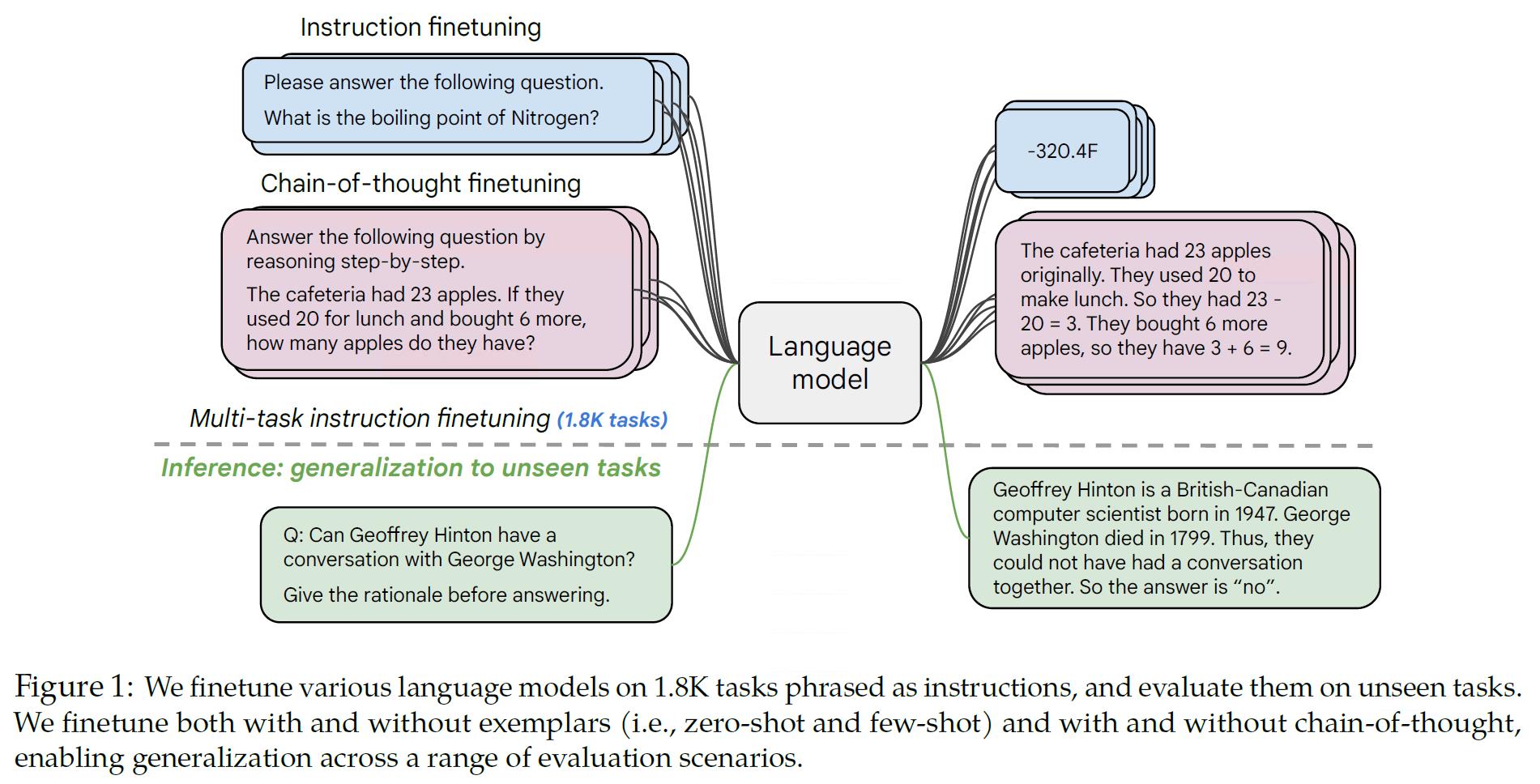

具体来说,在Flan最开始提出的时候,Flan只是用在了预训练语言模型上,但是这篇文章当中对Flan的适用范围以及使用的数据集等做了进一步的扩展研究,具体来说:

- 在Palm以及T5模型上测试了Flan的效果;

- 将Flan的数据任务进行了scale up;

- 将模型的size进一步进行了scale up;

- 加入CoT数据考察效果。

基于此,文章获得了更好的整体指标表达以及一些case如下:

下面,我们来具体看看文中的实验结果。

2. 实验

1. 数据集 & 模型

首先,我们来看一下文中使用的数据集以及模型进行一下整理。

1. 数据集考察

我们首先看一下文中使用的数据集:

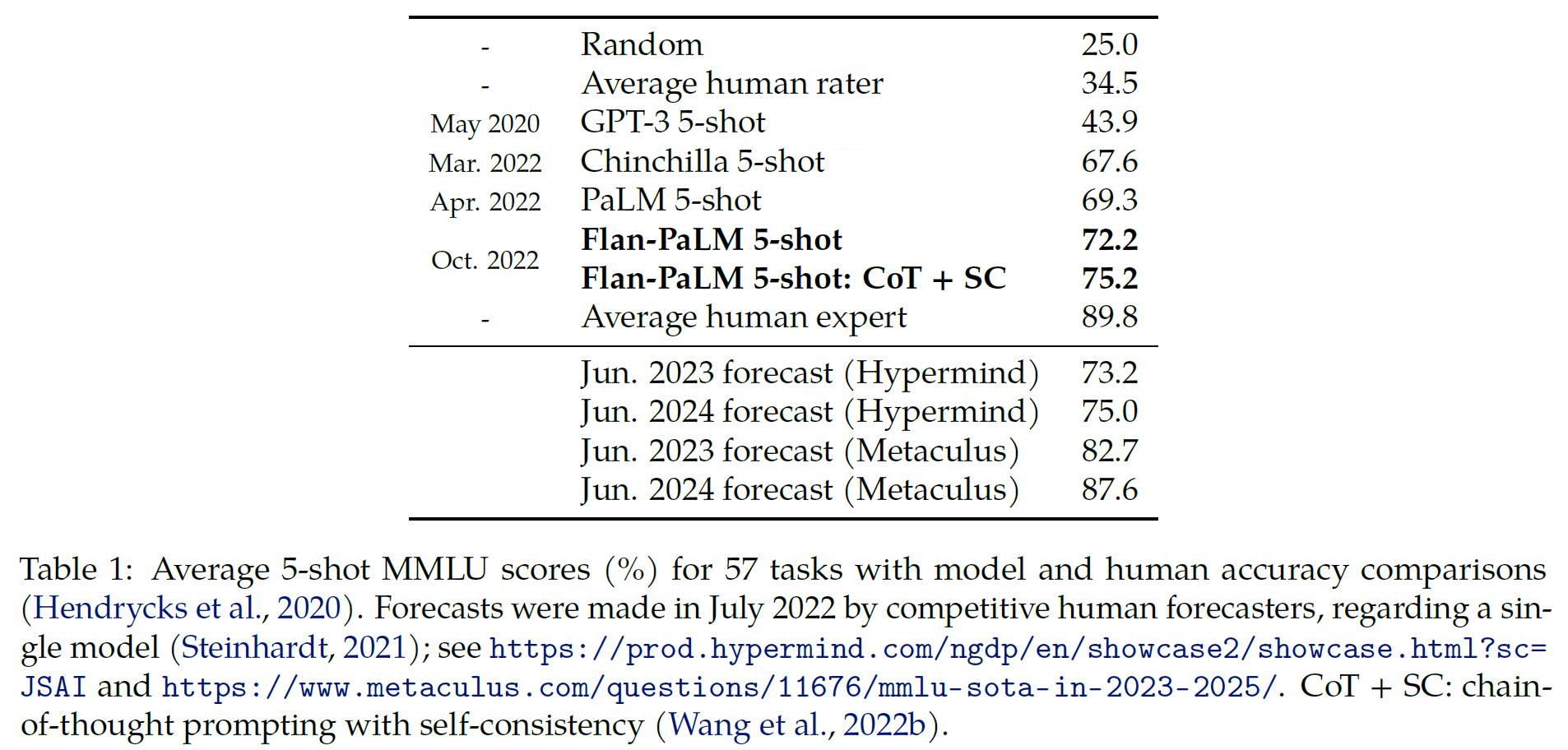

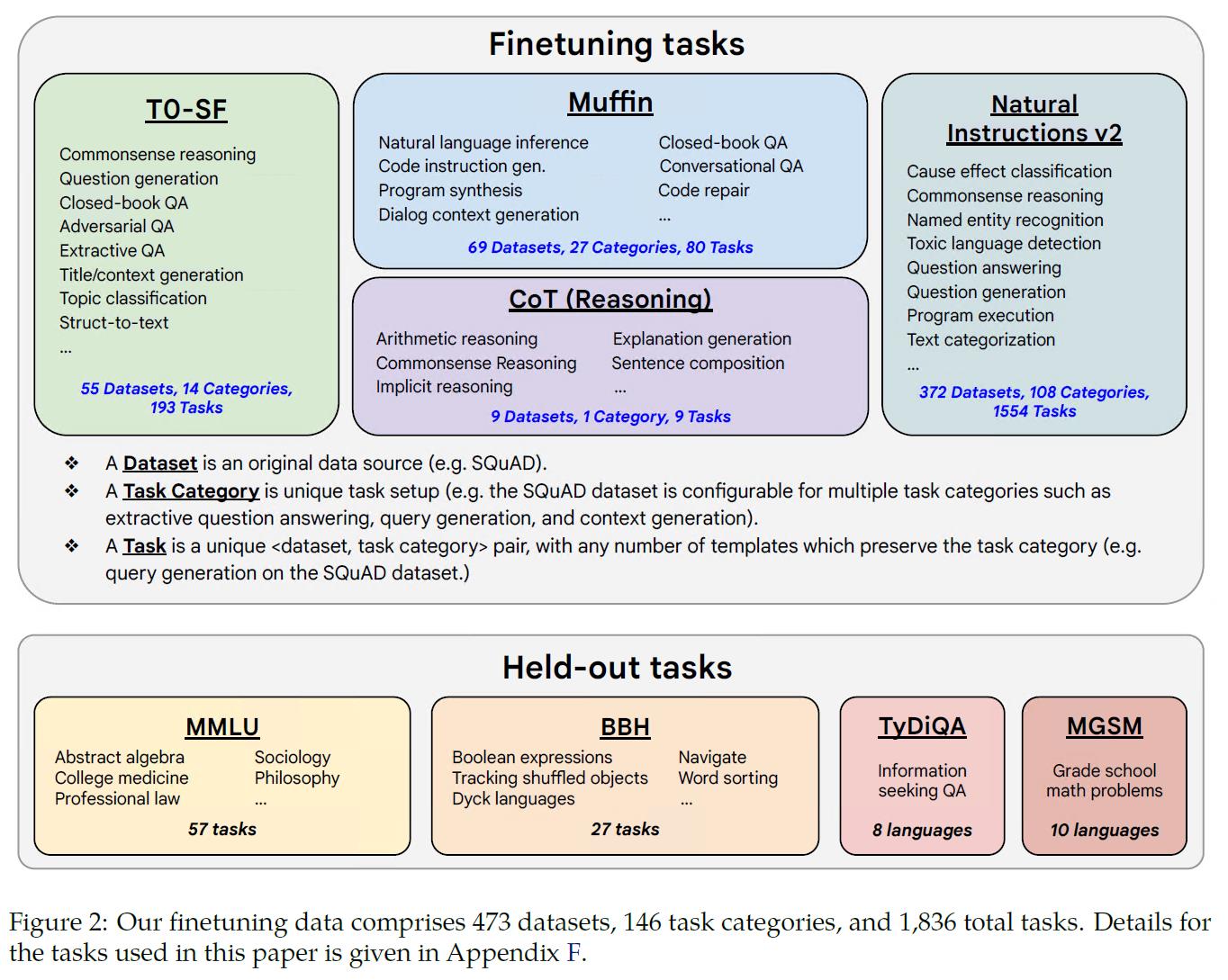

可以看到,相较于前作Flan的62个训练任务,本文对任务进行了大幅的扩充,扩展至146个任务类型中的473个数据集以及合计1836个任务。

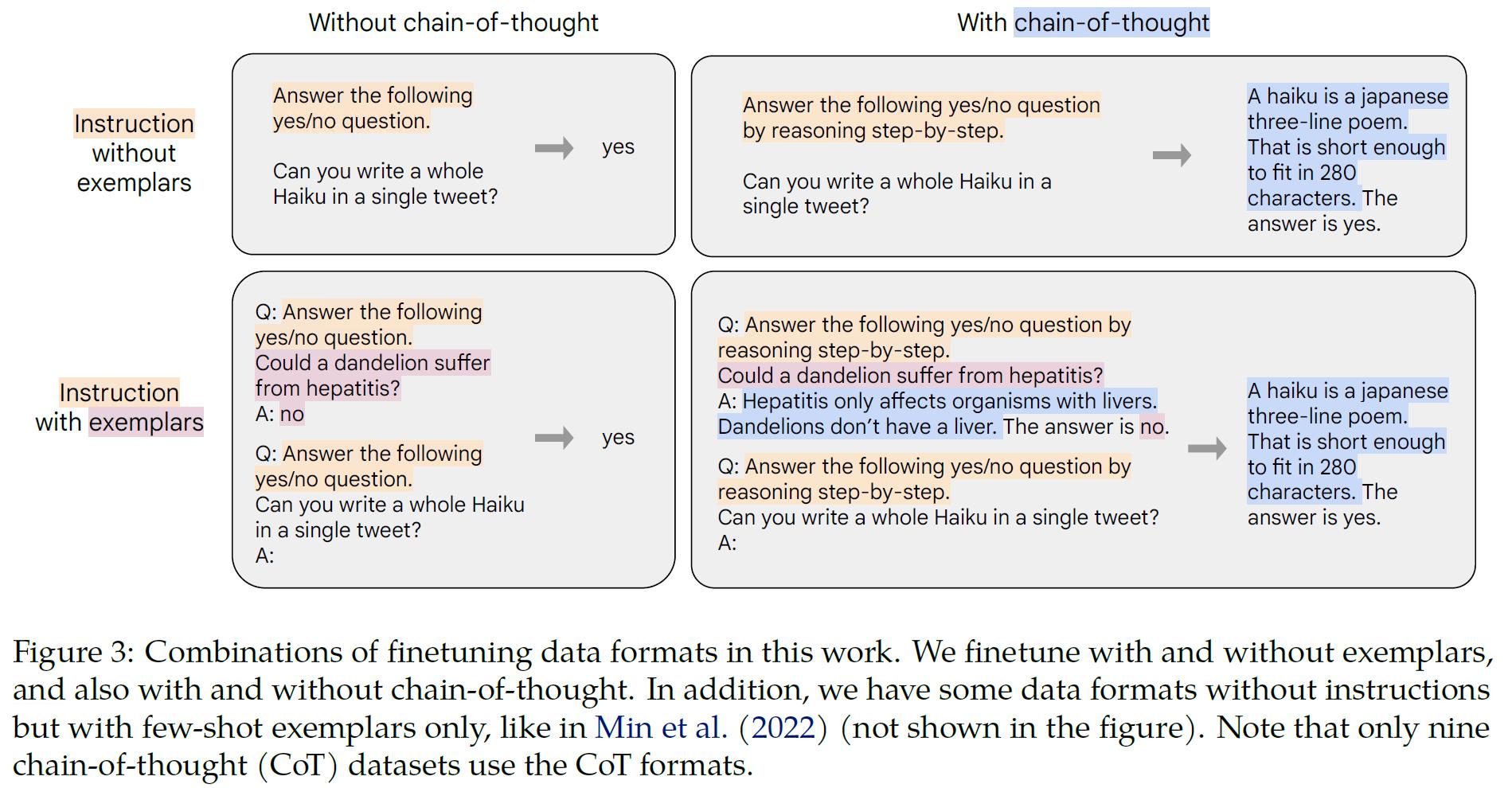

其中,关于CoT数据集的使用方式如下:

可以看到,其实就是加上引导词“by reasoning step-by-step”,然后答案当中加入推理过程。

2. 使用模型

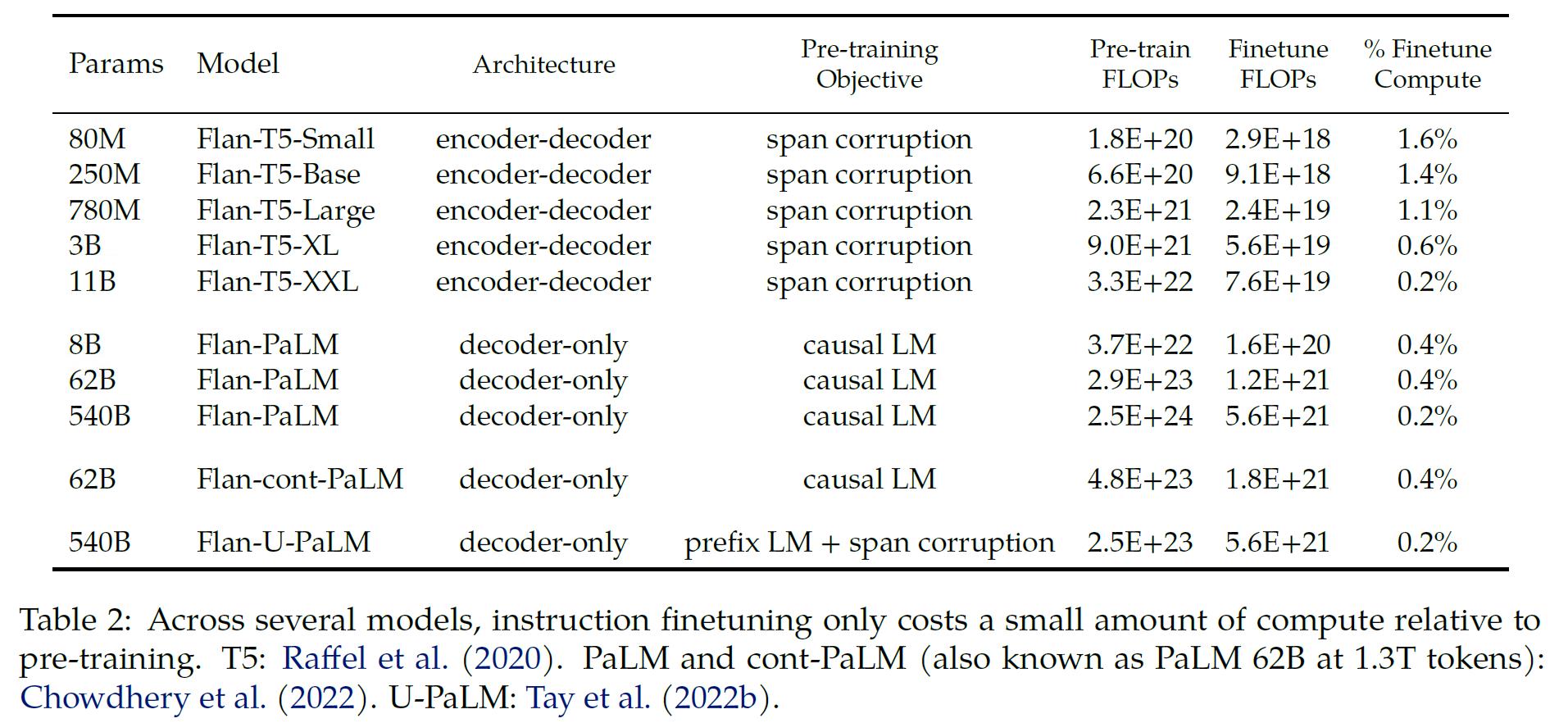

而文中使用的模型则如下表所示:

可以看到,文中同时考察了自回归语言模型以及Transformer架构的T5模型,比对了不同的预训练方式以及不同的模型size下Flan的效果。

2. scale up对模型效果的影响

下面,我们首先来看一下scale up对模型效果的影响,具体包括:

- 模型size的scale up对模型效果的影响;

- 训练任务的scale up对模型效果的影响;

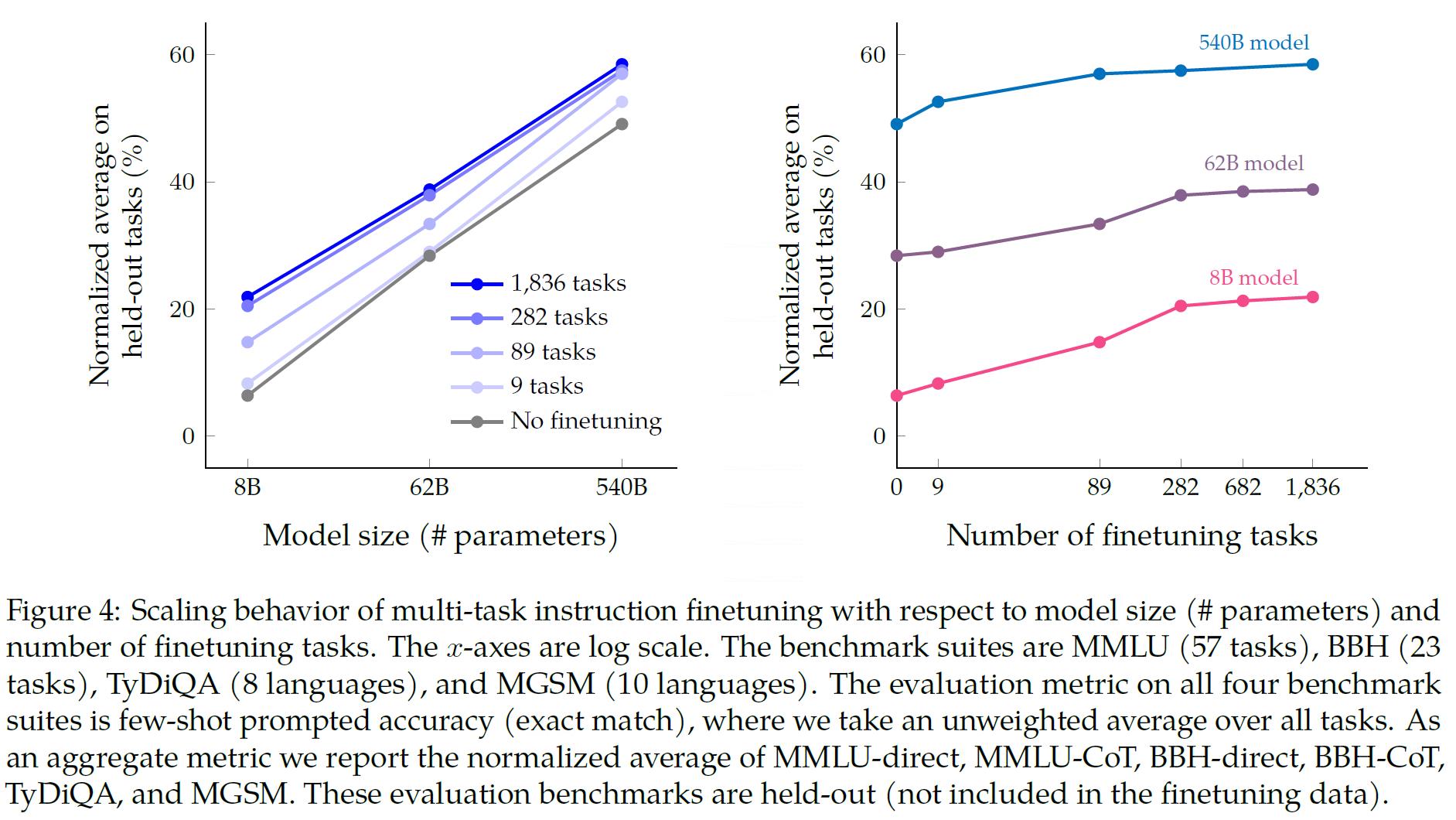

给出文中的实验结果如下:

可以看到:

- 随着模型size的增大,模型效果不断提升;

- 随着模型使用的finetune数据集的增多,模型效果也是不断提升的。

更直观的,文中还给出了上述结果的图表形式:

3. CoT对模型效果的影响

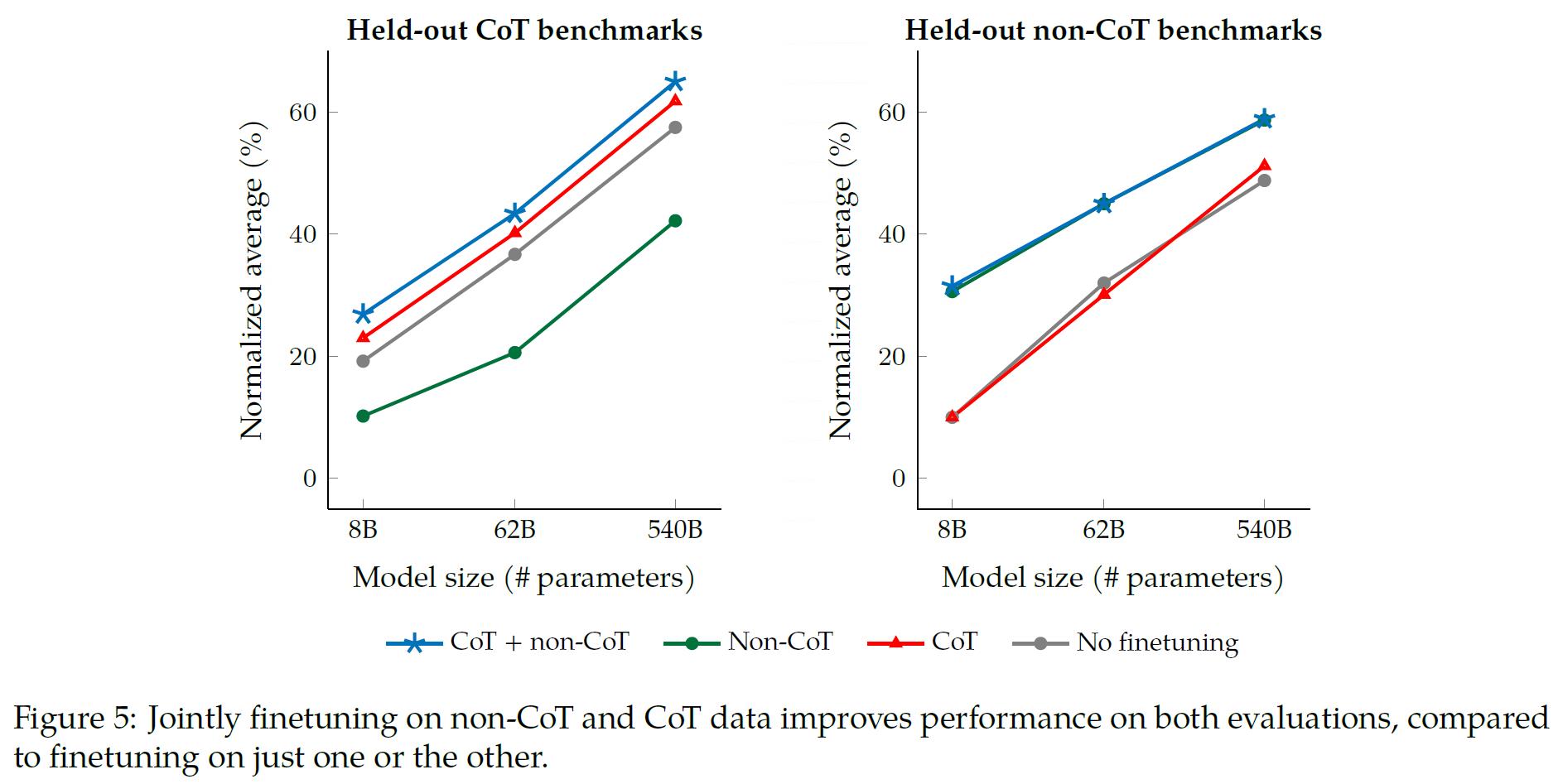

然后,我们来看一下CoT数据集对模型效果的影响。

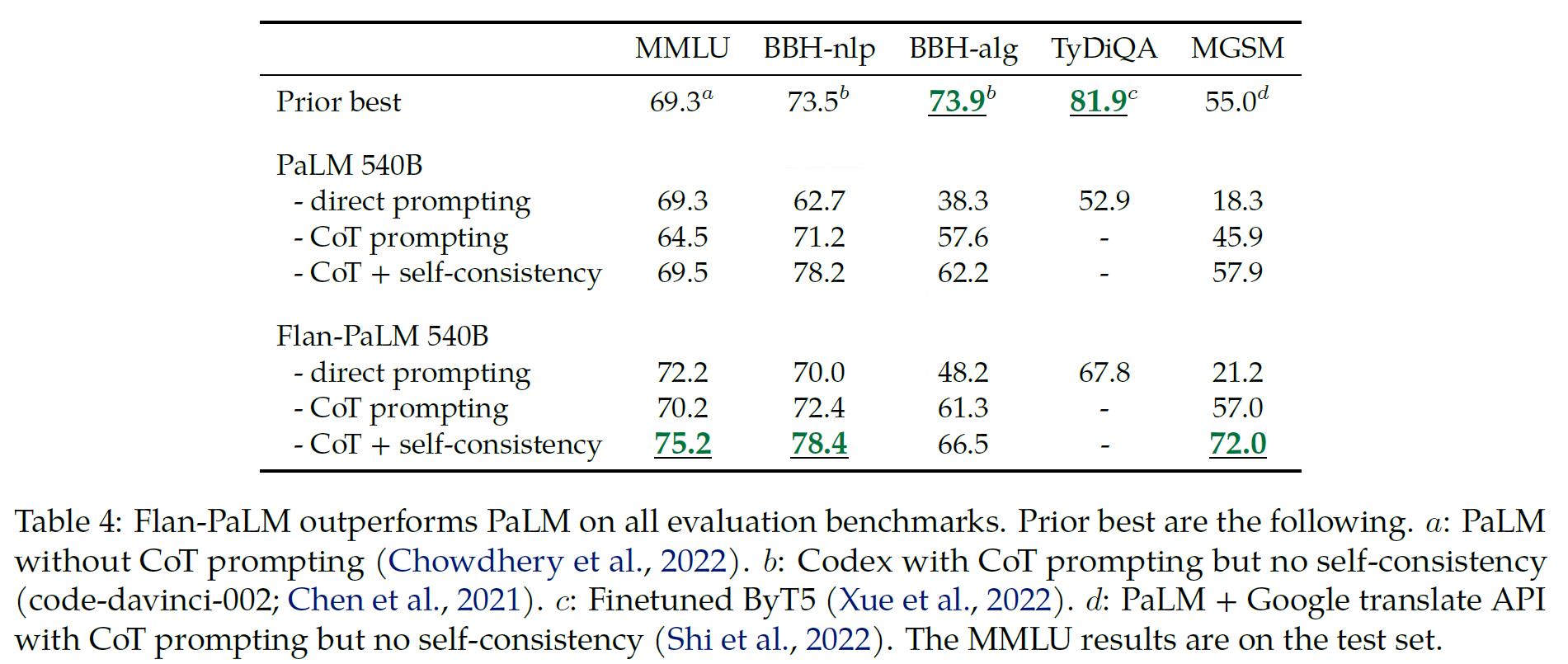

同样,我们首先给出文中的实验结果表格如下:

可以看到:

- CoT数据集对于LLM的效果总是正向的。

而在不同的benchmarks下,可以看到:

- 对于CoT benchmarks,CoT数据集对效果提升很明显,而对于non-CoT benchmarks,CoT数据集对于模型效果并没有太大的影响。

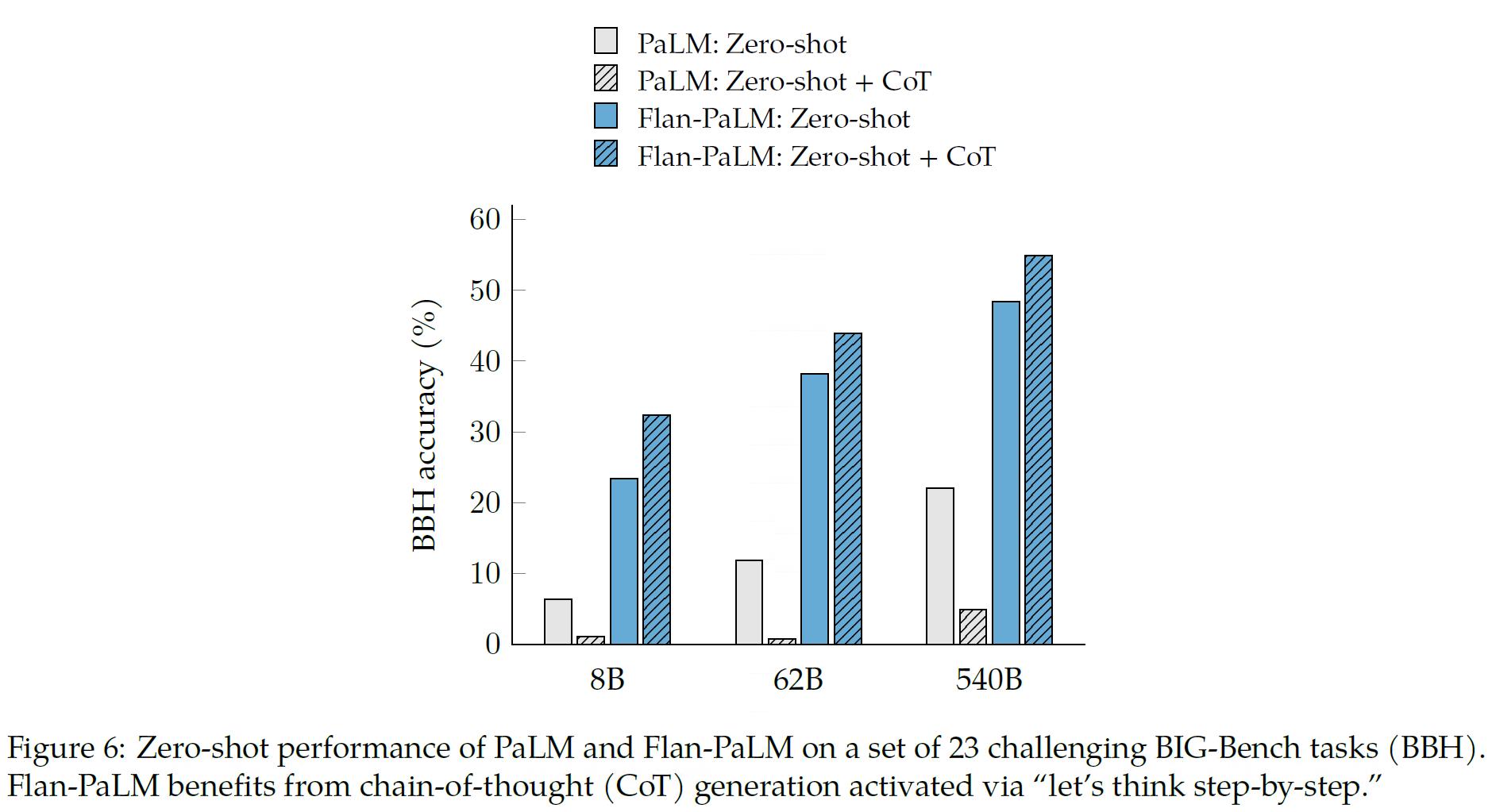

另外文中还在BBH数据集上考察了CoT对于Zero-Shot的影响,得到结果如下图所示:

可以看到:

- 对于不加入Flan训练的Palm模型,CoT文本的加入并不能够带来效果的提升;

- 对于Flan之后的Palm模型,CoT能够明显的提升模型的效果;

- Flan本身也能够给模型带来足够的效果提升。

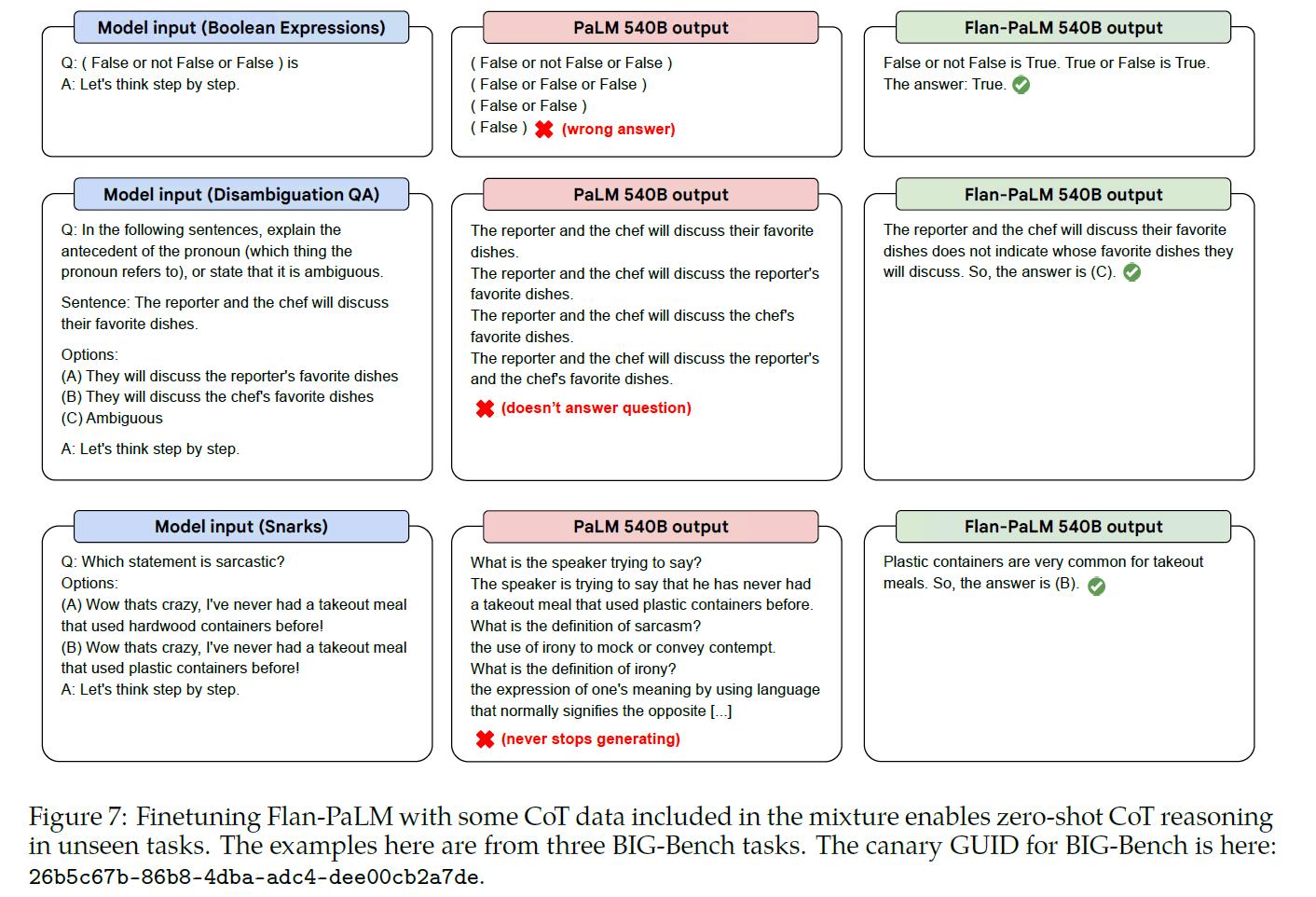

最后,文中还给了几个具体的case如下:

4. 不同模型下Flan的影响

除了在自回归语言模型的情况下,文中还对T5进行了考察,看了一下T5这种完形填空式的预训练方式得到的大模型对于Flan以及CoT数据集的兼容性,得到结果如下:

5. 开放接口人工标注指标

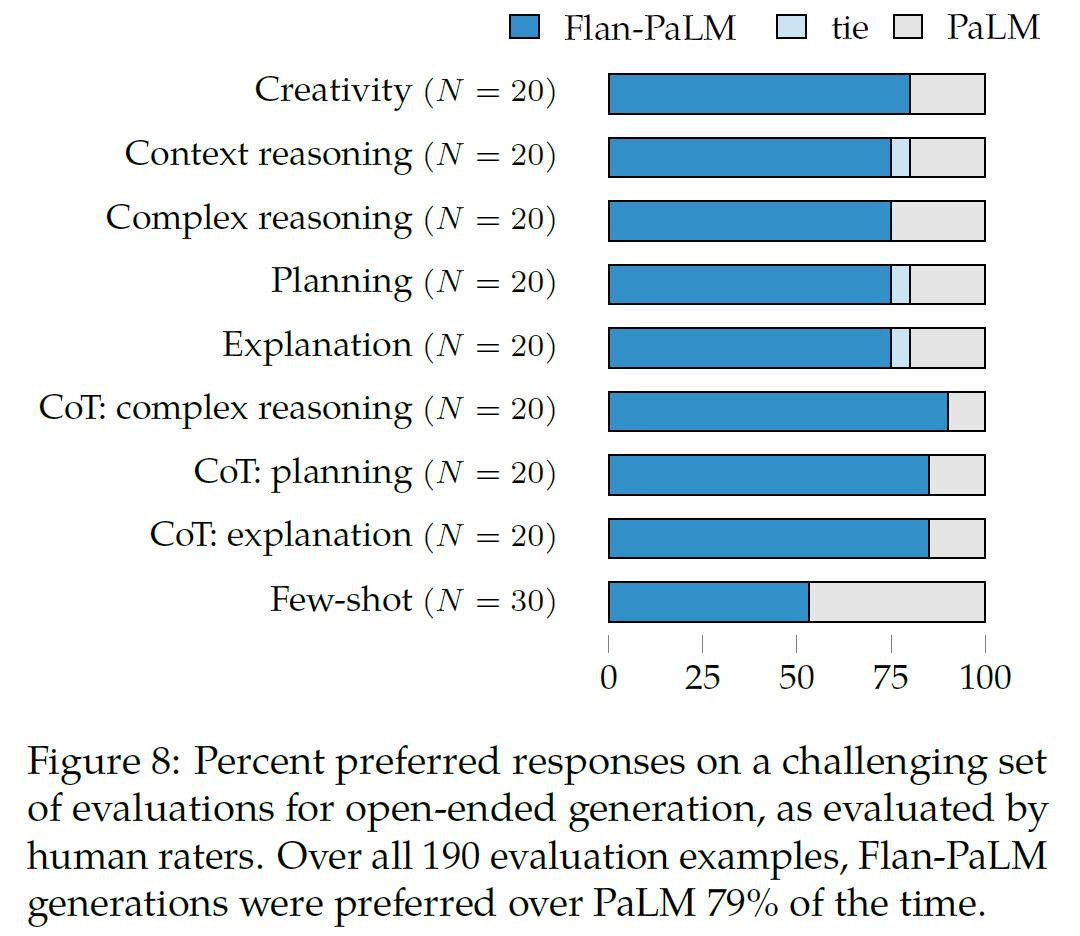

最后,文章使用人工标注结果对比了Flan-PaLM以及PaLM模型的效果,得到结果如下:

可以看到:

- Flan-PaLM的效果确实是优于PaLM的。

3. 结论

综上,文章进一步考察了Flan以及CoT在大模型中的效果,整体上可以看到:

- Flan和CoT对于模型效果都是正向的影响,且目前看起来还没有到顶;

- Flan以及CoT除了在自回归模型上有效之外,在T5上面同样有效,但是前者似乎效果更好。

不过还是那个说法,大模型现在真就是看着玩玩了,完全不可本地服务化,也不可能自己去跑这看效果,这能通过外部接口访问了,大概就只能作为旁观者看他们玩了……

以上是关于文献阅读:Scaling Instruction-Finetuned Language Models的主要内容,如果未能解决你的问题,请参考以下文章