速通版吴恩达机器学习笔记Part2

Posted ViviranZ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了速通版吴恩达机器学习笔记Part2相关的知识,希望对你有一定的参考价值。

目录

1. 代价函数(cost function)(P11-P15)

1. 代价函数(cost function)(P11-P15)

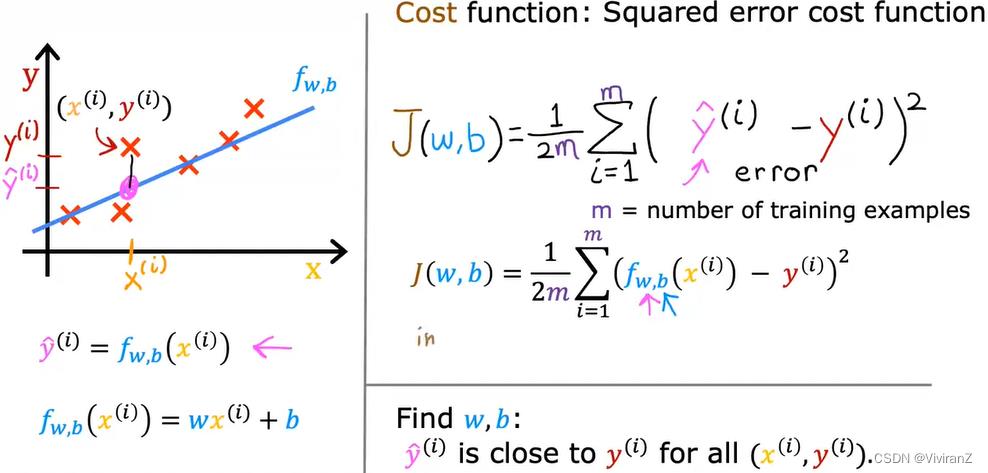

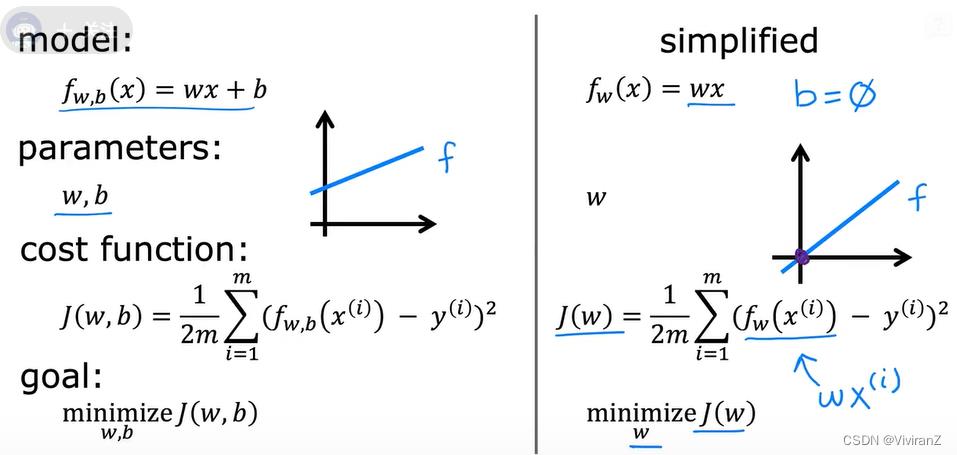

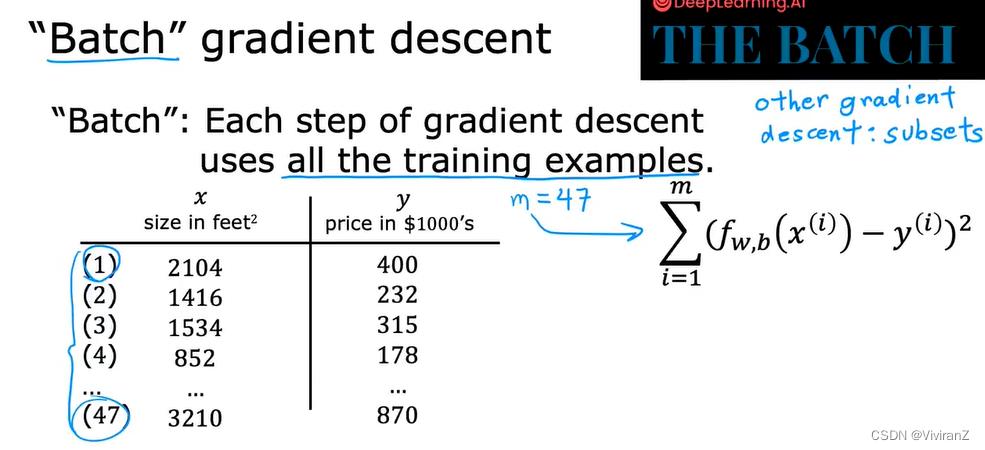

代价函数用来评判算法结果的好坏,主要用的平方误差函数

认为J衡量fit的程度

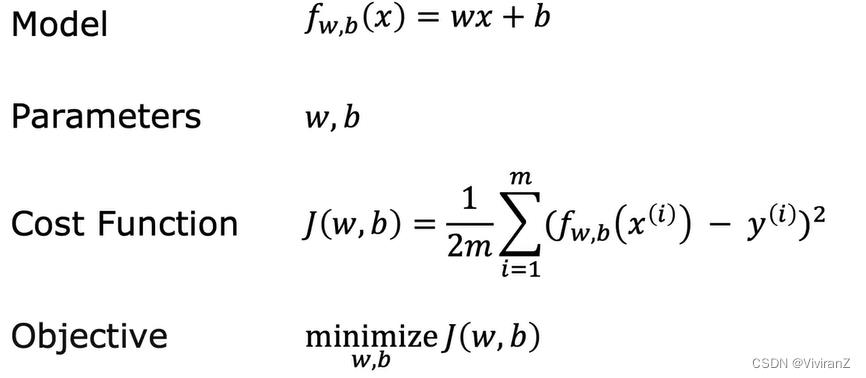

总结:

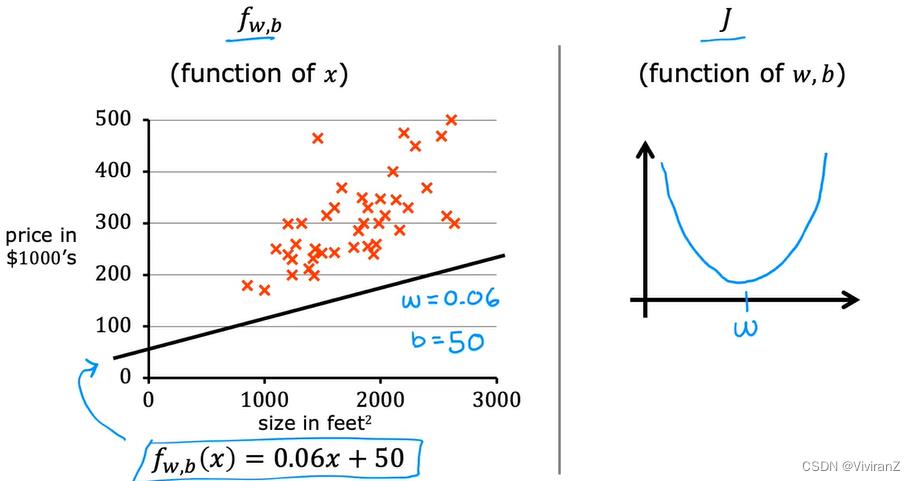

一个例子:

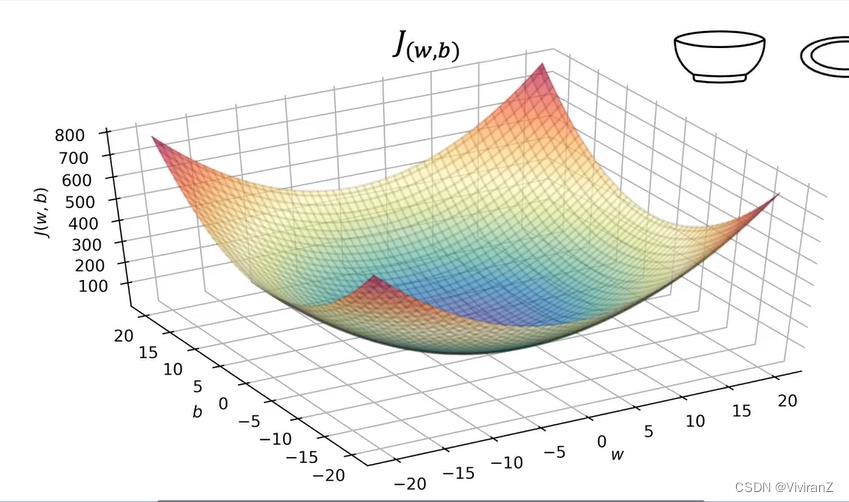

能理解,类似于一个二维优化问题,找二维里最佳的(w,b)

2.梯度下降(GD,gradient descent)

直观理解:

这玩意太熟了,应用范围广、针对可微函数很好用,但是问题在于必须针对可微函数并且容易陷入局部最优 。但是在线性回归+MSE的问题里只有一个局部最小(同时也是全局最小),因此这个方法非常实用。

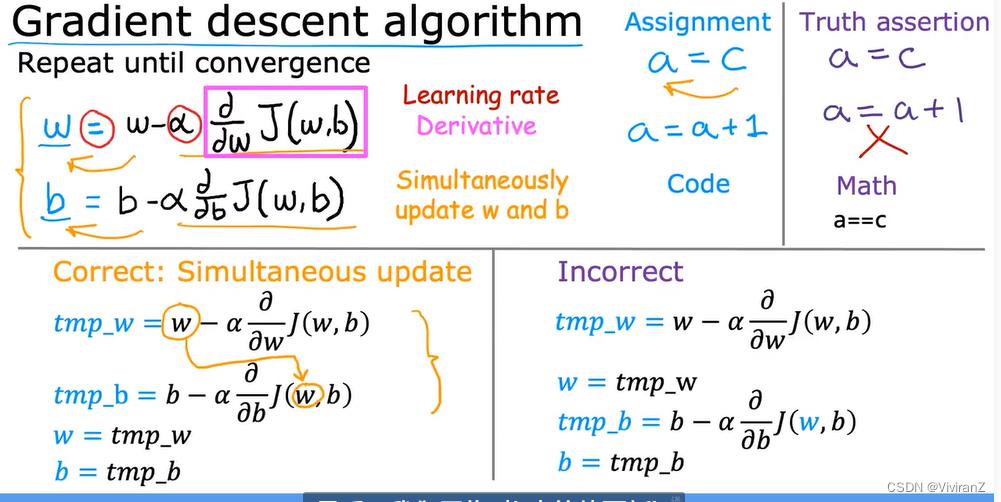

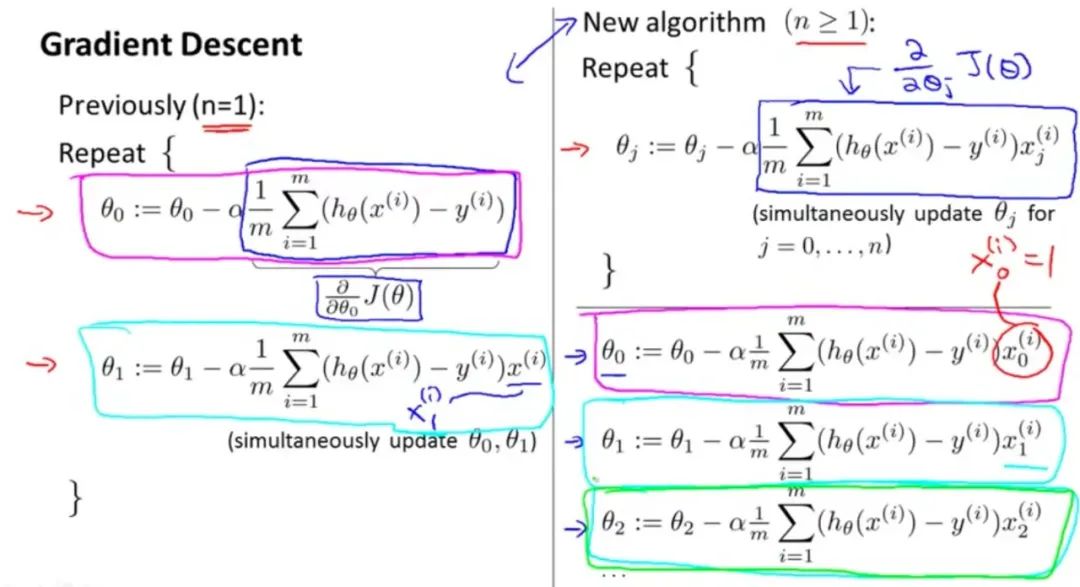

关于derivative等不再赘述,\\alpha 是学习率、优化里的步长。关键在于【同时更新w和b】,这是当提及GD时候的默认的关键

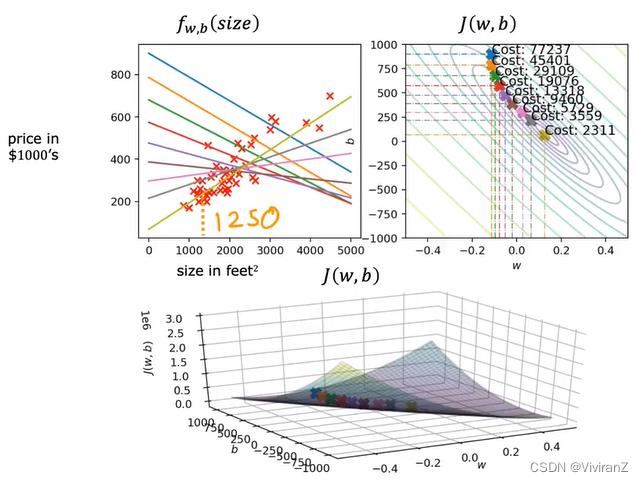

关于这个学习率,小了收敛很慢,大了可能来回横跳,但是我们事先并不知道哪个值是最佳的,只能事先设置。理论上,我们知道当我们步数越多的时候,步长应该越小,(就像找东西,找到近的位置的时候应该更仔细,)但是,下面图表示出我们直观上可以用恒定的步长找到最优值(因为derivative在变小)

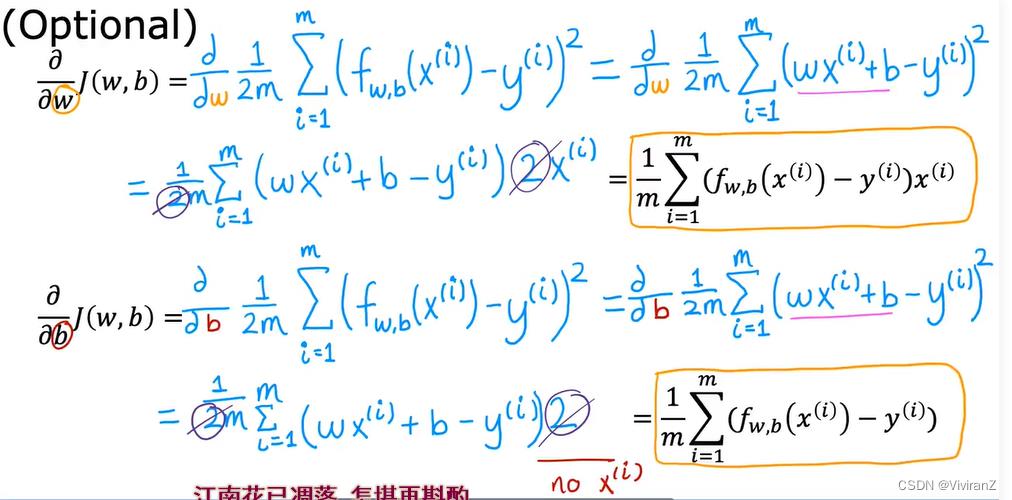

数学式子如下:最简单的微积分 过

用图示直观理解如下:

之前

第一次作业相对简单,matlab码过多次了,其实就是一个梯度下降法的循环,略。 有需要可以参考:Coursera-ML-AndrewNg-Notes/code at master · fengdu78/Coursera-ML-AndrewNg-Notes · GitHub

以上是关于速通版吴恩达机器学习笔记Part2的主要内容,如果未能解决你的问题,请参考以下文章