带纹理3D网格的深度生成模型Gen-AI

Posted 新缸中之脑

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了带纹理3D网格的深度生成模型Gen-AI相关的知识,希望对你有一定的参考价值。

本文介绍了 TM-NET,这是一种新颖的深度生成模型,用于以部分感知的方式合成纹理网格。 经过训练后,网络可以从头开始生成新颖的纹理网格或预测给定 3D 网格的纹理,而无需图像引导。 可以为同一网格部件生成合理多样的纹理,同时通过条件生成实现相同形状部件之间的纹理兼容性。

论文下载地址:ArXiv Preprint,代码下载地址:Github,数据集下载地址:这里。

推荐:使用 NSDT场景设计器 快速搭建 3D场景。

1、TM-NET概述

具体来说,我们的方法为各个形状部分生成纹理贴图,每个部分都是一个可变形的盒子,从而产生失真最小的自然 UV 贴图。 该网络分别将部分几何体(通过 PartVAE)和部分纹理(通过 TextureVAE)嵌入到它们各自的潜在空间中,以便于学习以几何为条件的纹理概率分布。

我们引入了一个用于纹理生成的条件自回归模型,它可以以零件几何形状和已经为其他零件生成的纹理为条件,以实现纹理兼容性。 为了产生高频纹理细节,我们的 TextureVAE 通过基于字典的矢量量化在高维潜在空间中运行。 我们还利用纹理中的透明度作为对包括拓扑细节在内的复杂形状结构进行建模的有效手段。 大量实验证明了我们网络生成的纹理和几何形状的合理性、质量和多样性,同时避免了新颖的视图合成方法常见的不一致问题。

2、TM-NET结构

下图为TM-NET 关键组件,用于纹理网格生成。

每个部分都使用两个变分自动编码器 (VAE) 进行编码:PartVAE 用于几何图形,EncP 作为编码器,DecP 作为解码器,TextureVAE 用于纹理,EncP 作为编码器,DecP 作为解码器。 对于纹理生成,TM-NET 设计了一个条件自回归生成模型,该模型以 PartVAE 的潜在向量作为条件输入并输出离散特征图。 这些特征图被解码为输入网格几何体的纹理图像。

下图为用于表示纹理部件的网络架构:用于编码部件几何形状的 PartVAE 和用于纹理的 TextureVAE。

下图为TextureVAE 的网络架构。 编码器将输入图像块映射到两个连续的特征图,顶部(t)和底部(b)。 然后执行基于字典的矢量量化。 解码器将离散特征图作为输入并重建图像。

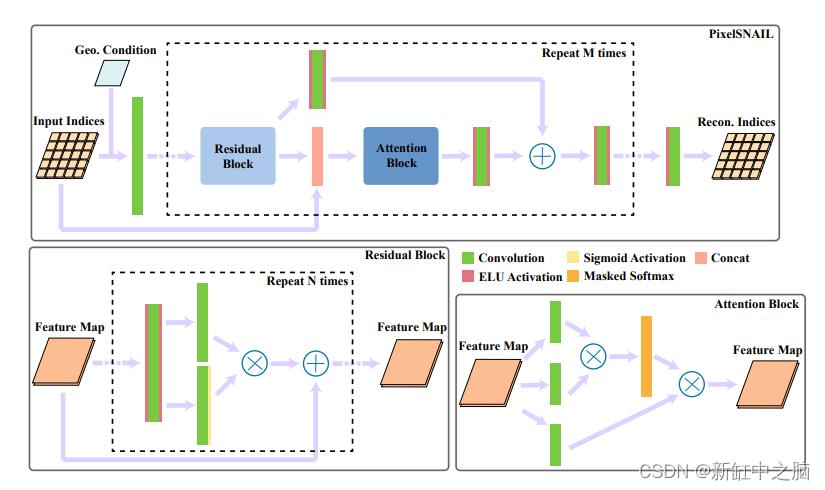

下图为自回归生成模型的架构。 该网络将索引矩阵作为输入,将几何潜在向量作为条件,并输出重构的索引矩阵。

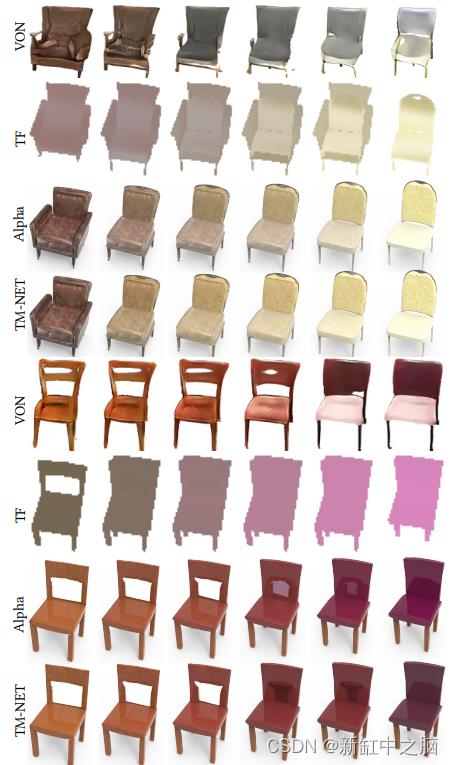

下图为椅子(第一列和最后一列)之间的潜在空间线性插值的随机采样结果,比较 TM-NET 和 VON [Zhu et al。 2018],TF [Oechsle 等人。 2019],以及逐个部分的 alpha 混合。

通过仅以输入几何条件为条件的学习概率分布的四次采样,随机选择形状条件纹理结果(左)。 种子部分分别是椅座和桌面。 请注意 TM-NET 生成的合理多样的纹理,以及为同一形状的不同部分生成的不同纹理。

下图为具有纹理的生成形状的代表性结果。 我们首先在 SP-VAE 的潜在空间上随机采样以生成结构化网格。 然后我们使用几何潜在作为 PixelSNAIL 的条件来生成所需的纹理。

原文链接:纹理网格深度生成模型 — BimAnt

以上是关于带纹理3D网格的深度生成模型Gen-AI的主要内容,如果未能解决你的问题,请参考以下文章